SEOにおいて、ランキングの判定要素を明確に把握することは、不可能と言えます。Webサイトの状況や時期的な要素などを含め、「効果的な施策」を日々探している方も多いでしょう。そういった状況の中、真偽の程は定かではない「効果的な施策」がさも事実であるかのように語られることは多いです。今回はそうした施策を「都市伝説」と名付け、それらを検証したSearch Engine Journalの記事を紹介いたします。

この記事では、SEOの専門家が繰り返し否定しているにも関わらず、未だに存在している20のSEOの都市伝説を紹介する。

SEOについてのアドバイスは様々だ。

実際に役に立つものもあれば、従ってしまうと道を踏み外してしまうアドバイスもある。

難しいのは、それらを見分けることだろう。

事実に基づいた正確なアドバイスと、誤って引用された記事やGoogleの声明に対する不十分な理解に基づいたアドバイスを見分けることは難しい。

それゆえ、SEOの都市伝説は未だに存在しているのだ。

こうした都市伝説を奇妙な場所で耳にすることもあるだろう。

重複コンテンツのペナルティを受けていると、自信を持って話してくれるクライアントもいるだろう。

ページタイトルを60文字以内にしなかったことで怒ってくる上司もいる。

多くの都市伝説は明らかにフェイクであるとわかる。しかし、検知することが難しい場合もある。

SEOの都市伝説の危険性

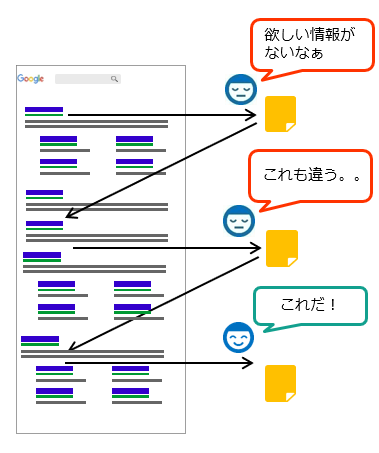

そもそもの問題は、我々は検索エンジンの仕組みを正確に把握できないということだ。

その結果、SEO担当者が行う施策は、試行錯誤や経験に基づく推測に終始してしまうことも多い。

SEOを学習している過程で耳に入った話の全てを検証することは不可能だ。

こうした状況の中、SEOの都市伝説が定着する。

気が付くと、自身のWebサイトのキャッチコピーを「BERT最適化」にすると、ラインマネージャーに誇らしげに話してしまう。

SEOの都市伝説の多くは、冷静に考えれば、すぐに打ち破れるものが多い。

具体的に、Googleはどうやって測定するのか?

実際に、エンドユーザーへのメリットは存在するのか?

SEOにおいては、「検索エンジンは全能である」と考えてしまう危険性がある。そのため、検索エンジンがWebサイトを理解し、測定する方法について、明らかに無理のある理論がまかり通るようになる。

SEOの都市伝説とは何か?

よくあるSEOの都市伝説を否定する前に、そもそもそれらがどのような形式であるかを理解しよう。

検証されていない知識

SEOの都市伝説は、検証されることなく、伝え聞いたものであることが多い。

その結果、質の高いオーガニックトラフィックの獲得に全く影響しないことが、さも重要であるかのように語られる。

些細な要素が大きな割合を占める

SEOの都市伝説の中には、オーガニックのランキングやコンバージョンに大きな影響を与えないにも関わらず、非常に重要なものとして扱われることもある。

SEOの成功に必要な要素としての「チェックボックス」の場合もあるし、競合サイトとあらゆる条件が同一の場合に限り効果を発揮するものもある。

時代遅れのアドバイス

都市伝説の中には、かつてはランキングやコンバージョンに効果があったが、現在では全く効果がないことが、真剣にアドバイスされることもある。

以前は効果的であったかもしれない。

しかし、時が経つにつれ、検索エンジンはより有能になっていく。

一般ユーザーはマーケティングされることを嫌うようになった。

単純に、かつては有益なアドバイスであったものが、現在では廃れてしまっているのである。

Googleへの誤解

多くのSEOの都市伝説は、Googleから始まる。

不幸にも、Google社員が与えた、多少曖昧で、単純ではないアドバイスが誤解されることがある。

気がつくと、Google社員が冗談で行ったコメントに基づく、新しい最適化サービスが販売されるようになる。

SEOの都市伝説は事実に基づいている場合もあるが、正確には、SEOの伝説と表現すべきかもしれない。

Googleから始まった都市伝説の場合、SEO業界の解釈によって事実が歪められ、もはや有益な情報ではなくなっている場合も多い。

都市伝説と呼ばれるようになったのは、いつからか?

自身のWebサイトで効果的でなかったからという理由で、とあるSEOのテクニックが都市伝説として他者から聞くことがある。

あらゆるWebサイトが、独自の業界、競合他社、テクノロジーなどの要素があることを忘れてはならない。

全てのWebサイトに対し同一の手法を施すとその結果も同じになる、と思うことは、甘い考えだ。

本当は効果的なテクニックであるにも関わらず、非常に競合性の高い業界で試したところ成功しなかった、といった場合も考えられる。

このテクニックが、競合性の低い業界の場合、成功しないということにはならない。

因果関係と相関関係を混同してしまう

施行された施策とオーガニックでのパフォーマンスとの関係性が不適切であることによって生まれる都市伝説もある。

SEO担当者として、自身が行った施策の効果があった場合、他のSEO担当者に同じ施策を行うべきとアドバイスすることは理解できる。

不幸にも、我々は因果関係と相関関係をしっかりと区別することがそこまで得意ではないのだ。

新しい施策を行ったタイミングでランキングやCTRの上昇が見られたとしても、その施策が理由とは限らない。

その他の要因があるかもしれないのだ。

非常に熱心なSEO担当者が、誤って信じてしまっている黄金のチケットを共有することで、SEOの都市伝説が生まれることもある。

SEOの都市伝説に惑わされないために

SEOの都市伝説を見破り、適切に行動することで、頭痛や収益の損失、また、多くの時間を節約することができる。

テスト

SEOの都市伝説に惑わされないためには、人から聞いたアドバイスは、可能な限りテストをすることが重要である。

仮に、ページのタイトルをとある方法で記載すると順位が上昇する、といったアドバイスを受けた場合、まずは1つか2つのページで試してみよう。

こうすることで、多くのページに対して実行する前に、それを行う価値があるかどうかを判断することができる。

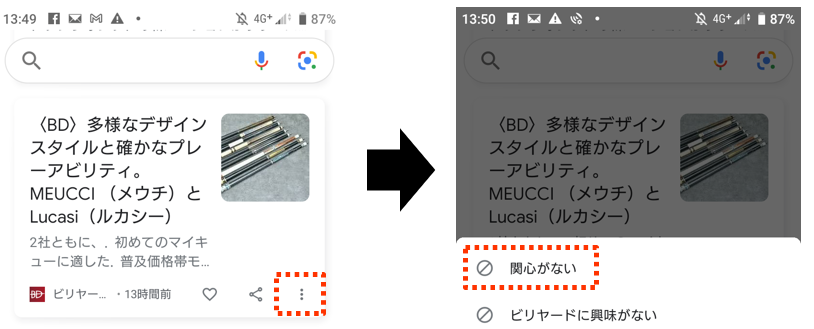

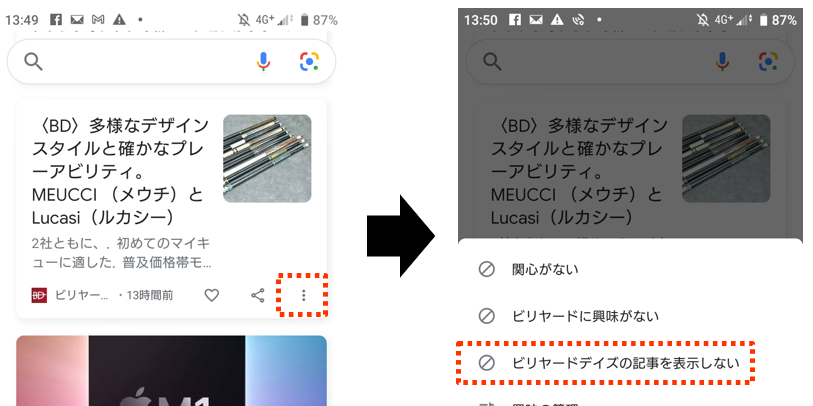

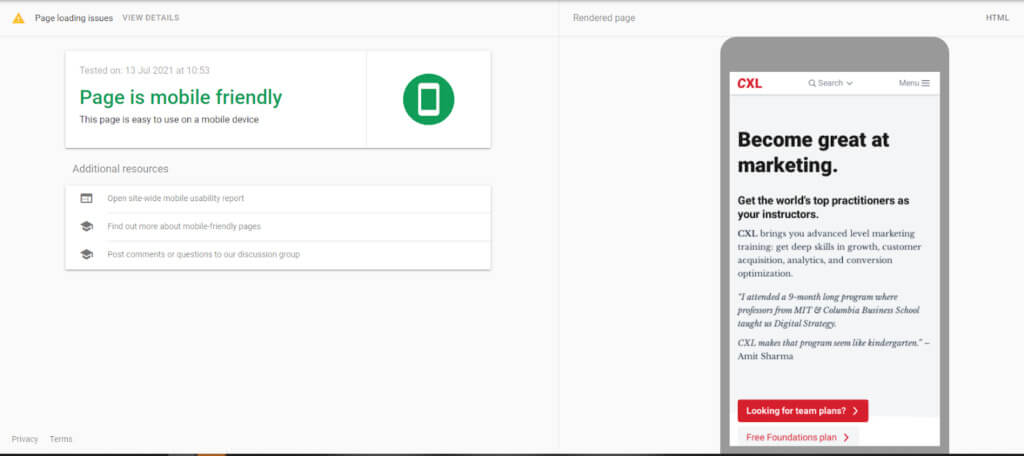

Googleはテストをしているだけなのか?

Googleが検索結果の表示方法や順番を変えることで、SEO業界が大騒ぎすることがある。

こうした変更は、検索結果全体に適用される前に、自然な状況でテストされることがよくある。

大きな変更が一人や二人のSEO担当者によって発見され、その変更に対する最適化のアドバイスが広まってしまう。

デスクトップの検索結果にファビコンが表示されたことを覚えているだろうか?

この時、SEO業界(また、Googleの一般的なユーザー)が受けた衝撃は相当のものであった。

そして、ユーザーを惹きつけるために検索結果にファビコンを表示させることが重要である、という記事が突如として公開されたのだ。

しかし、ファビコンがクリック率に与える影響を調査する時間はほとんど無かった。

なぜなら、Googleはすぐに元に戻したからである。

Googleによる変更がTwitterで拡散され、それが最新のSEOアドバイスとなる。しかし、それらに飛びつく前に、本当に有益かどうかを確認しよう。

現在は有益なアドバイスであったとしても、Googleがその変更を元に戻してしまえば、すぐに都市伝説となってしまうかもしれない。

よくあるSEOの20個の都市伝説

SEOの都市伝説の原因と根拠について理解したところで、よくあるSEOの都市伝説の真相を探ってみよう。

1.Google Sandbox

一部のSEO担当者の間では、新しいWebサイトが適切にランキングされるようになるまで、自動的に一定期間、順位が抑制されるという考えがある。

しかし、多くのSEO担当者が、これは真実ではないと述べている。

では、正しいのは誰だろうか?

長年SEOに携わってきた者の中には、Sandboxの考えを支持したり、否定したりする根拠を示してくれる。

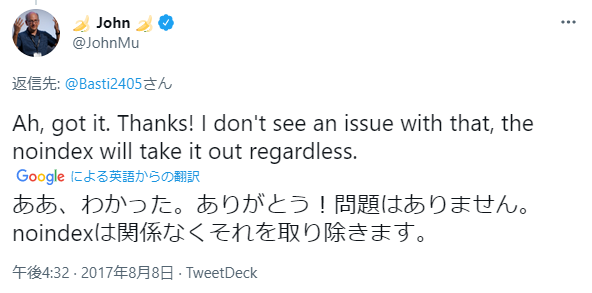

Sandboxに対して、Googleが与えてくれた唯一のガイダンスは、ツイートによるものだ。

前述した通り、Google社員のソーシャルメディアでの発言は、しばしば誤解を招くことがある。

画像内翻訳:

「通常、新しいWebサイトがGoogleのSandboxから解放されるまでにはどのくらいかかりますか?」

「Sandboxなど存在しません。」

判定:公式には(?)都市伝説とされている

非公式ではあるが、Googleが新しいWebサイトのページを理解し、順位付けするまでには、一定の期間が必要であるようだ。

これは、Sandboxに似ている事象かもしれない。

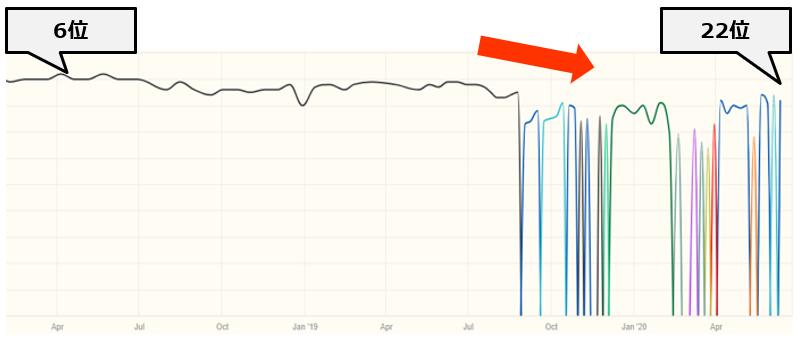

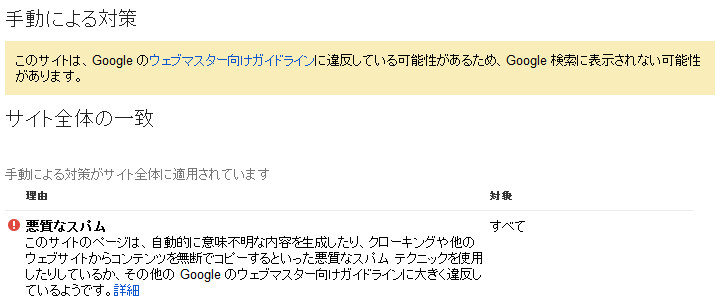

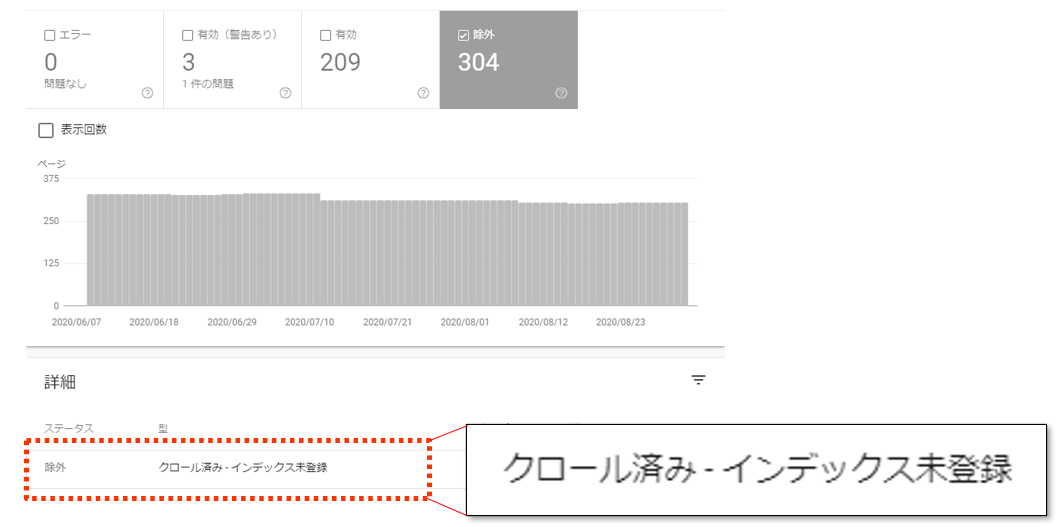

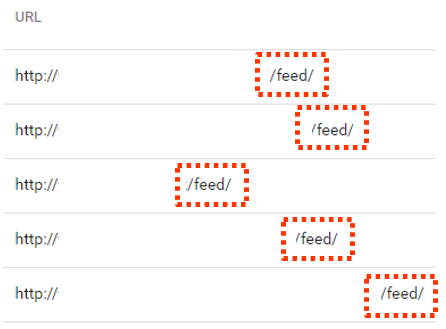

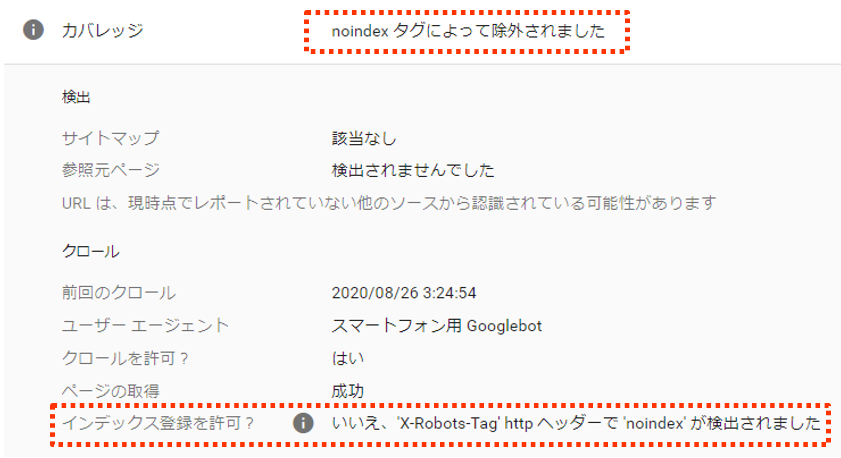

2.重複コンテンツによるペナルティ

非常によく耳にする都市伝説である。自身のWebサイト内で、Web上のどこかにあるコンテンツと重複しているコンテンツがある場合、Googleがペナルティを与える、という考えである。

これを理解するためには、アルゴリズムによる抑制と、手動アクションの違いを知ることが必要だ。

手動アクションは、WebページがGoogleのインデックスから削除されてしまうことであり、Google内の人の手によって行われるアクションである。

Webサイトのオーナーには、Search Console経由で、その知らせが届く。

アルゴリズムによる抑制は、アルゴリズムのフィルターに引っかかった結果、上位に表示されない状況を指す。

チュック・プライス氏は、Googleが行う様々な手動アクションをまとめた記事を執筆しており、そこでこれら2つの違いを見事に説明している。

基本的には、他のWebページから引用した文章がある場合、そのWebページが上位に表示されることは難しいかもしれない。

検索エンジンは、その文章のコピー元のホストの方が、より検索クエリに関連していると判断するかもしれないからだ。

複数の同じ文章を検索結果に表示するメリットはないため、あなたのWebページの順位が上がらないことはある。これは、ペナルティでは無い。アルゴリズムがその役割を果たしているに過ぎないのだ。

プライス氏が紹介しているように、コンテンツに関連した手動アクションはいくつか存在する。しかし、他のWebページのコンテンツを1~2ページコピーしたところで、その要因となることはない。

しかし、そのWebページのコンテンツを利用する法的な権利がなければ、別の問題が生じることもある。また、あなたのWebサイトが提供するユーザーに対する価値を損なってしまうかもしれない。

判定:SEOの都市伝説

3.PPC 広告はランキングの助けとなる

これはよくある都市伝説であり、すぐに否定することができる。

これは、ペイパークリック広告で多くのお金を費やしているWebサイトを、Googleが検索結果において優遇する、という考えである。

これは、単純に間違えである。

Googleの自然検索結果の順位を決定付けるアルゴリズムは、PPC広告の掲載場所を決定付けるアルゴリズムとは、完全に別物である。

SEOと同時期にGoogleの広告のキャンペーンを行うことで、Webサイトの利益となる場合も考えられるが、これは全く別の理由であり、直接的な恩恵をもたらすことはない。

判定:SEOの都市伝説

4.ドメインエイジはランキング要素である

この考えは、「因果関係と相関関係の混同」の問題と言える。

Webサイトが長期間運営されており、上位に表示されていることから、ドメインエイジはランキング要素である、という考えである。

Googleはこの都市伝説を何度も否定している。

事実、2019年7月に、ドメインエイジを「200個のランキング要素」の1つである、と言及するツイートに対し、Googleのウェブマスター・トレンドアナリストであるジョン・ミュラー氏が、「ドメインエイジは何の助けにもならない」という返信をしている。

画像内翻訳:

「ドメインエイジは信頼性を向上させるだけでなく、200以上あるランキング要素のうちの1つです。」

「いいえ。ドメインエイジは何の助けにもなりません。」

この都市伝説の背景にある事実は、古いWebサイトは長い時間をかけて良いものを作ってきた、ということである。

例えば、10年間運営されているWebサイトの場合、重要となるページに、大量の関連性のあるリンクを獲得しているかもしれない。

運営期間が6ヶ月以内のWebサイトが、こうしたWebサイトに対抗することは難しいだろう。

より長く運営されているWebサイトの方が順位が良いように見えるかもしれないが、ドメインエイジが決定要素であるとは考えられない。

判定:SEOの都市伝説

5.タブ付きのコンテンツはランキングに影響する

これは古くからある考えである。

前提として、Googleはタブやアコーディオンの裏に記載されているコンテンツには、大きな価値を与えない。

例えば、ページを最初に開いた場合には表示されないテキストなどである。

Googleは、2020年3月31日にこの都市伝説を再度否定しているが、多くのSEO担当者が何年間も議論している内容である。

2018年9月、Googleのウェブマスター・トレンドアナリストであるゲイリー・イリェーシュ氏は、コンテンツを表示するためにタブを使用することについて、Twitterのスレッドで回答している。

彼の回答は以下である。

「私が知る限り、何も変更はない。そうしたコンテンツを我々はインデックスするし、ランキングにも考慮される。しかし、スニペットでは太字で表示されないかもしれない。そのコンテンツがWebサイトによってどのように表示されるかについては、もっと別の、より技術的な問題である。インデックスには上限があるのだ。」

コンテンツがHTML内に表示されている限り、ページを読み込んだ際に最初にユーザーからは見えないからという理由で、そのコンテンツの評価を下げると考える理由はない。

これはクローキングに該当するわけではなく、Googleは簡単にコンテンツを取得することができる。

Googleに表示されることを妨げる要素が他にない限り、そのコンテンツは、タブではないコンテンツと同じように重み付けされるべきである。

さらに詳しい説明が必要だろうか?

そうであれば、この都市伝説を覆した、ロジャー・モンティ氏の投稿を確認してほしい。

判定:SEOの都市伝説

6.GoogleはGoogle Analyticsのデータを順位付けに使用している

これは、多くのビジネスオーナーに共通した考えである。

彼らはGoogle Analyticsのレポートを確認している。

Webサイト全体で、平均直帰率が高いと感じ、ページ滞在時間が短いと感じている。

これらの理由により、GoogleがそのWebサイトを低品質なWebサイトであると判断していると、心配になるのだ。

それが原因で、ランキングが上昇しないと考えているのである。

Google Analytics内のレポートをランキングアルゴリズムの一部として、Googleは使用しているという都市伝説がある。

これは昔からある都市伝説である。

Googleのゲイリー・イリェーシュ氏は、次のシンプルな言葉で、この都市伝説を否定している。

「我々は、Google Analyticsのデータをアルゴリズムに使用していません。」

論理的に考えれば、Google Analyticsのデータをランキングに活用することは非常に難しい。

例えば、フィルターを活用することでデータを操作し、実際には発生していないパフォーマンスを、発生しているように見せることは可能である。

そもそも、良いパフォーマンスとは何か?

「ページ滞在時間が長い」ということは、長文のコンテンツでは良いと言える。

しかし、「ページ滞在時間が短い」ということは、短いコンテンツにとっては適していると言える。

どちらが正しく、間違っているのか?

Googleは、各Google Analyticsの複雑な設定を理解する必要がある。

複数のボットを除外している場合もあれば、そうでない場合もある。

カスタムディメンションやチャネルグループを設定している場合もあれば、そうでない場合もある。

こうしたデータを信頼できるデータとして確実に使用することは、非常に複雑な作業となる。

また、他の解析プログラムを使用しているWebサイトも、何十万と存在している。

Googleはこれらをどのようのにして扱うというのだろうか?

判定:SEOの都市伝説

この都市伝説は「相関であり、因果では無い」の1つのケースと言える。

Webサイト全体の直帰率が高いということは、そのWebサイトの品質に問題があることを示している場合もあるし、そうでない場合もある。

ページ滞在時間が短いということは、あなたのWebサイトが魅力的でないことを意味する場合もあるし、あなたのコンテンツが素早く理解されていることを意味する場合もある。

これらの指標は、上位表示されていない理由を知る手がかりとはなりうるが、直接の原因とはなり得ない。

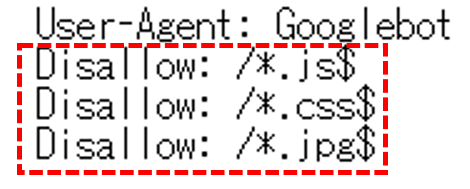

7.Googleはドメインオーソリティを考慮している

PageRankはWebページの重要度を測るための、Googleによるリンク解析アルゴリズムである。

かつて、GoogleはPageRankのスコアを、10を最大値として、ツールバーの上部に表示していた。

その後、2013年にツールバーの上部に表示されるPageRankのスコアを更新することを、Googleは停止した。2016年、Googleはツールバーの上部に表示されるスコアを今後は使用しないことを認めた。

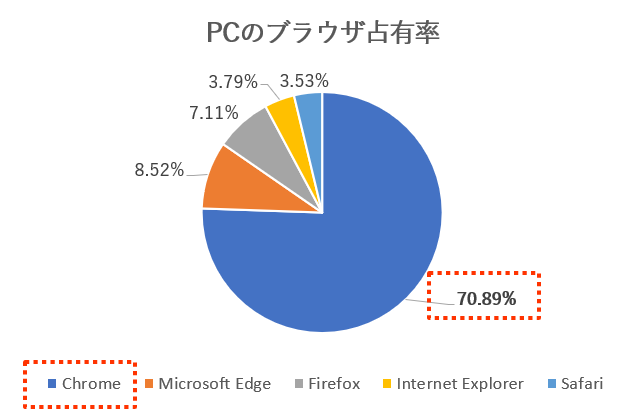

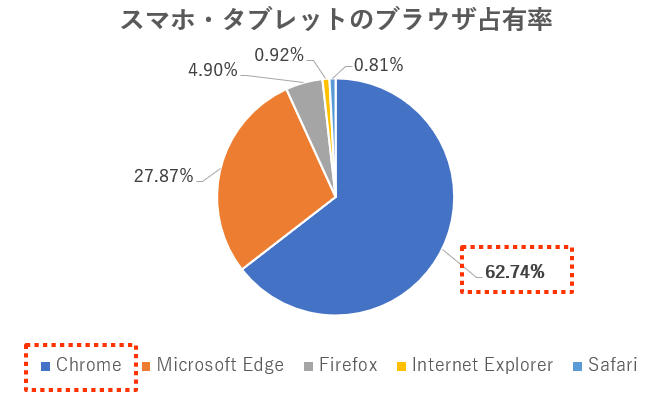

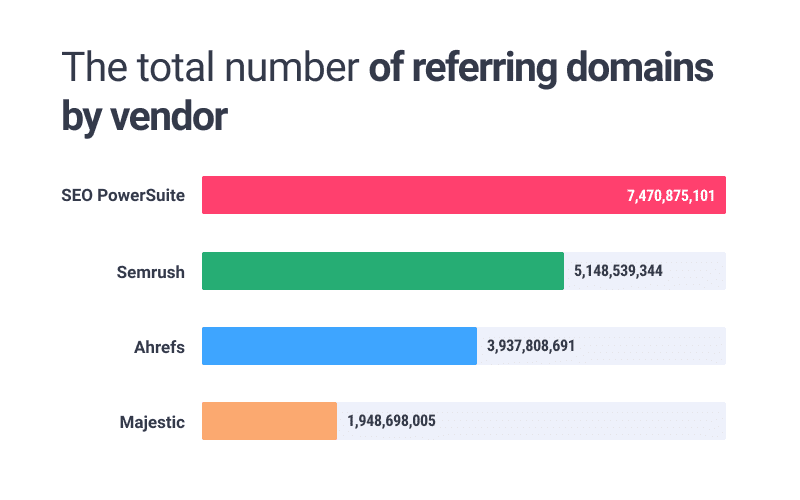

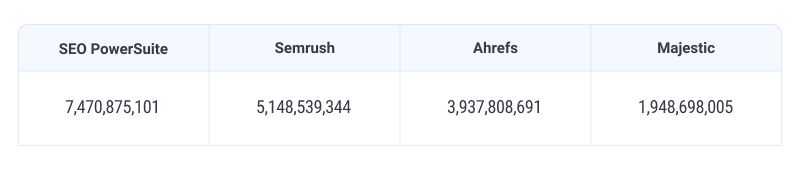

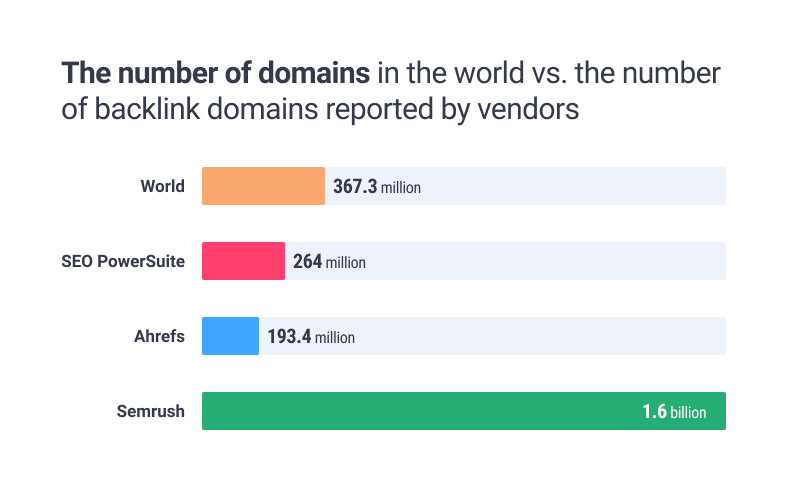

PageRankが無くなり、多くのサードパーティ製のオーソリティスコアが開発された。

よく知られているものをまとめてみよう。

- MozのDomain AuthorityとPage Authority scores

- MajesticのTrust FlowとCitation Flow

- AhrefsのDomain RatingとURL Rating

Webページの「価値」を判断するため、これらのスコアを使用するSEO担当者もいる。

しかし、これらの指標は、検索エンジンによるWebページの評価を正確に反映しているものではない。

一般的に、SEO担当者は、Webサイトのランキングパワーをバックリンクのプロフィールと共に言及することが多い。

これもドメインオーソリティとして知られている。

混乱の要因はここにあると考えられる。

Googleの担当者は、Googleが使用しているとされているドメインオーソリティという概念を否定している。

ゲイリー・イリェーシュ氏は次の言葉を用いて、この都市伝説を否定している。

「我々は、”全般的なドメインオーソリティ”は持っていない。」

画像内翻訳:

「全般的なドメインオーソリティにとって、jpgのURLへのバックリンクは、WebページのURLのバックリンクと同等の影響があるのですか?」

「我々は、”全般的なドメインオーソリティ”は持っていない。アンカーテキストのあるテキストリンクの方がより良くはあるが。」

判定:SEOの都市伝説

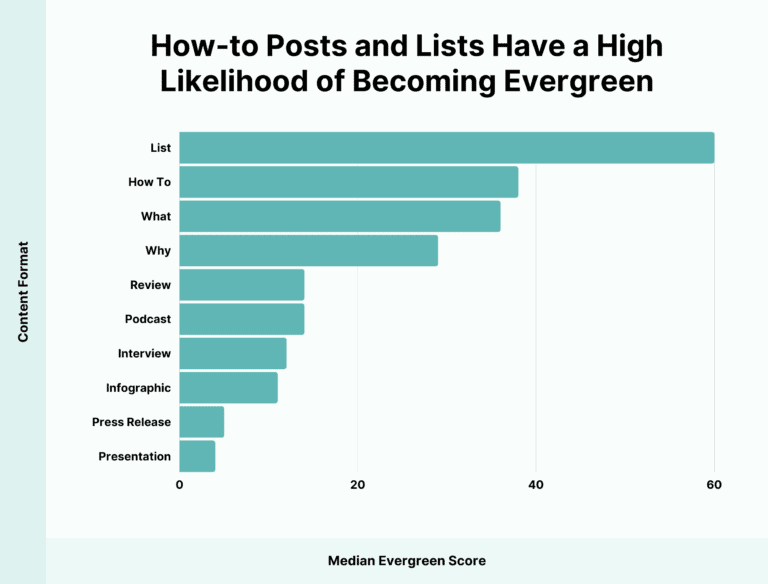

8.コンテンツは長ければ長いほど良い

長文のコンテンツの方が順位が高い、という話を一度は聞いたことがあるだろう。

より多くの単語を含んだページは、自動的に競合サイトのページよりも順位が良くなるという考えだ。

この考えは根拠がほぼ無いに等しいにも関わらず、SEOのフォーラムでしばしば「知恵」として共有される。

「検索結果で表示される上位10位のWebページでは、平均で1,450単語以上が含まれている」など、上位に表示されるWebページにおける真実として発表された調査は数多くある。

この情報だけを切り取り、1ページ目に表示されるためには1,500単語以上が必要である、と考えることは容易である。しかし、これはこうした調査が言わんとしていることとは異なる。

不幸にも、これは相関関係の例であり、因果関係を示すものではないのだ。

とある調査結果で、上位に表示されているページが、11位以下のページよりも文字数が多かったとしても、文字数がランキング要素であると言うことはできない。

Googleのジョン・ミュラー氏は、この都市伝説を否定している。

画像内翻訳:

「上位に表示されている記事と同じ単語数を用いたとしても、それだけで上位に表示されることはない。USBの充電器を大量に保持したところで、月に行くことはできないのと同じだ。」

判定:SEOの都市伝説

9.LSIキーワードは上位表示の助けとなる

LSIとは、正確には何を指すのであろう?

LSIとは、”潜在意味解析:latent semantic indexing“の略である。

テキスト内の概念を分析し、それらの関係性を明らかにするという、情報検索の手法である。

言葉は、その文脈によって、ニュアンスが変わる。”right”という言葉は、”left”という言葉と組み合わせた場合と、”wrong”という言葉と組み合わせた場合とでは、そのニュアンスが異なる。

人間であれば、テキスト内の概念を素早く判断することができる。しかし、機械にとっては、それは容易ではない。

機械が概念を理解するためには、エンティティ同士の文脈や関係性を理解する能力が必要となる。

LSIは、機械がテキストを理解する能力を前進させるための手法である。

しかし、LSIは同義語ではない。

不幸にも、同じような言葉やテーマとして関連している言葉を用いれば、テキスト内で明確に記載されていない言葉であっても、ランキングをあげることができるとSEO界隈では理解されている。

単純に、これは真実ではない。GoogleはLSIをはるかに凌駕する文章理解の技術を用いており、BERTなどはその例に該当する。

クラーク・ボイド氏による記事を読むことで、LSIとは何か、また、より重要なことである、LSIでないものは何か、ということについて、より深い理解を得られるだろう。

判定:SEOの都市伝説

10.SEOの効果を得るためには3ヶ月かかる

この都市伝説を用いることで、上司やクライアントとのしつこい会話から抜けだす事ができる。

約束した結果が出なくとも、十分な余裕を持つことが可能だ。

「SEOの効果が出るまでには、最低でも3ヶ月はかかる」

検索エンジンのボットが処理を行うための時間に変更が生じるのは当然のことだ。

もちろん、そうした変更がポジティブなものになるか、ネガティブなものにあるか、それを見極める時間も必要だ。そして、より多くの時間をかけて、あなたの作業を洗練させ、微調整する必要があるかもしれない。

しかし、それがSEOの名の下に行われるあらゆる作業が、3ヶ月間何も効果を生まないというわけではない。ランキングに変化が表れるのは、90日間が経過したタイミングであるとは言い切れない。

より多くの要素が絡んでいるのだ。

競争力が低く、ニッチなキーワードでの上位表示を狙っている場合、Googleが再クロールするだけでランキングに変化が見られることはある。

競合性の高いキーワードの場合、順位に変化が見られるまでにより多くの時間がかかる可能性はある。

200万キーワードを分析したAhrefsによって行われた調査では、Googleの検索結果で10位以内に表示されているWebページの平均年齢は、650日であったとのことだ。この調査では、新しいページが上位に表示されることは困難であることを示している。

しかし、SEOには、Googleの検索結果で10位以内に表示されること以上の意味がある。

例えば、Googleマイビジネスのリスティングを上位に表示させ、素晴らしいレビューを掲載することができれば、企業にとって大きなプラスとなる。

Bing、Yandex、Baiduであれば、検索結果で上位表示させることはより容易であるかもしれない。

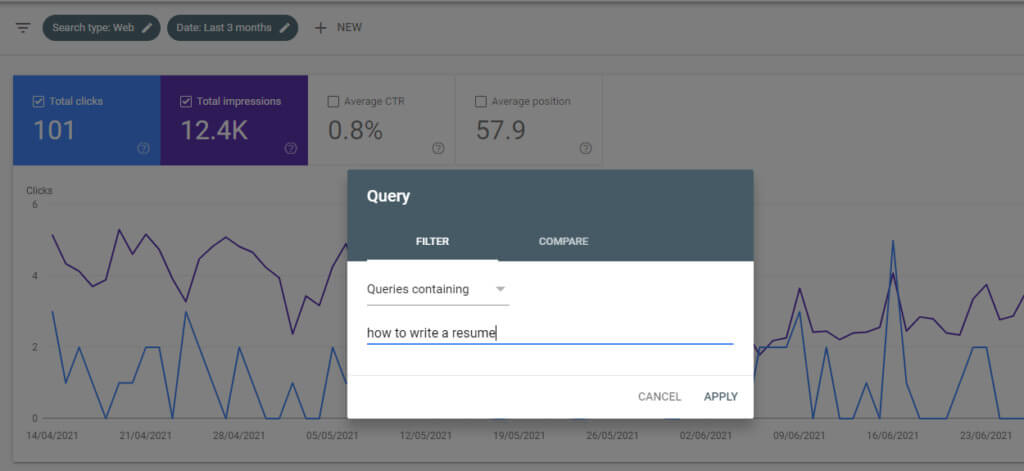

ページタイトルの些細な調整がクリック率に影響を与えるかもしれない。検索エンジンが再クロールすれば、その日のうちに改善が見られるかもしれない。

Googleの検索結果の1ページ目に表示されるまでには時間がかかるかもしれないが、SEOの成果をそれだけに留めることは賢明ではない。

そのため、「SEOの効果が出るまでには3ヶ月間かかる」と単純に言うことはできないだろう。

判定:SEOの都市伝説

11.直帰率はランキング要素である

直帰率とは、Webサイトへの訪問のうち、ページを閲覧しただけで終わる訪問の割合のことである。これは、Google AnalyticsのようなWebサイトの分析プログラムによって測定される。

SEO担当者の中には、それが品質の測定となるという理由で、直帰率をランキング要素を主張する者もいる。

残念ながら、直帰率は品質を測る指標として適切ではない。

Webページにアクセスした人が、そのWebサイトでは何もせずに去ってしまう理由は様々である。そのページで必要な情報が全て得られ、予約を取るために会社に電話するため、そのWebサイトを去ったのかもしれない。このケースの場合、そのWebサイトの企業にリードが発生したことになる。

Webページを訪問したユーザーがそのまま去ってしまうことは、コンテンツの質が低いことを示しているかもしれないが、必ずしもそうであるとは限らない。それゆえ、検索エンジンがWebページの品質を測る指標としては、十分な信頼があるデータとはなり得ないのだ。

検索結果に表示されるWebページをクリックし、その後、再び検索結果に戻ってくるという行動である「ポゴスティッキング」は、ランディングページの品質を測る為の、より信頼性のある指標となりうる。これは、そのページがユーザーが求めている情報を掲載していないことで、別のページを探したり、再検索することを意味している行動である。

Googleのジョン・ミュラー氏は、2018年の7月のウェブマスターハングアウトにて、この点について明らかにしている。

「検索においては、そのようなシグナルを用いないようにしている。ユーザーが行ったり来たりする事や、検索結果で色々なものを見たりする事や、Webページには僅かに滞在し、また戻ってきたりする事には、多くの理由があるためである。これらを活用し、”ランキング要素として用いよう”とするのは、本当に難しいだろう。」

判定:SEOの都市伝説

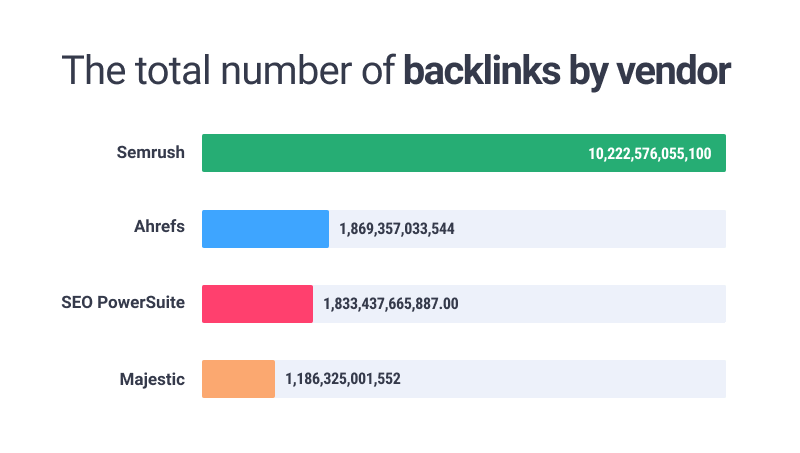

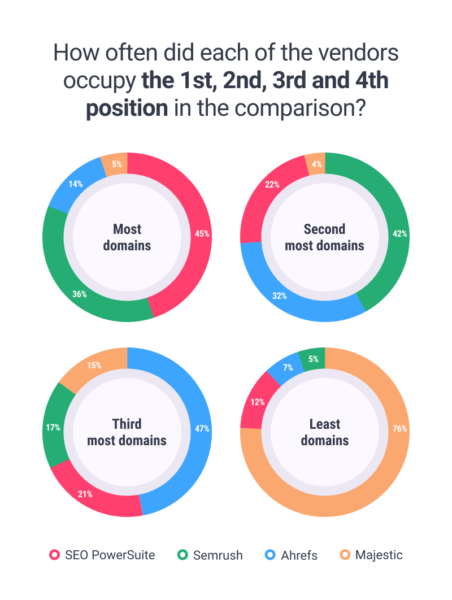

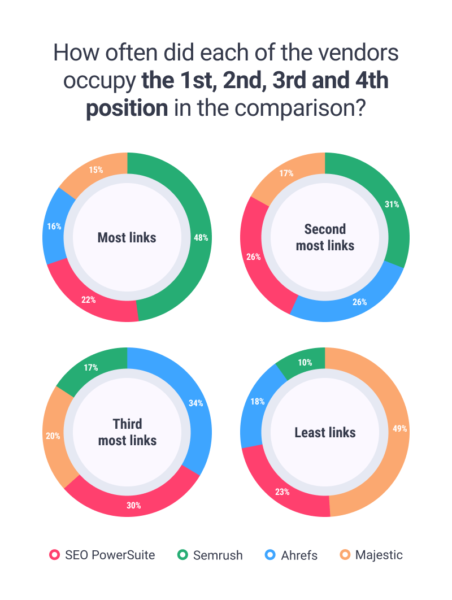

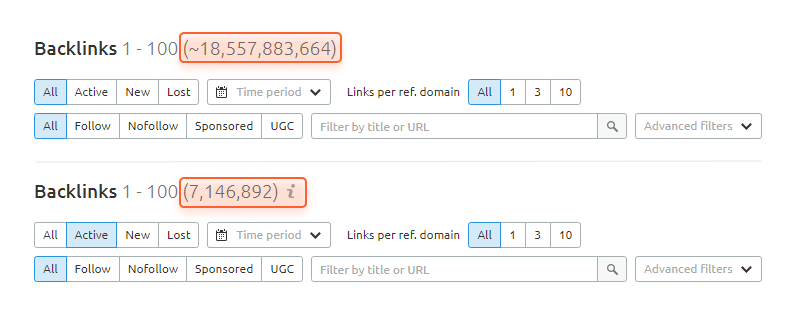

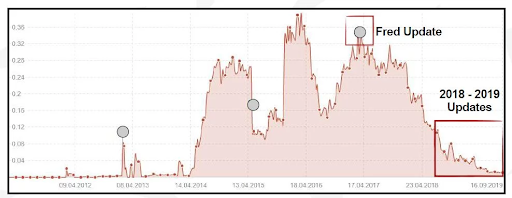

12.全てはバックリンクである

バックリンクが重要であることが議論されることはほとんどない。しかし、どの程度重要であるかについては、いまだに議論されている。

バックリンクは複数ある戦術の1つであり、ランキングに影響するが、最も重要なものではない、と伝えるSEO担当者もいるだろう。また、バックリンクこそが重要な要素である、と伝えるSEO担当者もいるだろう。

我々が把握していることは、リンクの効果は時間と共に変化しているということだ。以前は、リンクビルディングの戦術とは、可能な限り多くのリンクを自分のWebサイトに集めることであった。

フォーラムのコメントや無関係なディレクトリサービスでも、リンクの良いソースであった。

効果的なリンクを構築することが容易であったのである。

現在は容易ではない。Googleはアルゴリズムを変更し続け、質と関連性が高いリンクには恩恵を与え、「スパムな」リンクには効果を無視したり、ペナルティを与えたりしている。

しかし、リンクによるランキングへの影響は依然として高い。

SEOが成熟していない業界では、リンクビルディングに投資せずとも、コンテンツの品質や技術的な要素によって、Webサイトを上位表示できる場合もあるだろう。

しかし、ほとんどの業界では、それは当てはまらない。

もちろん、関連性の高いリンクはランキング上昇の手助けとなる。しかし、他の最適化の施策と連動する必要がある。

Webサイトには関連性の高いコンテンツが必要であり、クロールが可能でなければならない。

Googleのジョン・ミュラー氏は、「リンクは間違いなく、最も重要な要素ではない」と述べている。

画像内翻訳:

「リンクは間違いなく、最も重要な要素ではない」

Webサイトに訪問してくれるユーザーに実際に何かをしてもらいたいのであれば、バックリングが全てではない。

ランキングは、Webサイトに訪問したユーザーにコンバージョンしてもらうための、ほんの一部にすぎない。ユーザーエンゲージメントにおいては、コンテンツとユーザービリティは非常に重要なのである。

判定:SEOの都市伝説

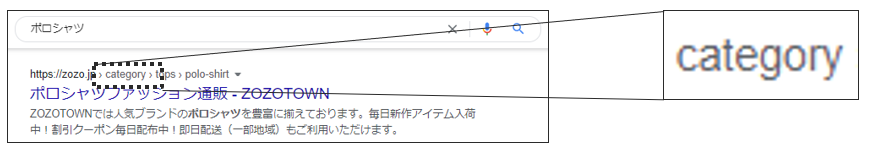

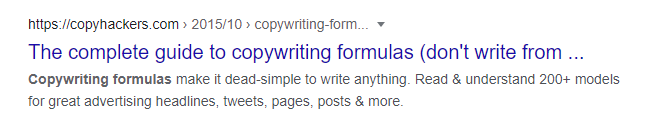

13.URL内のキーワードは非常に重要

URLにキーワードを詰め込みましょう。きっと順位が上昇するはず。

残念ながら、それだけでは効果は見られないだろう。

画像内翻訳:

「URL内のキーワードは、GoogleのSEOにおいて、過大評価されている。URLはユーザーのために作成しよう。また、モバイルにおいては、URLを見る機会も少ない。」

ジョン・ミュラー氏は、URL内のキーワードは非常に軽微なランキング要素であると、何度も発言している。

URLを書き換え、より多くのキーワードを含めようとしても、良いこと以上に悪いことが起こるだろう。

Webサイトの再構築は常にリスクを伴う。URLを一斉にリダイレクトさせる作業は、必要な場合に限り、行うべきだ。

URLにキーワードを追加するために、それを行うべきか?いや、その価値はない。

判定:SEOの都市伝説

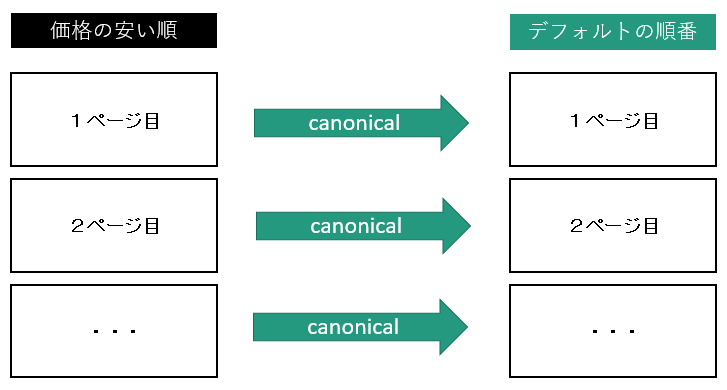

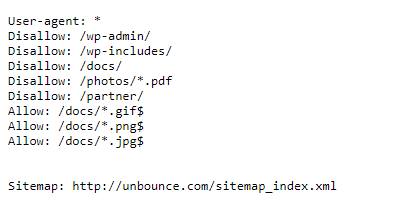

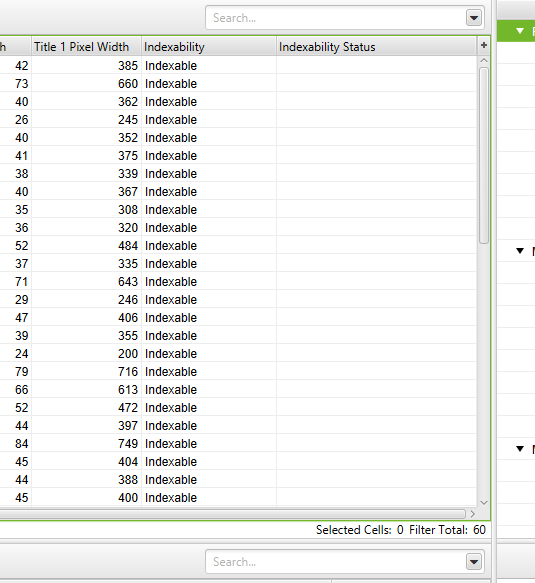

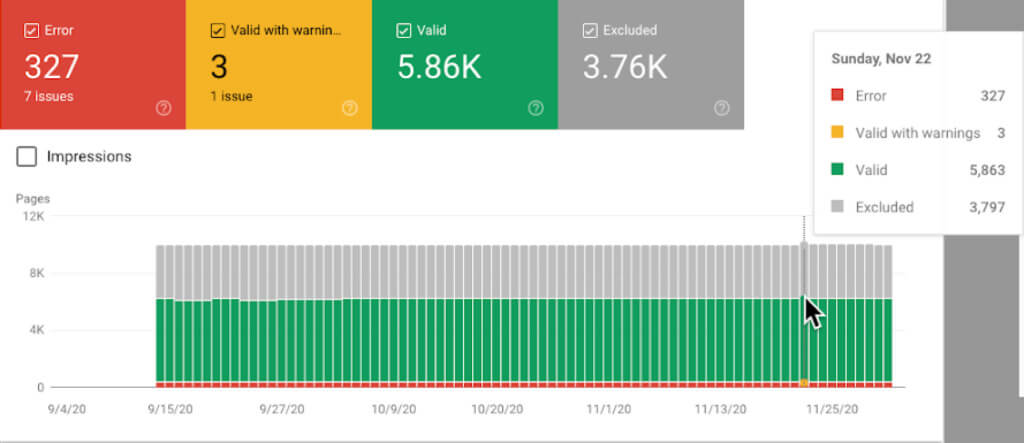

14.Webサイトの移行はリダイレクトが全てである。

SEO担当者によって、よく言われる言葉である。Webサイトを移行する場合、変更されるURLのリダイレクト設定を怠らないことだ。

本当にこれだけで良いのであれば、どれほど良かったか。

実際には、Webサイトの移行は、SEOの中でも最も複雑な作業が求められるものの1つである。

レイアウト、CMS、ドメイン、コンテンツなどの変更は全てWebサイトの移行とみなすことができる。

これらの例では、検索エンジンがターゲットキーワードとの関連性やページの品質を認識することについて影響しうる側面が複数ある。

その結果、該当のWebサイトのランキングとオーガニックトラフィックを維持したいのであれば、多くのチェックと設定が必要となる。

トラッキングに不備がないか確認する。コンテンツのターゲットを維持する。検索エンジンが適切なページにアクセスできることを確認する。

Webサイトが大幅に変更される際には、これらの全てが考慮されている必要がある。

変更されるURLのリダイレクトの設定は、Webサイトの移行において非常に重要な要素である。しかし、それが唯一のものではない。

判定:SEOの都市伝説

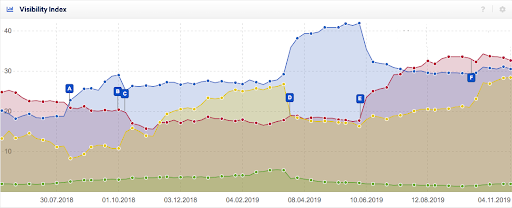

15.よく知られたWebサイトは、あまり知られていないWebサイトよりも、常に上位に表示される

大規模なWebサイトには、小規模なWebサイトにはないリソースがあることは、当然である。その結果、SEOへのより多くの投資が可能となる。

より魅力的なコンテンツが作成され、より多くのバックリンクを獲得することができる。ブランド名が知られることで、リーチ活動の信頼性がより高まる。

問題は、Googleはビッグブランドの知名度を、アルゴリズムや人の手によって、意図的に高めているのだろうか?ということである。

これについての議論は存在する。

Googleはビッグブランドを優遇していると主張する者もいる。Googleはそうではないと言っているが。

2009年、Googleは”Vince”というアルゴリズムをリリースした。このアップデートは、検索結果におけるブランドの扱いに大きな影響を与えた。

オフラインでよく知られているブランドは、競争の激しいキーワードで上位に表示されるようになった。

小規模なブランドは勝負を諦めるべき、ということではない。

Vinceアップデートは、権威性と品質を重視するGoogleの他の動きと合致したものである。

ビッグブランドは、小規模なブランドと比較し、広域のキーワードでより権威性があることは、よくある。

しかし、小規模なブランドにも勝機はある。

ロングテールのキーワード、ニッチな製品、ローカルでの露出など、これらは全て小規模なブランドの方が関連性を高めることが可能なものである。

もちろん、ビックブランドが有利な状況に変わりはないが、ビックブランドを凌駕することが不可能であるわけではない。

判定:全てが事実であったり、都市伝説であったりするわけではない

16.ローカルSEOで上位に表示されるためには、「近くの○○」をページに含める必要がある

この都市伝説がいまだに広まっていることは理解できる。

SEO業界では、いまだにキーワードの検索ボリュームが重視されている。その結果、ユーザーの意図や検索エンジンによる理解を疎かにしてしまうこともある。

検索者が「ローカルの意図」、つまり、物理店舗の場所やサービスなどを探している場合、検索エンジンはこの点を考慮した上で、検索結果を返す。

Googleにおいては、通常の検索結果に加え、Googleマップの結果が表示されることもあるだろう。

Googleマップの検索結果は、検索された場所を中心に表示される。しかし、検索クエリがローカルの意図を含んでいる場合は、通常の検索結果も同様である。

では、なぜ、「近くの○○」という検索は、混乱を招くのだろうか?

一般的なキーワード調査の結果は、下記のようなものだろう。

- ピザレストラン マンハッタン – 110(月間検索数)

- マンハッタン ピザレストラン – 110 (月間検索数)

- マンハッタンで一番おいしいピザ屋 – 90回 (月間検索数)

- マンハッタンで最高のピザレストラン – 90 (月間検索数)

- 近くのピザレストラン – 90,500 (月間検索数)

検索ボリュームがこのような場合では、「近くのピザレストラン 」が上位に表示されるのでは?と考えるのも無理はない。

しかし、「ピザレストラン マンハッタン」と検索するユーザーは、現在マンハッタン周辺にいる人か、マンハッタンにピザを食べに行く予定の人であると考えることができる。

「近くのピザレストラン」は、全米で90,500回検索されている。これらの検索の大部分が、マンハッタンのピザレストランを探しているわけではないだろう。

Googleはこのことを理解しており、位置情報を用い、検索者がいる場所に関連したピザレストランを、検索結果に表示するようにしている。

そのため、「近くの○○」という検索においては、キーワード自体よりも、キーワードの背後にある意図が重視されるようになる。Googleは、検索者がいる場所だと考えるのみである。

では、「近くの○○」という検索で上位に表示されるためには、「近くの○○」というコンテンツを含める必要があるのだろうか?

いや、そうではない。検索者がいる場所に関連している必要があるのだ。

判定:SEOの都市伝説

17.コンテンツが良ければ上位に表示される

SEOのフォーラムやTwitterのスレッドでよく言われていることである。よくある不満としては、「私のコンテンツは素晴らしい。しかし、競合サイトのページが上位に表示されている。彼らのコンテンツはひどいものなのに」といったものだ。

強い不満を持っている。詰まるところ、検索エンジンは「素晴らしい」コンテンツがあるWebサイトに恩恵を与えるべきではないのだろうか?と。

これは都市伝説であり、妄想とも言える。

コンテンツの品質というのは主観的なものである。自分自身のコンテンツに対しては、客観的に判断することはより難しくなるだろう。

おそらく、Googleからすると、あなたがターゲットとしている検索ワードにおいて、競合サイトのコンテンツよりも、あなたのコンテンツの方が優れているとは映っていないのだろう。

おそらく、競合サイトほど、検索者の意図に合致していないのかもしれない。

もしかしたら、コンテンツを「過度に最適化」してしまい、結果として品質を落としてしまっているのかもしれない。

コンテンツの質が高ければ、順位が上昇するといったケースはある。また、サイトの技術的なパフォーマンスの低さや、ローカルの関連性の低さが要因となり、順位が下がることもある。

コンテンツは、ランキングアルゴリズムの中の1要素に過ぎないのだ。

判定:SEOの都市伝説

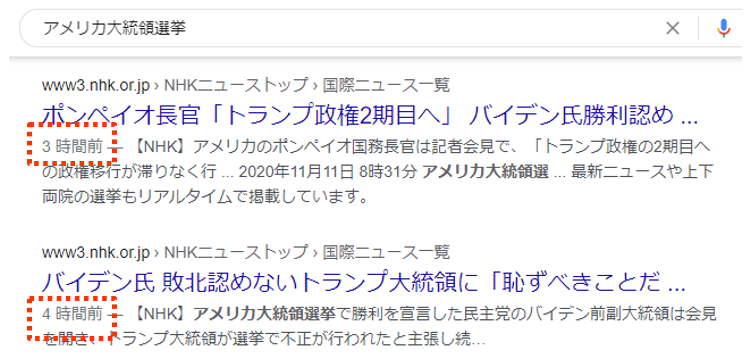

18.ブログを毎日更新すべき

この都市伝説は非常に残念なものである。なぜなら、SEO業界以外にも広まってしまっているからである。

Googleは更新頻度の高いコンテンツを好む。そのため、新しいコンテンツを追加したり、既存のコンテンツを調整したり、Webサイトの「新鮮さ」を保つために、毎日ブログを更新すべきである。

このような考えはどこから来たのだろうか?

2011年、Googleはアルゴリズムのアップデートを行い、より新鮮なコンテンツに恩恵を与えるようにした。

これは、一部のクエリにおいては、新鮮なコンテンツであるほど、正確性が増すからである。

例えば、2013年のイギリスで、「ロイヤルベイビー」と検索すると、ジョージ王子に関するニュース記事が検索結果に表示されていた。2015年に「ロイヤルベイビー」と検索した場合は、シャーロット王女に関するページが表示されていた。

2018年では、Googleの検索結果にはルイ王子に関する記事が上位に表示され、2019年では、アーチーちゃんの記事が上位に表示された。

もし、2019年のアーチーちゃんが生まれた直後で「ロイヤルベイビー」と検索した場合、ジョージ王子のニュース記事が上位に表示されても何の役にも立たないだろう。

この例では、Googleはユーザーの検索意図を判断し、最も新しいイギリスのロイヤルベイビーに関連する記事を上位表示するようにした。権威性などの要素から判断するよりも、より良い検索結果になる、という判断だ。

このアルゴリズムは、新しいコンテンツが古いコンテンツよりも常に上位に表示される、ということを意味するわけではない。Googleは、「そのクエリが新鮮さに値するかどうか」を判断するのである。

もしそうであれば、コンテンツの年齢がより重要なランキング要素となる。

つまり、単純に競合他社よりも新しいコンテンツを作成するだけで、常に上位に表示されるとは限らないのである。

例えば、「ウィリアム王子の2番目の子供はだれ?」といったクエリのように、ターゲットとしているキーワードが新鮮さに値しない場合、コンテンツの年齢は重要なランキング要素とはならないのである。

もしも、あなたが毎日コンテンツを書いており、その目的がWebサイトの鮮度を保ち、ランキングでの評価を高めることであれば、それは時間の無駄と言える。

よく練られ、調査され、有益なコンテンツを、頻度を少なくしてでも書き、権威性や共有性の高いコンテンツを作成するためにリソースを確保した方が良い。

判定:SEOの都市伝説

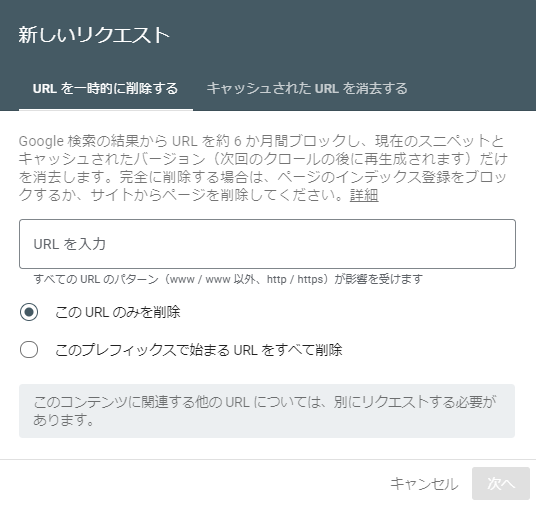

19.コピーは一度最適化すれば完了

「SEOに最適化された」コピーというのは、エージェンシーの世界ではよく使われるフレーズである。

これは、よく検索されるクエリに関連したコピーを作成するプロセスを説明する際に、よく使われる。

この表現の問題点は、一度コピーを書いて、検索者の質問に適切に答えていることを確認すれば、もう次に進むことができる、という考えに基づいていることだ。

残念ながら、検索者によるコンテンツの探し方は、時間と共に変化する。使用するキーワード、求めるコンテンツの種類なども変化することもある。

また、検索エンジン自体も、クエリに対する最も関連のある答えに対する考えを変更するかもしれない。そのため、キーワードの背後にある意図への認識も変化するかもしれない。

検索結果画面のレイアウトも変化するかもしれない。例えば、今までは通常のWebページが検索結果に表示されていたとしても、動画が最上部に表示されるかもしれない。

ページを一度見ただけで更新することはせず、ユーザーのニーズに合わせて進化させずにいると、相対的な遅れとなる可能性がある。

判定:SEOの都市伝説

20.SEOには正しい方法がある

これは複数の業界で言われていることではあるが、SEO業界では一般的なようだ。SEOのソーシャルメディア、フォーラム、チャットなどでは、多くのゲートキーピングが行われている。

残念ながら、話はそう単純ではない。

SEOについては、核となる考えがいくつか存在する。

通常、検索エンジンの代表者によって述べられたものは、分解され、テストされ、そして、最終的に真実だと宣言される。

それ以外は、個人的、もしくは、集団的なトライアンドエラー、テスト、そして経験による結果である。

SEOのビジネスの機能として、プロセスは非常に価値のあるものだ。しかし、それらは、進化し、適切に適用されなければならない。

異なる業界内の、異なるWebサイトが、他のWebサイトとは異なる方法で、変化に対応していく。メタタイトルを60文字以下の長さに変更することで、クリック率の向上の助けとなるかもしれないが、別のページではそうではないかもしれない。

最終的には、何らかのSEOにおけるアドバイスをもらった場合、その内容が自分のWebサイトに適しているかどうかを、事前に考える必要があるのだ。

判定:SEOの都市伝説

結論

都市伝説の一部は、何らかの論理によって発生したものもある。また、それ以外は、意味のないものもある。

今回の記事を読むことで、真実かそうでないか判断がつかない考えを耳にしたとき、その対処法が理解できたと思う。

全部で20個の都市伝説を紹介した、ボリュームのある記事でした。SEOに長く携わっていなければわからないもの、長く携わっているからこそ信じてしまうもの、それらは様々ありますが、「自身のWebサイトにとって必要かどうか?」はすべてのWebサイトで共通する考えだと思います。Googleの進化に併せ、都市伝説の進化(?)は今後も続くと思われますが、実装する前の考察と検証は、ぜひ行いたいと思います。

この記事は、Search Engine Journal に掲載された「How to Spot SEO Myths: 20 Common SEO Myths, Debunked」を翻訳した内容です。

投稿 SEOのよくある20の都市伝説 は SEO Japan|アイオイクスのSEO・CV改善・Webサイト集客情報ブログ に最初に表示されました。

time.

Lisette’s Café & Bakery, Subang Jaya