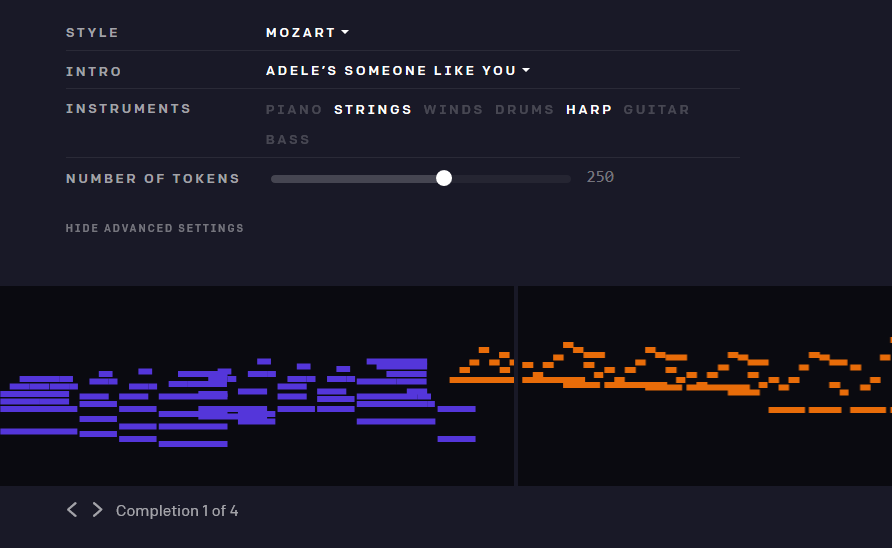

これまでに、ケイティ・ペリーによる、モーツァルトスタイルのピアノとハープの協奏曲を聞きたいと思ったことはあるだろうか?試してみても良いはずだ。なぜなら、今やOpenAIの最新の成果であるMuseNetを使えば、それが可能になったからだ。幸いなことに今回の成果物は破滅的な可能性は秘めていない。

この機械学習モデルは、アーティストの知識に基づき、数小節を与えられることで、これまでになかった音楽を生み出すことができる。

これまでこうした例がなかったわけではない。コンピューターによって生成される音楽はすでに何十年前から存在している。しかしOpenAIのアプローチは柔軟性があってスケーラブルなもののように思える。様々なジャンルやアーティストの情報に基いた音楽を生成し、それらを自由な音のスタイルで組み合わせるのだ。このモデルは多くのDNAを、「公開するには危険すぎる」言語モデルGPTと共有しているが、無限に音楽を世界に流し続けることの脅威は、自動生成されたものと判定できないコンピューター生成テキストが流されることに比べれば、小さいように思える。

MuseNetは数十人のアーティストたちの作品によって訓練を受けている。使われたアーティストは、ショパンやバッハから(比較的)モダンなアーティストであるアデルやビートルズまで、そしてアフリカ、アラビア、そしてインドの作品も含まれている。その複雑な機械学習システムは「アテンション」に多くの労力を使っている。これはAIにおける専門用語で、基本的には、創作の次のステップに対してモデルが使うコンテキストの量を意味している。

たとえば、モーツァルトの作品を見てみよう。もしモデルが一度に数秒分しか学習しないとしたら、強弱に満ち、音調や楽器が切り替わって行くような、交響曲のより大きな音楽の構造を学習することはできないだろう。しかし、今回使われているモデルには、音を約4分間保持できるくらい十分な仮想脳空間が与えられている。これはゆっくりとしたスタートから壮大なフィニッシュまでや、基本的なヴァース・コーラス・ヴァース形式を取り込むのに十分な長さだ。

ハイドンがシャナイアに直接影響を及ぼしていないって?現実を見よう

まあもちろん理論的にはということだが。モデルは実際には音楽理論を理解してはいない。理解しているのは、この音があの音に続いていて、そのあとにはこの音が続き、そしてこんな種類のコードが続く傾向がある、というものだけだ。その作品は構造的には初歩的なものだが、取り込まれた楽曲が非常によく模倣されていることは、聞いたときに明らかにわかる。

印象的なのは、1つのモデルが、非常に多くの種類の音楽にわたって確実にこれを行うということだ。数週間前のBachの誕生日に公開された素晴らしいGoogle Doodleのように、特定のアーティストやジャンルに焦点を当てたAIは、これまでも作成されてきた。そしてまた別の比較のために、Generative.fmも挙げておきたい。これは私が仕事している際に聞きたい静かな環境音楽を生成してくれる(もし読者がこれを気に入ったなら、私のお気に入りの1つのレーベルであるSereinもチェックしてほしい)。しかし、これらのモデルはどちらも非常に厳しい制約を抱えている。一方MuseNetにはそうした制約はあまりない。

ブルーグラスやバロック様式のピアノ曲を無限に作り出すことに加えて、MuseNetは両方の特徴を組み合わせるために、スタイル転送プロセスを適用することができる。作品のさまざまな部分がさまざまな属性を持つことができる。絵を描く際に、構成、主題、色の選択およびブラシスタイルなどを選ぶようなものだ。ラファエル前派の主題と構成を、印象派の技法で描くことを想像してほしい。なんだか楽しそうじゃないか?AIモデルは、こうした異なる側面を分類していくことが得意なので、そういう生成作業はお手のものなのだ。音楽の場合でもそのパターンは変わらない。ポップソングの音階やリズム、その他のパターンを抽出し、その楽器編成とは別に利用することができる。ハープを使ってビーチ・ボーイズのハーモニーを楽しんでもいいはずだ。

とはいえ、アデレのような雰囲気のものを、彼女の特徴的な声なしに生み出すのは少し難しい。そしてチームが選択した比較的基本的な合成手法は全体的に効果を安っぽくしている。そして、チームがTwitch上で提供した「ライブコンサート」を聴いても、MuseNetが次のヒットを量産してくれるとは、私には思えなかった。だがその一方で、特に少々の調子外れが許容される、ジャズやクラシックの即興演奏では、素晴らしい進歩を着実に挙げている。

とはいえ、アデレのような雰囲気のものを、彼女の特徴的な声なしに生み出すのは少し難しい。そしてチームが選択した比較的基本的な合成手法は全体的に効果を安っぽくしている。そして、チームがTwitch上で提供した「ライブコンサート」を聴いても、MuseNetが次のヒットを量産してくれるとは、私には思えなかった。だがその一方で、特に少々の調子外れが許容される、ジャズやクラシックの即興演奏では、素晴らしい進歩を着実に挙げている。

これは何のために使われるものだろう?そうした疑問はもっともだ。この分野はまったく新しいものである。MuseNetのプロジェクトリーダーであるクリスティーヌ・ペイン(Christine Payne)氏は、このモデルに満足していて、それを利用する人も既に見つけている。

クラッシック音楽の訓練を受けたピアニストとして、私はMuseNetがベートーベンやショパンの複雑な和声構造を理解できることに、とても興奮しています。私は現在、MuseNetを彼自身の作曲作業に統合することを計画している、ある作曲家と協力しています、人間とAIの共同作曲の未来が、私たちを連れて行く場所を目にすることにワクワクしています。

OpenAIの代表者の1人は、モデルが自分の作品をどのように解釈したり模倣するのかを知りたいと思っている現代の作曲家たちの作品を、チームが統合する作業も始まったと述べた。

MuseNetは5月中旬までプレイできるようになっている予定で、その後一度オフラインになり、ユーザーからのフィードバックに基づいて調整される。その後程なく(数週間だと思われるが)、少なくとも部分的にはオープンソースとなる予定だ。おそらく人気のある組み合わせや、人々がずっと耳を傾けている組み合わせが、調整によってもう少し重みを与えられることになるのだろうと想像している。彼らがMIDIの再生にもう少し表現力を追加してくれることを願っている。しばしば曲がロボットによって演奏されているように感じられるからだ。しかし、しばしばそのサウンドがとても素晴らしく聞こえることは、OpenAIの仕事の質の高さを証明している。

[原文へ]

(翻訳:sako)