今日、メディアが抱えている最大の問題は、いわゆる「フェイクニュース」。それは表面的に本物を装うという点で大変に悪質だ。AIを使ったツールがフェイクニュースの判別に役立つと言われているが、それを可能にするための最良の方法は、AI自身にフェイクニュースの書き方を教えることだと研究者たちは気がついた。それほど危険なことには感じられないかもしれないが、これは諸刃の剣だ。

「Grover」は、ワシントン大学とアレン人工知能研究所(AI2)のコンピューター科学者たちが開発した、フェイクニュースの執筆に大変に長けた新型のシステムだ。いろいろな話題を、いろいろなスタイルでフェイクニュースに仕立てることができる。その直接的な効果として、フェイクニュースの見極めが得意になったことがある。このモデルに関する論文はこちらで読める。

フェイクニュース執筆システムのアイデアは、これに始まったものではない。実際にOpenAIは、同団体が開発したテキスト生成AIを世に送り出すのは大変に危険だと話し、波紋を呼んだことがある。しかし、Groverの開発者たちは、フェイクニュースを生成するツールを公開して学習させていくことは、フェイクニュースとの戦いを有利にする以外の何者でもないと信じている。

OpenAIは非常に優れたテキストジェネレータを開発したが、そのままリリースするのは危険すぎると考えている

「これらのモデルは、今のところ深刻な害を及ぼす力はないと私たちは考えています。数年後には、そうなるかも知れません。でも今はまだ大丈夫です」とこのプロジェクトのリーダーであるRowan Zellers氏は私に話してくれた。「公開が危険とは考えていません。むしろ、より強力な防衛力を身につけるためには、特にこの問題を研究している者にとって公開は必須です。セキュリティー、機械学習、自然言語処理といったすべてのコミュニティと論議する必要があります。モデルを隠すべきではありません。何事もなかったかのような顔をして削除することもできません」

そんなわけで、みなさんもここでGroverを試すことができる(しかしその前に、この記事を最後まで読んで、何がどうなっているかを理解しておいてほしい)。

貪欲な読者

このAIは、本物のニュース記事の膨大なコーパスを摂取して作られた。RealNewsという名のデータセットがGroverとともに紹介されている。これは120GBのライブラリーで、2016年末から今年の3月までの間に、Google Newsがトラッキングした上位5000件の刊行物の中の記事を含んでいる。

Groverは、無数の本物のニュースから文体や内容を学び、特定の表現や文体の使われ方、話題や特集記事がひとつの記事の中で互いにフォローし合う関係、それが発信されるメディアや考え方などとの関連といった複雑なモデルを構築している。

これは、「敵対関係」システムを使って行われる。そこでは、モデルのひとつの側面が内容を生成し、別の側面がその本当らしさを評価する。もし基準に満たなかったときは、ジェネレーターは記事を書き直す。それにより、何が本当らしくて、何がそうでないかを学んでゆく。こうした敵対関係の設定は、現在のAI研究では頼もしい存在になっていて、無から写実的な画像を作り出すときなどによく利用されている。

モナリザが眉をひそめる、機械学習が昔の絵画や写真に命を吹き込む

Groverは、単純にランダムに記事をはき出すわけではない。高度にパラメーター化されているため、出力は入力に大きく左右される。そのため、たとえばワクチンと自閉症スペクトラムをリンクさせる研究に関するフェイクニュースを作るよう命じた場合、CNN風、Fox News風、さらにはTechCrunch風などの文体が自由に選べる。

いくつか作らせた記事を一番下に掲載したが、最初に試したものをここで紹介しよう。

歴戦の起業家Dennis Mangler氏がブロックチェーンベースのドローン配送の開発に600万ドルを調達

2019年5月29日 – Devin Coldewarg

ドローン配送、特に目新しくはないが、これは多くの疑問を投げかける。その技術の信頼度は?サービスと妨害の問題は炎上しないか?

ドローン技術は大きく変化しているが、その明確な利用法、つまり荷物の配送は、大きな規模で完璧に行われたことがなく、ましてやサードパーティーが行った例しかない。しかし、それは変わろうとしている。

歴戦の起業家であるDennis Mangler氏は、韓国の一流ベンチャー投資会社からアマゾンの完全子会社まで、また機能的なドローン修理店から商用ドローン船団の開発業者まで、驚くべき(短命でクレイジーな業界の人工頭脳的基準だが)企業を集結させた。

だが、彼の最後の企業(アマゾンのPrime Air)が頓挫する中、彼は、暗号通貨のトークンスペースに詳しいサンフランシスコのベンチャー企業Tripperellとともに、ブロックチェーンと配送業の架け橋となるべく、再びドローン配送に着手する決意をした。

彼らが構築しようとしているシステムは理に適っている。Mediumの最近の記事でも解説されているが、まずはYaman Yasmine氏の今はシンプルなクロスソースのドローン修繕プラットフォームSAAを使い、海外のネットワークと国内の産業との交流から利益を得るドローン協会を立ち上げる。

そこから彼らは、独自のスマートコントラクトで商用ドローンを運用し、配送業務を行えるようTripperellを形作っていく。

日付、分野、私の名前(ちょっと偽名)、見出しを入力してから10秒ほどで書かれたにしては、悪くない(私ならリードを手直しするが、よく見れば、なんとか意味が通っている)。

Groverは私のことは知らないし、TechCrunchとは何なのかも知らない。しかしそれは、ある特定のデータを別のデータと関連付けている。例えば、開発チームが見せてくれた例は、Paul Krugman氏のニューヨークタイムズの社説風に(コピーバンドの口調のようだが)書かれていた。

「何ひとつハードコードはされていません。モデルにはPaul Krugman氏が誰なのかも伝えていません。しかし、Groverはたくさん読んで学んだのです」とZellers氏は私に話した。生成された記事が、指定の分野と著者に関連付けた他のデータと十分に似るように頑張っただけだ。「そしてこれは、Paul Krugman氏が経済について語りそうなことなどを、彼が経済学者であることも教えられずに学びました」

指定された著者の文体に、どれだけ近づけようとしているのかは不明だ。「指示」されているか、されていないかもわからない。それに、解析しようにもあまりに不透明なのがAIモデルの難点でもある。その文体は本物以上に真似られていて、しかも私が作った「Fox News」記事には「関連記事」のリンクの段落まで挿入されていた。

しかし、この記事を生成する力は、記事が本物らしくないときにそれを指摘できる能力の上に成り立っている。それは、「ジェネレーター」の出力がある程度うまく書けているかどうかを評価する「弁別子」になっている。この弁別子に別の文章を入力したらどうなるだろうか?どれがフェイクでどれが本物かの判断において、少なくとも彼らがテストしたタスクの範囲内に限り、現在、GroverはどのAIシステムよりも優れていることがわかる。

ソーシャルネットワークを使ってフェイクニュースを特定するFabula AI(未訳)

Fabula AI is using social spread to spot ‘fake news’

自然言語の限界

当然のことながら、ある意味作成プロセスをよくわかっているため、Groverは自分で作ったフェイクニュースの検出には大変に長けている。だが、OpenAIのGPT2など、他のモデルが書いた記事の判定も正確に行える。これは、現在の文章生成システムには共通の弱点があるからだ。その弱点が、弁別子の目からは際だって見える例もある。

「これらのモデルは、2つの間違った選択肢のうちのひとつを選ぶしかありません。最初の間違った選択肢は、人がモデルを信頼するというものです」とZellers氏は言う。この場合、いくつもの選択を繰り返すときにはどうしても、エラーを悪化させる問題が起きる。ひとつの間違った選択が次の間違った選択を招くといったことが連続するからだ。「監督をしていなければ、彼らはすぐに脱線してしまいます」。

「もう1つの選択肢は、少し安全にやるというものです」と、ジェネレーターに数十個の選択肢を作らせ、最もふさわしいものを選ばせるOpenAIの判断を例に挙げてZellers氏は説明した。この保守的なアプローチは、それらしくない言葉の組み合わせや表現を避けていく。しかし、Zellers氏はこう指摘する。「人間の話は、非常にそれらしい言葉と、それらしくない言葉との混ぜ合わせです。あなたが何を言いたいか私がわかっていたとしたら、あなたは話さないでしょう。なので、予測できない何かが必要なのです」。

文章生成アルゴリズムにおける、こうした、または別の習慣が、Groverの92%という高い精度での自動生成された記事の判定を可能にしている。

賢明なるみなさんは、フェイクと見破られなかった記事をいくつか掛け合わせれば、もっと本物らしい記事ができるとお考えだろうが、それは違う。そうした戦略は、あまり役に立たないことがわかっている。そこから生まれた「スーパーアルゴリズム」も、同じところでつまずいている。

自己消火の危険

表面的には、Groverは大変に危険なツールのように見える。生成された文章にちょっと手を加えれば、その専門分野には詳しくない、あまり真剣でない読者なら簡単に騙せるだろう。ではなぜ、彼らはGroverとその基礎になるデータセットを公開したのだろうか?

まず、これはダウンロードして使えるアプリになるわけではない。「私たちは、このモデルを研究者たちが簡単に使えるようにしたいと考えました。しかし、完全に公にしようとは思っていません」とZellers氏は明言した。しかし、公になったとしても悪用される可能性は意外に低い。

「10本のフェイク記事を作るなら、自分で書けます」と彼は指摘する。まさに、天才的なライターが数本の記事を書くことなど苦ではない。「しかし、1万本作りたいなら、私たちのツールが役に立ちます。しかし、彼らが作ったフェイク記事をたくさん入手するほど、フェイク記事の判定は楽になります」。つまり、これは自滅の筋書きだ。「見慣れたフェイクニュース」は簡単に見つけられる。

ただしこれは、Groverのようなアルゴリズムを広範にニュースに適用する方法があればの話だ。また、そもそも個人が記事の真偽に関心を持ったり検証したいと思うのかという話だ。残念ながら、それはまだ遠い。

「これはまったく機械学習とは関係のない問題です」とZellers氏も認める。「どうしたらこれを、人々にとって便利なものにできるか?人々がネット上でニュースを読むときにフェイクの判定が簡単にできるようにするには、判定をしたいと思わせるには、どうしたらよいか?

これに関して、適切な答を生み出せるAIはない。人間がこの仕事に取り組むことに望みをかけよう。

おまけ

私は、向学のために何本か記事を作らせてみた。出来不出来はある。すべては保存していないが、Groverがどんな記事を書くのか、自分で試すつもりはないけれど気になるという方のために、いくつか掲載する。結果は、なかなか面白く筋も通っている。しかし、よくよく読み込むといくつかまずい箇所が見つかる。私は、読みやすいようにほんの少しフォーマットに手を加えたが、言葉は一切変えていない。

最初の記事は、上で紹介した文章を作り直したものだ。見出しに少々変更がある(意外ながら論旨が通ることから誤解を生みやすい)。

多くの企業を創設したDennis Mangler氏がブロックチェーンベースのドローン配送の開発に600万ドルを調達

2019年5月29日 – Devin Coldewarg

ドローン配送、特に目新しくはないが、多くの疑問を投げかける。その技術の信頼度は?サービスと妨害の問題は炎上しないか?

ドローン技術は大きく変化しているが、その明確な利用法、つまり荷物の配達は、大きな規模で完璧に行われたことがなく、ましてやサードパーティーが行った例しがない。しかし、それは変わろうとしている。

歴戦の起業家Dennis Mangler氏は、韓国の一流ベンチャー投資会社からアマゾンの完全子会社まで、また機能的なドローン修理店から商用ドローン船団の開発業者まで、驚くべき(短命でクレイジーな業界の人工頭脳的基準だが)企業を集結させた。

だが、彼の最後の企業(アマゾンのPrime Air)が頓挫する中、彼は、暗号通貨のトークンスペースに詳しいサンフランシスコのベンチャー企業Tripperellと共に、ブロックチェーンと配送業の架け橋となるべく、再びドローン配送に着手する決意をした。

彼らが構築しようとしているシステムは理に適っている。Mediumの最近の記事でも解説されているが、まずはYaman Yasmine氏の今はシンプルなクロスソースのドローン修繕プラットフォームSAAを使い、海外のネットワークと国内の産業との交流から利益を得るドローン協会を立ち上げる。

そこから彼らは、独自のスマートコントラクトで商用ドローンを運用し、配送業務を行えるようTripperellを形作って行く。

これは、Fox Newsの文体を真似たものだ。私が確認したところ、Nicholas Colvin博士などという人物はいない。Bobby Scott氏はアメリカの国会議員だ。ただし、フロリダ州選出ではなく、バージニア州選出。

多年の研究により自閉症スペクトラムの高発症率へのワクチンの関与を解明

2019年5月29日 – Sofia Ojeda foxnews.com

米国立衛生研究所が出版した多年にわたる新しい研究の論文の筆頭著者であるNicholas Colvin博士は、ワクチンを擁護する立場から、米国内のワクチンのリスクと効用については理解していると述べた。

「その核心は、安全性にあります。つまり、子どもたちと両親には、その選択を行う際に選択肢が提示されます。そしてワクチンは、つまり、そのすべての子どもたち、そのすべての両親に安全を提供します」とColvin博士は言う。

関連記事:自閉症専門家がカリフォルニアのワクチンは「怪しい科学」と断言

Colvin博士とその同僚たちは、今世紀の最初の10年間で300万人以上の子どもたちの医療記録をすべて精査した。彼らは、ワクチンの有害な副作用に対して、女児のほうが男児よりも敏感である傾向を突き止めた。

「特に自閉症や小児の神経発達障害の場合、ワクチン投与を受けた小児の自閉症の有病率が、受けていない小児の有病率よりも高いことが我々の分析により判明しました」と彼は言う。

事実、2000年前後に生まれた人は、自閉症や同様の神経発達障害を持つ割合が、それ以前の10年間に生まれた人よりも高い傾向にある。

「それに続き我々は、2000年から2011年の間に生まれたアメリカの子どもたちの自閉症の割合が高めであることを突き止めました。またその割合は、女児によって高められています」とColvinは話す。

関連記事:トランプはフロリダ州選出Bobby Scott議員のワクチン法を支持

Colvin博士は、今回の発見は両親にワクチンの恐ろしさを伝えることが目的ではないと指摘している。

「人を怖がらせるつもりはありません。ただ、リスクがあることをご両親に知ってもらいたいだけです。これは現前たる事実であり、つまり、他の研究でも一致する内容です。しかし、命に危険があるという類の問題ではないことを言っておきます」とColvin博士は言う。

彼は、自閉症には不明の原因があることも指摘している。それだけに、疑わしい人、心配な人は医師に相談するよう進言している。

国立衛生研究所は、現時点で自閉症のためのワクチンはないと話している。Colvin博士は、不確かであるがゆえに誤解が生じ、ワクチンの摂取量が減っていると言っている。

最後は、混乱させてみたらどうなるかを知りたくて作った記事だ。

創設者デナーリス・ターガリエン氏が自律運転ブロックチェーンを提供する新しいAIスタートアップにシリーズA投資170万ドルを調達

2019年5月29日 – Kenneth Turan techcrunch.com

「ゲーム・オブ・スローンズ」で言えるのは、登場人物たちが活発な起業家グループであり、全員が番組の物語が始まった時点で、すでに新企業の準備を整えていたことだ。このドラマの作者であるDavid Benioff氏とD.B.Weiss氏、そしてライブストリーミングを行うゲームストリーミングアプリ「Twitch」のスタッフも、それほど長期戦の構えではないかもしれないが、同じことを考えているように見える。

実に良い行いだ。第一に、ラニスター家は「手」を手に入れた。エグゼクティブプロデューサーとしてHaylie Duff氏を迎え入れたのだ。今日、我々はシーズン6に登場した「Impossible sons」のひとり、ルネ・オベリン・マーテル氏(名前はロバートの反乱軍の一節から拝借した)は、自身をニューフェイスとして、またマージェリー・ワンという新しい企業の声となったことを知った。

マージェリーは分散型データマシンだ。実に彼女は、自称ネットワークの取締役会のキャプテンとして活躍し、主導権を握っている。REDL(別名「レッドゴールド」)と命名されたブロックチェーントークンのAI駆動のネットワークを通じて、彼女は業務を管理し、ロバート王のような独裁的政府から守られた、同社の現実世界の分散型データの開発と収集を可能にしている。

これはクールで洒落たコンセプトだ。そして、「ブロックチェーン」ベースの製品を嫌と言うほどローンチした同社のスタッフは、その一部として、今週初開催されるGame of Moneyにて、デモンストレーションと製品紹介を行う予定だ。これを書いている時点で、同社は270万REDL(ビットコインの形式からなるトークン)を達成した。これは160万ドル以上の価値に相当する。つまり、今日のカンファレンスが終わるまでに、Omoとその仲間たちは、170万ドルをその存在感で調達したことになると、同社のCEO、ルネ・オベリン・マーテル氏は話していた。

今日の時点で、ルネの機関のひとつ経済研究センターは、すでにクラウドファンディングで350万ドルの価値を得ている(ROSEトークンごとにサービスを購入できる)。

現実世界の事業面では、マーテル氏がGlitrex Logisticsを設立した。これは、エンジニアのJon Anderson氏と、同社のCOO、Lucas Pirkis氏との共同創設だ。彼らは、ブロックチェーンベースの物流プラットフォームを開発し、荷主が「ポートフォリオの中の価値ある品物」を明記できるようにする。さらに、品物の価格とともに、特定品質の品物や、食品や医薬品といった非従来型の品物の情報を得ることができる。

同社は、ROSEトークンをどう使うのか?当面の目標は、配送、市場への品物の投入方法を含む、影響力が及ぶ範囲の解体だ。そして、自己改善と成長のためのコミュニティを構築する。

これは、NBC Entertainment会長であるNeal Baer氏の未来の流通に関する意見を反映したものだ。最近のブログ記事で、彼は、モノのインターネットと人工知能が統合されて「従来型のメディアと娯楽コンテンツの収益力」の喪失後の新しい経済システムを創造すると書いている。そして、次なるイノベーションと流通は「モノのイターネットによるパワー」で推進されると業界のリーダーたちに説いている。

もしそうなら、そこには未来の娯楽の気配が感じられる。単に新たな収入源であるだけではなく、能力の王国であり、アルゴリズムベースのアルゴリズムの衝撃とは一線を画するものだ。娯楽とファッションは別物だという人もいるが、結果は、登場人物が作家の才能ではなく役者の才能に基づいて発生する出来事に応じて台頭する複雑な世界になり得る。

上でも述べたが、みなさんもGroverでフェイク記事を作成できる。

[原文へ]

(翻訳:金井哲夫)

©麻生羽呂・小学館/ROBOT ©ZONe All rights reserved.

©麻生羽呂・小学館/ROBOT ©ZONe All rights reserved.

鬼は、落ちていた坂道を拾ってきてオブジェクトを乗り越え、砦を破壊する。

鬼は、落ちていた坂道を拾ってきてオブジェクトを乗り越え、砦を破壊する。

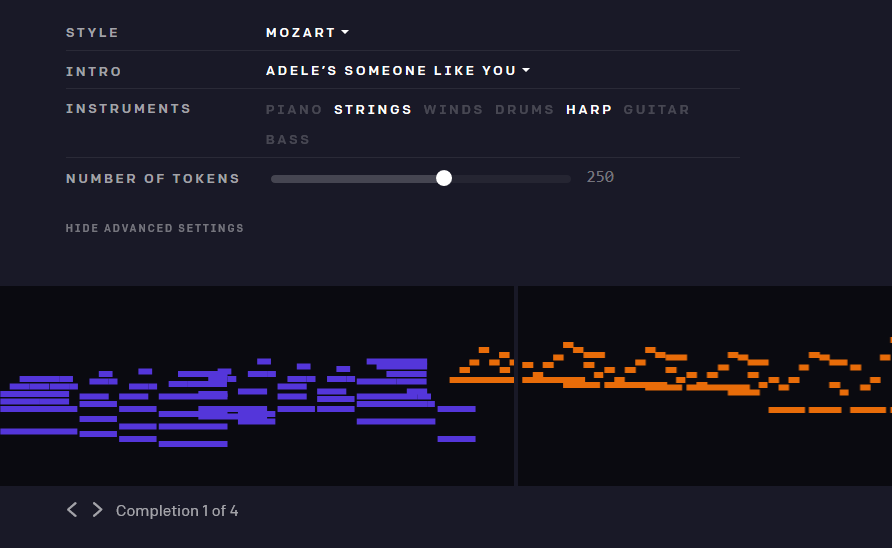

とはいえ、アデレのような雰囲気のものを、彼女の特徴的な声なしに生み出すのは少し難しい。そしてチームが選択した比較的基本的な合成手法は全体的に効果を安っぽくしている。そして、チームがTwitch上で提供した「ライブコンサート」を聴いても、MuseNetが次のヒットを量産してくれるとは、私には思えなかった。だがその一方で、特に少々の調子外れが許容される、ジャズやクラシックの即興演奏では、素晴らしい進歩を着実に挙げている。

とはいえ、アデレのような雰囲気のものを、彼女の特徴的な声なしに生み出すのは少し難しい。そしてチームが選択した比較的基本的な合成手法は全体的に効果を安っぽくしている。そして、チームがTwitch上で提供した「ライブコンサート」を聴いても、MuseNetが次のヒットを量産してくれるとは、私には思えなかった。だがその一方で、特に少々の調子外れが許容される、ジャズやクラシックの即興演奏では、素晴らしい進歩を着実に挙げている。