10月にGoogleがVisual Coreを発表したときは、ちょっと意外だった。Pixel 2が発表されたから3週間後に、そのハンドセットに最初からあったSoCについてあらためて発表するなんて、ね。

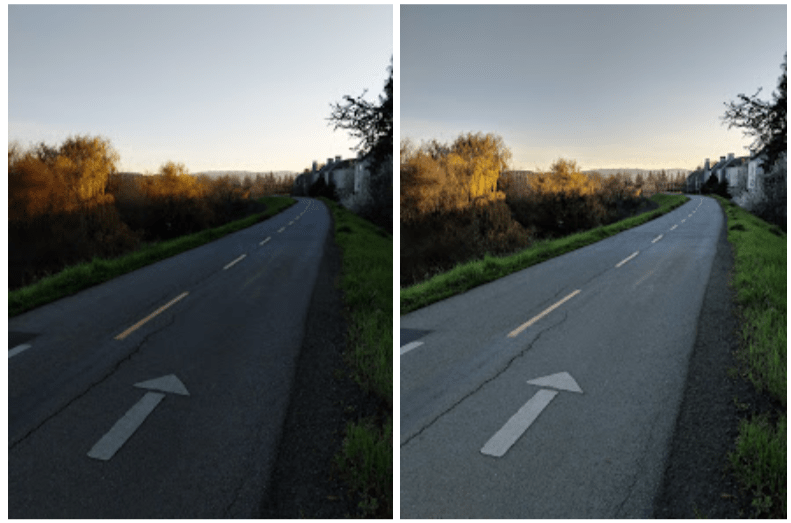

その写真専用のプロセッサーはほとんどもっぱら、Google自身のアプリで撮った写真を改良することが目的で、とりわけ、PixelのカメラアプリにHDR+の技術を付与する。その技術は主に、Googleのコンピューテーショナルフォトグラフィー(computational photography, 計算写真学)と機械学習を利用して、写真の画質を上げる。

そして今回は、約束どおり、この技術がサードパーティのアプリにも適用される。もちろんGoogleのハードウェアの上でも、Google以外のソフトウェアで取られる写真がとても多いだろう。また一部の著名なアプリだけでなく一般的にサードパーティの写真アプリが、この技術をGoogle公認で使えるようになった。

Googleは12月にAndroid 8.1の公開ベータの一環として、この機能のデベロッパープレビューを発表した。そして今日からはPixel 2の全ユーザーが、人気の高い三つのモバイルアプリInstagram, WhatsApp, Snapchatでそれを使える。さらに今日からは、この機能を全てのサードパーティデベロッパーが使えるようになる。

チップのこのようなアクチベーション過程はGoogleのみならず、一般的にハンドセットのメーカーとしても異例だ。たしかにそれは写真の新しい技術ではあるが、数多い安定的なパートナーシップの下に多数のアプリデベロッパーがいるGoogleで、技術が一般的に公開されるまでこれだけの時間がかかるなんて、おかしい。

Googleの上級スタッフハードウェアエンジニアOfer Shachamはこう言う: “これは、われわれとしても初めてのことだ。新しい技術の、すっきりした順調な展開をしたかったんだ。パートナーたちがつまずくようなことが、ないようにしたかった。だから事前に、あらゆる部分の改良に努めた。画質だけでなく、性能やパワーについてもだ。だからPixel Visual Coreのデベロッパーオプションをやっと11月にローンチしてから、今でもずっと改良を続けている。我社のスマートフォンは、絶えず進化しているようにしたいんだ”。

Visual CoreのPixel 2ユーザーへの展開は、今月のアップデートの一環として今後数日以内に行われる。Pixel以外の機種については、Googleはまだスケジュールを明らかにしていない。