GoogleのDeep Dreamをはじめ、最近の興味深い実験的開発の多くを、高度なニューラルネットワークが支えており、それらをさらに膨大な量の計算機力が動かしている。NVIDIAの提案は、それだけの膨大なコンピューティングパワーをワンボックスに収め、AI研究者たちのニーズに応えることだ。

NVIDIAのGPUはすでに、ディープラーニングのアプリケーションに使われているから、次の一歩がそうなるのも不思議ではない。そのDGX-1と呼ばれるボックスは、GPU 8基から成るスーパーコンピューティングのクラスタを収納する。そこに、おかしな部分は何もない。Tesla P100カードが8枚、そのそれぞれに16GBのRAM、そしてネットワークを訓練するときのデータを収める7TBのストレージという構成だ。ほかにNVLink Hybrid Cube Meshというものもあるが、とにかく構成はシンプルだ。

ニューラルネットワークを訓練するためのソフトウェアも同梱されるが、しかしエンドユーザーの多くは自前のソリューションを使うだろう。DGX-1自身にとっては、どちらでもOKだ。このように、シンプルに標準化されたプラットホームは、システムを構築するときの“分からないけどやってみよう”(guesswork)を取り除き、NVIDIAというビッグネームがサポートと定期的アップデートを提供するから、意外なところで余計な経費が発生するおそれも少ない。

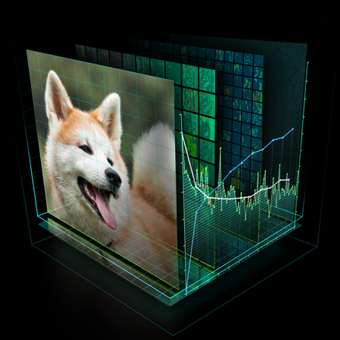

そもそも、ディープラーニングシステムとかニューラルネットワークって、一体何だ? 簡単に言うとそれは、人間の思考の過程をシミュレートして、大量のデータの中に、さまざまなレベル(大小、複雑単純、少次元多次元、etc.)の類似や差異を見つけていくソフトウェアプロセスだ。

そのようなシステムは、画像分析やオブジェクト認識ないしパターン認識のようなタスクを迅速かつ効果的に実行する。こういう、ニューラルネットワークの大規模高密度な利用は、AIやコンピュータサイエンス畑の人びとにとっても、かなり新しい。今のあなたがよく知らなくっても、また、ぼくの説明が下手くそでも、お互い、悪びれる必要はない。

もちろん、通常のソフトウェアだからふつうのCPUでも動かせるが、今や大規模なデータ処理を実用速度で動かすためには、大規模な並列処理の利用がほぼ常識だ。GPUは元々、大規模な並列処理に向けて最適化されているプロセッサーだ。画像処理は、大量のデータを次々と瞬間的に処理しなければならない。だからGPUは、今どきのスーパーコンピューティング用にも適している。8つのTeslaが並列で動くと、170TFLOPSという猛スピードを実現する。今では、クラウド上のクラスタでもそれぐらいは可能かもしれないが、時間課金をされない自前のハードウェアが手元にあった方が気楽だ。トラブルシューティングとメンテナンスは、NVIDIAがやってくれる。

ただし、DGX-1は一台のお値段が12万9000ドルだ。未来は決して、お安くはない。