Googleの研究者たちは、人びとが他人を騙(だま)して、今自分は月にいる、と思わせたり、今は昼ではなくて夜だと見せかけることが好きだ、と知っている。しかしそんな楽しいいたずらは、映画のスタジオへでも行って、グリーンのスクリーンの前で撮影しないと実現は難しい。そこで2018年の優秀なプログラマーたちは、自分たちにできることをした: ニューラルネットワークを利用してそれをやるのだ。

その、“ビデオセグメンテーション”(ビデオ切り出し)と呼ばれるツールは、モバイル上のYouTube Storiesで今日(米国時間3/1)から一部のユーザーに展開される。画面上にこのオプションがある方は、おめでとう、あなたはベータテスターだ。

この機能には、さまざまな工夫が盛り込まれているようだ。前景(被写体本体)と背景の境界を見つけなければならないが、それはiPhone Xの前面カメラ配列のような深さ(z軸方向)を感知するカメラと、大量の処理時間と、電池よりも長時間使える電源があれば、朝飯前だ。そう、デスクトップコンピューターを使えばよい。

でも、モバイルでしかもふつうのRGB画像(深さ情報がない)となると、そう簡単ではない。スチルの画像でも難しいのに、ビデオとなるとなおさらだ。コンピューターは、背景検出のための計算を、少なくとも毎秒30回やらなければならない。

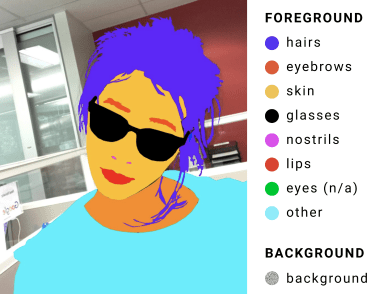

そう、Googleの技術者たちも、それをチャレンジと捉えた。畳み込みニューラルネットワークをセットアップし、それを数千のラベル付き画像(その例が右図)で訓練した。

そのニューラルネットワークは、人の頭と肩のような、よくある特徴を検出できるように訓練され、一連の最適化によって、正確な検出のために必要なデータの量を減らしていった。また、前の計算の結果(頭の切り抜きなど)を次のための素材として使うという、一種のコンピューター騙しによって、計算負荷をさらに下げた。

その結果、高速でしかも比較的正確なセグメンテーションエンジンが得られ、ビデオに対しても使えるほどの速度を達成した。GoogleのPixel 2スマートフォンの上では40fps、そしてiPhone 7では100fpsを超えた(!)。

これは多くの人たちにとってビッグニュースだ。背景をなくしたり、入れ替えたりすることは、ツールボックスに常備したい楽しいツールだし、しかも、とても容易にそれができる。そして願わくば、短時間で電池を空にしませんように!。