今週の初めにAWSは、AIを勉強して音楽を作るウェブ上の一連のツールと、メロディーを入力するための99ドルのMIDIキーボードを組み合わせたDeepComposerをローンチした。しかしそのローンチはかなりの混乱を招いたので、私たちはAWSのAI DevicesグループのディレクターであるMike Miller(マイク・ミラー)氏に会って、DeepComposerが同社の一連のAIデバイスの中でどんな位置づけになるのかを聞いてみた。そのほかのAIデバイスとしては、DeepLensカメラやAIカーのDeepRacerなどが挙げられるが、どちらも、AIの特定のコンセプトをデベロッパーに教えることが目的だ。前者は画像認識、後者は強制学習に特化している。

まず重要なのは、DeepComposerが学習ツール(教材)であることだ。ミュージシャンではなく、生成AIについて学びたいエンジニアが使う。「世界初のデベロッパーのための機械学習対応の音楽用キーボード」というAWSの説明はあまり理解の助けにならないが、キーボードそのものはごく普通のMIDIキーボードだ。それ自身に人工知能はない。AIの仕事はすべて、クラウドで行われる。

ミラー氏は「目標は生成AI(Generative AI)を、機械学習の最近10年間の最も興味深いトレンドとして教えることだ。具体的にはそれはGANs(Generative Adversarial Networks、敵対的生成ネットワーク)のことで、2つのネットワークが一緒に訓練される。我々から見て興味深いのはそれが極めて複雑で、デベロッパーが2つを一緒に訓練するとき、機械学習のモデルの訓練に関するいろんな要素が絡み合っているからだ」と語る。

DeepComposerを使ってデベロッパーは、学習の基礎的な過程を一歩一歩学んでいく。キーボードから単純なメロディーを入力できるが、実際はそれをする必要はない。画面上のキーボードから第九交響曲の歓喜の歌などのデフォルトのメロディーを入れてもいい。そしてデベロッパーが曲調を指定すると、そのメロディーに合った伴奏をシステムが生成する。物事を単純化するためにこのシステムは、曲の速さや音の強弱など一部の要素を無視する。だからこれは、ミュージシャンが使う楽器ではない。しかしもっと重要なのは、デベロッパーが、システムが生成したモデルを調べられることだ。それらをJupyter Notebookにエクスポートすることもできる。

DeepComposerの目的にとってMIDIデータは、デベロッパーにGANsとSageMakerについて教えるためのデータソースの1つにすぎない。後者のSageMakerは、楽屋裏でDeepComposerを動かしているAWSの機械学習プラットホームだ。

ミラー氏によると「MIDIファイルを訓練用に使うことの利点は、訓練に使うデータの表現が、画像などの中のデータ表現と同じ形式であることだ。だからとても使いやすく(画像などとの)類似性がある。デベロッパーがSageMakerのnotebookを見てデータのフォーマッティングとその渡し方を理解すると、それを他の分野にも応用できる」とのこと。

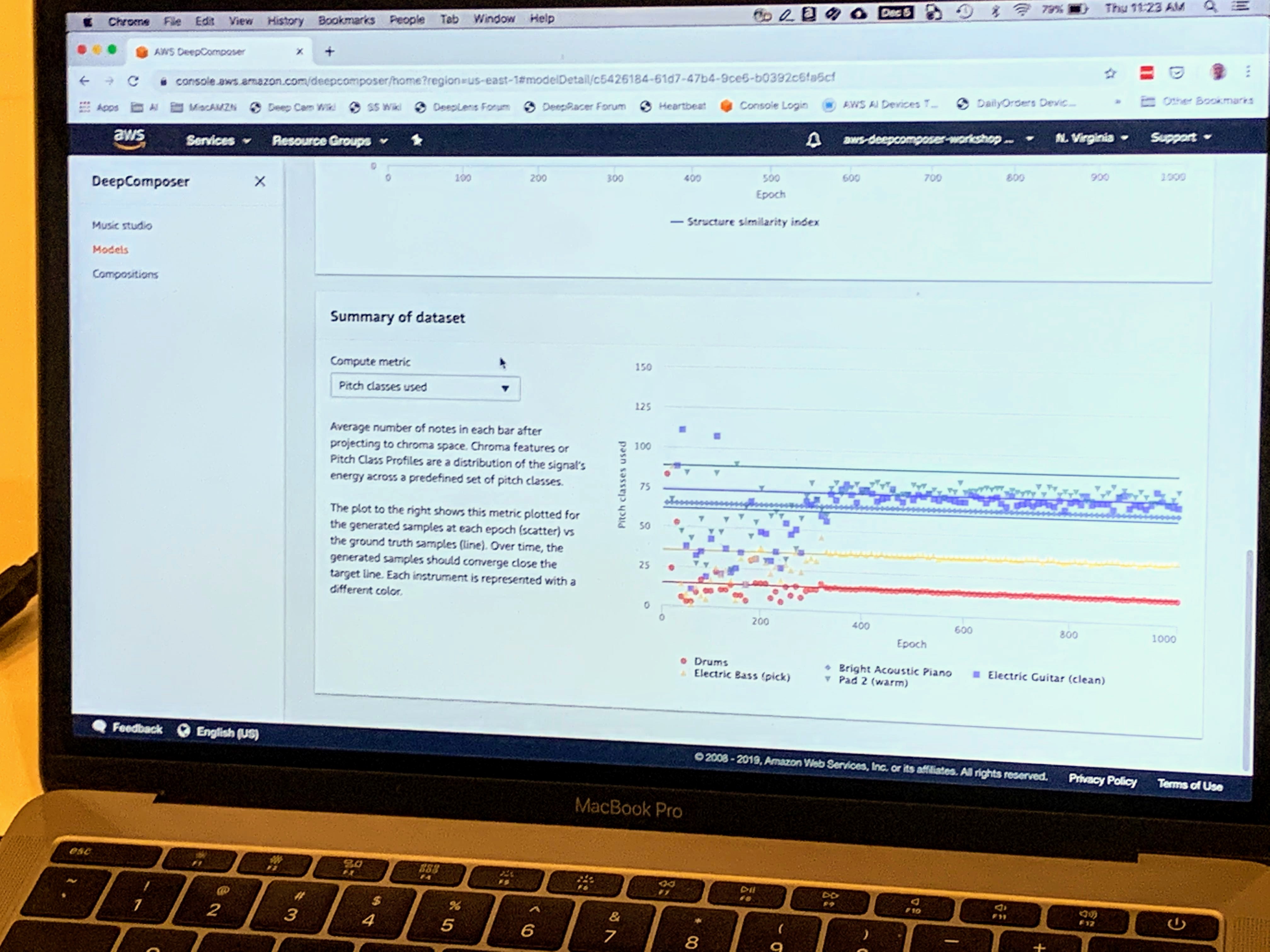

そこでこのツールは、損失関数やアナリティクス、そして受容できる結果を得ようとしてトライしたときのさまざまな結果など、あらゆる生データを露出する。当然ながら音楽を作る道具でもあるので、ピッチや空の小節など、音楽に関するデータも露出する。

そこでこのツールは、損失関数やアナリティクス、そして受容できる結果を得ようとしてトライしたときのさまざまな結果など、あらゆる生データを露出する。当然ながら音楽を作る道具でもあるので、ピッチや空の小節など、音楽に関するデータも露出する。

「デベロッパーはSageMakerのモデルを学ぶと思うので、音楽ではない他の分野への応用でも、自分で比較的楽にモデルを作れるようになるだろう」と同氏は語る。

これまでの結果を聴いたかぎりでは、DeepComposerからヒット曲が生まれることはないだろう。ドラムスのトラックは上手だが、ベースラインにはエラーがある。でも、機械学習のテクニックのデモとして見ればなかなかクールだ。個人的感想としては、DeepRacerほどの人気者にはならないだろう。DeepRacerは単純明快だから、多くのデベロッパーが気に入りそうだ。それに対し楽器の演奏は、苦手な人は苦手だろう。

追加記事提供:Ron Miller

関連記事

・AWSが開発者向けの機械学習キーボード 「DeepComposer」 を発表

・Why AWS is building tiny AI race cars to teach machine learning(なぜAWSは機械学習を教えるために小さなレースカーを作るのか、未訳)

・AWSが機械学習のためのミニレースカー「DeepRacer」をアップデート

・Amazonが開発者たちに機械学習を教えるために、縮小版自動運転車を発表

[原文へ]

(翻訳:iwatani、a.k.a. hiwa)