私たちは、物体を識別したり、路上をナビゲートしたり、顔面の表情を認識するために機械学習システムを訓練してきたが、それらを例えば犬をシミュレートできるレベルほどに洗練することは困難のようだ。だがここで紹介するプロジェクトは、それを狙おうというものだ、まあもちろん極めて限定された範囲ではあるのだが。以下に紹介するAIは、一匹の賢いメス犬の振る舞いを観察することによって、犬のように行動する方法の基礎を学んだ。

この研究はワシントン大学とAllen AI研究所の共同研究であり、その結果の論文は、6月のCVPR(コンピュータービジョンとパターン認識の国際会議)で発表される。

なぜこの研究を行うのだろうか?まあ、オブジェクトを特定したり、それに注目するといった、認識のサブタスクをシミュレートするための研究は多く行われてきたが、「エージェントがその視覚を用いて行動しタスクを起こすために必要とされる視覚データの理解」という意味ではあまり多くの研究は行われてこなかった。言い換えれば、目としての振る舞いではなく、その目を動かすものとしての振る舞いである。

それに何故犬なのか?何故なら彼らは十分な複雑さを備えたインテリジェントエージェントであり、「にも関わらずその目標や動機を、しばしば先験的に知ることは困難だから」である。言い換えれば、犬は明らかにスマートな存在だが、彼らが何を考えているのかは分からないということだ。

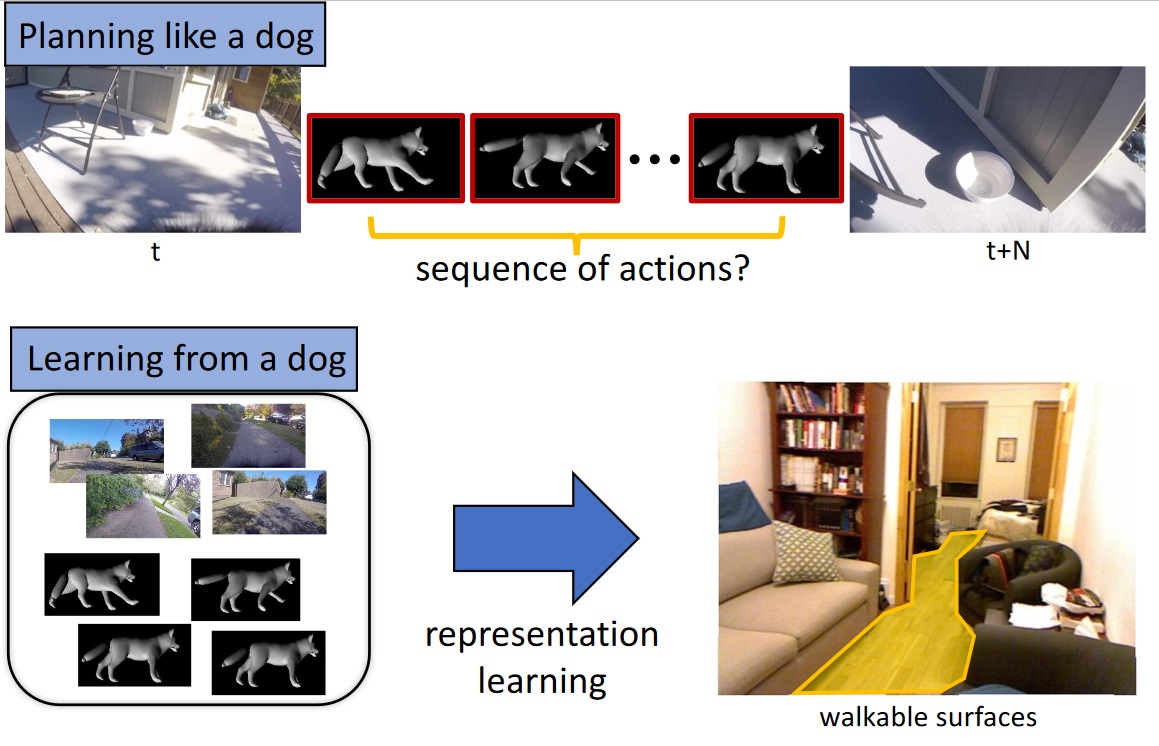

この研究の最初の試みとして、チームは犬を密接にモニターし、その移動や行動を犬が見ている環境にマッピングすることによって、犬の動きを正確に予測するシステムを作り出すことができるかどうかを知りたいと考えた。

ということで、彼らはKelp M. Redmonという名前のマラミュート犬に基本的なセンサー群を装着した。Kelpの頭にはGoProカメラが載り、脚、尾、胴に6つの慣性計測ユニットが装着されてそれぞれの位置を検出する。さらにマイクと全てのデータを統合するためのArduinoも備えられた。

彼らは何時間にもわたるKelpの活動を記録した。様々な環境で歩き、物を取らせ、ドッグパークで遊び、そして食べる。これらの動きを犬が見たものと同期させて記録したのだ。その結果得られたものが、「犬環境における自我中心の行動データセット」(Dataset of Ego-Centric Actions in a Dog Environment:DECADE)だ。このデータは新しいAIエージェントを訓練するために用いられる。

訓練されたAIエージェントは、特定の感覚入力(例えば部屋や通りの景色、またはそこを横切るボールのようなもの)があったときに、その状況で犬が何をするかを予測することができる。もちろん、こと細かなレベルではない。しかし単にどの身体をどのように動かそうとするのか、どこへ移動しようとするのかを判定するだけでも、大変な仕事である。

研究者の一人であるHessam Bagherinezhadは「歩行する際の関節の動かし方を学習し、歩いたり走ったりする際に障害物を回避する方法を学んでいます」とメールで返信してきた。「リスを追いかけることを学び、飼い主の後に従い、『とってこい』のために飛んでいる犬用のおもちゃを追跡することを学んでいます。これらは、各タスクに対する別々のデータ(行動計画、歩行可能な表面、物体認識、物体追跡、人物認識)を集めることで私たちが解決しようとしている、コンピュータビジョンとロボティクスの基本的なAIタスクの一部です」。

これは、かなり複雑なデータも生成することが可能だ。例えば犬のモデルは、本物の犬自身がそうしている様に、ここからそこまで歩く際に、どこを歩くことができるのかを知らなければならない。それは木の上や車の上、そして(家庭によると思うが)ソファの上を歩くことはできないからだ。したがって、モデルはそれらも学習する。その結果は別途コンピュータービジョンモデルとして利用され、ペット(もしくは脚付きロボット)が、見えている画像のどこを歩くことができるのかを決定するために利用できる。

これは、かなり複雑なデータも生成することが可能だ。例えば犬のモデルは、本物の犬自身がそうしている様に、ここからそこまで歩く際に、どこを歩くことができるのかを知らなければならない。それは木の上や車の上、そして(家庭によると思うが)ソファの上を歩くことはできないからだ。したがって、モデルはそれらも学習する。その結果は別途コンピュータービジョンモデルとして利用され、ペット(もしくは脚付きロボット)が、見えている画像のどこを歩くことができるのかを決定するために利用できる。

これは、まだ最初の実験に過ぎない。研究者たちは実験は成功したが、結果はまだ限られていると言う。より多くの感覚の取り込みが考えられていることだろう(嗅覚は明らかにその1つだ)、あるいは1匹(もしくは複数の)犬から生み出されたモデルが、他の犬たちにどれほど一般化して適用可能かの研究も考えられているだろう。彼らの結論はこうだ:「私たちは、この研究が、視覚情報と私たちの世界に生息する他の知的存在に対する、より良い理解をもたらす手段への道を切り拓いてくれることを期待しています」。

[原文へ]

(翻訳:sako)