ぼくの世代〔John Mannes, 1995/11生〕は、ほぼ全員がInstagramにはまっている。でもぼくは、2015年にこのプラットホームを去った(ごめんなさい)。理由は単純で、どの写真をポストするか、なかなか決められないこと、そして、簡潔で魅力的なキャプションを考えるのに、いつも苦労するからだ。

画像提供: Google

でも、ぼくと同じ問題を抱えているひま人は、Google TensorFlow〔昨年オープンソース化〕の画像キャプションモデルを利用すれば、そのくだらない第一世界問題に終止符をうてるだろう。ぼくも、それが楽しみだ。右の、“A person on a beach flying a kite.”(ビーチで凧をあげている人)なんか、すごくビューティフルでクリエイティブだよねー。〔皮肉〕

ジョークは置いておくとして、GoogleのBrainチームの研究員社員たちが作ったこの技術は、なかなかのものだ。“Show and Tell”(見せる/教える)というキュートな名前のこのプロジェクトの精度は93.9%だそうだ。精度は、89.6%、91.8%とバージョンを重ねるたびに上がってきた。分類というタスクは、精度が少し上がっただけで有用性が大幅に向上する。

そこまで到達するためにチームは、視覚と言語の両方でニューラルネットワークを訓練してきた。用いた教材は、画像と、それに人間がつけたキャプションだ。そのおかげでこのシステムは、画像中の物(砂、凧、人)を認識するだけでなく、説明的な文章を生成できる。精度の高いモデルを作るための鍵は、物と物の関係、という要素を導入したことだ。たとえば上の写真では、男の上に凧があるのではなくて、男が凧をあげているのだ。

>画像提供: Google

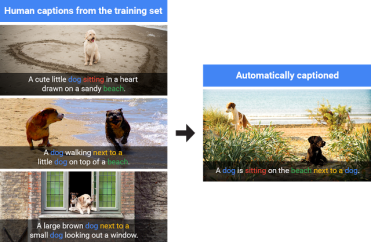

チームは、このモデルは教材中の語句をオウムのように真似しているのではない、と主張する。たとえば左の例では、複数の画像のパターン(左図の左)を合成して、これまで見たことのない画像(左図の右)のためのキャプションをオリジナルに作っている。

この画像キャプションモデルのこれまでのバージョンは、一教材につきNvidia G20の上で3秒の訓練時間を要していた。しかし今日オープンソース化されたバージョンでは、その1/4、0.7秒だ。昨年はMicrosoft COCOと横並びにまでこぎつけたが、今のバージョンはそれよりさらに高性能、ということだろう。

数か月前にラスベガスで行われたComputer Vision and Pattern Recognitio(コンピュータービジョンとパターン認識)カンファレンスでGoogleは、このモデルについて説明し、画像中の物を認識できるだけでなく、人間がキャプションをつけた画像で訓練することにより、画像中のばらばらの要素を組み合わせてキャプションを作れる、と述べた。

物をコンテキスト(それが置かれている文脈、状況)に結びつけることは人工知能の長年の難関だったが、このキャプションモデルはそれの解決に向けての第一歩かもしれない。コンピューターが画像や映像を見て状況を認識できるようになったら、たとえば、警察から逃げようとしている人と、そのおそろしい場面から逃げようとしているたまたま居合わせた人とを、正しく区別できるだろう。