GoogleのKubernetes Engine(旧: ‘Google Container Engine and GKE’)では、これからすべてのデベロッパーが自分のコンテナにNvidiaのGPUをアタッチできる。

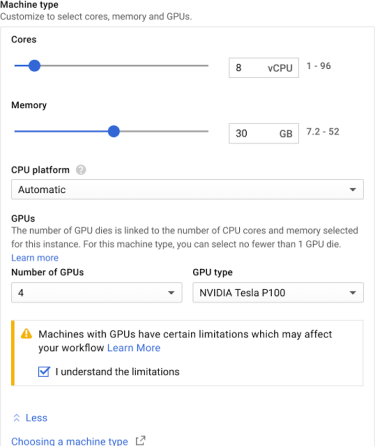

そのGPUs on GKE(←これはGoogleがよく使っていた頭字語だが、今はあまり使われていない)は、これまで半年あまり、非公開アルファで提供されていた。しかし今度からそのサービスは公開ベータになり、機械学習アプリケーションなどのワークロードを動かしたいデベロッパーが誰でも、GPUの力を利用できる。Googleによるとこのサービスは、Tesla P100とK80 GPUs の両方へのアクセスを提供する。それらはどちらも現在、Google Cloud Platformで利用できるGPUだ。

コンテナとGPUという組み合わせのアドバンテージは、必要に応じてワークロードの増減に、容易に対応できることだ。GPUのワークロードのすべてにスパイクがあるわけではなくても、万一のときには便利なオプションとして評価できるだろう。

Googleでは、GPUジョブのモニタリングを、そのAPIやStackdriver、ロギングサービスなどから容易に行える。

全体としてKubernetes Engine(←GoogleがGKEの正式名として使うことにしたらしい名前)は、そのコアアワー(core数×時間)が2017年に9倍になった。コンテナのブームと、(当時の)GKEが2016年にローンチしたばかりであることを考えると、9倍も意外ではないが、しかしそれは、Googleがコンテナの世界で勝馬を獲得したことを、意味しているのかもしれない。