Facebookはどのようなコンテンツであれば掲載してもよいと考えればいいのだろうか? また、多様な意見や文化の違いが存在する中、彼らはどのようにユーザーの安全と真実のバランスをとればよいのか? Facebookはこのような一筋縄ではいかない問題の解決に向けて、本日(現地時間6月15日)7つの”難問(hard questions)”に関する記事を公開した。ユーザーは各項目に対するフィードバックや、他にFacebookが取り組むべき問題を、所定のメールアドレス(hardquestions@fb.com)に直接送ることができる。

Facebookは今後それぞれの問題に対する考えをまとめたブログ記事を公開しようとしており、まずは本日、インターネット上でのテロリズムの拡散とFacebookがどのようにこの問題に取り組んでいるかについての記事がアップされる予定だ。

[アップデート:こちらから最初の”難問”に関するFacebookのブログ記事を確認できる。予定通りこの記事ではテロ対策が取り上げられており、詳細については以下で触れている]

「私たちの選択に疑問を抱いている人もいるかと思いますが、Facebookの考え方やどれだけ真剣に私たちがそれぞれの問題に取り組もうとしているかについて、このブログシリーズを通じて知ってもらえればと考えています」とパブリックポリシー担当VPのElliot Schrageは記している。「また、こういった情報を公開して説明責任を果たすことで、今後間違いを犯す回数が減り、何か問題が起きてもすぐに対応できるようになると信じています」

Facebookが取り組んでいる7つの”難問”は以下の通りだ。各項目には関連情報を追記している。

- ネット上のプロパガンダの拡散を防ぐためにソーシャルメディアはどのようなアプローチをとればいいか?

Facebookはこれまでにテロ支援を表明しているページやアカウントを閉鎖してきた。しかし、テロリズムとの関連が不明確なものへの対応や、忌憚のない意見とプロバガンダの線引きに関しては明確な指針を示せないでいる。

- アカウントの持ち主が死んでしまった場合、その人の情報をどのように扱うべきか?

現在のところ、Facebookでは亡くなった人のアカウントが追悼アカウントに変更され、事前に「追悼アカウント管理人」に定められた人がそのページを管理するようになっている。しかし、もしもアカウトの持ち主が生前に管理人を定めていなければ、たとえ家族の誰かに対してであっても、管理権を移譲するためには複雑なプロセスを経なければいけない。

- ソーシャルメディアは、問題となりそうな投稿や画像をどのくらい積極的に監視・削除すべきなのか? 特にさまざまな文化的背景を持つ世界中のユーザーが利用しているサービスでは、誰がコンテンツの問題性を判断すればいいのか?

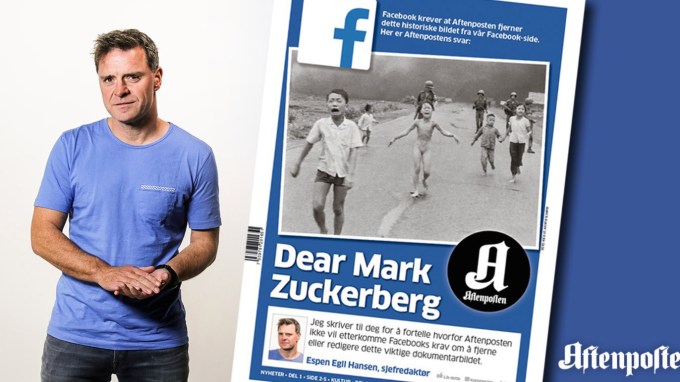

Facebookはさまざまな年代のユーザーや広告主の安全を守りつつも、熱い議論が交わされるトピックを検閲しないようにするという難しい綱渡りを強いられている。最近では、警察による暴力がおさめられた動画や、裸の子どもが写った戦争の恐ろしさを伝える歴史的な写真を一時的にブロックしたことで批判を受けていた。この点に関しマーク・ザッカーバーグは、各ユーザーがフィルター機能を自分で調節できるようにし、各地域のユーザーの平均的な設定をその地域のデフォルト設定にしたいという考えを示していた。しかし、各地域の基準が国際的な基準と一致しない場合、Facebookは依然として厳しい選択を迫られることになる。

- 誰が「偽ニュース」と「賛否の分かれる政治的な発言」の線引きを行うのか?

2016年のアメリカ大統領選挙以降、Facebookは偽ニュースの拡散に対して十分な対策をとっていないと批判を浴びており、特に右派の陰謀論やドナルド・トランプの勝利に繋がったとされる情報の拡散が話題になった。しかし、もしもFacebook自体が偽ニュースを取り締まり始め、思想的に偏った決断を下すようになると、ユーザー間の議論が沈静化し、オンラインコミュニティがさらに分裂してしまうだろう。その一方で、彼らが何もしなければその判断は有権者の手に委ねられることになる。

- ソーシャルメディアは民主主義にとってプラスなのか?

ひとつ前の問題にも関連しているが、ユーザー間で”ニュース”が勝手に広まることで、これまで誤報や不正確な情報から読者を守ってきたプロの編集者が入りこむ余地がなくなってきてしまった。残念ながら、扇情的な虚偽のコンテンツほどエンゲージメント率が高く、結果的にニュースフィード上でも目立つ位置に配置され、これがさらなる拡散に繋がってしまっている。これに対し、Facebookは偽ニュースが目立つ位置に表示されないようにアルゴリズムを改変し、外部のファクトチェッカーとも協力してきたが、フィルターバブルが縮小化したことでユーザーが多様な意見に触れる機会が減ってしまう可能性もある。

- どのようにユーザーデータを活用すれば、ユーザーの信頼を損なわずに利便性を高めることができるのか?

Facebookはいい意味でも悪い意味でもデータ発掘機のような存在だ。大量のデータがあるからこそ彼らはユーザーの好みにあったコンテンツを表示することができるのだが、ユーザーデータは広告の効率化にも使用されており、Facebookの影響力はさまざまな業界に留まらず、私たちのプライバシーにまでおよぶ。

- 若いネットユーザーが安全な環境で自分を表現するためにはどうすればよいのか?

大人にとっては重要なニュースだったり軽いエンターテイメントだったりするものが、子どもにショックを与え動揺させてしまうことがある。そんな中、Facebookはお互いに繋がりあえるような環境を子どもに与えつつも、悪意を持ったユーザーから子どもたちを守るようなネットワークを構築していかなければならない。既に同社は成人ユーザーがグラフ検索で18歳未満のユーザーを見つけられないよう制限を設けているほか、親向けにさまざまなリソースを公開しているが、子どもが投稿した内容は一般公開できるようになっているため、見知らぬ大人が子どもと関わりを持つ可能性を根絶できてはいない。

テロリズム対策

テロ対策に関するFacebookのブログ記事はユーザーとの対話のスタート地点に過ぎず、AIや人間のスタッフ、外部パートナーといった、プロパガンダ拡散を防ぐための手段をリストアップしただけのものだった。

Image via BuzzNigeria

彼らの取り組みは以下の通りだ。

- 既に削除対象となったコンテンツが再びアップロードされるのを防ぐための類似画像検索機能の実装

- テロ行為を支援するような文章を特定できるアルゴリズムを使い、似た文章を見つける機能のテスト

- テロ支援を理由に削除されたアカウントと繋がっている、もしくは似たアカウントの削除

- 削除後に再登録したと思われるアカウントの動きを特定し”再犯率”の低下を狙う

- プラットフォームを超えてテロリズムの撲滅を目指すためInstagram、WhatsAppと協力

- 現状Facebookでは、警察からの要請に対応する緊急時用の専門スタッフを含め、何千人というモデレーターが同社の社員としてフラグの立てられたコンテンツのレビューを行っている。ここにさらに3000人のモデレーターを追加し、150人の専門家をテロ対策専用のチームに配備する。

- FacebookはTwitterやYouTubeをはじめとする企業とパートナーシップを結び、テロ関連コンテンツのフィンガープリントを共有しているほか、世界各国の政府機関からブリーフィングを受け、反過激主義・反ヘイトスピーチプログラムを支援している。

残念ながら、今回の記事にはフィードバックのためのメールアドレスは記載されておらず、プロパガンダとされるコンテンツをチェックする際の基準に関する哲学的な問題も提起されていない。

[アップデート:この記事でメールアドレスが記載されていないということを指摘した結果、当該ブログ記事にhardquestions@fb.comが追記され、今後”難問”に関連する全ての記事にメールアドレスを記載するという連絡をFacebookから受け取った。この対応から、実際にフィードバックに耳を傾け行動を起こそうとする同社の姿勢を感じられた]

透明性だけでは事態の重大さは変わらない

この度公開された”難問”からは、どうすればザッカーバーグが「これまでとは違うメディア企業」と呼ぶ存在であり続けられるのかというFacebookの葛藤が感じられる。ソーシャルネットワークというものは、ユーザーが肉付けしていく骨格のようなプラットフォームであると同時に、何が有益で楽しいコンテンツで何が誤解を招く邪魔なコンテンツなのかを判断し、自分たちの色を出していく出版社のような存在でもある。

そういう意味では、考えていることを社内に秘めておかずに公開すると決めたFacebookの判断は賢明だったと言える。また、情報が公開されたことで、人々はFacebookが少なくとも問題に真剣に取り組もうとしているのだと安心できるかもしれない。問題は、透明性が高まったからといって、急を要する事件が起きたときに、何十億もの四半期売上高を誇るFacebookが時間をかけてそれに対応する余地が与えられるかということだ。フィードバックや解決策をクラウドソースするだけでは足りない。たとえ解決策がビジネスの妨げになるとしても、Facebookは実際にアクションを起こしていかなければならないのだ。

[原文へ]

(翻訳:Atsushi Yukutake/ Twitter)