SEO業界は2010年以来劇的な変化に直面しているが、今度どのように進歩するのだろうか?

賢くなったGoogle

Googleは常に賢いサービスであった。立ち上げられたばかりの頃、ページランクアルゴリズムによって、Googleは検索業界を一変させた。あまりにも革命的であったため、今となっては誰も覚えていないその他諸々の検索エンジンを次々と葬っていった。カフェインが導入される前の、初期のGoogleも賢く、2010年以降に登場するGoogleの前任者としては申し分のない製品であった。

過去を振り返ると、Googleの品質保証、つまり検索エンジンの結果ページ(SERP)を保護する取り組みは力に頼っていた。相互リンク、有料テキストリンク、アーティクルリポジトリのリンク等、迷惑なリンクを特定して、ウェブスパムを識別し、対処するプログラムを書くのが常套手段であった。インフラに対するビッグダディアップデートが行われる前は、特にこの傾向が強かった。

インデックスのインフラを対象としたカフェインアップデートが2010年に導入された際、マイリー・オイェはウェブマスターセントラルで「ウェブ全体が拡大、そして、進化を続けており、カフェインを投入することでGoogleも共に進化することが可能になる」と話していた。この言葉は嘘ではなかった。カフェインが導入されると、Googleは好みのサイトをより正確に特定することが可能になった。

例えば、Googleは、上位にランクインしているコンテンツを書き直し、反復するのではなく、新しい情報、アイデア、あるいは、考えを当該のトピックに与えるコンテンツを求めている。

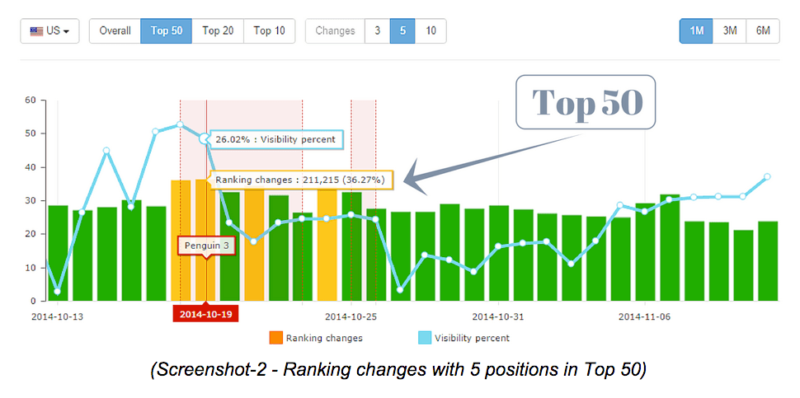

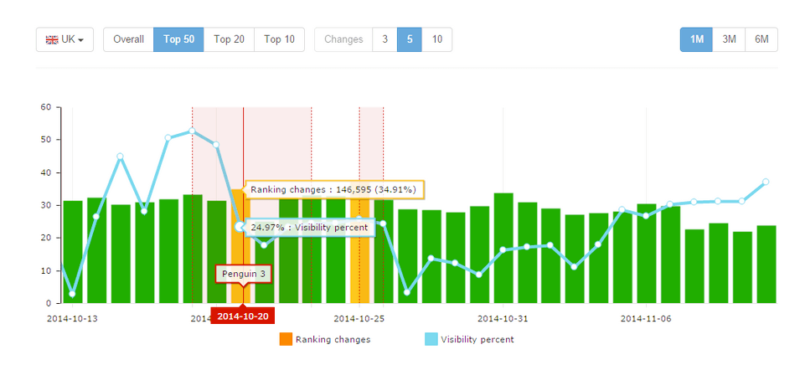

確かに、Googleはさらにパワフルな武器も導入している(パンダやペンギン等)。しかし、現在のGoogleはより知的な行動を取る気がする。ページランクアルゴリズムとパトロールが強化されただけではない。

初期のGoogleに話を戻す。10年以上前のGoogleと同じく、SEOコミュニティもまた賢かった。相関関係を誰かが発見するずっと前に、SEOコミュニティは重要なランキングファクターを特定することに成功していた。

SEOコミュニティはGoogleの裏をかくこともあった。SEO業者に欠けていたのは、知識、あるいは、知識だと思っていたモノを体系化するプロセッサとストレージだけであった。

その後、ムーアの法則が追いつき、クラウドが登場した。MajesticとMoz等の会社がウェブの広範囲をクロールするようになり、ベールを取り払い、Googleの隠し味の多くを明らかにする取り組みを始めた。

SEOの知識がピークに達したのは、カフェインが導入された時期と一致すると主張する声もある。当時、Googleはあらゆる情報を公開していた。

しかし、現在、SEO業界はGoogleの発表に関して既に持っている知識を精査することに専念している。同時に、Googleは共有するデータの量を減らしている。

今年の10月、Googleは — 「利用を止めた」ではなく、– ページランクに別れを告げると言った。また、Googleはキーワードの分析機能を取り上げ、さらに、キーワードツールのレベルを低下させた。知識と影響の比率において、2010年と現在を比べると、現在、SEOに対する知識の量は低下している可能性がある。

それでは、カフェイン導入後5年目に差し掛かろうとしている現在、SEOはどこに向かおうとしているのだろうか?

SEOの終焉

SEOに関して、ウェブサイトのオーナーは次の3つのタイプのいずれかに当てはまる:

- SEOをマーケティングのチャンネルの一つと考える。このタイプの見解を持つサイトのオーナーは、トラフィックを増やす手段としてSEOを実施する。SEO目的で、コンテンツを作り、ページを最適化し、リンクを構築する。

- SEOのトラフィックを、SEO以外の取り組みを全て適切に実施した褒美と考える。キーワードを選び、コンテンツを最適化するものの、コンテンツ、ソーシャルメディア、そして、宣伝を活用し、エンゲージメントとアウェアネスを高める取り組みに力を入れる。このタイプの人達は、SEO以外のタスクを全て正しく実施すれば、結果として、自然なトラフィックが増えると考えている。

- SEOを実施しない。 このタイプのウェブサイトのオーナーは認める認めないに関わらず、我流を貫く。デザイン、アーキテクチャ、そして、サイト上のコンテンツにSEOのベストプラクティスを反映されることはない。SEOが結果的に効果を発揮することを望むものの、その準備を行わない人達もこのグループに属する。

様々な理由で3つ目のタイプの見解を持つサイトのオーナーが増えつつある。最新のHTML5/CSS3/JavaScriptのデザインに夢中になり、何も変えたくない人もいれば、単純に諦め、豊富な資金を持つブランドとは勝負にならないと考えている人もいる。

大勢のSEOの関係者がこの業界を去りつつある。コンテンツマーケッターに転身した人もいれば、インバウンドマーケッターに転身した人もいる。このタイプに当てはまる場合、今でもSEOを仕事の一環として行っているが、仕事の範囲を拡大している。SEOのみでは、あまりにも仕事が限定されてしまうためだ。

SEOのみを生業とする業者は今でも存在するが、業界全体としては撤退する傾向が見られる。

Googleが有名な企業に大きなアドバンテージを与えるため、中小規模のビジネスは苦戦を強いられるようになり、とりわけ国内のみで営業する小さな会社は大きな規模のライバルに対して闘志を燃やすようになった。スタートアップ、そして、大企業レベルであっても、SEOをその他の部門に組み込む動きが進んでいる。

SEO専門の業者は確実に実在するものの、雇用の機会は減少を続けている。現在、SEO専門のエキスパートはエージェンシーか個人か企業社内のポジションに限られる。

ページランクの終焉

ページランクのアップデートを終了すると言うGoogleの発表は、少し拍子抜けした感が否めなかった。この発表を行うまでに、なぜこんなに時間がかかってしまったのだろうか?それよりも重要なことhな、貴重な情報がまた一つ取り上げられてしまったことだ。

Googleはアドワーズのキーワードツールを没収した。アナリティクスでは(随分前の話だが)キーワードのリファラー情報の提供を停止した。Googleはウェブマスターツールを気が向いたら強化しているものの、重要なアップデートを頻繁に行う必要のある本格的なソフトウェアプロジェクトのようには扱っていない。

現在、Googleの利益に貢献しない取り組み、あるいは、PCCの投資を減らす取り組みは、全て粛清の対象になってしまう気がする。

オーサーシップが思ったような効果を発揮しなかったら、修正するのではなく、諦めた方が良い。Google+の+1が期待したほど指標としての役目を果たさなかったら、断念しよう。今後も、Googleは情報を隠す手段を次々に考案していくはずだ。

キーワードターゲティングの終焉

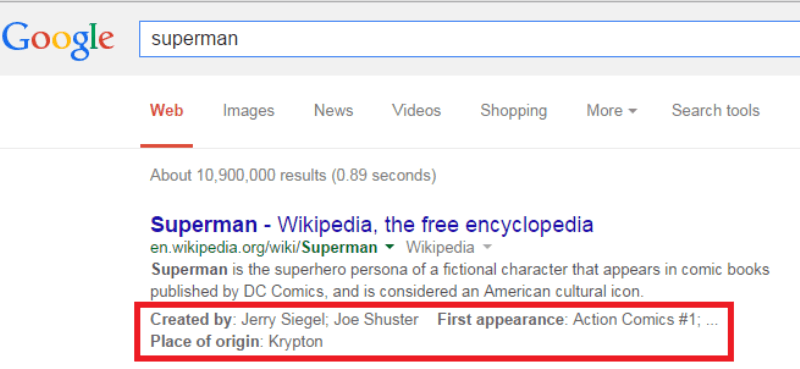

ハミングバード(および、エンティティの基本的な概念)のおかげで、1つのページに関連する全てのキーワードとそのバリエーションを詰め込む最適化の手法が編み出された。

この展開に行き着く前、SEOのエキスパートはキーワードごとにページを作る方針を採用していた。Googleはリスクの分散を認めなていない。うまくやれば、多数のキーワード、キーフレーズ、あるいは、バリエーションで上位にランクインすることが出来る。失敗すると、沈没する。

また、Googleは既に他の誰かが言ったことを繰り返すのではなく、新たな考えを提示せよと注文をつけている。 これは効果的なSEOコンテンツを作る上で、大きな障害を作り出している。多くのページを1つのページにまとめ、オリジナルのテキストではなく、オリジナルの考えを詰め込まなければならないのだ。

ちなみに、SEOエージェンシーに勤めている/経営している方に言っておくことがある。今なら、ハミングバード以前のコンテンツをエンティティに変えるタスクを、製品として提供することが出来る。パンダから復帰させるサービスと組み合わせると良い。ただし、上位にランクインし、多くのトラフィックを獲得しているウェブサイトを台無しにすることがないように注意してもらいたい。

リンク構築の終焉

リンク構築は今まで以上に重要になったのだろうか?それとも、息絶えたのだろうか?Googleは有料のリンクを無視、または、罰っし、その一方で、無料のリンクを評価する方法を見出したようだ(ペンギンさんの登場)。

トッド・マイコートが作成したリンクベイト講座を読み直してもらいたい(その際は、フレーズ「リンクベイト」を無視しよう)。

Googleはウェブサイトのオーナーに対して、オーディエンスを獲得し、リンクとソーシャルメディアのシェアでオーディエンスから見返りを与えてもらうシステムを提案している。コンテンツがオーディエンスのアクティビティ、または、会話を促さないなら、リンクを得ることは出来ない。

そのため、ブログでのコメントやソーシャルメディアでのシェア等の指標に注目する必要がある。ただし、全ての記事、投稿、または、ページがバイラル化するわけではない。10本のうち2本がリンクをもたらしているなら、高く評価するべきだ。3本リンクを獲得したなら表彰状ものだ。

リンク構築のプロ — と言ってもウェブサイトの管理者に勧誘電話をかける人達ではなく、戦略的にリンクを構築することが可能な有能な人達 — つまり、お互いに助け合うグループをまとめることが出来るネットワーカーには、生き残る道がまだあると私は考えている。

個々のグループは大きな影響力を持たないかもしれないが、雪だるま式に膨らんでいくと、読者やフォロワーはコメントを残したくなり、シェアしたくなり、そして、リンクを張りたくなる。

最高のネットワークは最高のコンテンツに勝つ。インフルエンサーの仲間で構成されたソーシャルネットワークに属するインフルエンサーこそが、最高のリンクビルダーになれる。

マット・カッツの終焉

…と言っても、マット・カッツがもうすぐあの世に旅立つわけではない。十分に値する休養を終えた後、ミスター Googleとして、SEOコミュニティ専門の広報として、復活を遂げるだろう。期待しているが、復帰する確率は50%程度だと私は見ている。

マット・カッツが提供する情報は、GoogleのエンタープライズのPPCアドバイザーが提供する情報よりも、非エンタープライズのサイトを助けてくれる。そもそも、ウェブが若く、流動的であった時代と比べると、小さな事業を大規模な広告スポンサーに成長させることは難しくなっており、Googleには、公式の発表とアップデートを提供する以外にSEOを助けるインセンティブが存在しない。

また、個人、エージェンシー、そして、スモールビジネスのSEO担当者は、大企業のSEO担当者よりも鋭い質問、または、不満を投げ掛ける傾向がある。従って、雲隠れすることで、気まずい雰囲気を作らずに済む。

そもそも、Googleは質問に答える必要はあるのだろうか?Googleのエキスパートがこの役目を果たしている。Mozu等の会社は、そのツールと調査を駆使して、SEOに関してGoogleが今まで提供した情報よりも多くのデータと答えを提供している。

Googleの他の従業員もネット上で質問に答えているものの、Moz等のサービスは随分前からこの取り組みを行ってきた。事実、マット・カッツの穴を埋めるほどの働きをしている従業員はいない。アダム・ラスニクがウェブマスター Q&Aの動画を撮影している姿を見たことがない。Googleのエンジニアによる講演の機会が減る可能性は十二分にある。

最後に

質問は多いが、まともな回答はほとんど得られない。2020年にはGoogleはページランク、そして、リンクベースの検索エンジンから、オーソリティよりもクオリティを優先する検索エンジンへと姿を変えているのではないだろうか。

しかし、Googleのブランド贔屓が直ることはないだろう。つまり、大きな企業は今後もSERPで幅を利かせ、小さなビジネスが上位にランクインするのはますます難しくなっていく。大半のSEOの関係者はこの業界から足を洗い、ウェブディベロッパー、デザイナー、そして、コピーライターのスキルの一つに成り下がる可能性が高い。

この記事の中で述べられている意見はゲストライターの意見であり、必ずしもサーチ・エンジン・ランドを代表しているわけではない。

この記事は、Search Engine Landに掲載された「The Decade Is Half-Over: Where SEO Has Been & Where It’s Going」を翻訳した内容です。

もちろん、特殊ケースに対応できる職人的技や、検索経由のトラフィック獲得に注力したウェブマーケッターという意味でSEO専門職のニーズはあり続けると思いますが、それなりのレベルに達していなければ、これまでのようなビジネスを続けることは相当難しいのではないでしょうか。

私自身も昨年から新規サイトを幾つか立ち上げていますが実質やっていることの大半はコンテンツマーケティングですし、結果として従来のテクニック寄りのSEO以上に検索経由のトラフィックを伸ばせています(それ以上にソーシャル経由のトラフィックが多かったりもしますが)。もちろんベースにSEOの知識があることでコンテンツの価値を最大限活かせていると思いますが、コンテンツマーケティングやソーシャルメディアと切り離された「従来のSEO」は、既にその価値をほぼ失っているのでは、と思う最近です。SEO業者の代表がこんなことをいっていいのか、とも思いつつも汗、覚悟を決めて今年SEOに取り組んでいきたいと思う私です。 — SEO Japan