常に進化を続けるGoogleですが、Googleの社員以上にGoogleのアルゴリズムに詳しいといわれるGoogle特許オタクのSEO by the Seaが最新のGoogleのランキングシグナル、つまり上位表示の要素についてまとめてくれた記事を。Google+視点で書かれておりソーシャル要素が中心となっていますが、

オーソリティプログラム無き今、オーソリティ構築の観点からも重要な項目が目白押しです。 — SEO Japan

最近、Googleのランキングシグナルをリストアップした長文の記事を数本読んだ私は、自分でもランキングシグナルに関する記事を書いてみたくなった。

今回のブログの投稿では、7つ目までのシグナル、そして、8つ目の「フレーズベースのインデックス」特許に記載されていた共起マトリックスを取り上げる。

また、取り上げたシグナルに関連するSEOの取り組みにおいて、特に重要だと私が考えた論文と特許へのリンクも提供する。

それでは、8つ目までのシグナルを紹介していこう:

1. ローカルの相互的なつながり

この連載では、Googleが、過去に、クエリに対する検索結果のランク付けに利用してきた可能性が高い、各種のランキングシグナルを検証していく。

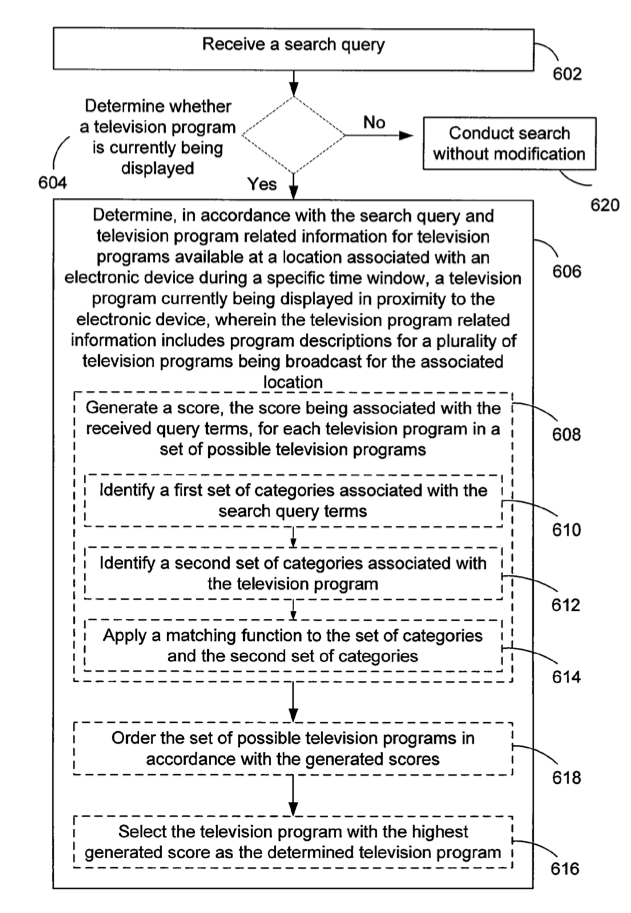

2001年、クリシュナ・バーラトが、米国特許商標局に特許を出願した。この特許は、2年後の2003年に付与された。この技術は、上位の検索結果(トップ 100、トップ 1000等)の中から、「ローカル」の背景において相互に「言及」している、または、「リンク」が張られている頻度に応じて、一部の検索結果のランキングを押し上げるものであった。

本特許によると、検索結果は、関連性や重要度(PageRank)等、通常の順序で並べられる。続いて、再び精査が行われる。そして、ローカルの関連性スコアが加えられ、結果の順序が変更される:

ローカルランクは、ページに対する古いスコアと平行して考慮される

さらに、このメソッドは、生成された一連の文書をランク付けして、各文書に対するローカルスコアの値を計算する。ローカルスコアの値は、生成されたセットの別の文書から言及された回数を数値化している。

クリシュナ・バーラトが、ヒルトップアルゴリズムを適用して、2000年代前半のGoogleの仕組みを書き直したことは、よく知られている。本特許の「その他の参照情報」の欄には、Googleに入社する前に、バーラトが、ヒルトップについて、そして、その仕組みについて説明した論文が言及されている:

ヒルトップ: 専門的な文書をベースとした検索エンジン

Googleは、それ以来、その他のシグナルに応じて、ローカルの結果を押し上げる、または、格下げする仕組みを説明する、複数の特許と論文を発表しており、今後、この連載で取り上げていく予定だ。

ローカルをつながりを基に結果のランキングを変更

2. ハブとオーソリティ

ウェブページに2つのセットのスコアが与えられたと仮定しよう。この2つのセットのスコアは、例えば、「バイクについて詳しく知りたい」、のような「広範なトピック」に与えられる。

1つ目は、オーソリティスコアであり、広範なトピックにどれだけ答えられているかに応じて決められる。2つ目は、ハブスコアであり、リンクの複雑な関係を示す。このスコアは、当該のトピックに対するオーソリティのレベルに高いページを見つけるために用いることが可能である。

リンクを張った特許は、考案者がAltaVistaに務めていた際に作成したものである。その後、OvertureがAltaVistaを買い取り、続いて、Yahoo!がOvertureを買収し、Yahoo!のものになった。考案者の一人は、1つ目のシグナルで取り上げたクリシュナ・バーラトである。そして、この特許には、モニカ・ヘンジンガーも参加している。いずれかの特許に目を通しておくことを薦める。

特許で言及されている論文には、SEOを研究しているなら、そして、ページが検索結果でランク付けされる仕組みを学んでいるなら、読んでもらいたい。この論文を綴ったのは、ジョン・クラインバーグである:

ハイパーリンク環境での信頼できるソース(pdf)

特許に進む前に、出来るだけこの論文を読んでもらいたい — 特許を読み、理解しやすくなるためだ。

この特許は、クラインバーグが綴った論文におけるハブとオーソリティのアルゴリズムを改善し、意味が複数存在する可能性がある用語に焦点が絞られる際に、トピックの脱線を防ぐことを重視している(例えば、Jaguarは、自動車メーカー、動物、または、ジャクソンビルを本拠地にするNFLのチームを指すこともある)。

コンテンツが取り込まれ、続いて、つながりに応じてランクの変更が行われる

バーラトとヘンジンガーは、共にGoogleに入社したものの、この特許と論文は、Googleが所有しているわけではない。ハブとオーソリティのスコアの要素は、この文書で確認してもらいたい。

コンテンツとつながりの分析を用いて、ハイパーリンク化されたページをランク付けするメソッド

3. 到達することが出来る確率

この特許には触れずにはいられなかった — 100-200点のランキングシグナルを1日に1つ取り上げていくつもりだが、このペースを辛抱強く続けることが出来るかどうかは不明だ

始めに取り上げた2、3つシグナルでは、重要な役割を担うオーソリティとハブをGoogleが特定しようとしている点、そして、一部のページは、高くランク付けするべきである点に注目した。

この特許は、他のページからリンクが張られたページに対して、リーチャビリティ(到達することが出来る確率)を特定するため、ユーザーの行動に関するシグナルの確認に焦点を絞っている。良質なハブページは、オーソリティレベルの高いページに導く傾向がある。ある程度、優れたハブとしての役目を持つページのスコア付けに似ている。

本特許は以下の記事で取り上げたことがある:

Googleは文書のランキングにリーチャビリティのスコアを用いているのか?

つまり、その他のリソースに向かうページのリンクの品質の数値を基準として、優れたページは、当該のページのランキングを押し上げることもあり得る。

リーチャビリティスコアによる当初のランキングの変更

スティーブン・レヴィは、Googleに関する本を綴り、Googleが、品質のシグナルとして「ロングクリック」を重視していると指摘している。本特許でも、Googleがロングクリックを特定する仕組みには触れているものの、直接的なランキングシグナルとして利用しているとは明記されていない。本特許は、ロングクリックを用いて、複数のページにリンクを張り、結果的にロングクリックを実現したページの質を特定する仕組みを描いている。このページは、良質なハブページの可能性が高い。

リーチャビリティの特定

4. バースト

ジョン・クラインバーグは、一定の時期に、例えば、中間試験や期末試験が近づいて来ると、テストや業務時間の延長に関するeメール等、特定のトピックに関するeメールが増えることに、ある時、気がついた。

クラインバーグは、この類の行動はウェブ上でも行われており、様々イベントによって、ブログで、ニュースで、そして、検索クエリ等で、特定のトピックの発生を促していることを察知した。そして、大統領のメッセージ、2回目の任期、このメッセージを導くイベント等、アーカイブを調べ、情報の流れについて注目するようになった。

クラインバーグは、調査の中で、大統領の演説に用いられたワードに注目していた。

トラフィックがネットワークを通る際は、安定して流れるのではなく、一気に移動する(バースト)。バーストにパターンが見られることもある。人気の高いトピック、既に落ち着いたトピック、季節限定のトピック、または、時間や曜日の影響を受けるトピックを把握しておくと、役に立つかもしれない。

検索エンジンが用いるランキングシグナルを挙げるリストには、「新鮮さ」等の用語が登場することが多い。ニュースやブログ検索等のアイテムに対するアルゴリズムには、「新鮮さ」が重要なシグナルの役割を果たすものの、検索エンジンが、図書館のように情報源の役目を果たす際は、歳月を経た結果が求められている可能性もある。

モニカ・ヘンジンガーが、ウェブ文書の始期に関する特許をGoogleのために作成した際、文書は、初めて配信された日付、また、検索エンジンに初めてクロールされた日付に応じて、始期が決定されると指摘していた。日付によって、このような文書のランキングが決まることもあれば、一連の検索結果の相対的な古さの影響を受ける可能性もある。

「declaration of independence」(独立宣言)を検索し、古い文書が多く返されたら、Googleは、古い文書の表示を求めており、検索結果で優先していると思われる。一方、「Windows 8.1」を検索すると、検索結果には新しいページが多く掲載されているはずである。この結果では、新しい文書が優先されると見られる。

「justin bieber canada」(ジャスティン・ビーバー カナダ)の検索が急激に増えた場合、集中的に情報が流れ、その結果、より新鮮な文書が上位に押し上げられると、Query Deserves Freshness(新鮮さを優先したクエリ)アルゴリズムが発動され、ニュース記事や新しいページが、検索結果で優遇される可能性がある。

ただし、古いページが、上位に掲載されることもあるため、一概に「新鮮さ」と言う用語を使うべきではない。

オンライン情報の一時的な動態(PDF)

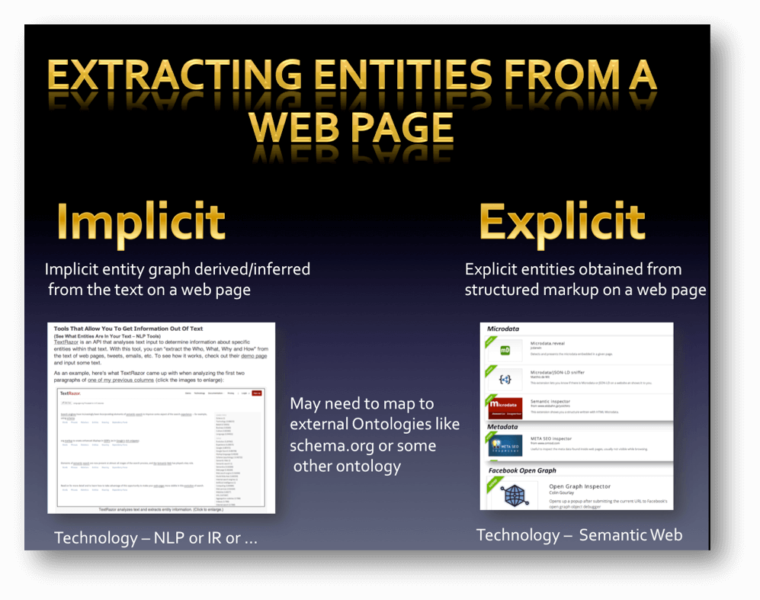

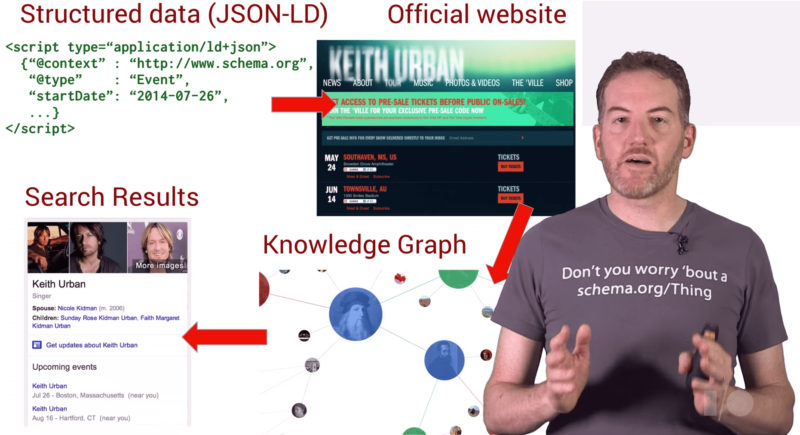

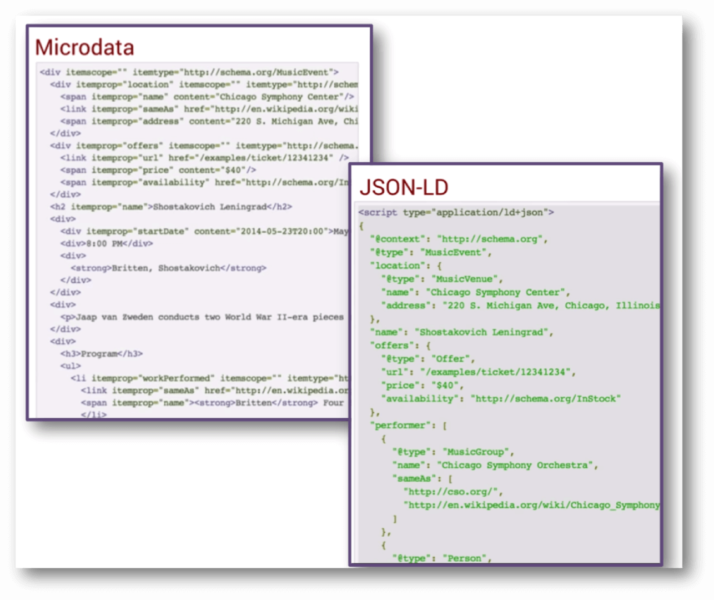

5. セマンティックな面での近さ

「セマンティック」と言うワードを聞くと、セマンティックマークアップやschema.orgのマークアップを探す方がいる。このグループに属するなら、この投稿を読む必要はない。

また、ヘッダーの要素を確認し、その他のテキストよりも大きく、そして、濃いため、ヘッダー内の用語における検索結果で、優遇されるのかどうかを考える方もいる。このグループに該当する方もまた、この投稿を読まなくても良い。

その一方で、ページ上でリストを目にした際に、厳密には、HTMLのリストの要素を使う必要がない状態で、リスト内のアイテムをアルファベット順、または、ワードの長さ順、もしくは、適当に並び替えることが可能である点、また、リストのそれぞれのアイテムが、その他のアイテムと同じぐらい重要である点を考える方もいる。そして、ヘッダーのリスト内のワードとその他のリストのアイテムとの距離が同じだと考える。

この「近さ」は、検索エンジンおよびSEOにおいて、魔法のような効力を持つ。「アイスクリーム」で検索を行った場合、フレーズ「アイスクリーム」を含むページは、「店にクリームを買いに行ったら、アイス(氷)の上で転んだ」より関連性が高く、上位にランク付けされるはずである。

リストでセマンティックの近さを示すため、この特許の画像に注釈をつけた。

このリストのアイテムは、ヘッダーからの距離が等しいだけでなく、ページのヘッダーの要素への距離、そして、ヘッダーの中身の各ワードへの距離も等しい。この点を私が心得ているのは、Googleの「セマンティックの近さの定義で取り上げられていたためだ。

先程も申し上げた通り、セマンティックの近さをもたらす上で、schema.orgのマークアップは、必ずしも必要とされるわけではない。ワードには意味が存在し、そして、一部のHTMLの要素には、意味が刻み込まれている。HTMLのページで、それぞれのアイテムを提示する以上の役割を担っている。

従って、ヘッダーの要素とGoogleでのランキングの間に相関関係が存在しないと誰かが言っていたら、セマンティックの近さを説明してもらおう。考え込んでしまうはずだ。この段階で、答えを出せないなら、永遠に理解することは出来ないだろう。

文書内の用語間のセマンティックな距離を基に文書をランク付け

6. ページの分割

なぜMicrosoftのリンクが?と訝しく思う方もいるかもしれない。それは、ページの分類に関する調査をGoogleやYahoo!よりも本格的に行い、アイデアとコンセプトをより深くし理解しているからに他ならない。

分割を説明するMicrosoftのVIPSの論文。

Googleもページ分割のコンセプトそのものを取り上げた特許を幾つか持っている(「SEOの最重要特許」シリーズで言及している)。

以下に、レポートと特許でMicrosoftが指摘しているポイントの一部を挙げていく:

- ブロックレベルのPageRank: ページの異なるブロックやセクションのリンクが、PageRankの過去のアプローチでのページのようにPageRankを運ぶ。

- ページで、とりわけ、複数のストーリーを持つ雑誌タイプのページで、最も重要なブロックを特定する方法 — 最も重要なブロック内のテキストのRelevance Value(関連値)が最も高くなるように。

- ブロック、または、セクションの言語の特徴を基に、ページの異なるブロックやセグメントを分析し、理解する手法。

ブロックのコンテンツは、基本的に、センテンスケース内の完全な文を用いており、最初の複数のワードのみ大文字で表記されているか?

ブロックは、タイトルケース内で、ワード/フレーズのリストのみであり、主に、別の場所にリンクを張っているか?

ブロックには、著作権通知が、主にフッターに掲載されており、関連性の面で、とりわけ低くランク付けされるようになっているか?

ウェブページの分割に関しては、ブログで何度か取り上げたことがあり、もう少し詳しい情報が欲しい方は、是非、参考にしてもらいたい:

VIPS: ビジョンベースのページ分割アルゴリズム

7. リーゾナブルサーファー PageRank

PageRankは、Googleが、その他の検索エンジンと一線を画すきっかけを作ったアルゴリズムであった。しかし、当初のアルゴリズムと、現在のアルゴリズムは同じではない。90年代後半のPageRankを正確に説明することが出来る自信はないが、異なるモデルに注目してもらいたかった。

リンクによって、重み(重要度)、PageRankの量、さらには、ハイパーテキストの関連性のレベルは異なる。これは、Googleのスタッフが数年前に明らかにしているポイントである。Yahoo!やBlekko等の検索エンジンにおいては、例えばブログのコメント欄のリンク等、リンクによっては、完全に無視されることもある。

リンクの特徴が重みを決める

この特許でも指摘されているように、Googleは、ページの「利用規約」のアンカーテキストを確認すると、自動的に当該のページにはPageRankを送信しない決断を下すと見られる。

本特許を発明した人物の欄に、ジェフリー・ディーンの名前が掲載されている。この人物の名前は、その他のGoogleの特許にも何度も登場する。ジェフリー・ディーンは、Googleが作っている全世界的なデータセンターに関わる技術的な課題、そして、機械の全体的な仕組みを取り上げることが多い。Googleの特許を読む時間があるなら、ディーンが書いた特許に目を通してみる価値はある。「Googleでのリサーチ活動」ページを見ると、圧倒されてしまうだろう:

ジェフリー・ディーン — Googleでのリサーチ活動

数年の間に、PageRankに関する文書が多数綴られているが、リーゾナブルサーファーに関する文献を読んでいないなら、ランダムサーファーからの移行を理解することは出来ないため、是非、読んでもらいたい。

以下に、手始めに読んでもらいたい記事を紹介する:

Googleのリーゾナブルサーファー: リンク、文書の特徴、ユーザーデータに応じてリンクの価値は異なる

ユーザーの行動/特徴のデータに基づいて文書をランク付け

8. 共起マトリクス

過去10年で、フレーズベースのインデックスに関する記事を多数投稿してきたが、これは当時、SEOのトピックとして、とりわけ重要度が高かった。しかし、無視されることも、軽視されることも多かった。それでも、実際には、フレーズベースのインデックスの仕組み、そして、Googleの転置インデックスの仕組みを指摘する特許は多い。

フレーズベースのインデックスを考案した発明者は、21世紀で最大級の検索エンジン、Recall(インターネットアーカイブでデータとして用いられていた)の発明者にも名を連ねていたアンナ・パターソンである。アンナ・パターソンは、Googleを去り、夫のトム・コステロと共に検索エンジンのCuilをローンチした。Cuilは、ローンチ時に1兆2000億ページがインデックスされていると推定されていた。Cuilは失敗に終わったが、アンナ・パターソンは、すぐにGoogleのリサーチ部門の責任者に就任していた。

フレーズベースのインデックスでは、ウェブページで有益で良質なフレーズが特定され、転置インデックスにおいて、ページにフレーズが散りばめられていく。クエリに対する検索結果では、トップ 100、または、トップ 1000で共起するフレーズの特定が行われると見られる。複数の意味を持つワードやフレーズにおいては、同様のトピックに関するページにまとめられ、共起するフレーズを探し出す。

フレーズベースのインデックスにおけるシステムの概要

この共起するフレーズは「関連するワード」と呼ばれ、初回のクエリに対して上位にランク付けされている可能性のあるページに表示される際、Googleは、検索結果で優先すると考えられる。「関連するワード」が、統計的に見て、多過ぎる場合、Googleは当該のページをスパムと判断すると推定される。

Googleは、「関連するワード」をアンカーテキストの中で探し、共起するレベルに応じて、アンカーテキストに関連するリンクの重みを別々に判断する可能性がある。以下に、この仕組みを説明する特許に記載されている一節を紹介する。先程述べたHITSアルゴリズムを鑑みると、共起の多い関連するワードを「専門的な文書」と呼んでいる点は注目に値する。

[0206] R.sub.i.Q.関連するフレーズのベクター R*D.Q.関連するフレーズのビットのベクター。

[0207] プロダクトの価値は、アンカーフレーズ Qの文書 Dに対する関連度のスコアで決まる。このスコアを、「インバウンド・スコア・コンポーネント」と呼ぶ。このプロダクトは、参照する文書 R内のアンカーフレーズの関連性ビットベクターによって、現在の文書 Dの関連性ビットベクターを計測する。参照する文書 R自体が、クエリフレーズ Qに関連している場合(そして、関連性フレーズのビットベクターの値が高い場合)、現在の文書 Dのスコアの重要度を引き上げる。本文のヒットスコアとアンカーのヒットスコアを組み合わせて、先程説明した文書スコアを生成する。

[0208] 次に、参照する文書 Rに対して、それぞれのアンカーフレーズ Qの関連するフレーズのビットベクターを取得する。これは、アンカーテキスト Qが、文書 Rに対して、どれだけ関連しているかを計測する値である。この値を、アウトバウンド・スコア・コンポーネントと呼ぶ。

[0209] インデックス 150から、アンカーフレーズ Qに対して、(参照する文書、参照された文書の)全てのペアが抽出される。このペアは、関連する値(アウトバウンド・スコア・コンポーネント、インバウンド・スコア・コンポーネント)に応じてソートされる。実装に応じて、片方のコンポーネントは、第一ソートキーになり、残りのコンポーネントが、第二ソートキーになる。ソートされた結果は、ユーザーに提示される。アウトバウンド・スコア・コンポーネントで文書をソートすると、クエリに対する関連するフレーズを多く持つ文書は、高くランク付けされ、「専門的」な文書として提供される。一方、インバウンド・コンポーネント・スコアでソートを行うと、アンカーの用語において頻繁に参照される文書が上位にランク付けされる。

特許「フレーズベースのインデックス」は、とても内容が濃く、また、詳細を検証する必要のある要素が多数追加されている。この要素については、以下の投稿で多数取り上げているが、残りの特許を見ていくと、Googleが共起マトリクスを活用するその他の多くの手段が明らかになる。

フレーズベースの情報検索とスパム検知

「SEOの最重要特許ベスト10 その5 – フレーズベースのインデックス」(日本語)で特許の多くを取り上げているので、是非、目を通しておいてもらいたい。

複数のインデックスをベースとした情報検索システム

エピローグ

このシリーズは今後も継続していく。ただし、裏付ける情報が存在しないため、このシリーズから漏れるシグナルも多数あるだろう。ランキングシグナルのリストの中には、作り話以外の何でもない要素も多く、このシリーズで幾つか言及するかもしれない。

Googleは、複数のアルゴリズムを利用している可能性は高く、また、1年間に約500点の変更をランク付けの仕組みに加えていると明らかにしている。

この点に関しても、詳しく調べていくつもりだが、自分でリサーチしたい方々が、調査に取り掛かることが出来るように、十分な量の特許を紹介していきたいと思う。因みに、リサーチを行うなら、是非、連絡して頂きたい。

この記事は、SEO by the Seaに掲載された「The Incomplete Google Ranking Signals, Part 1」を翻訳した内容です。

余りに濃すぎるその内容、マニア以外は読む気にならないかもしれませんが、改めて考えてみると過去にSEO Japanで紹介してきた様々なGoogleの最新アルゴリズムが適度にまとまった記事でした。これまでの記事を敬遠して読んでこなかった方も、これ一本で十分かも、と記事の最後にいうのもなんですが。 — SEO Japan

Innocent Drinksも気に入っている。同社は、非常に競争の激しい業界に参入し、誰もが失敗を予想していた。しかし、この悲観的な予想を裏切る結果を同社は達成した。この成功をもたらした要因は、製品と結びつけたストーリーであった。

Innocent Drinksも気に入っている。同社は、非常に競争の激しい業界に参入し、誰もが失敗を予想していた。しかし、この悲観的な予想を裏切る結果を同社は達成した。この成功をもたらした要因は、製品と結びつけたストーリーであった。