Google Cloud Platform(GCP)が今日(米国時間9/21)、Google Compute Engineに、Nvidiaの強力なGPUのサポートを加える、と発表した。

同社はすでにNvidia K80 GPUをサポートしているが、今回はNvidia P100 GPUのインスタンスが新たな長期料金体系(sustained pricing model)によりベータで加わる。

機械学習のワークロードを抱える企業にとっては、クラウドでGPUを利用できれば、分単位の料金制でも柔軟な利用が可能だ。しかし長期料金制なら、一定の長時間、最大30%の割引料金で利用できる。言い換えると、(額が最初からわかっているので)月末になって巨額な請求にびっくり仰天することはない。

そしてGoogleの主張によれば、この方式によりベアメタルに近いパフォーマンスを享受できる。GPUサポートを発表するブログ記事で、Googleはこう言っている: “クラウドのGPUは、ベアメタルのパフォーマンスを得るために提供される便宜である。それは1 VMあたりP100が最大4、K80なら最大8となる(K80のボードは最大4で、一枚あたり2 GPUだ)”。

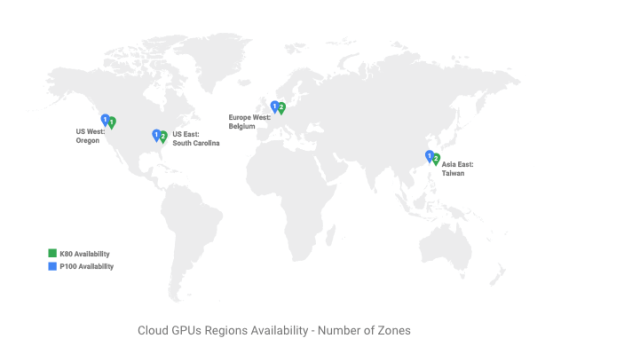

GPUのワークロードは仮想マシンで直接動かしてもよいし、コンテナに収めてもよい。下図のように、サービスは世界の4つの場所から提供される:

地図提供: Google

Googleが想定しているこのサービスの主な用途は、遺伝子研究や金融工学、機械学習のモデルの訓練と推断など、さまざまな計算集約的なタスクだ。二種類のGPUが提供されるため、ワークロードの特性に応じて速度と料金の適正な均衡をユーザーは実現できる。このGPUクラウドの初期の顧客Shazamは、その音楽同定(音→曲名アーチスト名)サービスに利用している。