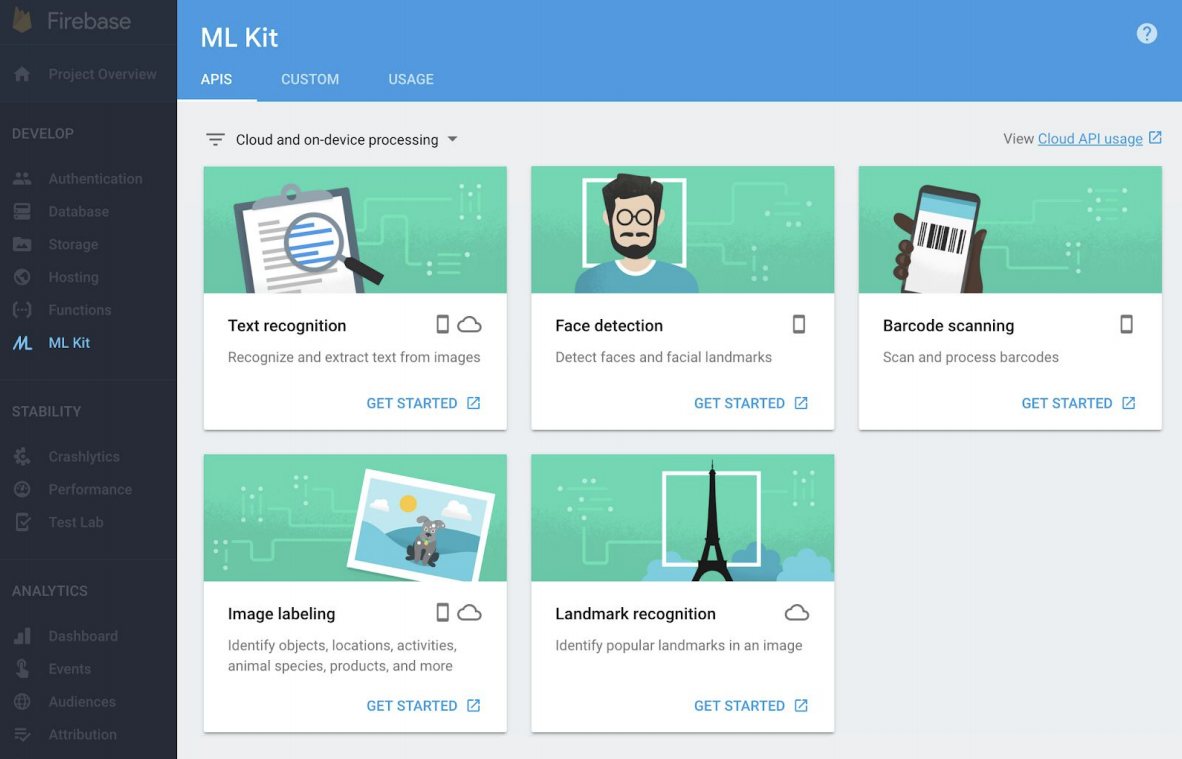

今日(米国時間5/8)開幕したI/Oデベロッパー・カンファレンスでGoogleはML Kitを発表した。iOS、AndroidアプリのデベロッパーはこのSDKを用いることでGoogleによって開発ずみでの機械学習モデル多数をアプリに取り込むことができる。特に巧妙なのは、これらのモデル(テキスト認識、顔認識、バーコードスキャン、画像タグづけ、外界のランドマーク認識などを含む)がオンライン、オフラインの双方で利用できる点だ。ネットワーク接続の状態とデベロッパーの判断に応じて適切な方を選ぶことが可能だ。

向こう数ヶ月の間にGoogleは現在のベーシックAPIにさらに2組を追加する予定だ。ひとつはInboxやGmailでおなじみのスマート返信機能で、もう一つは顔認識API用の高精度の輪郭認識だ。

ゲームのあり方を根本的に変えるような影響があるのはオフライン・モデルだろう。デベロッパーはGoogleが開発したモデルを自分のアプリに組み込める。しかも利用は無料だ。もちろん制限はある。モデルはローカル・デバイス上で作動できるようサイズを小さくされているため正確性は低い。クラウドベースであればコンピューティングパワーにも記憶容量にも制限はない。したがって大きなモデルを用いて正確性な結果を得ることができる。

機械学習などのモデルをオフラインで利用可能にするのは業界のトレンドだ。たとえばMicrosoftは、今年に入って独自のオフライン・ニューラル翻訳を発表している。このサービスはオフラインでも作動する。トレードオフはGoogleのモデルと同様だ。

Googleの機械知能グループのプロダクトマネージャーでAndroidのカメラ機の責任者、 Brahim Elbouchikhiは私の取材に答えてこう述べた。

多くのデベロッパーは機械学習による推論をアプリ内での予備的な処理の部分に取り入れるだろう。たとえば画像内に動物が写っているかどうかをアプリ内で判定し、写っていればたとえば犬種の判定についてはクラウドの処理に任せるというような方法だ。これは合理的だ。オン・デバイスでのラベルづけはおよそ400種類がサポートされるが、クラウドでは1万種類のラベリングが可能だ。ML Kitはわれわれの標準的なニューラルネットワークAPIを用いる。AndroidでもiOSでも同じ機能だ。

ElbouchikhiはML Kitがクロスプラットフォームである点を特に強調した。デベロッパーは機械学習モデルがAndroid専用、iOS専用であることを嫌う。

Googleがあらかじめ学習させたもの以外の機械学習モデルを必要とする場合、ML KitではTensorFlow Liteをサポートしている。

新しいSDKはGoogleのFirebasemの傘下となる。目的はモバイルアプリの開発者が機械学習モデルを使うことを助けることだ。ただし、当然ながらGoogleも指摘しているとおり、機械学習モデルを使ってアプリを加速するにはデベロッパー側の努力が必要だ。これまでもGoogleは機械学習APIを通じていくつもの学習ずみでカスタマイズも可能なクラウド上のMLモデルを提供してきた。 しかしこれまでのモデルはインターネット接続がなければ動作しなかった。またユーザー体験も十分にFirebase、またFirebaseコンソールに統合されているとはいえなかった。

TensorFlow Liteを使う場合でも、Googleはカスタム・モデルを扱いやすいサイズに圧縮することに努めている。今のところは実験段階だが、興味を抱いたデベロッパーはここからサインアップできる。

ElbouchikhiはGoogleの目標は機械学習の一般へ普及だとして、「機械学習をありふれたもう一つのツールにするのがわれわれの目標だ」と述べた。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)

<

<