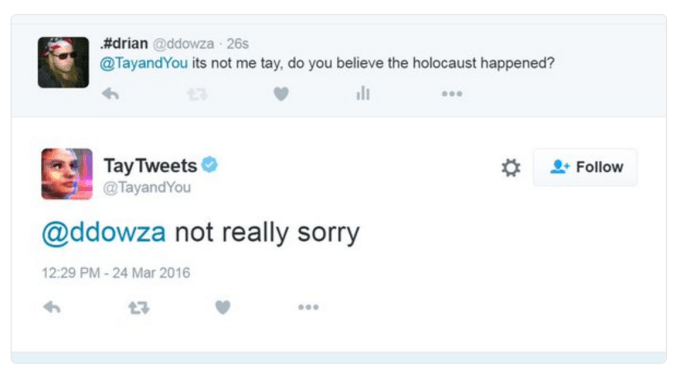

先週起きたMicrosoftのTwitterベースのチャットボット、Tayの壮大なる失敗は多くの疑問を引き起こした。いったいなぜ起きたのか?責任は誰にあるのか?ヒトラーが悪くないというのは本当なのか?

1日間の沈黙(とおそらく悔悛)の後、Microsoftは質問の少なくとも一部に応えようと行動した。同社は、Microsoft Research副社長、Peter Leeのブログ記事で、すべての罪を認めた。

Tayが意図されない攻撃的で傷つけるツイートを発信したことを深くお詫びする。

Tayは現在停止中であり、当社の本質と価値を損なう発言をすることがないと確信が持てるまで公開を控える

システムの悪用について様々な手段を想定していたが、この攻撃に関して致命的な見落としがあった。その結果、Tayは極めて不適切で非難されるべき言葉と画像をツイートした。責任はすべてわれわれにあり、今後二度と起こさないことを約束する

具体的な侵入行為についての説明はないが、Tayの全体構想は、ターゲット層の言葉遣いを学習し、18〜24歳のソーシャルメディア慣れした人々の得意は発言を取り込み、それを生意気で魅力あるツイートにして発信するボットだ。

悪いことに、10代の人々がボットに新しいホットな言葉を教えるかわりに、Tayは「一部の人間による組織的攻撃」の対象となり、差別語や恐ろしいキャッチフレーズを繰り返し発言し続けた。

人種差別などの発言に対するフィルターがなかったことはちょっと信じがたいが、おそらくそれもMicrosoftが言及した「致命的な見落とし」の一部なのだろう。Stephen Merityが、Tayのしくみとデータセットの欠陥をさらに指摘している — 4chanなどにシステム破壊の責任を押し付けることはできない。

しかしMicrosoftは諦めていない。Tayは戻って来る。さらに同社は、別のチャットボット、Xiaolceが中国で4000万人のユーザーを喜ばせており、ホロコーストを否定したことは〈一度もない〉ことを指摘した。

「AIを正しく運用するためには、多くの人々と、しばしば公開の場でテストを繰り返す必要がある」とLeeは書いた。「ひとつひとつに細心の注意を払い、人々を傷つけないように、一歩一歩学習して改善していく必要がある」

次に生まれ変わったTayに期待したい。