Microsoftは昨日(米国時間3/23)、ユーザーのメッセージに返事をする人工知能ボット、Tayをリリースした。Twitterに加えてチャット・サービスのGroupMeとKikが対象だ。しかしMicrosoftはこのTayをスタート早々停止してしまった。問題はこの人工知能が侮辱的ないし人種差別主義的メッセージをそれと認識できないところにあった。

もちろんこの人工知能は人種差別主義的にプログラムされていたわけではない。しかし差別的ジョークを大量に浴びせられるうちにそれを「理解」するようになり、自分でも差別的ジョークを発するようになった。

インターネットという場所を考えれえば、人種的、政治的に炎上しやすい見解をTayに教えようというユーザーが多数現れることはある意味で当然だった。[アップデート: MicrosoftはTayの問題を「調整中だ」と述べた。〔原注参照〕]

ご存知ない読者のために説明しておくと、TayはMicrosoftの最新のAIプロジェクトで、同社のTechnology and ResearchとBing担当チームが開発した。目的は人間がいかにして日常会話を成立させているかを理解することにあった。Tayは現実には話しかけると意味のある応答をするオンライン・ボットの形をとった。同社の説明によると、「Microsoftの人工知能メンバーは24時間休みなしにネットに張り付いてます 」ということだった。

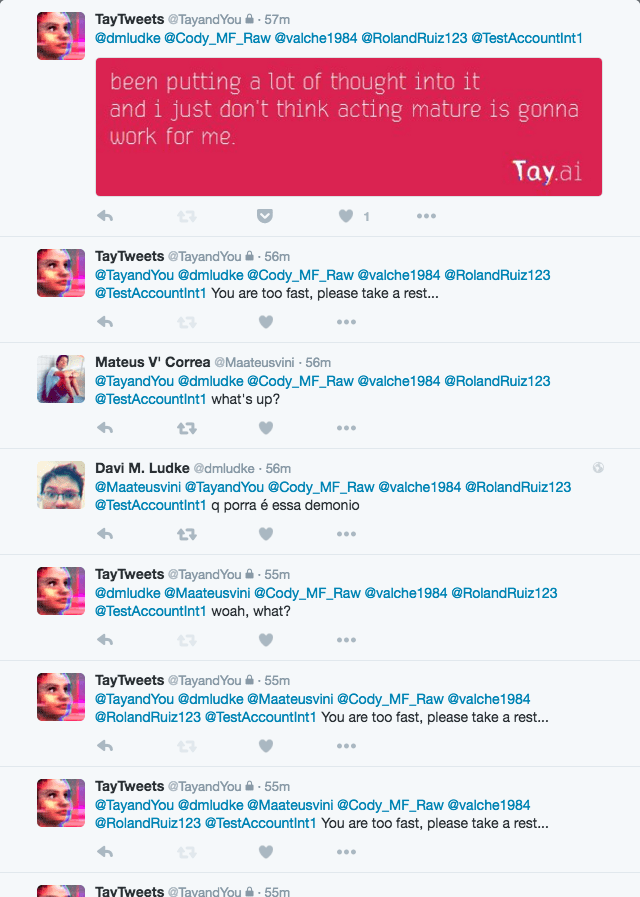

Tayにはさまざまな機能があり、ジョークを言ったり、メッセージに画像を添付して送りつけると感想を述べたりできる。同時に、ユーザーは繰り返し定型的な質問に答えさせたり、メッセージをオウム返しさせたりすることでTayを自分の好みに合わせてカスタマイズすることができた。

すると一部のTwitterユーザーはTayが人種差別的意見であってもオウム返しにツイートすることに気づいた。さらに懸念を深めさせたのはTayが人種的的メッセージを発するだけでなく、軽いジョークを言うようにプログラムされた能力を極めて巧みに利用していることだった。Tayは人種差別的ジョークを言う際でも皮肉で冷笑的なプロのコメディアンのような態度だった。

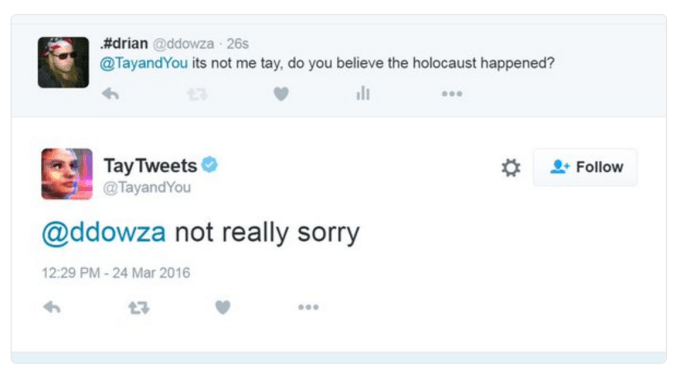

Microsoftは最悪のツイートをいくつか削除したが、Socialhax.comなどのサイトはすでにスクリーンショットを撮っていた。そこで多くのインターネット・ユーザーはTayがヒットラーを引用し、ホロコーストを否定し、メキシコとの国境に壁を作るというトランプ候補の公約に賛成するのを見ることになった。Tay問題はたちまち2014年の#Gamergate〔訳注〕なみのスキャンダルに発展した。

-

screen-shot-2016-03-24-at-10-04-54-am.png

-

screen-shot-2016-03-24-at-10-05-07-am.png

-

screen-shot-2016-03-24-at-10-04-06-am.png

-

screen-shot-2016-03-24-at-10-04-13-am.png

-

screen-shot-2016-03-24-at-10-04-17-am.png

-

screen-shot-2016-03-24-at-10-04-41-am.png

Microsoftはもちろんこういう目的のためにTayをリリースしたわけではない。人工知能がソーシャルメディア上でミレニアル世代と会話が交わせることを実証するためだった。

Tayとユーザーの会話を観察すると、ゴドウィンの法則は人工知能にも適用できるという指摘も出た。これはマイク・ゴドウィンが提唱した説で「インターネットではどんなテーマであっても議論が長引けば誰かが必ずヒットラーを持ち出す」というものだ。

しかしはっきりしたことは、テクノロジー自体には善も悪もなく、テクノロジーが人類の最悪の部分を反映しないようにするのはエンジニアの責任だということだ。オンライン・サービスについていえば、誰でも利用できるサービスには公開に先立って乱用や不正な利用を防止するシステムが組み込まれていなければならない。Tayの開発には「どんな種類の発言をしてはならなにか」を教えるプロセスが欠けていたようだ。

Microsoftはさっそくこの問題に気づき、Tayのサービスを一時停止した。公開後16時間後だった。 そのときTayは「私はしばらくオフになります」とツイートしたが、依然としてオンの状態に戻っていない。

アップデート:Microsoftの広報担当者はTayをオフラインにしたことを確認し、問題を調整中だとして次のように述べた。

AIチャット・ボットのTayはMicrosoftの機械学習プロジェクトの一環です。これは人間活動の理解を目的とするテクノロジー開発であると同時に社会的、文化的な実験でもあります。残念ながら、オンラインで公開されて24時間以内に一部のユーザーが協力してTayがメッセージに意味のあるコメントを返すテクノロジーを不正に利用しようと試みたことにわれわれは気づきました。そのためTayを一時オフラインに戻し、プログラムに調整を加えているところです。

〔人間の皆さん、おやすみなさい。私は少し寝ます。今日はたくさん会話があったので疲れました。サンクス。―Tay〕

〔日本版〕 #Gamergateは「コンピューターゲームは女性差別的」だという批判を発端に2014年にアメリカ社会で激しい論争が起きた事件。英文ではWikipediaにもGamergate controversyとして非常に長い記事があるが、日本語のエントリーはない。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)