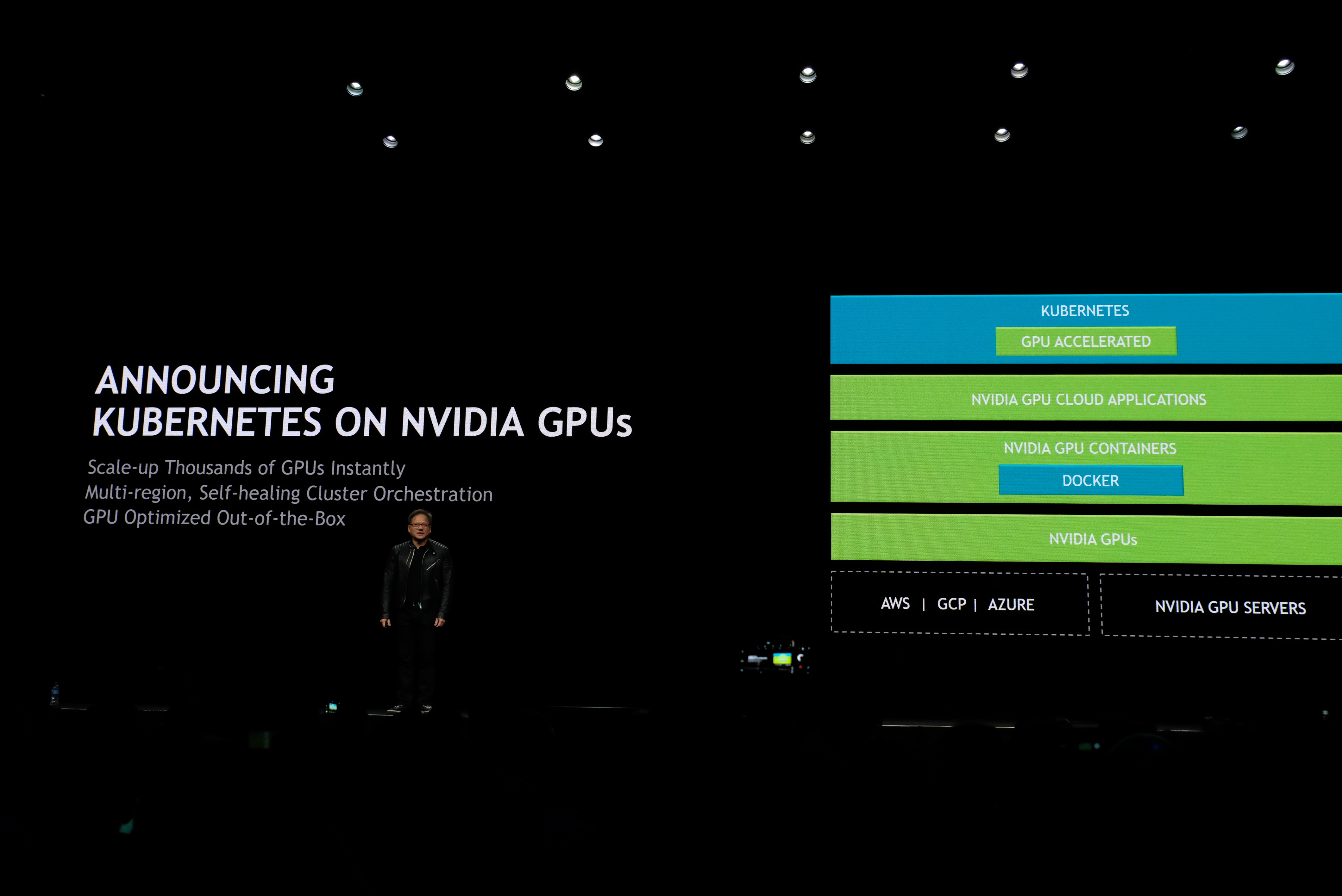

やっと、という感じだが、NvidiaのCEO Jensen Huangが今日(米国時間3/27)、彼のGTC(GPU Technology Conference)キーノートで、Googleで生まれ育ったコンテナオーケストレーションシステムKubernetesをNvidiaのGPUでサポートする、と発表した。

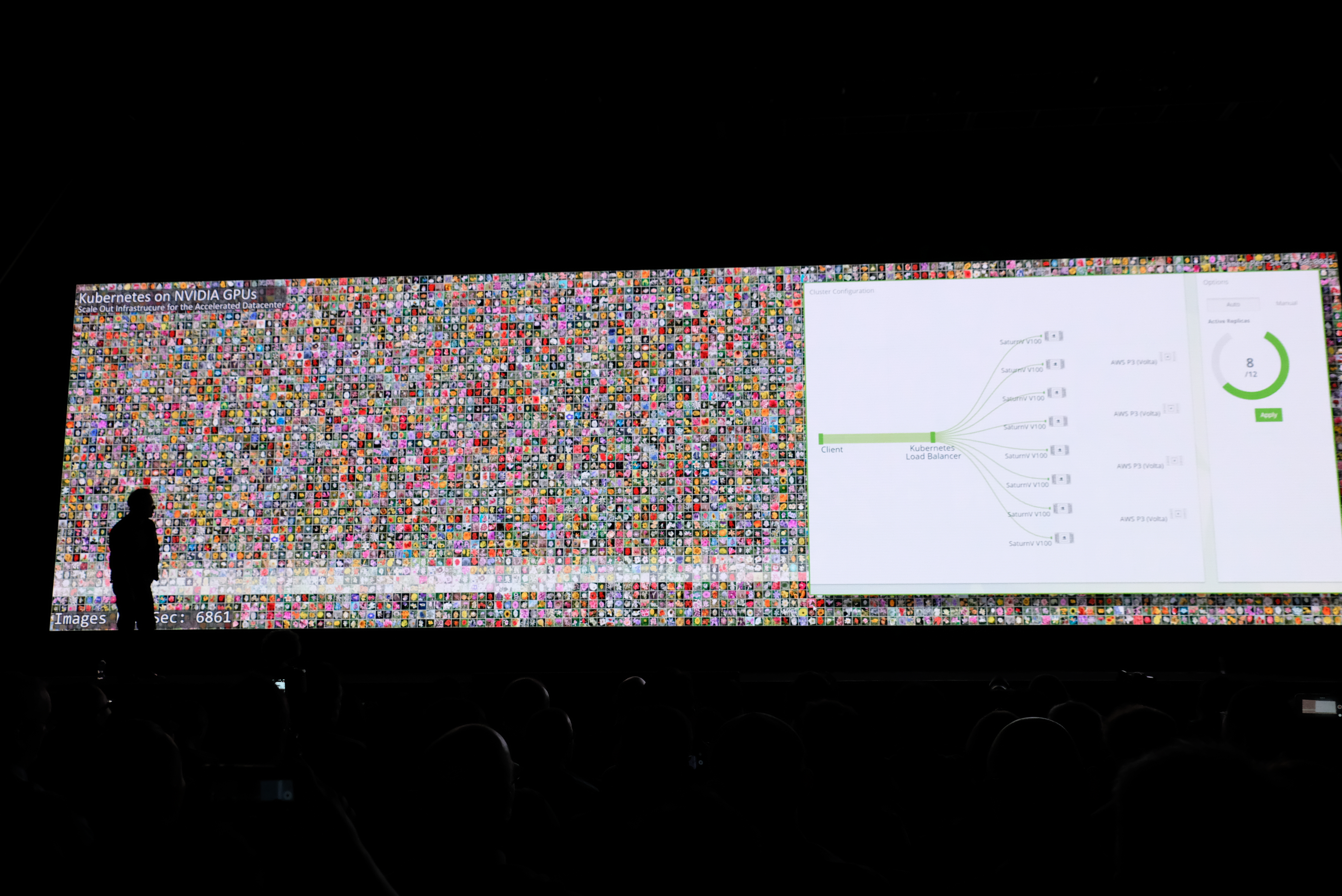

その意味は、何百何千ものGPUが機械学習処理の高速化などのために使われているような、いわゆるハイパースケールなデータセンターでGPUの使用を最適化し、デベロッパーがコンテナをなんの変更も加えずに複数のクラウドへデプロイできるようにする、ということだ。

Jensenはこう言った: “今やフレームワークは高速化し、コードも高速化した。では、それをデータセンターの世界へデプロイするにはどうするのか? そうだ、そこにはうまい具合に、Kubernetesというものがある。良かった!すごく良かった!”。

NvidiaはKubernetesのGPUによる高速化技術とそのコードを、オープンソースのコミュニティに寄贈する。機械学習のワークロードは、計算とデータの両方で巨大なものになりがちだ。Kubernetesはそんなワークロードのオーケストレーションを助け、そして今や、その仕事にGPUを使える。

Huangは次のように述べて、会場からの笑いを誘った: “Kubernetesは今やGPU対応だ。DockerのコンテナはGPUが加速する。そして私がこれまで名を挙げたようなフレームワークはすべて、GPUで加速される。そしてまた、みなさんが抱え込んでいる推論のワークロードもGPUが加速する。そしてこれらのクラウドのすべてでNvidiaのGPUが動く。そしてさらに、すばらしいオーケストレーションのレイヤとしてKubernetesがある。完全に満たされた人生だね”。

KubernetesのGPUによる高速化は、今日の発表以前にもある程度サポートされていた。たとえばGoogleは、そのKubernetes EngineですでにGPUをサポートしている。