Snapchatはビデオクリップの人物の顔を自分のセルフィーに入れ替えられる機能を準備中だ。このCameo機能は簡単にいえば、現在話題になっているディープフェイクの簡易版で、テンプレートのショートビデオから簡単に自分の顔のGIFを作って共有できる。いわばBitmojiのビデオ版というところで、エモーティコンとして自分の感情や状況をユーモラスに表現できる。Cameoが一部フランスのユーザーに公開されていることをSnapのウォッチャーである@Mtatsisが発見した。

Snapchat Cameoであなたもビデオ・スターになれる

TechCrunchがSnapに取材したところ、同社はCameo機能を一部の外国でテスト中であることを認めた。Snapは「Cameoはまだ一般公開の段階ではないが、近く世界デビューする。期待していただきたい」と述べた。以下にフランスのSnapユーザーからのツイートを紹介する。

Cameoを使うにはまず自分のセルフィーを撮ってSnapchatに「自分がどんなふうに見えたいか」を教える。ここで男性または女性ぽい体型を選べる。

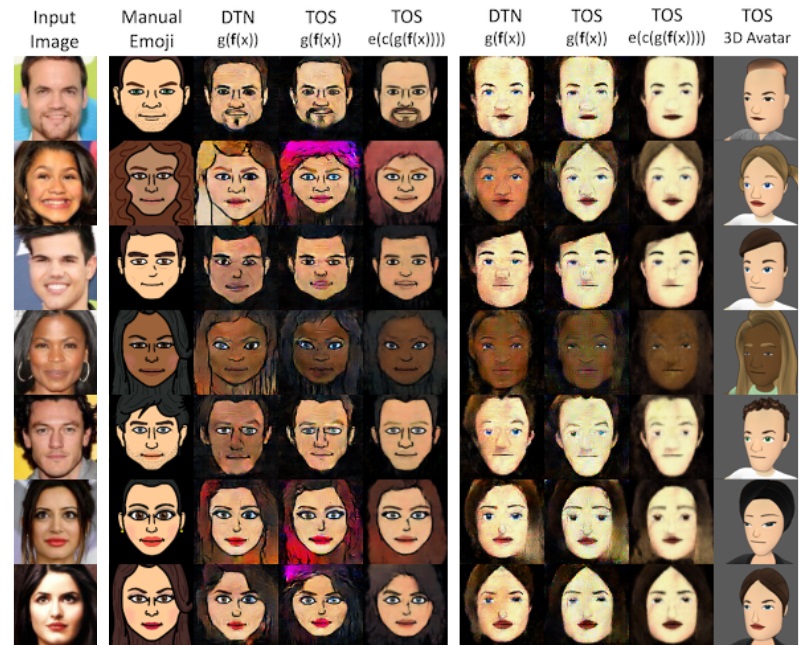

Cameoはメッセージ・キーボードのBitmojiボタンからオプションとして選択できる。Snapchatではテンプレートとなるサウンド入りビデオクリップを多数用意しているので好みのビデオを選ぶ。Snapchatは先ほどのセルフィーから得た顔情報をビデオクリップの顔に埋め込む。ビデオクリップの俳優の顔がユーザーの顔に置き換わるわけだ。ユーザーは他のエモーティコンを送信するのと同様、状況に合わせて好みのテンプレートを選ぶだけでよい。

CameoはSnapchatがアメリカでインスタント・メッセージの首位を守るために重要な手段になるだろう。FacebookグループのInstagramとWhatsAppがSnapchatがパイオニアだったストーリー機能をコピーして大成功を収めているため、Snapとしては急追するこうしたサービスとの差別化を図る必要に迫られていた。

もっともCameoのケースはSnapは中国の顔交換アプリ、Zaoをコピーしたと言われるかもしれない。これは中国で大人気となったセルフィー・ビデオをスターやセレブの顔に変えるディープフェイク・アプリだ。またJibJabが何年も前に導入したクリスマスの妖精のGIFにユーザーのアバターを貼り付ける機能も方向としては似ている。

Snapは最近ソーシャル・ゲーム中のSnapchatに広告を導入して収益化を図り始めた。 SnapはARレンズと同様の仕組みで広告主にCameoクリップを販売して収益化を試みるかもしれない。

Cameoはショートビデオの人物の顔を自分の顔に入れ替えて面白い効果を上げようとするテクノロジーだ。 しかしディープフェイクはフェイク情報の拡散やネットいじめにも利用されやすい。ポルノや政治家のビデオなどを自由に加工させるのではなく、Snapでは無害なビデオだけをテンプレートとして提供することで危険を避けようとしている。SnapchatのCameoはディープフェイクのユーモラスな利用法として成功するかもしれない。

画像:Jeff Higgins]

[原文へ]

(翻訳:滑川海彦@Facebook)

QLF (@gregv_)

QLF (@gregv_)