グーグルウェブマスターツール(WMT)は、強力な味方になり得る。しかし、ミスをすると、もしくは、間違った使い方をすると、SEOにマイナスの影響をもたらす可能性がある。この記事では、ウェブマスターツールの利点を完全に利用していない人達のために、ウェブマスターツールの基本的なSEOガイドを提供したいと思う。

これから説明するツールの一部は、その他のツールよりもサイトにより大きなダーメージをもたらすことがある点を指摘しておく。また、それぞれのツールやレポートに対する記事が既に投稿されている可能性もある。このウェブマスターツールのSEOガイドは、鋭い見解を交えた要約だと思ってもらいたい。

ウェブマスターツールのSEOガイド

メッセージ: スパムの警告 & その他の通知

優先順位: 中/高

サイトに問題が見つかると、グーグルがウェブマスターツールにeメールを送信することは、よく知られている。ウェブマスターツールのメッセージを頻繁にチェックしていない場合、重要な情報を見逃してしまう可能性がある。

重要メッセージの例として、不自然なリンクの通知が挙げられる。このようなメッセージは、重大な問題を示唆する場合もあれば、結果的に何も起こらない場合もある。特定の状況に対処するグーグルの計画に左右される。いずれにせよ、このタイプのメッセージを受信したなら、その理由を解明するべきである。

リンク警告

設定

優先順位: 高

設定のタブでは、- 地域ターゲット、使用するドメイン、そして、クロール速度の3つの設定を行うことが出来る。

地域ターゲット

グーグルは次のように指摘している。「お客様のサイトで汎用的なトップレベル ドメイン(.com、.org など)が使用されている場合は、地域ターゲティングの情報を基に グーグルでは検索結果へのお客様サイトの表示方法を決定できます。地域ターゲティングにより、地域に関連する検索結果の精度も向上します。お客様のサイトを特定の地域に関連付けたくない場合は、[指定なし] を選択してください。」

この項目を設定して、意図する地域のマーケットに狙いを定めよう。

使用するドメイン

グーグルはこの項目について、「使用するドメインを http://www.example.com と指定し、グーグルが検出したサイトのリンクが http://example.com である場合、この 2 つのリンクは同一と見なされます。」と説明している。

私は使用するドメインに関しては、ウェブサイトをどのようにインデックスして欲しいかを考慮して設定するよう薦めている。こうすることで、wwwと非wwwのドメインの双方の所有権を証明する必要がある可能性がある。

クロール速度

最後の選択肢は、クロール速度である。グーグルは、「グーグルでは、サーバーの帯域幅に大きな負荷をかけることなく、サイト内のできるだけ多くのページをクロールすることを目標としています。サイトのクロール速度(クロール処理での グーグルのリクエストの速度)は、www.example.com や http://subdomain.example.com のようなルート レベルまたはサブドメイン レベルのサイトで変更できます。新たにカスタマイズしたクロール速度は 90 日間有効です。」と説明している。

大抵の場合、ウェブマスターは、グーグルにそれぞれのウェブサイトに対するクロール速度の選択をグーグルに任せている。しかし、一部のケースでは、グーグルボットが問題を起こす可能性があり、その場合は速度を変えなければならない。

ウェブマスターツール – 設定

サイトリンク

優先順位: 中

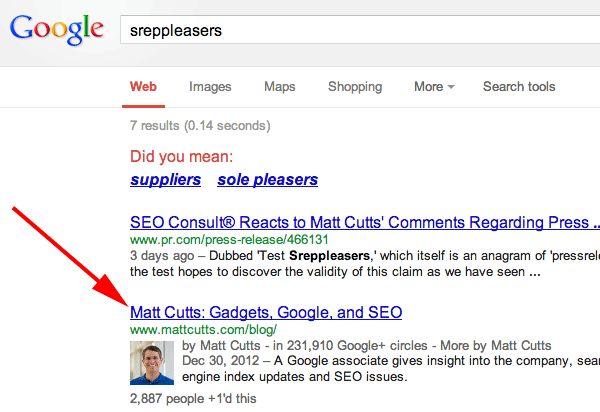

あらゆるウェブサイトのオーナーが良質なサイトリンクを求めている。ちなみにサイトリンクとは、グーグルの検索結果でドメイン名の下に表示されるリンクのことである。

小さなサイトリンク:

小さなサイトリンク

大きなサイトリンク:

大きなサイトリンク

サイトリンクは、特定のクエリに対して、ドメインが持つオーソリティの高さに基づいて決定される。サイトリンクを構築して、オンラインの評判管理を支えているウェブサイトは多い。ネガティブな情報をページの下の方に下げることが出来るためだ。

サイトリンクがどのように表示されているにせよ、ウェブマスターツールのこのセクションで、サイトリンクを降格させることが出来る。従って、何らかの理由で表示させたくないサイトリンクがあるなら、削除しておこう。

ここで一点注意しておきたいことがある。1本のサイトリンクの順位を下げた結果、全てのサイトリンクが数ヶ月間に渡って表示されなくなったケースがある。そのため、軽はずみな気持ちで、順位を下げるべきではない。

ウェブマスターツール – サイトリンク

URL パラメータ

優先順位: 高

ウェブマスターツールでは、URL パラメータを指定し、クロールするべきURLとするべきではないURLをグーグルに伝えることが出来る。これは非常に強力なツールになり得る。しかし、失敗すると、サイトの大半がインデックスから削除されてしまう。

個人的には、このツールの利用を避けるべきだと思う。このツールが役に立つ問題に直面したなら、rel=canonical、no index/no follow、301 、または、robots.txtを使う方が無難である。

このツールを利用する必要がある場合は、適切に設定していることを確認してもらいたい。また、ウェブサイトのURLの構造を熟知していることが、このツールを利用する上での大前提だと言っておこう。

サイトのURLの構造がクリーンであり、適切な人物が利用しているなら、役に立つだろう。

ウェブマスターツール – URL パラメータ

アドレス変更

優先順位: 中

引っ越しするなら、適切にその旨を伝える必要がある。

この項目についてグーグルは次のように説明している。「新しいドメインにサイトを移す際、アドレス変更ツールを使って 、グーグルに新しいURLを伝えることが出来ます。グーグルは、インデックスを更新し、新しいURLを反映させます。変更は180日間に渡って有効であり、その頃までには、新しいURLのページをクロール & インデックスしているはずです。」

ウェブマスターツール – アドレス変更

過剰な量のクロールのエラー

優先順位: 中

ウェブサイトの動きが悪く、定期的にエラーが発生しているなら、対処するべきである。しかし、現実には、エラーに対処していないウェブサイトが多い。ユーザビリティに悪影響を与えるエラーは、顧客の損失につながりかねない。

ウェブマスターツール – クロル エラー

クトールの統計情報

優先順位: 中

このレポートは、1 日あたりのクロールされたページ数、1 日にダウンロードされるキロバイト(KB)数、そして、ページのダウンロード時間 (ミリ秒)を報告している。偶然にも、ページのダウンロード時間を伝えるレポートが新たにグーグルアナリティクスに導入されている。個人的には、アナリティクスのレポートの方が遥かに質は高いと思う。しかし、このタイプのレポートは、全体的に有効だと言えるだろう。レポートを確認する際は、次のように考えてもらいたい:

- クロールされるページが多ければ多いほど良い(グーグルがコンテンツに興味を示し、チェックしている)

- ダウンロードされるページが多ければ多いほど良い(無視しても良い領域でグーグルが時間を無駄に費やす問題が発生していない場合)

- ダウンロードに費やす時間が短ければ短いほど好ましい。ご存知のようにページスピードはSEOの要素である。しかし、特定のメディアのダウンロードに時間がかかる可能性もある。

注記: 上述した原則は、全てのウェブサイトに当てはまるわけではない。あくまでも一般的な目安である。

ウェブマスターツール – クロールの統計情報

ブロックされたURL

優先順位: 中/高

このレポートでは、robots.txtによってブロックされたURLを確認することが出来る。一部のケースでは、ブロックされるべきではないサイトの領域が表示されることもある。このケースに該当する場合は、ブロックを解除する必要がある。

ウェブマスターツール – ブロックされたURL

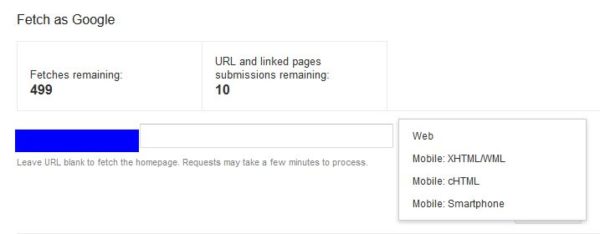

Fetch As Google

優先順位: 高

Fetch as Googleは、グーグルのようにウェブサイトのページを取得することが出来るツールである。ページがアクセス可能かどうかを調べたい場合、このツールは大いにプラスに働く。大規模なサイトの場合、様々な取り組みが行われており、このシンプルなツールが頼りになることがある。直接的な答えを得られるからだ。当該のページをグーグルが取得することがどうかが分かる。

また、このツールには、グーグルボット-モバイルとして、ページをフェッチするオプションも用意されている。モバイル向けの最適化の異なる形式に対して、必要な要素が存在するため、このオプションは大いに役に立つ可能性がある。

ウェブマスターツール – Fetch as Google

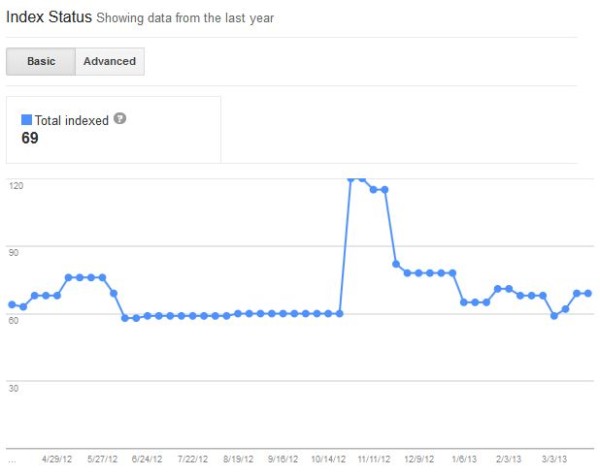

インデックスステータス

優先順位: 中

インデックスステータスのレポートは、グーグルがウェブサイトで見つけることが出来るURLから、何本のURLがインデックスされているのかを報告する。

このレポートを利用することが可能な用途の例を一つ紹介しよう: サイトマップに300本のURLを抱えていると仮定する。この300本のURLは、インデックスしてもらいたいURLであり、また、恐らく、サイト上に存在することを把握しているURLだと考えられる。しかし、インデックスレポートは、20,000本のURLから、3,000本のURLをインデックスしていると指摘している。

このような不一致が意味することは、サイトが、カノニカルURLや重複するコンテンツの問題を抱えているか、または、ただ単にウェブマスターがサイトでの取り組みをよく分かっていないかのいずれかである。

ウェブマスターツール – インデックスステータス

マルウェア

優先順位: 高

フォーラムやコメントに誰かがコードを挿入した場合、問題が発生する。グーグルはこの問題に気づき、マルウェアだと判断する。すると、誰かがこのサイトに訪問すると、ユーザーにとって安全ではない旨を説明するメッセージが表示される可能性がある。そのため、マルウェアのレポートを確認する必要がある。

ウェブマスターツール – マルウェア

検索クエリ

優先順位: 中

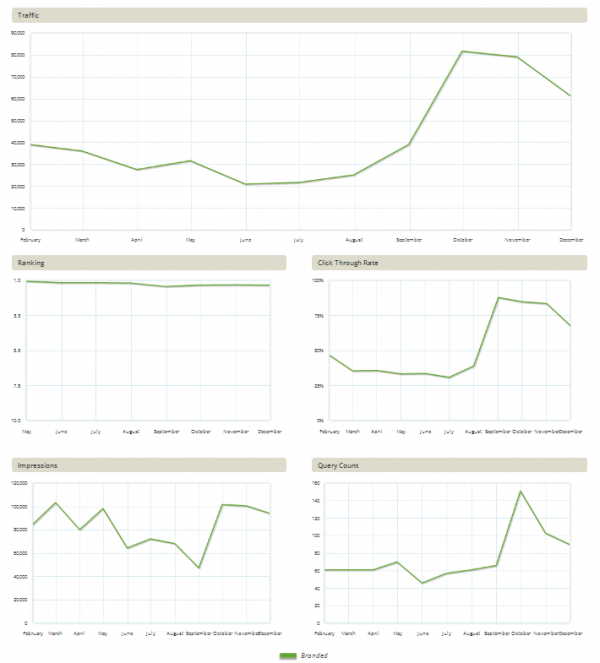

検索クエリのタブでは、グーグルのインデックスでURLが得ているインプレッションとクリックの回数の目安を知ることが出来る。このツールは、上位のクエリを表示し、また、携帯電話、画像、動画、ウェブ、場所、そして、トラフィックに分類されている。

このレポートを確認することで、ランキングとトラフィックの目安を得られる。しかし、信頼性に欠けると言わざるを得ない。このレポートで提供される情報は目安に過ぎない。チャートに大きな変動があるなら、調べてみる価値はある。

ウェブマスターツール – 検索クエリ

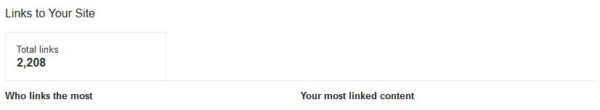

サイトへのリンク

優先順位: 中/高

ご存知のように、劣悪なウェブサイトから張られたリンクはサイトに害をもたらす可能性がある。一つのキーワードに対してアンカーテキストが多過ぎる(日本語)と、アルゴリズム関連のペナルティを科される可能性がある。ウェブマスターツールのリンクレポートでは、誰がリンクを張ったのかが分かる。また、上位のアンカーテキストの情報も得ることが出来る。上位のアンカーテキスト内に表示されている用語で上位にランクインしていないなら、リンクの一部を削除しておくことを薦める。

この項目では、ウェブサイトに向かうリンクを全てエクスポートし、見直すことが出来る。審査請求を行う前にリンクを無効化する必要がある場合、この項目を時間を割いてよく調べる必要がある。とりわけ、私はこのレポートを見る時、サイトに大量のリンクを向けている質の低いサイトを確認するようにしている。通常、海外の質の低いサイトからのリンクは、グーグルに注意を促す。リンクを評価する方法を延々と語ることも出来るが、このツールが存在する点をここでは知ってもらいたい。

ウェブマスターツール – サイトへのリンク

内部リンク

優先順位: 中

良質な内部リンクは、グーグルがページを発見する上で大いに役に立つ。また、適切に実施すれば、ランキングアップにもつながる。ページに対するリンク1本1本が、それが、内部リンクであれ、外部リンクであれ、グーグルで上位にランクインするための票の役目を持っている。そのため、内部リンクがもたらす価値についてよく考えてもらいたい。

ページに向けられているリンクが多ければ多いほど、グーグルの目には、ページのオーソリティが高く映る。従って、検索にとって特に重要なページに対して、頻繁にリンクを張るように心掛けよう。しかし、その他の取り組みにも共通することだが、過剰にリンクを張る行為は避けるべきである。妥当な範囲内で内部リンクを行い、その他のページの内部リンクの比率に合わせるように努力しよう。

ウェブマスターツール – 内部リンク

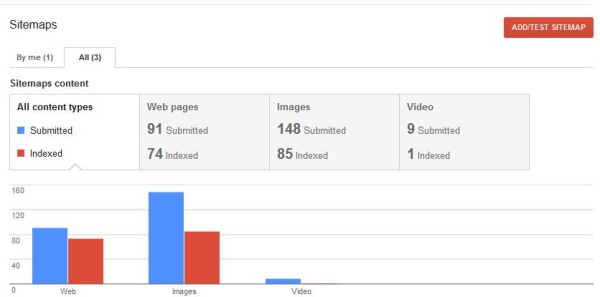

サイトマップ

優先順位: 中/高

サイトマップに関しては、少なくともウェブマスターツールには投稿しておくべきである。これは、基本的なXMLのサイトマップであることが多い。また、画像のサイトマップ、ニュースのサイトマップ、動画のサイトマップ、または、モバイルのサイトマップもまた投稿することが出来る。

いずれにせよ、この項目をチェックして、サイトマップが投稿されているかどうか、エラーが生じているかどうかを確認しよう。サイトマップは多ければ多いほど良い – サイトマップを支えるコンテンツが存在することが条件。

ウェブマスターツール – サイトマップ

URLの削除

優先順位: 中/高

グーグルはURLの削除ツールを用意しており、ウェブマスターは、URLの削除を依頼することが出来る。当然、ウェブサイトを持っていることが条件である。残念ながら、このツールの効果を理解することなく利用している人がいるようだ。以前、ある会社の従業員がこのツールを使って、大規模なウェブサイトのホームページを削除していたことがあった。私がこのリクエストの存在に気づくまで、誰もトラフィックが激減した理由を理解することが出来なかった。

また、先日、あるディベロッパーがこのツールを使って、50本以上のURLを削除していた。全てのURLのページは割と上位にランクインしており、301リダイレクト、または、単純に修正して残しておくべきであった。このツールは強力であり、誰にでも利用させて良いわけではない。

ウェブマスターツール – URLの削除ツール

HTMLの改善

優先順位: 中

このレポートはとても価値が高い。グーグルの視点で、ウェブサイト上の重複したコンテンツの形態を見ることが出来る。重複するコンテンツのタイトルタグのリンクをクリックすると、同じタイトルを利用しているページのリストが表示される。これは、カノニカルURLやサイト上のその他の重複するタイトルやディスクリプションを見つける上で大いに役立つ。

ウェブマスターツール – HTMLの改善 Improvements Webmaster Tools

コンテンツ キーワード

優先順位: 中

コンテンツ キーワードレポートは、ウェブサイトで特に多く利用されているキーワードを報告する。この内容はSEOに影響をもたらす。パンダアップデート以来、ウェブサイトに関連するテーマを持つことが重要になった。

論理的なテーマを持つキーワードのグループを携えることで、グーグルで上位にランク付けされる可能性は高まる。難易度の高いキーワードに焦点を絞っているなら、コンテンツ キーワードレポートに反映されているべきである。

ウェブマスターツール – コンテンツ キーワードレポート

構造化データ

優先順位: 中

構造化データレポートは、グーグルがサイトで見つけた構造化データの数、そして、構造化データが用いられているページの本数を報告する。また、サイトで利用されている構造化データのタイプの数も伝える。構造化データは、競合サイトから差別化する上で効果があり、今後、SEOにおいて大きな役割を担うようになるだろう。このタブを見れば、サイト上の構造化データを明確に理解することが出来る。

ウェブマスターツール – 構造化データ

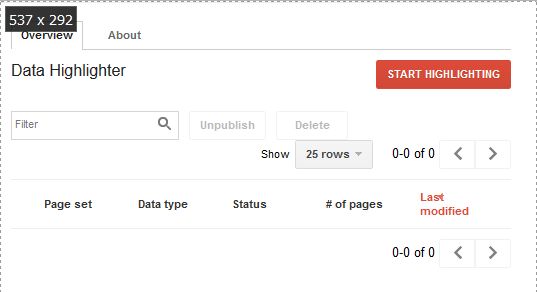

データハイライター

優先順位: 中

データハイライターは、コーディングに自信がないウェブマスターにとって貴重なツールである。このツールを使うと、サイトに変更を実際に加えることなく、構造化データをウェブサイトに適用することが可能になる。現在、利用することが出来るのは、イベントの構造化データのみだが、今後、グーグルが構造化データを加えていく可能性はある。

ウェブマスターツール – データハイライター

その他のリソース

優先順位: 中

その他のリソースには、3つのツールが用意されている。一つずつ簡単に紹介していく。

これは、グーグルが正確に構造化マークアップを解釈し、表示していることを確認するためのツールである。

グーグルが提供するこの無料のローカルプラットフォームはグーグル+になったものの、ここではグーグルプレイスと表記されている。アップデートしてもらいたいものだ。

これは製品データをアップデートするための場所である。先日のアドワーズの統合により、このアカウントをアドワーズに接続して、グーグルショッピングで良好なパフォーマンスを実現することが重要になった。この点に関して詳しく知りたい方は、この分かりやすいスターターガイドを参考にしよう。

作成者の統計情報

優先順位: 中

このページには、作成者(オーサー)のプロフィールがウェブサイトに適切に接続されている場合、スタッツが表示される。新しいウェブサイトにrel=”author”を設定する際に私はこのツールを多用した。全て適切に設定され、準備が整っていることを確認するためだ。

ウェブマスターツール – 作成者の統計情報

カスタム検索

優先順位: 低

グーグルの検索バーをウェブサイトに加えることが出来る点を知っていただろうか?このタブでは、カスタム検索に関する情報を得られる。 私はカスタム検索を複数のサイトに設定したことがあるが、全て問題なく動いている。このツールには、サイトの検索レポートを有効にする利点がある。

ウェブマスターツール – カスタム検索

インスタントプレビュー

優先順位: 低

このツールは、Fetch as Googleにとても良く似ている。ウェブサイトを取得し、その後、検索のオンデマンド インスタント プレビュー、検索のプリレンダリング インスタント プレビュー、そして、モバイル検索のインスタント プレビューを見ることが出来る。

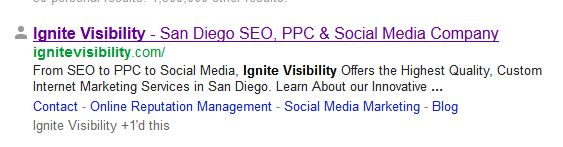

このセクションでは、取得中のエラーも表示される。ここでは、Ignite Visibilityを例として用いている。ご覧のように幾つか問題は発生していたが、デザイン変更を終えようとしているところであり、今後対処する予定である。下の方には9つのエラーが発生した旨が表示されている。

ウェブマスターツール – インスタントプレビュー

サイトのパフォーマンス

優先順位: 一番低い

グーグルは、サイトのパフォーマンスのサポートを終了している。グーグルはこのセクションで次の情報を提供している。

サイトパフォーマンスはWebmaster Labsの機能でしたが、現在はサポートを終了しています。

サイト パフォーマンスを把握し、改善するには、以下のサービスをお試しください:

- グーグル アナリティクスのサイトの速度では、ユーザーのページ読み込み時間が測定され、他のユーザー設定速度も測定できます。

- ページスピードインサイトではページのコンテンツが分析され、パフォーマンス改善のための提案を見ることができます。

ちなみに、私はページスピードインサイトを愛用している。

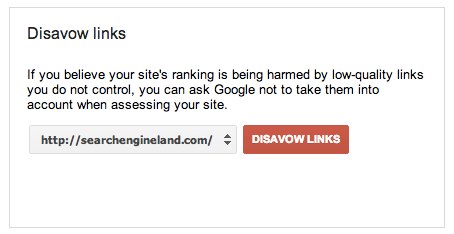

リンクの否認ツール

優先順位: 議論の余地あり

リンクの否認ツールは、役立つこともあれば、害をもたらすこともある。グーグルでウェブスパム対策を統括するマット・カッツ氏は、強力なツールだと強調している。しかし、良質なリンクをブロックしてしまうと、ランキングが落ちる可能性はある。質の低いリンクを否認すると、SEOにプラスの影響を与えると見られている。

従って、このツールを利用する際は、リンクの質を理解しておく必要がある。大半のSEOのエキスパートは、質の低いリンクを分析するための基準を用意している。

このガイドでは多くのポイントを取り上げたものの、他にもこのツールを利用する用途は数多くあり、また、このツールとレポートから得られるメリットも他にも多く存在する。まずは、始めることが最初のステップである。サーチエンジンランドには、グーグルウェブマスターツールの最新情報、そして、ウェブマスターツールを特集したニュースが豊富に揃っており、情報源としても利用してもらいたい。

この記事は、Search Engine Landに掲載された「The SEO Guide To Getting Started With Google Webmaster Tools」を翻訳した内容です。

先日、

先日、

2006年に立ち上げられたHubPages.comは、ユーザーが作成するコンテンツを配信するサイトであり、作者は記事の投稿(同サイトはhubと読んでいる)、質疑応答、そして、フォーラムでのコミュニケーションを実施することが出来る。このサイトには

2006年に立ち上げられたHubPages.comは、ユーザーが作成するコンテンツを配信するサイトであり、作者は記事の投稿(同サイトはhubと読んでいる)、質疑応答、そして、フォーラムでのコミュニケーションを実施することが出来る。このサイトには

Mahaloは2007年に人間が管理する検索エンジンとしてスタートし、ユーザーが、ウェブの人気の高い検索用語の多くにマッチするコンテンツを作成するサイトを謳っていた。Mahaloは、アンサーセクション(ヤフー!アンサーズと同様のコーナー)を2008年に加え、最終的に、リンクの提供と“検索結果”から、出来るだけ多くのコンテンツを作成するサイトに方針を転換した(Mahaloの元従業員が綴った、「

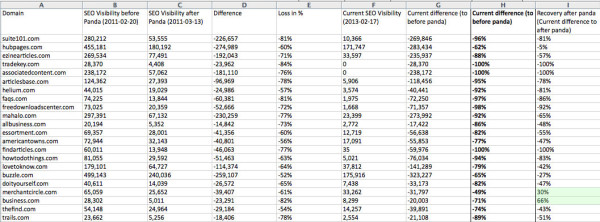

Mahaloは2007年に人間が管理する検索エンジンとしてスタートし、ユーザーが、ウェブの人気の高い検索用語の多くにマッチするコンテンツを作成するサイトを謳っていた。Mahaloは、アンサーセクション(ヤフー!アンサーズと同様のコーナー)を2008年に加え、最終的に、リンクの提供と“検索結果”から、出来るだけ多くのコンテンツを作成するサイトに方針を転換した(Mahaloの元従業員が綴った、「 上の表には、ユーザーが作成した記事をベースとするサイト、Suite101.comのビジビリティの推移も描かれている。サーチメトリクスのデータによると、Suite101.comのSEOのビジビリティは、パンダアップデートが行われてから1週間で81%減少し、その後も減少を続けていった。現在のビジビリティは、パンダが行われる前のビジビリティと比べ、96%低い数値になっている。。

上の表には、ユーザーが作成した記事をベースとするサイト、Suite101.comのビジビリティの推移も描かれている。サーチメトリクスのデータによると、Suite101.comのSEOのビジビリティは、パンダアップデートが行われてから1週間で81%減少し、その後も減少を続けていった。現在のビジビリティは、パンダが行われる前のビジビリティと比べ、96%低い数値になっている。。

コンテンツベースのウェブサイトとして長い歴史を持つAbout.comは、パンダの負け組として、

コンテンツベースのウェブサイトとして長い歴史を持つAbout.comは、パンダの負け組として、 これは記事を検索するエンジンであり、以前投稿された無数の記事(私の記憶が正しければ、その多くは新聞や雑誌の記事)にアクセスするためのサービスであった。無料で閲覧することが出来る記事もあれば、有料制を敷いている記事もあった。私自身、2008年に出版したロックバンドに関する本を綴っていた時、FindArticlesを何度も利用した。

これは記事を検索するエンジンであり、以前投稿された無数の記事(私の記憶が正しければ、その多くは新聞や雑誌の記事)にアクセスするためのサービスであった。無料で閲覧することが出来る記事もあれば、有料制を敷いている記事もあった。私自身、2008年に出版したロックバンドに関する本を綴っていた時、FindArticlesを何度も利用した。

先日、フェイスブックの

先日、フェイスブックの