Nvidiaが今日(米国時間9/1)、データセンターにおける機械学習と推論のための新しいGPUを発表した。そのTesla T4 GPUs(TはNvidiaの新しいアーキテクチャTuringを指す)は、クラウドコンピューティングのメジャーなプロバイダーのほとんどが現在提供しているP4 GPUsの後継機種だ。Nvidiaによると、GoogleはT4 GPUsをクラウドプラットホームで採用する最初の企業のひとつだ。

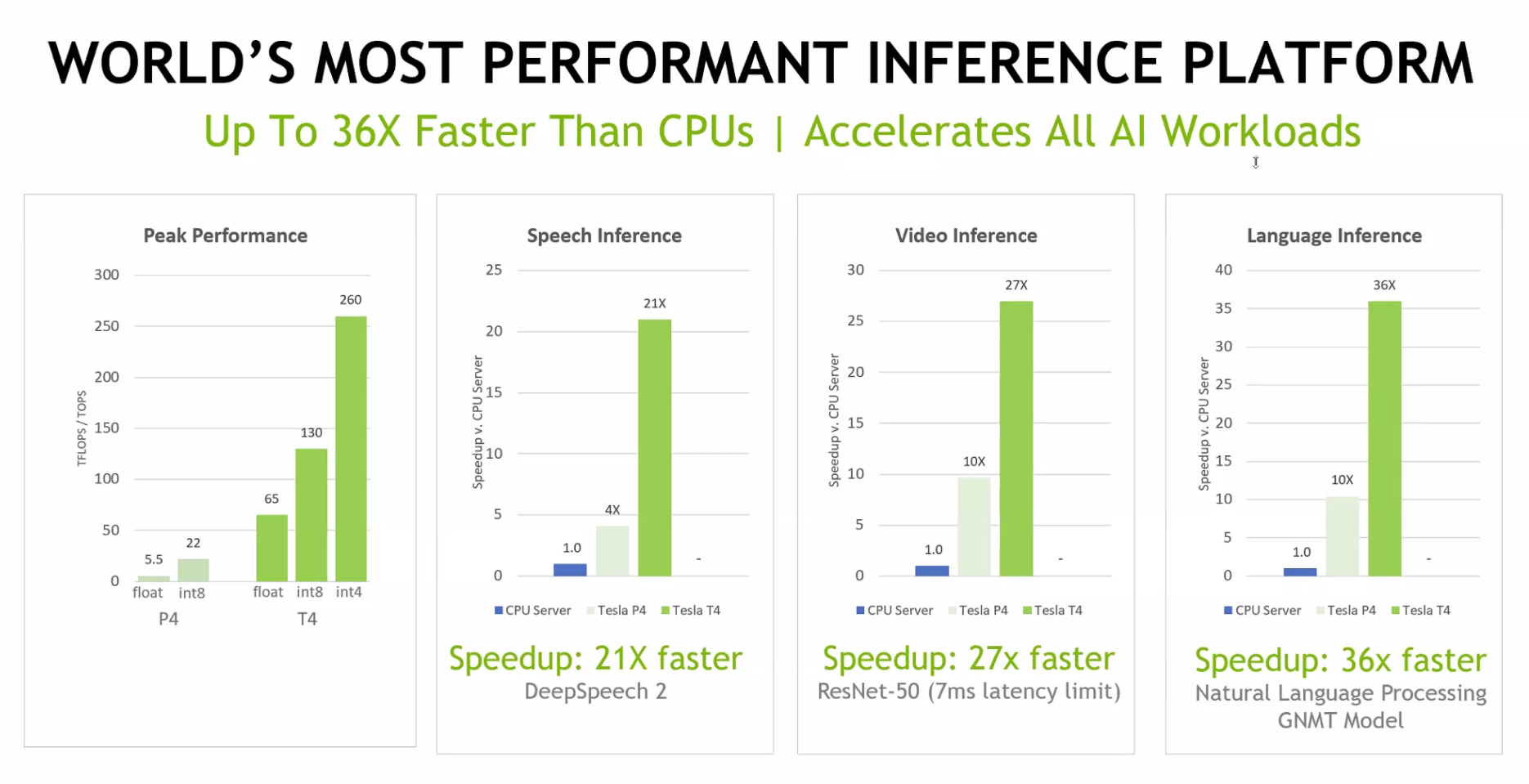

Nvidiaによると、T4はP4よりも相当に速い。たとえば言語の推論では、T4はCPUを使うよりも34倍速く、P4より3.5倍速い。T4のピーク時性能は4ビットの整数演算で260TOPS、浮動小数点演算で65TOPSだ。T4は、標準的な75ワットのLow Profile PCI-eカードに載っている。〔関連記事〕

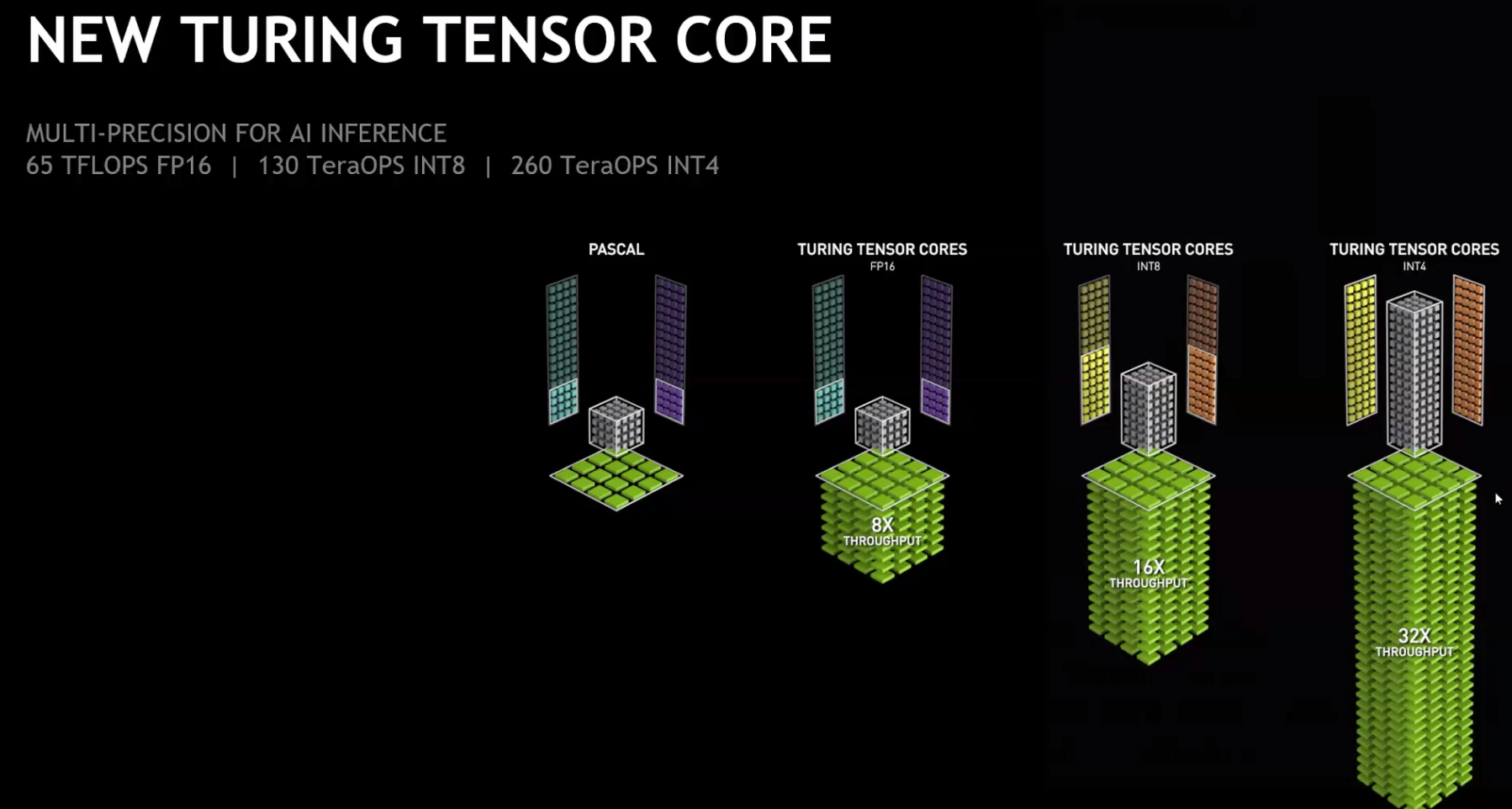

しかしもっとも重要なのは、Nvidiaがこれらのチップを、AIの推論専用に設計したことだ。NvidiaのVPで同社のTeslaデータセンター事業部のGM Ian Buckはこう語る: “Tesla T4が推論用としてこれほど効率的なGPUであるのは、Turingアーキテクチャの新しいテンソル・コアのせいだ。CEOのJensen Huangがすでに述べたように、そのTensorコアはゲームやレンダリングやAIにも有効に利用できるが、設計の前提は推論だ。トータルでこのチップには、320のTuting Tensorコアと2560のCUDAコアがある”。

Nvidiaは今回、新しいチップのほかに、同社のソフトウェアTensorRTの、ディープラーニングのモデルを最適化するアップデートをローンチした。この新しいバージョンには、TensorRT推論サーバーも含まれており、それはデータセンターの推論のための完全にコンテナ化されたマイクロサービスとして、既存のKubernetesインフラストラクチャにシームレスに接続する。