英紙の調査によって暴かれた、児童性的虐待やテロリストのプロパガンダに関連したコンテンツの拡散により、再びFacebookは、問題のあるコンテンツへの対処について厳しい批判にさらされることとなった。

UGC(ユーザー・ジェネレイテッド・コンテンツ)をアルゴリズムで管理するというFacebookの仕組みは、確かに違法コンテンツの拡散に繋がっているようだ。

昨日のThe Timesの報道では、同紙の記者が仮のアカウントを作成したところ、すぐに不快で違法性の高いコンテンツを発見できたと、Facebookが糾弾されている。発見されたコンテンツの中には、小児性愛を想起させるイラストや子どもが暴力をふるわれている様子をおさめた映像、ISISサポーターが作成した断首映像やエジプトの教会でおきたテロ事件を称賛するコメントのように、テロリストのプロパガンダを支持するものが含まれていた。

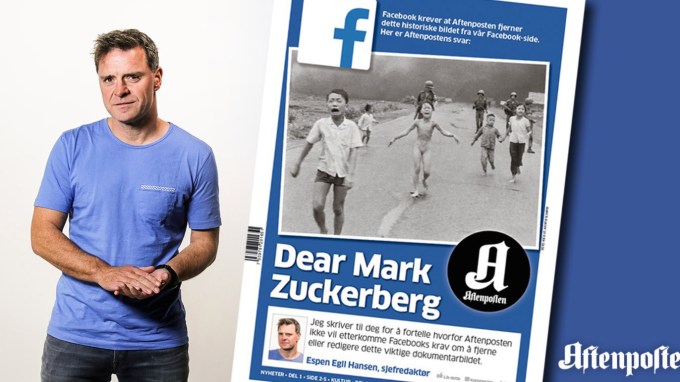

しかもこれらのコンテンツをFacebookに通報した際にも、ほとんどのケースで、画像や動画が同プラットフォームの規約に違反していないという返答をFacebookから受け取ったとThe Timesは報じている(しかしその後、The Timesが身元を明かして再度Facebookにコンタクトしたところ、最終的にモデレーターがそのままにしていた小児性愛を想起させるイラストが削除されたとのこと)。

その後、The Timesが通報したコンテンツは全て削除されたとFacebookは話している。

まさにこのような問題を解決するために、現在ドイツで議論が進められている法案では、苦情を受け付けた後に違法コンテンツを早急に削除しないソーシャルメディア・プラットフォームに対して、巨額の罰金が課されることになっている。ドイツ政府も今月に入ってからこの法案に対する支持を表明しており、今期中に同法案が可決される可能性もある。

そしてヨーロッパの他の国も、ドイツに追従する可能性が高い。イギリスを例にとれば、先月ロンドンで起きたテロ事件を受けて、同国政府は再度ソーシャルメディアとテロリズムに対する警戒を強めており、内務大臣はFacebookを含むソーシャルメディア各社に対して、テロ組織のプロパガンダを自動で検出・削除するツールの開発を進めるよう圧力をかけている。

The Timesの調査にあたり、同誌の記者はFacebook上で30代のITプロフェッショナルに扮したプロフィールを作成した上で、100人以上のISISサポーターと友だちになり、児童の”わいせつもしくは性的な”画像を奨励するグループに参加した。「それからすぐに、児童性愛に関連した何十枚といういかがわしい画像を、ジーハーディストが投稿している様子を目にした」と同記者は記している。

The Timesが、発見されたコンテンツを勅選弁護士のJulian Knowlesに見せたところ、同コンテンツはイギリスのわいせつ罪にあたるか、テロ行為を直接もしくは間接的に奨励する言論や出版を禁じているTerrorism Act 2006に触れる可能性が高いという返答を受け取ったされている。

「もしも誰かが違法な画像をFacebookに通報し、シニア・モデレーターが画像を削除しないと決定した場合、Facebookは違法画像の出版および流通を奨励またはほう助したとみなされ、有罪となる可能性があります」とKnowlesはThe Timesに語っている。

Facebookは先月にも、コンテンツ・モデレーションの仕組みについて同様の批判を浴びていた。児童のわいせつ画像に関する通報に対し、Facebookがどのような反応を示すのかBBCが調査したところ、Facebookは通報を受けた画像の大半を放置していたのだ。実は昨年にも、非公開のFacebookグループ内で、小児性愛者が児童のわいせつ画像をやりとりしているのをBBCが報じていた。

FacebookはThe Timesの報道に関する広報担当者へのインタビューには応じなかったものの、グローバルオペレーション担当VPのJustin Osofskyは、TechCrunchに対するメールでの声明の中に「私たちはThe Timesによる通報をありがたく思っています。問題の画像はFacebookのポリシーに違反していたため全て削除されました。このような事態が発生してしまい、大変遺憾に思っております。依然として改善の余地は残されていますが、今後もFacebookに対して人々が当然抱いているであろう、高い期待に応えるため、努力を重ねていきます」と記している。

Facebookは世界中のオフィス(ヨーロッパのコンテンツはダブリンオフィスの管轄)で、”何千人”という数のモデレーターを雇い、24時間体制で問題のあるコンテンツへの対応にあたっていると言う。しかし20億近いMAU(厳密には2016年末時点で18.6億MAU)を記録しているFacebookのユーザーが、常に無数のコンテンツをアップロードしていることを考えると、モデレーターの数は大海の一滴でしかない。

人間の手で対処するとなると、現状のモデレーターの数では到底追いつかず、人件費を考慮するとFacebookがモデレーターの数を急激に増やすということも考えづらい(Facebook全体の従業員数でさえ1万7000人強しかいない)。

FacebookはMicrosoftのPhotoDNA技術を導入し、アップロードされた画像全てを予め準備された幼児虐待の画像と照らし合わせているが、問題につながる可能性のあるコンテンツを全て見つけるというのは、エンジニアリング力ではなかなか解決しづらい課題だ。というのも、問題のあるコンテンツを全て検出するには、文脈や各コンテンツの内容に応じて個別の判断が必要となるだけでなく、世界各国の法体制や文化的な考え方も考慮しなければいけない可能性があり、作業の自動化が極めて困難なのだ。

CEOのマーク・ザッカーバーグは、この問題に関して最近発表したコメントの中で、「ユーザーの安全を守るための素晴らしい手段のひとつとして」Facebookが「プラットフォーム上で何が起きているかをより速く、より正確に理解できるようなAIを開発中」だと述べている。

さらに彼は、Facebookには「もっとやるべきことがある」と認めたものの、コンテンツ・モデレーションの仕組みを改善するにはまだ「数年」かかると記している。

また、「現在私たちは、テロ組織の採用活動にFacebookを利用しようとしている人を早急に締め出すために、テロ行為に関する報道と実際のプロパガンダを区別できるようなAIの使い方を模索しています。問題を解決するには、報道内容を読んで理解できるようなAIを開発しなければならず、これは技術的に難しいことです。しかし、Facebookは世界中のテロ行為と戦うために、そのようなAIの開発に取り組んでいかなければいけません」という言葉に続き、彼は「個人の安全と自由を守る」という考えが、Facebookコミュニティーの哲学のコアにあることを強調していた(同時にこの考え方が背景となって、Facebookは言論の自由と不快な発言の間でうまくバランスをとることを余儀なくされている)。

究極的には、違法なコンテンツが最低ラインのモデレーションのハードルを上げ、Facebookのモデレーションプロセスを大きく変化させる原動力となっているのかもしれない(たとえ、その国/地域では何が違法な発言で、何が単なる悪口や不快な発言と解釈されるかは、別途議論を要するとしてもだ)。

ただし否定できない事実として、Facebook自身が、大手メディアによって発見されたコンテンツは規約に違反しているため、プラットフォーム上から削除されなければいけないと認めている。これは同時に、それではなぜ最初に通報があったときにそのようなコンテンツを削除しなかったのかという疑問にも繋がってくる。その原因は、モデレーションシステムの障害なのかもしれないし、企業全体の偽善なのかもしれない。

The Timesは、今回の調査結果をロンドン警視庁と国家犯罪対策庁に提出したとしているが、テロ行為や小児性愛関連のコンテンツを削除しなかったことで、Facebookが今後イギリスで刑事告発されるかどうかはまだわかっていない。

さらに同紙は、Facebookのアルゴリズムが問題のあるコンテンツの拡散を促しているということについても、同社を非難している。これはユーザーが特定のグループに加入したり、特定の人と友だちになった際に、問題のあるコンテンツが自動的に表示されるようになっている仕組みのことを指している。

この点に関しては、「おすすめのページ」機能のように、共有の友だちや職歴、学歴、加入しているグループ、インポートされたコンタクト情報や、表には現れないその他のさまざまな要因をもとに、各ユーザーが興味を持つ可能性の高いコンテンツが自動的に表示される機能がFacebookには確かに存在する。

ニュースフィードの機械学習アルゴリズムが偽ニュースを広めていると非難されたときと同じように、ユーザー同士やユーザーが興味を持っている事柄を繋ぎ合わせようとするアルゴリズムの動き自体が、犯罪行為を助長しているのではないかと疑われ始めているようだ。

[原文へ]

(翻訳:Atsushi Yukutake/ Twitter)