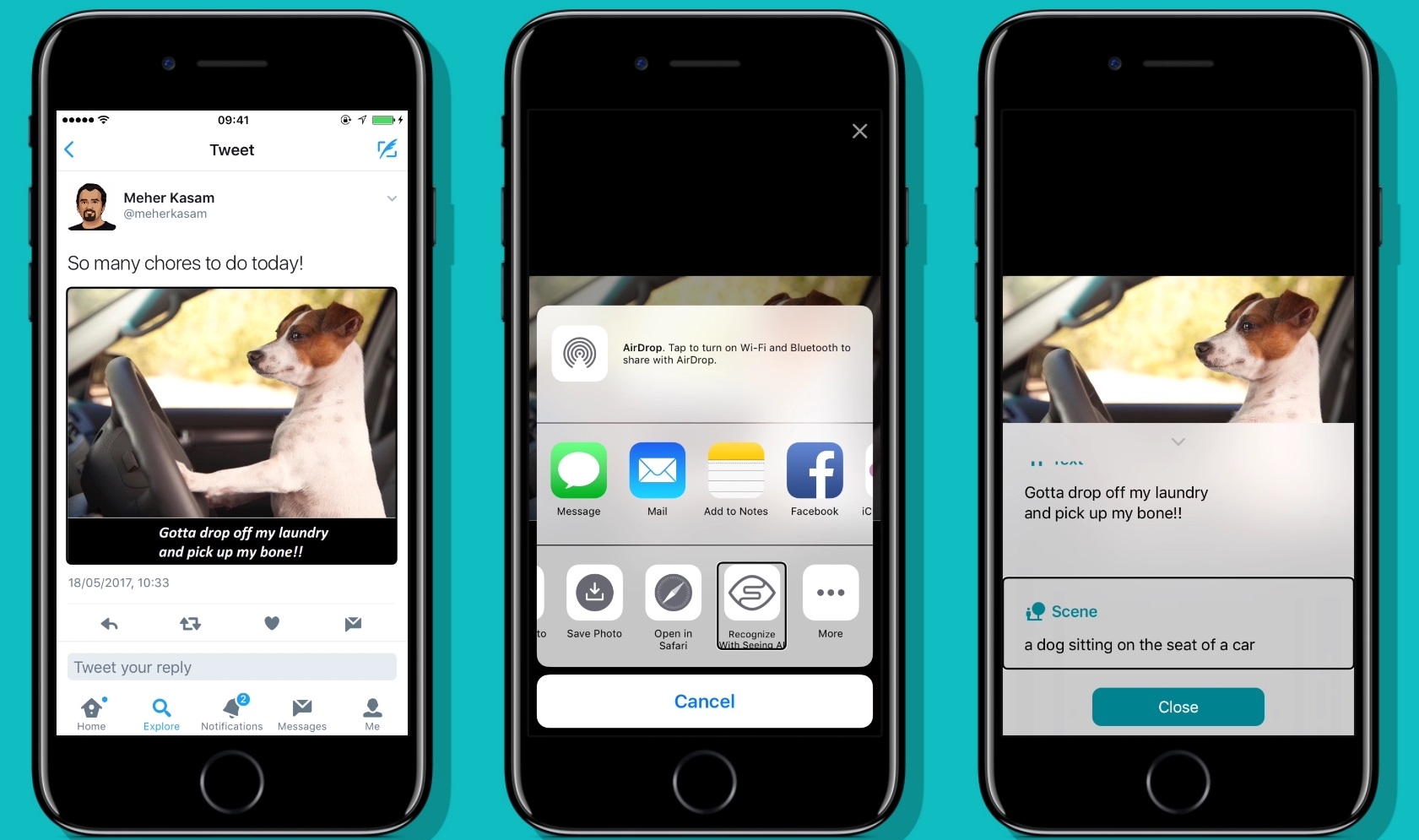

Microsoft(マイクロソフト)のSeeing AIは、目の不自由な人が視覚データをオーディオに変換できるアプリだが、今回、便利な機能がひとつ増えた。ユーザーが、写真の中のオブジェクトや人間をタッチして調べることができるのだ。

それはもちろん、機械学習のオブジェクトや情景の認識機能を利用している。写真を撮ったり、ビューワーの中で開いたりしたら、その上のどこでもいいからタップするだけだ。

「この新しい機能でユーザーは、タッチ画面に表示されている画像を指でタップして、そこに写っているものやそれらの空間的関係の説明を聞くことができる」と、Seeing AIの主席開発者Saqib Shaikh氏がブログ記事でそう述べている。「このアプリは、人の肉体的な外見や彼らの気分も説明できる」。

顔認識機能もあるので、友だちの写真を撮ったら誰がどこで何をしているのか聞くことができる。その写真の中に犬がいることもわかる(こいつは重要だ!)。これは、下図に示すように、全画面的にはすでに実現していた。

でも今度からは、ユーザーがあちこちをタップして、どんなオブジェクトがどこにあるか知ることができる。それは新奇な機能というより、写真を見る際には本来とても重要なことだ。説明書にはないが、もっと細かいこと、たとえば前景に花があるとか、背景に映画のポスターがある、なども分かる。

しかもこのアプリはiPadをサポートするようになったので、アップルのタブレットがいろんなメディアや対話の主要なインタフェイスとして役に立つだろう。今回のアップデートでは、このアプリから好きなものを注文できるようになった。

Seeing AIは無料で、iOSデバイス用にここからダウンロードできる。

画像クレジット: Microsoft