今回は、毎年恒例、SEO計画書のパート 2(パート 1はこちら(日本語))をお届けする。まずは、SEO計画書のパート 2を作る上で最高のアイデア(SEOを成功に導く要素の周期表)を与えてくれたことを、ダニー・サリバンおよびサーチエンジンランドのスタッフに感謝したい。

今回は、毎年恒例、SEO計画書のパート 2(パート 1はこちら(日本語))をお届けする。まずは、SEO計画書のパート 2を作る上で最高のアイデア(SEOを成功に導く要素の周期表)を与えてくれたことを、ダニー・サリバンおよびサーチエンジンランドのスタッフに感謝したい。

パート 2では、コンテンツ、HTML、そして、アーキテクチャを含む、オンページの要素を取り上げていく。間違いなく、思考回路を刺激するはずだ。また、行動に移すことが可能な提案も行う予定である。これは、手順を追ってSEOを説明するガイドではなく、形式には全くこだわっていない。そのため、SEOキャンペーンに取り掛かる前に、自分でリサーチを行うか、エキスパートに相談することを薦める。

コンテンツ: 品質

2013年は、ワード数や奥深いコンテンツ等、品質に関する議論が多く行われた。

パンダアップデートが行われると、短い「薄っぺらい」記事を作る行為に終止符が打たれたと誰もが感じた。しかし、新鮮なコンテンツを投稿することに苦労していたウェブサイト、特に企業のウェブサイトは、この行為を継続している。最近、ある企業が、10点の必読書を紹介するブログの記事を投稿していた。この記事は、本のサムネイルのイメージとタイトルを挙げ、オンライン書店にリンクを張っていただけであった。このような安っぽい記事は、パンダによるペナルティーの格好のターゲットであり、何度も投稿するのは危険過ぎる。

反対に、推奨されているのは、1500ワード以上で構成される詳細なコンテンツ(ページ & 記事)である。このタイプのコンテンツを持つウェブサイトは成功しており、多数の短く、「安っぽい」記事を作成するための時間を、少数の長く、より有意義なコンテンツを作成するために利用する方が無難である。いずれにせよ、文法、および、誤字脱字に注意して、まともな文章を綴る必要がある。意見を出すだけでなく、思慮に富んだ見解、または、リサーチして発見したデータで裏付けを行ってもらいたい。肉付けをする必要があるのだ。私個人は、450ワード以下のコンテンツに関しては、その他のコンテンツと組み合わせるか、あるいは、書く価値がないコンテンツと位置づけるようにしている。

以前、Eコマースのデスクリプションには、250ワードが最適だと考えていた。しかし、現在は、ワード数よりも、優れたリストを作成し、メリットと機能のマッチングさせることに力を入れている。

コンテンツ: キーワード

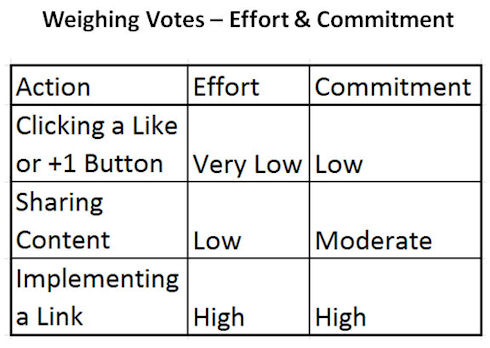

キーワードリサーチは、今後も姿を消すことはなく、今も尚オンサイトSEOの基盤として健在である。ハミングバードアップデートが導入された後、エンティティの役割を取り上げるようになり、結果ページでキーワードに代わり、トピックが表示されるようになった。グーグルは、類義語の検知とコンセプトの分類において飛躍的に発展を遂げている — ロングテールキーワードの終焉を宣言する専門家もいる(しかし、SEO業界のあらゆる終焉宣言に共通することだが、この主張もまた大げさである)。

各ページを、トピックとして、独立させることが出来るようにしてもらいたい。別のキーワードに対する最適化を実施するために、同じトピックに対して、複数のページを作成する行為は慎むべきである。そうではなく、単一の、良くまとめられた、言及に値するトピックページにこだわり、このページを複数のキーワードに対して最適化するべきである。この点もまた、長文形式のコンテンツを用いる理由の一つに数えられる。

コンテンツ: エンゲージメント

ビジターが時間を割いてコンテンツを読んでいるか、もしくは、直帰するかが、エンゲージメント(参加を介した交流)を左右する。ここでも、やはり、有益なコンテンツが鍵を握る。何においても、最終的に品質が運命を決める。オーディエンス、または、ターゲットのユーザー層が読みたいと思うコンテンツを提供しているのか、編集カレンダーを埋めるためだけにコンテンツを配信しているのか、もしくは、最近、記事の投稿が滞っていたため、罪悪感からコンテンツを抵抗しているのか、どのタイプに当てはまるのか考えてもらいたい。

また、エンゲージメントは、テキストのコンテンツだけに限定されるわけではない。ウェブページのデザインも大事である。エンゲージメントを活性化するだけでなく、見た目も重要である。読みやすさには、ページのレイアウト、フォントの選択、文字と行間のスペース等が含まれる。さらに、ナビゲーションと他のコンテンツへ向かうリンクの表示にも注意してもらいたい。このような要素は、直帰率や滞在時間等のビジターエンゲージメントのスタッツに大きな影響を与える。

コンテンツ: 広告

広告を配置するレイアウトにも気を配る必要がある。検索エンジンは、広告を掲載することに対して、罰を与えるわけではない。そこまで厳しくはない。検索エンジンがペナルティーを与えるのは、過剰な量の広告を掲載する行為、または、不適切な位置に広告を掲載する行為である。

現行の検索エンジンのポリシーが強化される以外は、この領域において、2014年に大きな変化が起きることはないだろう。 ただし、広告の表示に加え、テキストリンク広告に関して、特に注意が必要である。コンテンツに適切である点、または、コンテンツにマッチしている点、nofollow化している点を確認してもらいたい。今でもコンテンツ内に自動フレーズリンク広告を利用しているなら、削除することを強く薦める。インタースティシャル広告やポップアップ広告を利用しているなら、検索エンジンによるページのクロールを妨げないように気をつける必要がある。

コンテンツ: 新鮮さ

私は新鮮なコンテンツを大々的に支持している — と言っても、人気のあるトピックに関するコンテンツを投稿するだけでなく、定期的、または、頻繁に新しいコンテンツを投稿するべきである。新しいコンテンツは、読者を集めるだけでなく、クロールの頻度と深さを改善する上でも重要である。先程、投稿カレンダーを埋めるためだけに、コンテンツを作るべきではないと指摘した。しかし、投稿カレンダーを用意していないなら、まずはこの予定表を策定し、コンテンツの作成に取り掛かる必要がある。

コンテンツを、知名度と信頼度を高めるためのツールと考えるとよい。つまり、会社、そして、製品やサービスに関する記事を投稿するだけでは、不十分である。活動範囲を広げ、– ターゲットのマーケット、そして、ターゲットのマーケットに属する消費者や企業にとっての情報源になることを目指すべきだ

この広範なアプローチにより、さらに多くのトピックが生まれ、ターゲットのマーケットが関心を持つトピックに焦点を絞ることが出来るようになる。これが、オーディエンスを増やすことが可能なコンテンツのタイプである。マーケティングファンネルの上部の層でオーディエンスを獲得する試みを行っていないなら、方針を誤っている可能性がある。当然ながら、例外はある — ただし、例外に該当する会社よりも遥かに多くのの会社が、この試みに失敗している。

HTML: タイトル & ヘッダー

現在、タイトルタグに注目が集まっている。最適化したタグとヘッダーを作成する基本的なルールは、変わっていない。検索エンジン(特にグーグル)が、より多くのタイトルタグをアルゴリズムを基に書き換えるようになると私は予想している。グーグルにタイトルタグを書き換えられているなら、試しに、HTMLをグーグルがSERPに表示するテキストと同じテキストに変えてみよう。「試しに」と言ったが、あくまでも賢明に変更するテキストを選び、パフォーマンスのスタッツの変化をチェックしてもらいたい。改善が見られたら、より広い範囲でタイトルタグを最適化する価値があるかもしれない。

エンティティの検索、そして、複数のキーワードに対する最適化に話を戻す — トピックの最適化を行う際は、タイトルタグおよびH1タグでどのキーワードを利用しているか、認識する必要がある。確実な公式を紹介したいところだが、そんなものは存在しない。類義語を検討する際は、完全に一致する検索を最も獲得しているワードとフレーズに留意し、人気の高い言葉に関しては、自分の直感に従おう。

HTML: デスクリプション

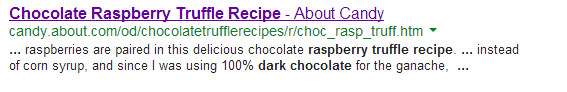

メタデスクリプションタグの最適化に関しては、特に変更は見られない。各ページに固有のデスクリプション(記述)を用意する必要がある。ランキングを変動する力はないものの、質の高い記述は、クリックスルー率を高める効果がある。

私は長さが150ワード前後になるように心掛けている。現実として、実際の長さは、文字の画素幅に左右されるものの、結果に表示された際に、全文が記されるように工夫する必要がある。

サイトリンクで表示されるページに対しては、各リンクの下に現れるデスクリプションの部分が、分かりやすく表示されるように工夫するべきである。これは、多くの企業のサイトやブランドが改善する余地のある領域である。

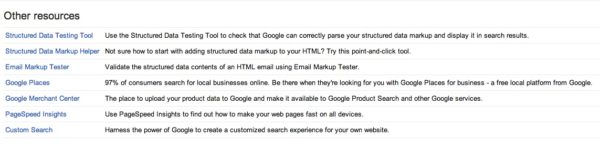

HTML: 構造化データのマークアップ

毎年のように、構造化データのマークアップが重要なトピックとして挙げられている気がする。

まず、自然なSEOに利用するべきかどうかについて、意見が分かれる。この業界の一部のベテランは、構造化マークアップ、または、コンピュータが読み取れる言語の利用を嫌う。なぜなら、訪問を活性化しない形式で、検索エンジンに情報を提示してもらいたくないためだ。

例えば、好きなNFLのチーム名を入力すると、グーグルは、次回の試合の予定を含むこのチームの情報をSERPで提供する。例えば、今でもよく覚えているのだが、動物園のウェブサイトを運営する際、検索結果の上部に営業時間を表示してもらった方が良いのか、あるいは、ウェブサイトに訪問してもらい、現在の動物の展示および催しを知ってもらった方が良いのかと尋ねられたことがある。もっともな質問である。そして、動物園により多くの来園者をもたらす方法を選べ、と言うのがもっともな答えであった。

グーグル、ビング、そして、ヤフー!は、気に入ったデータを、ウェブサイトのオーナーやビジターの気持ちを考慮せずに、好きな形式で表示する。個人的には、たとえウェブサイトの情報がSERPに表示されたとしても、情報源として信頼してもらうことを選ぶ。そのため、私はschema.orgやRDFa等の構造化データマークアップの利用を推奨している。

なかには、authorタグやpublisherタグ等、問題視されず、ベストプラクティスとして評価されつつある構造化マークアップの形式もあるので、是非、利用してもらいたい。

HTML: キーワードスタッフィング & 要素隠し

キーワードスタッフィングや隠しテキスト等、ランキングにマイナスの影響を与える要素は、一昔前の用法であり、大半のSEO業者は、利用していない。しかし、残念ながら、この問題は割と奥が深い。

キーワードスタッフィングは、Eコマースサイトのショッピングカートを最適化する上で、絶対に欠かせない要素として君臨している。同じワードやフレーズが、カテゴリや製品の説明欄で利用されている場合、繰り返しを避けるのは非常に難しい。ショッピングカートによって、ウェブマスターが管理することが可能な領域も異なる。容易に最適化することが出来るカートもある。一方、カテゴリページで、各ページに表示する製品の数を制限することしか出来ない可能性もある。ショッピングカートの最適化を詳しく説明するつもりはないが、これだけは言っておく — 過去2年間、一度もショッピングカートの見直しを行っていないなら、今すぐチェックしてもらいたい。eコマースのプラットフォームが時代の流れと共に進歩しているかどうか確認する必要がある。

また、意図的ではないクローキングを、驚くほど多く見かける。通常は、テンプレートのライターが、コンテンツ管理システムの予測のつかない事態を避けようとした結果、この問題が発生する。しかし、一部のページでdisplay: noneを使ってクロークしたテンプレート内に静的なリンクが掲載されており、カテゴリ等、何かしらの要素によって、リンクが表示されるケースに遭遇することもある。

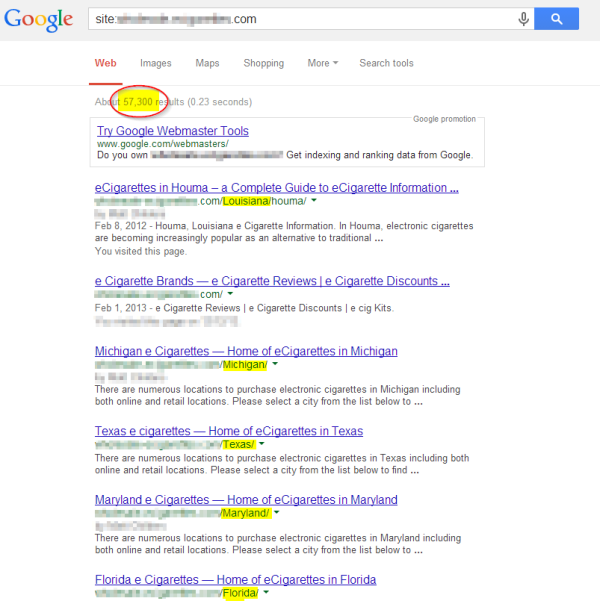

アーキテクチャ: クロール

クロールに十分に注目しているSEOの専門家は少ない。大ざっぱな表現である点は百も承知だが、この業界の関係者の大半は、その他の取り組みに忙殺されており、赤い、ど派手なエラーメッセージが表示されない限り、まずクロールを軽視する。検索エンジンが、ウェブサイトの全てのページ(少なくともクロールしてもらいたいページ)をクロールすることが出来る状態を維持しなければならない。サイト全体のページランクの流れを台無しにしたくないなら、ページを除外する際は、robots.txtではなく、メタのnoindex、followタグを利用しよう。

検索エンジンのクロールおよびキャプチャのアップデートが、タイミング良く行われているかどうかを確認することも重要である。タイミング良く行われていないなら、ドメインオーソリティの問題、もしくは、十分な量のページランクがサイトの隅々まで行き届いていない可能性が考えられる。

更新したレベル 2以降のページに到達するまで、ホームページ、または、レベル 1のページから更新したページにリンクを張る等、この問題を解決する手法が幾つかある。しかし、より健全なアプローチを求めているなら、更新されるコンテンツを、よりオーソリティの高いコンテンツ、または、コンテンツのセクションに自然に近づけるか、あるいは、オフサイトのページランクを持つ関連するコンテンツから妥当な内部リンクを構築する手法を勧める

すべてのコンテンツが常にクロール可能な環境を作れと命じているわけではない。それ相応の理由があって、検索エンジンは、クロールの頻度と深さを重視している。要するに、ウェブサイトのクロールの量を管理し、適切に利用する必要があるのだ。成り行きに任せるべきではない。

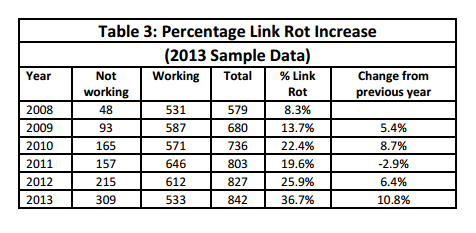

アーキテクチャ: 重複するコンテンツ

2013年の始め、マット・カッツ氏は、重複するコンテンツに関して心配する必要はないと述べ、SEO業界を震撼させた。 カッツ氏は、グーグルは重複するコンテンツを特定し、分配されたオーソリティを組み合わせ、SERPに1本のURLを表示すると断言していた。

グーグルは随分と前からこの方針を採用しており、実は、驚くような展開ではなかった。ウェブマスターツールには、自動パラメータ確認機能が用意されており、グーグルの代表者は、重複するコンテンツの統合について、以前から説明を行っていた。

以前指摘したことを繰り返すが、検索エンジンはグーグルの他にも存在し、グーグルの指摘と現実が異なることもある。つまり、重複するコンテンツを、出来るだけ、予防、もしくは、削除することで管理し、残ったものに関しては、カノニカルタグを利用するべきである。

カノニカルタグと言えば、1つのカノニカルなURLを、不適切に、複数の記事の全てのページで利用する手法がよく見受けられる。カノニカルの手法は他にもある。この手の手法には注意する必要がある。 カノニカルタグ、検索エンジンが読み込めるコンテンツ、もしくは、高度なメタタグを利用しているなら、ウェブサイトが技術を駆使しており、SEOを活用していることを、検索エンジンにアピールしているようなものである。要するに、特に吟味して欲しいと自ら望んでいることになる。

グーグルが、このタイプの技術的な誤りに対して、ウェブサイトの取り締まりを強化する可能性はある。検索エンジンは、無実のウェブサイトを葬ってしまうことを恐れて、アルゴリズム主体でペナルティーを課す行為には躊躇する傾向がある。しかし、パンダとペンギンで身をもって学んだように、積極的に行動することもある。クライアントのサイトを最適化しているなら、清廉潔白なサイトを維持するべきである。

アーキテクチャ: スピード

ウェブサイトのスピードアップによって得られるSEOのメリットを理解するウェブサイトは少ない。グーグルは、ランキングアルゴリズムのこの領域の影響を受けるサイトはごく僅かだと常に指摘している。この見解は、相関関係の調査によって裏付けられているように思える。近場のカフェに行って、ウェブサイトを実際に閲覧すると、スピードを実感することが出来る。ページがスムーズに読み込まれるなら、問題はないと見てよい。

ただし、大企業のサイトとeコマースサイトは例外である(つまり、スピードに気を配る必要がある)。このタイプのサイトを最適化しているなら、読み込みにかかる時間を数ミリ秒短縮するだけで、直帰率を下げ、コンバージョンとセールスを高める効果が見込める。

アーキテクチャ: URL

URLの現在のベストプラクティスは、2014年も活用することが出来るはずだ。シンプルで、読みやすいURLは、SEO以外のメリットももたらす。現在のブラウザは、複数のタブを用意しているため、ウェブユーザーは、タイトルタグよもURLを目にする機会の方が多い。

また、検索エンジンの結果ページに表示される際に、読みやすいURLは、無意味なURLよりもクリックされる可能性が高い。利用しているコンテンツ管理システム(CMS)が、タイトルタグをベースに分かりやすいURLを作る機能を提供していないなら、そのCMSを見直すべきである。これは基本的なSEOの機能であり、この機能すら提供されていないなら、残りのSEOの機能の効き目も疑わざるを得ない。

アーキテクチャ: モバイル

2013は、モバイル SEO(日本語)にとって、刺激的な1年であった。グーグルとビングは、全てのデバイスに対して、単一のURLを用意し、デバイスに合わせてサイトを表示するためにレスポンシブなウェブデザインを利用する構造が理想的だと認めた。現実として、全てのCMSが、この構造に対応しているわけではない。また、ウェブデザイナーのコミュニティによって、検索エンジンのスタンダードが、現実的でもなければ、望ましくもないことを示すケーススタディが提示されている。

グーグルとビングが推奨する取り組みを実施することが出来るなら、実施するべきである。しかし、実施することが出来ない、もしくは、実施しないまっとうな理由があるなら、各ページの最も完全な形に近いバージョン(恐らくデスクトップ版が該当する)に向かうカノニカルタグを利用し、スクリーンのサイズごとにブラウザのプラットフォームを基にリダイレクトを採用しよう。

ウェブサイトが全てのデバイスのユーザーを同様に扱い、検索エンジンのスパイダーを特別扱いしていない限り、検索エンジンからペナルティーを課される危険はない。基本的に、言語の好みにおいて、場所を基に、ビジターを自動的にリダイレクトする取り組みに似ている。

2014年に注目するべきオンページ SEOの要素は、これで全て紹介した。パート 3では、リンク構築に関するオフページのSEOの要素、ローカル検索、そして、ソーシャルメディアを取り上げる予定なので、楽しみに待っていてもらいたい。

この記事の中で述べられている意見はゲストライターの意見であり、必ずしもサーチ・エンジン・ランドを代表しているわけではない。

この記事は、Search Engine Landに掲載された「2014 SEO Playbook: On-Page Factors」を翻訳した内容です。

基本的な概要まとめ記事かと思いきや、意外と参考になる点も多かった良記事でした。内部最適化を語る時、コンテンツ、HTML、アーキテクチャとカテゴリを分類するのは分かりやすくていいですね。次回は外部最適化を取り上げるということで、ますます見逃せません! — SEO Japan [

G+]

Are you ready for 2014?

Are you ready for 2014? 今回は、毎年恒例、SEO計画書のパート 2(パート 1は

今回は、毎年恒例、SEO計画書のパート 2(パート 1は

SEOの基礎は、過去15年間、大きく変化したことはない。それでは、合言葉「質の高いコンテンツを作り、質の高いリンクを得る」も変化していないのだろうか、あるいは、変わったのだろうか?

SEOの基礎は、過去15年間、大きく変化したことはない。それでは、合言葉「質の高いコンテンツを作り、質の高いリンクを得る」も変化していないのだろうか、あるいは、変わったのだろうか?

これはSEO業界に大きな影響をもたらす。この変化について、優秀なSEOのエキスパートと話し合ったところ、セマンティックSEOを新たな視点で評価し、焦点を絞る取り組みが、何度も話題に上がった。

これはSEO業界に大きな影響をもたらす。この変化について、優秀なSEOのエキスパートと話し合ったところ、セマンティックSEOを新たな視点で評価し、焦点を絞る取り組みが、何度も話題に上がった。