Googleは年に1度、Androidの新バージョンから自動走行車まで(秘密の守られ方はそれぞれだが、ともかく)厳重な秘密にしてきた新プロジェクトをお披露目することにしている。そして明日がその日だ。Google I/Oのキーノートが予定されている。さて何がテーマとなるのだろう?

もちろん確かなことは分からないが、あらゆる種類の噂が渦を巻いている。その中には当たっているものもあるだろう。

われわれは明日朝10時から〔JST 5/19 AM2:00〕からGoogle I/Oを会場で取材する予定だ。ライブブログも用意されている。ここでは何がテーマになりそうか予想してみよう。

Android Nの詳細

これはいわば既定事実だ。Googleは以前からAndroid Nについて語ってきた。これはAndroid OSの次世代メジャー・プラットフォームで、デベロッパー向けにプレビュー版が提供されている。

I/Oではリリース日時、新機能など新バージョンの詳細が発表されるのが通例だ。

われわれもすでにAndroid Nについては繰り返し報じてきた。新OSにはディスプレイの分割表示(LGとSamsungはすでに分割表示できるアプリを発表しているがOSレベルで公式にサポートされたものではない)、通知のデザインの改良、プルダウン窓を利用したインライン返信、電力消費を自動的に低減させる新たなロジックなどが含まれている。

興味の中心は、Google CardboardやSamsung GearVRのような拡張現実システムがAndroid NではOSレベルでサポートされるかどうかという点に集まっている。

Android Wearのアップデート

Android Wearが発表されてから数ヶ月経つのでそろそろ何らかのアップデートがあっていい時期だ。

事実、 I/Oの2日目には「Android Wearの新機能は?」というパネルが用意されている。

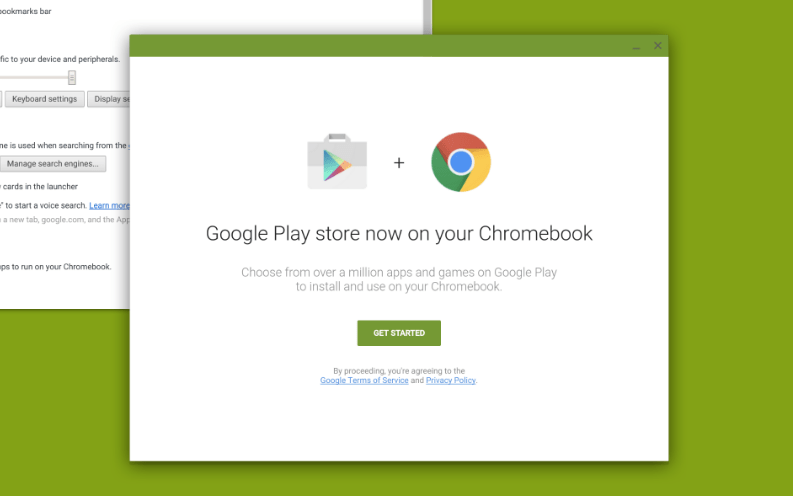

ChromebookのAndroidアプリ

スクリーンショット: InauspiciousPagan on Reddit

情報を総合すると、ChromebookノートパソコンでAndroidアプリが作動するようになることは間違いなさそうだ。それも数十個などではなく、Androidアプリのすべてではないとしても何百万のアプリが作動するようになる。

誰かがredditに 、「AndroidアプリをChromebookで作動させる」というチェックボックスのスクリーンショット投稿してからまだ1月にならない。

今回のI/Oかどうかは別として、この機能が登場するのも確実だ。

Google独自のVRヘッドセット

われわれはこのところずっと Googleのウルトラ低価格な段ボール製VRヘッドセットがこれだけ成功しているからには、もう少し高機能で造りもしっかりしたシステムが登場してもいいはずだと考えてきた。

しかし具体的にどんなものかとなると推測は各人各様だ。【略】

Wall Street Journalの記事によれば、Googleは完全に独立な(スマートフォンやパソコンや煩わしいケーブルを一切必要としない)拡張現実ヘッドセットを開発しているという。

さてどうなるだろう?

Android VR

スタンドアロン型のVRヘッドセットが開発されているなら、そのプラットフォームがあるはずだ。

先週、GoogleはAndroid VRの一端をちらりと見せた。GoogleはAndroidにVR能力を持たせることによってあらゆるガジェット、サービスにVRを導入する考えらしい。

プロジェクトTango

このプロジェクト自体は最近始まったものではない。これはコンピューター・ビジョン・システムでスマートフォン(やVRヘッドセット)に現実世界での位置を正確に認識させるためのテクノロジーだ。動く対象にマーカーを貼り付けたり外部センサーを利用したりせずにすむコンピューター・ビジョンなら位置認識以外にもありとあらゆる応用が考えられる。

Amazonに対抗するGoogle Chirp

音声認識で作動する家庭用アシスタントのAmazon Echoは大人気だ。Echoに話しかけるとUberを呼んでくれる! 天気、交通情報、ニュースを教えてくれる! 明かりも消してくれる!

音声認識が日常生活を便利にする技術であることはわかった。では音声認識を得意とするのはAmazonの他にどこだろう? もちろんGoogleだ。Uberを呼んだり(買収したNestを通じて)電気を消したりするテクノロジーに優れているのもGoogleだ。【略】

噂や情報を総合すると、GoogleはコードネームChirp〔おしゃべり、さえずり〕というEchoのライバルとなるシステムを開発中だという。I/Oはそのデビューの舞台としてうってつけだ。

そして…

それは明日のお楽しみだ。われわれは早くから会場入りする(私とTito はTechCrunchのSnapchatアカウントを利用してリアルタイムで報告する)。ライブブログは午前10時前にはスタートさせる。では明日!

(原注) I/Oは開催場所が変わった。これまではサンフランシスコ最大のコンベンション・センターの一つ、Moscone Centerで開催されていた。今年の I/OはGoogleのマウンテンビュー本社キャンパスに隣接するショアライン・アンフィシアター(Shoreline Amphitheater)という野外劇場に変更になった。これまでにも耳を聾する大音量のコンサートがたびたび開かれてきた会場だ。われわれはI/O 2016をしばらく前からGoogle Warped Tour”と呼んでいる。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)