タグ: アクセス解析

BtoB企業のマーケッターの一日。 「毎日こんな業務をしています。」

[寄稿]年間予算は1000万円未満?調査で明らかになったBtoB企業のWebマーケティングの実態

日本を代表するアクセス解析ツール4社が集結!競合同士でインバウンドマーケティング討論(後編)

[寄稿] SEO担当者が知らないと恥ずかしいGoogleアナリティクスの基礎指標

日本を代表するアクセス解析ツール4社が集結!競合同士でインバウンドマーケティング討論(前編)

BtoBサイトへ良質なアクセスを激増させる「SEOキーワード選定法」とは?

[寄稿] 何のために数値化するのか?「ユーザエクスペリエンスの測定」読書会レポート

[寄稿] 「検索順位で1位になる」ことがSEOの成功なのか?を、事例を踏まえて考えてみる

データドリブンマーケティングを理解するための7のキーワード

今後、データドリブン(主導)の戦略や活動が、より一層展開されていくことになる。そのため、今のうちに、押し寄せるデータの波を迎え撃つ準備を進めておこう。

アトリビューション

ラストクリック(購入前の最後の接点に全ての功績を認める方針)は、ブランディング、そして、従来のマーケティングが、下火になっていた、オンラインマーケティングの初期段階において、大きな注目を集めていた。しかし、ここ数年、ファンネル全体、そして、購入までのパスでマーケティングを実施する戦略の効果が証明され、大きな難題として、マーケッターの前に立ちはだかるようになった。

多くのツールや手法が、成熟期に入っている。従って、2014年においては、購入までのパスの全ての接点を特定し、評価する試みによって、どのように広告予算を用いるのか、そして、どのメッセージを、いつ、どこのオーディエンスの部分に提示するのかが決まるようになる。

Google アナリティクスのマルチチャンネルファンネルとアトリビューションモデリングを使って、マーケティングの支出を管理する方法を学ぼう: Google アナリティクスのアトリビューションモデリング & マルチチャンネルファンネル

ビッグデータ

「今年はモバイルの年になる」(少なくても4年前から言われ続けている気がする…)と同じぐらい、「ビッグデータ」と言う用語を何度も聞かされているはずだ。Cardinal Pathの情報戦略を統括するステファニー・ハメル氏は、「Excelに押し込めないものは全てビッグデータに相当する」と分かりやすくビッグデータを定義している。

2014年においては、あらゆるタイプのデータ — 構造化されたデータ、構造化されていないデータ、ソーシャルのデータ、クリックストリームのデータ、顧客のデータ、売り上げのデータ等 — を集めて、大きなスケールで、正しい決定を下す際に役に立つテクノロジーや手法を適用する必要がある。

ビッグデータの詳細、そして、力を入れるべき分野を詳しく知りたいなら、Cardinal Path社のハメル氏が作成した記事に目を通しておくことを薦める: ビッグデータ – デジタルアナリストに与える影響

顧客分析

マーケッターは、顧客のデータを集め、そして、調べて、価値のレベルを把握し、生涯価値を割り当て/推測し、個人に特化したメッセージ、行動やアトリビューションに応じたメッセージを送る取り組みを長年続けてきた。

現在、消費者は、前例のないレベルで、拡大を続けるデータの足跡を残しており、マーケッターは、顧客の全体像を間近で見ることが出来る — 最善の顧客、最悪の顧客、常連の顧客、さらには、避けたい顧客さえも把握することが可能である。これは、とても特殊なデータであり、徹底的に掘り下げ、見つけ出すべきである。

スピードが最優先され、また、顧客のデータの融合を行う、新世代のデジタル分析ツールを学びたいなら、次の記事を参考にしよう: 新世代のデジタル分析ツール

データサイエンス

データサイエンスは、レポートを読むだけでなく、実用的な情報を得る行為を指す。現代のデータサイエンティストは、数学的なモデルや統計的な手法を用いて、RやSAS等のツールの力を活用し、– それが運営のメソッドであれ、メッセージのテストであれ、あるいは、売り上げの推測であれ — 調べているトピックに関して有益なストーリーをもたらす。

優秀なデータサイエンティストは、現在も、そして、今後も需要が高く、データの収集、分析、予測分析を含むマーケティング戦略を実行し、ほぼリアルタイムで、推奨事項、さらには、プログラムのアクションを改良するスキルを持つ。

レポートを読むだけのグループ、または、有益な情報を得るグループのどちらのグループの属しているかを知りたいなら、次の記事に目を通しておこう: そのKPIが無意味な理由 & 対策

データの視覚化(データ・ビジュアライゼーション)

分析ツールが集めた大量のPDFを受け取ることがあるなら、大半のレポートが役に立たなくなりつつある点に気づくはずだ。この類のレポートを受け取るのは、「これがデータです。解明して下さい」と言われているのと同じだ。

データの視覚化(データ・ビジュアライゼーション)とは、決定を下す上で有効な、有益な見解を得られるデータを、分かりやすく選択し、提示をする試みを指す。基本的なものでは、円グラフや線グラフが該当する。しかし、最近では、インタラクティブなモーショングラフ、ネットワークツリー、地域別のオーバーレイ、そして、ヒートマップに至るまで、様々な選択肢が存在する。データへの投資に対する見返りは、複雑なデータを魅力的で、分かりやすく表現するグラフィックとして現れ、情報を知識へと変えることが可能になる。

次の記事を読んで、効果的なグラフを作り、データに応用する方法をマスターしよう: 効果的なデータの視覚化

オムニチャネル

既にオムニチャネル計画の策定を要請されているのではないだろうか?購入へのパスは、デバイス、メディア、場所、そして、時間を横断している。このようにマルチチャネルマーケティングは進化しているため、消費者が、マスメディア、検索、ソーシャル、モバイル等で、自社の製品を探している際に、その場にいるだけでは、十分とは言えなくなった。

現在、データをまとめて、消費者と顧客候補が行う相互的な活動の複雑な組み合わせを理解する上で、ITとマーケティングの調整が、重要な鍵を握っている。例えば、お店で、探している製品を見つけるため、あるいは、(動画広告か何かで学んだ)チェックインした顧客のみが利用可能なクーポンを探すために、買い物客が使うモバイルアプリをイメージしてもらいたい。これでもシンプルな部類に入る。

個人情報(PII)

PII(Personally Identifiable Information)とは、特定の人物に関連付けることが可能なデータのポイント全てを指す。eメールのアドレス、クレジットカード番号、住所等が該当する。

この件には、法律、倫理、そして、実務の面が絡んでいる。最高の分析データ、そして、アクションの一部は、集約し、匿名化したデータから得られる点を覚えておいてもらいたい。例えば、ターゲット候補となる、利益を多くもたらすユーザーの層を特定することが出来れば、名前やeメールアドレスを知らない状態で、このユーザー層、そして、類似するユーザーの匿名のクッキーに狙いを絞ることが可能になる。ダイレクトメールの送信、勧誘電話、あるいは、個人に特化したメールブラスト等が、PIIを介したつながりを作る取り組みに挙げられる。

最後になるが、2014年を迎えるにあたって、今回紹介したポイントを胸に刻み込んでもらいたい。私が参加する飲み会にたまたま出席する機会があったら、熱い議論を是非交わしたいと思う。

この記事は、Online Behaviorに掲載された「Top Data-Driven Marketing Terms」を翻訳した内容です。

【Googleアナリティクス中級編】目標到達プロセスを120%活用してコンバージョンを倍増させる方法!

【初心者向け】 アクセス解析を売上につなげるカギは「目標設定」と「現状分析」

スタビライザー小松氏による寄稿5記事目。今でこそアクセス解析を行っていないWebサイト自体少なくなりましたが、一方でツールを導入していてもなんとなく数字を眺めているだけ、、というケースも少なくないのでは。基本に立ち返り、なぜアクセス解析が必要なのか?改めて見直してみてはいかがでしょうか。

「アクセス解析って、何のために行うんですか?」

さて、この質問、あなたならどう答えますか?

これは、最近私のクライアントの方から立て続けに聞かれた質問です。この記事を見られている方の多くはアクセス解析をしてる人のほうが多いかもしれませんね。

Webサイトじゃなくて、自分の体でまずは考えてみましょう。

「アクセス解析って必要なの?」という質問は「健康診断って受けないといけないの?」によく似てます。

ちなみに、会社の健康診断は安全衛生法により定められている為、会社は健康診断を受けさせなければなりません。

では、皆さんは、法律で決まっていなかった場合、健康診断は受けますか?受けませんか??

「悪いところあったらやだから、受けようかな・・・」という人、「体調悪くないし別に受けなくてもいいや」と思う人など、様々かと思います。ただ、あくまで「現状確認」にすぎないと思います。

今の自分のカラダがどうなっているのかな?というのを知りたい、そしてなにかしら対策をするべきなのか?それを知りたい方が多いかと思います。

「Webサイトのアクセス解析、よくわからないけどちゃんとやった方が良いのかな?」という方は、この状況に近しい方が多いです。

アクセス解析して悪いところを直そうと思う人もいますが、見たって別に修正しないし、修正すると費用かかるし…。

そういうことであれば、売上や問い合わせが増えない、急激に落ちたと体感した時に原因を探る一つとして参考程度に見ればよいのです。まさに、自分のカラダの健康診断と一緒ですね。

売上をWebサイトであげよう!と思っている場合はどうするか?

一般的なサラリーマンの健康診断に例えると上記のような話ではあるのですが、Webを活用して売上を上げよう!と考えている場合はまた少し違います。つまり多くの場合はこちらの話です。

この場合はアスリートの体力測定です。

皆さんがアスリートとして大会に向けて例えば背筋力、持久力、肺活量Upの為にトレーニングに励んでいた場合、体力測定って受けますか?受けませんか?

この場合はおそらく積極的に受けるはずです。

トレーナーの方がつく場合もありますが、まずは、トレーニング前に一度は体力測定を行い、一定期間トレーニングを行った後、改めて同じ項目を測定します。そして、数値を測った結果、

- もっとここの筋肉をつけたほうが良い

- このトレーニングをもっと増やしたほうがいい

- こっちは達成しているから別のトレーニングにしよう

と、まず

- 現状を分析し、

- 結果をもとに差異を測り、

- 今後の計画をたてる

といったようなことをされるのが普通ではないでしょうか。そして、Webで売上をあげるためのアクセス解析は、このアスリートの体力測定と同じです。

大事なことは目標設定と現状分析

CV(コンバージョン)目標を決めて、まずは現状分析を行います。その上で、例えば

- アクセスを増やす施策を行った、広告出してみた、SEOに取り組んだ

- サイトの改善を行って直帰率の高いページを改善した

- CVRが1%だったので、エントリーフォームを改善することで1.2%を目指したetc

など、あくまで【現状】を元に【目標】を設定し【計画】を立てる。

アクセス解析は【現状(結果)】しか分かりません。大事なのは目標を目指して何かをした結果をどう捉えて、どう次のアクションに結びつけるか?ということです。

アクセス解析で改善点を見つけ、手を打つ。また、アクセス解析して打った手がどうだったか検証する。この繰り返しです。

アクセス解析に必要なのはGoogleアナリティクスのテクニカルな使い方とか、タグマネージャーの高度な使い方を細かく知ることではありません。

アクセス解析をすることは、Webサイトの目標設定と目標を達成する為の手法です。目標設定なしにアクセス解析のデータをいじくり回しても何の価値もありません。

理想と現実のギャップを埋めるのがアクセス解析のやり方の一つですから、まずは現状分析から初めて、その上で、目標設定してみることが大事だと言えます。

目標なしにWebサイトを運営するのはただ、その辺をうろうろと散歩しているのと同じです。決して目的地に着くことはありません。登る山(目標)が決まれば必要な装備(施策)も決まってきます。

まとめ:目標なしにアクセス解析をしても無意味

とはいえ、下記のような方も多くいらっしゃるのが現実です。

- 現状Webサイトはあるが、何となく運営していて目標が明確でない

- Webサイトを全面リニューアルしたいが、どのような戦略で進めていいのか分からない。

- アクセス解析は実施しているが、何を見ていいか良く分からない

そのような方は、お気軽にご相談ください。

個性豊かな新世代のデジタル分析ツール6選

新世代のデジタル分析ツールが次々に登場している。この世代のツールは、スピードを重視し、顧客のデータを統合する機能に秀でている。典型的なツールを使った結果、レポートや分析データが混乱を生じさせているなら、中断し、これから紹介する新しい6つの分析ツールをチェックしてもらいたい。

Heap Analytics

「何もかも手に入れる」がHeap Analyticsが掲げているテーマである。タグの管理と同様に、サイトに少量のコードのスニペットが加えられる。すると、多くのデータがなだれ込んでくる。このデータは、イベントフィードとして、未加工の状態でもたらされる。全てのクリック、タップ、スワイプ、ページが記録される。このようなアクションは、「Facebook いいね!」や「Twitter フォロー」等に分類される。そして、イベントが組み合わされ、スーパーイベントが生成されることもある。例えば「Facebook いいね!」と「Twitter フォロー」を含む「ソーシャルアクション」はスーパーイベントに該当する。

データが「適切」に取得されなかった場合、再び分類が行われる。分析のQAを待つことなく、新しいページもその都度送られてくる。しかし、Heaps Analyticsの本当の実力が発揮されるのは、イベントが特定された後である。

ページビューでデータを分類するその他の分析ツールとは異なり、Heapは、まず、ビジターによる整理を行う。ビジター IDが指定されていない場合は、独自のビジター IDを用いる。続いて、「フォームの一部を入力したユーザー」等の区分が特定され、区分に該当する個人がリストアップされる。さらに、それぞれの顧客に関連するイベントストリームが、IDに加えられ、決定した区分に該当する場合、それぞれの顧客が辿ったルートを簡単に確認することが可能になる。

Heapは、ユニークビジターの人数に応じて、価格が変わるシステムを採用している。50万人のユニークビジターを調査する場合、約2000ドル/月が必要になる。heapanalytics.com/

Lytics.io

Lytics.ioは、全ての顧客データを結びつけ、区分を厳格に絞り込み、その他のマーケティングツールに力を与える。Lyticsは、Eメールアドレスやウェブログ等の少量のデータから着手し、その後、独自のマッチングテクノロジーを用いて、Rapleaf、Facebook、そして、キーワードの検索データを、外部データソースとして使い、顧客の記録に色を塗っていく。最終的に、明確な顧客像を用いた「黄金の顧客記録」が作成される。

一連のルールを介して、Lyticsは、Eメールの送信、メッセージの投稿、さらに、顧客への接触を誘発する細かい区分を生成する。顧客記録には、インターネットを頻繁に利用する時間、位置、頻繁に利用するデバイス、関心、年齢層、そして、心理学的属性のデータが含まれる。

Lyticsの価格は、初期のモデルにおいて約5000ドル/月に設定されている。lytics.io

Nectar

Nectar Online Mediaは、ソーシャルメディアのストリームを統一することでもたらされる「ハイパーパーソナライゼーション」に特化している。また、Nectarは、データを一体化して顧客を総合的に見るだけでなく、顧客を最高のタイミングで行動してもらうことを意図した、スピーディーなトリガーの実施を目標に掲げている。

例えば、販売しているカメラの様々なモデルを展示するページをAさんが閲覧しているとする。Aさんは、特定のモデルを入念にチェックした後、購入せずにサイトを去った。

AさんのFacebookのストリームからデータを確認したところ、イベントが近づいていることが判明した…カリブ海にバカンスに行くようだ。そこで、AさんのFacebookのニュースフィードに100ドルを値引くクーポンを投稿した。次にリマーケティングの手法を使って、Aさんがウェブを利用する際に、カメラと付属品の広告を表示させる。これが、ハイパーパーソナライゼーションである。

Nectarの価格は公表されていない。nectarom.com

Infogr.am

良いか悪いかは別として、見やすさを意識してデータを表示すると、読む量、そして、取り込む量を管理することが出来る。しかし、分析の知識を持つデザイナー、そして、反対に、デザインスキルを持つ分析のエキスパートは少ない。ここで、Infogr.amが役に立つ。

Infogr.amは、既製のインフォグラフィックのテンプレート、そして、カスタマイズ可能なグラフィック、ワードクラウド、そして、アイコンを持つオンラインシステムである。自分のグラフィックと動画をアップロードし、エンベッドすることも出来る。

Infogr.amのシステムは、とても分かりやすい。データを既に用意しているなら、5-10分もあればインフォグラフィックを作ることが可能だ。しかも、その大半は、各種のカスタイゼーションの選択肢を調べることに費やされる。Infogr.amは、静的なシステムであり、インフォグラフィックを投稿したら、数字に手を加えることは出来ない。また、大量のデータを掲載するケースには向いていない。しかし、注目を集めることを目指した有益なサマリーを提供するなら、うってつけのサービスとなる。

Infogr.amは無料版を提供しているものの、テンプレートの選択肢を増やしたいなら、12ドル/月のプロ版の購入を検討しよう。infogr.am

Insight Rocket

Insight Rocketは、自動のマルチチャンネルでのストーリーテリングを可能にする。これは、Tableauのレポートの長所と柔軟性に、主張する力を組み合わせたツールである。Insight Rocketは、スタッツを異なる経緯で解釈する、例えば、ブランドやコマース等の複数のチームを擁する大きな企業に向いている。同じ計測基準を全チームが用いる状況が理想だが、これは稀なケースである。管理するデータを「真実」として表に出す前に、社内で連絡を取り、合意を得る必要がある。

さらに、Insight Rocketには、データの分類を支援する強力なデータ統合チームが控えている。つまり、データが組み合わされ、Tableauのレポートが実施された後、分析スタッフは、自由にデータを研究することが出来る。有益な情報が見つかると、ストーリーのように配信され、Eメールやイントラネットシステムに送り込むことが可能である。その上、ストーリーを踏まえた質問および回答を提供する機能も用意されている。

Insight Rocketの価格は、2000ドル – 10,000ドル/月に設定されており、データのソース、および、必須のサポートに応じて変動する。insightrocket.com

Beyond Core

Beyond Coreは、データ分析の新しい領域を切り開くツールである。真のデータサイエンスの方法、機械学習、そして、自動作成動画を組み合わせている。Beyond Coreは、分析のビギナー、そして、一流の分析のエキスパートに対して、多くの機能を用意している。

ビギナー、または、分析を専門としていないユーザーに対しては、分かりやすいアドバイス機能を提供している。データがシステムに読み込まれると、ユーザーに代わって、マシンが、特に興味深いデータで表を作成する作業を担当し、*その後*、要点を2分間で説明する自動のインテリジェントな動画ナレーションを提供する。分析データを解釈することが出来る人材はほんの一握りしかいないため、このツールは非常に有益である。データの意味を同じ関係者に何度も説明したことがある分析家なら、情報を自動的に送るこの機能を大歓迎するはずだ。

また、Beyond Coreは、高度な分析の取り組みにも対応している。このシステムはHadoopをベースとしており、サンプリングを行うことなく、(数週間ではなく)たった数時間で大量のデータ列を処理することが出来る。データがロードされると、分析担当者は、システムが最適化する列を選択する。その後、計算が始まり、数字を増やす要因が表れる。明らかな答えが表れたら(例えば、保険に加入していない大勢の患者が、病院の費用を上昇させているケース)、当該のグループを排除し、再び分析を行おう。2度目の分析では、より深い相関関係が浮上してくる(分析のやり直しには、通常、数週間を要する)。さらに、多数の変数を加えることが可能であり、初期の変数の選択に対する偏りを取り除くことが可能である。

Beyond Coreはセルフサービス形式のツールであり、価格は500ドル/月~に設定されている。beyondcore.com

ビッグデータ革命は、デジタル分析のスピードとツールに多くの変化をもたらしている。企業の重役陣は、分析スタッフが明らかにするソリューションをまだ知らない。この活躍により、分析の担当者はヒーロー扱いされるだろう。

編集者記: サムネイルで利用した画像は、強力な視覚化ツールのCircosから借りた。

この記事は、Online Behaviorに掲載された「The New Generation Of Digital Analysis Tools」を翻訳した内容です。

BtoBサイトのGoogle アナリティクス入門~アクセス解析で初心者が見るべき16指標~

消費者の購買行動に関する4つの発見 – ソーシャル、Amazon、ブランド、店舗

小売のプロモーションに特化するParago社は、複数の製品のカテゴリーにおける、消費者がリサーチ、そして、購入を行う経緯を調べ、先日、調査結果を発表した。この調査は、消費者による購入に関する見解が多く詰まっており、デジタルマーケッターは様々なヒントを得られる。

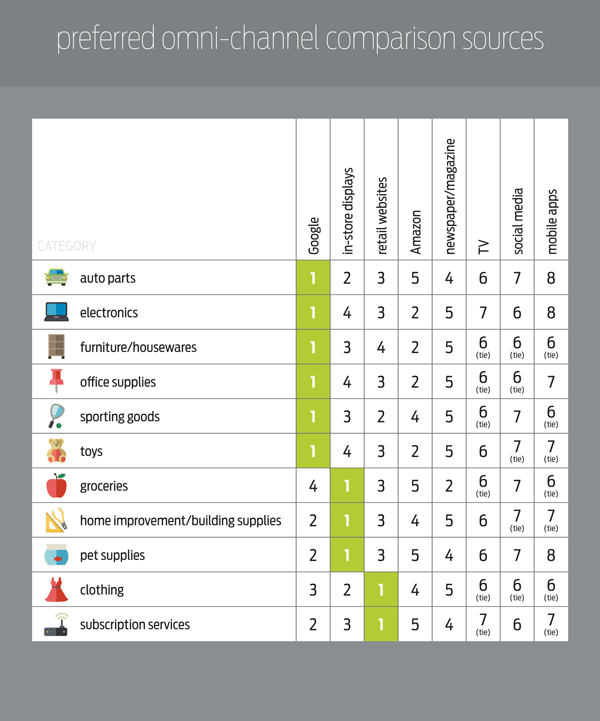

ここでは、リサーチの一つの領域にスポットライトを当てる — それは、消費者が購入モードに入った時の消費者の行動に関する見解である。購入する製品を調べる際に消費者がチェックする情報源をリストアップした下のチャートは、デジタルマーケッターに様々なアイデアをもたらす。

消費者がオンラインで購入を行う経緯。画像の著作権 — Parago

左側: 自動車部品、電化製品、家具/家庭用品、オフィス用品、スポーツ製品、オモチャ、食料品、日曜大工道具/住宅用品、ペット用品、購読サービス

上: Google、店舗内のディスプレイ、小売店のウェブサイト、Amazon、新聞/雑誌、テレビ、ソーシャルメディア、モバイルアプリ

1. ソーシャルは購入調査のチャンネルではない

Conductorによる調査では、購入リサーチプロセスにおいて、ソーシャルは最も利用される回数が少ないチャンネルであることが判明した。97%の確率で利用される検索と比べ、ソーシャルは、たった15%であった。

Conductorの調査が行われたのは2012年であり、時間が経過しても、消費者は、ソーシャルに頼ろうとしていないことになる。これは注目に値する。

当然ながら、ブランドを構築する、顧客の声に耳を傾ける、コンテンツを配信する等、ソーシャルには大きなメリットがある — 事実、私達が実施した調査では、ソーシャルの利用目的の中で、2番目に多かったのはコンテンツの発見であった — しかし、消費者は、購入する製品のリサーチには、ソーシャルを利用していない。

2. Amazonの影響力は思っているよりも低い

オンラインショッピングにおいて、Amazonの力は絶対的であり、製品の深さと広さ、そして、確立されたブランドは、多くの小売業者が、インターネットショッピングの分け前を得るには、あまりにもスケールが多過ぎると言う考えが定着している。

しかし、Paragoの調査では、確かに、Amazonは絶対的なブランドを構築し、また、レビューが多数投稿されたサイトは、オンラインリサーチにおいて重要な情報源ではあるものの、オンラインの小売業者も十分に戦えることが判明している — 自然な検索結果で、ある程度上位にランク付けされていることが前提となる。

小売業者は、製品を買ってもらうために、同等の価格に設定する必要はあるが、Amazonがリサーチのチャンネルとして2番目に多く用いられている全ての分野で、オンライン検索(Google)が1位を獲得している。

3. ブランドロイヤルティが購入の決定に大きな影響を与える

調査によると、ショッピングサイトは、購入プロセスにおいて、3番目に利用されることが多いようだ。

つまり、ブランドロイヤルティは、オンライン検索ほどではないにせよ、購入プロセスに影響を与えていると言えるだろう。面白いことに、アパレル業界のブランドロイヤルティは、購入に最も大きな影響を与えている — これは、服の購入は、個人の好みに左右され、また、消費者の信頼を必要とする事実に基づいている。

4. 店舗内で実際に確かめなくてもよい製品もある

店内での販売は、オンラインの買い物を抑制すると言う、当たり前の主張が長らく浸透している。 しかし、「in-store displays」(店舗内のディスプレイ)をよく見ると、消費者は、実際に手に取ることが出来なくても、オンラインで製品を購入していることが分かる。

事実、– 電化製品、家具、家庭用品、そして、スポーツ用品等、実際に手に取って確かめたいと思われる製品のカテゴリーにおけるチャンネルとし、「in-store displays」は3番目、もしくは、4番目に位置しており、重宝されているわけではない。

店舗内の展示が最も利用される回数が多い製品のカテゴリーは、オフラインの購入が今でも大半を占める、食料品、ペット用品等のカテゴリーであり、配送が面倒で、急に必要になる製品が該当する。

このデータから、店舗内の購入から、消費者が距離を置き始めていることが見えてくる。しかし、このデータだけで判断するべきではない。オンラインショッピング、そして、「ポイント & クリック」する購入には、調査では取り上げられていない消費者のニーズが欠けている — 「感覚で製品を選ぶ」ニーズ、「実際に手に取って、触りたい」ニーズ、そして、「他の製品と比べたい」ニーズ。

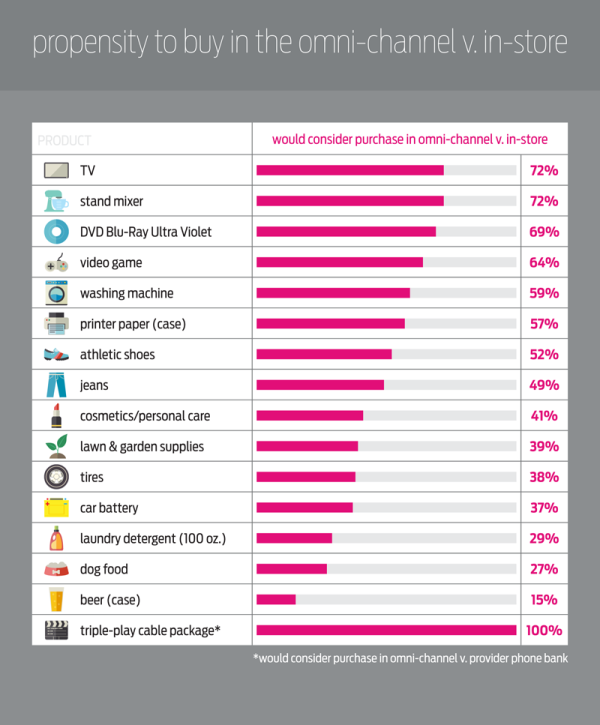

消費者が製品を購入する場所 — 画像の著作権 Parago

左側: TV、ミキサー、DVD ブレーレイ ウルトラバイオレット、テレビゲーム、洗濯機、プリンター、運動靴、ジーンズ、化粧品/パーソナルケア用品、芝生 & 庭用品、タイヤ、車のバッテリー、洗濯用洗剤、ドッグフード、ビール、TV/インターネット/電話のパッケージ

上: 製品、店舗以外で購入する割合

このニーズは、購入の決定を楽にすることに力を入れている小売業者によって、少なくとも部分的には、満たされる。要するに、店を訪問して収集する豊富な情報を消費者に提供する必要があると言えるだろう。

また、リッチメディアのコンテンツを提供することも求められている — 情報を基に購入の決定を下してもらうことを目標に掲げ、店の中で刺激される感覚にアピールするような、大きく、詳細が分かる画像、動画、そして、ユーザーによるレビューを提供するべきである。

オンラインコマースを成功に導く鍵

消費者のオンラインショッピングに関する最新の調査では、ほぼ全ての製品のカテゴリーにおいて、消費者は、リサーチの情報源として、Googleを最も利用していることが分かった。この調査は、以下の2つの当然の事実が、オンラインコマースに当てはまると示唆している:

- 勝つためにはまず参加する必要がある。 消費者は、製品を購入する際に、他の何よりも検索を頼りにしている — つまり、検索結果に表示されていなければ、競争に参加することさえ出来ないのだ。

- 最高のアイテムを提供する必要がある。 消費者が、購入プロセスにおける情報源として、店舗内の展示から距離を置きつつある中、オンラインの小売業者は、隙間に入り、店舗内の買い物で得ていた情報や経験に代わるものを提供しなければならない。

上記の2点を考慮し、サイトに反映させるオンライン小売業者は、オンラインコマース化の流れにおいて、有利な立場に身を置くことが出来るようになる。

この記事の中で述べられている意見はゲストライターの意見であり、必ずしもサーチ・エンジン・ランドを代表しているわけではない。

この記事は、Search Engine Landに掲載された「4 Revealing Facts About How Consumers Search And Buy Online」を翻訳した内容です。

SEOのランキングレポートの必要性と妥当性を考える

SEOコミュニティでは、以前から、自然ランキングのレポートの是非について、議論が交わされている。データの精度に関して、利用規約を破って、データをコピーするツールに関して、クライアントのレポートの必要性に関して等、この分野賛否両論のトピックに事欠かさない。また、ランキングレポートが、パフォーマンスを観察する上で、本当に必要かどうかを問う声も上がっている。この主張を押す側、そして、反対する側の双方が、説得力のある – そして、適切な – 意見を展開している。

SEOのエキスパートとして、主要な成果の基準(自然なトラフィックやコンバージョンの量)を優先するべきだ、と私個人は考えている。ビジネスの結果にとって、このメトリクスは、より適切だと思えるからだ。

「ランキング」の価値

同じクエリの検索結果で、ウェブサイトを上位にランクインさせることは可能である。そして、この「ランク」は、毎分、毎日、そして、デバイスによって、変動する。検索エンジンが結果を表示する前に検討する複雑な要素を考慮すると、ランキングを計測する確実な方法を編み出すことは、事実上不可能である。パーソナライズ、ローカル、検索の履歴、利用されるデバイス等 – の不確定要素、そして、検索結果への影響の詳細な分析が行われている。

関連性のある自然なトラフィックをウェブサイトにもたらすためには、ウェブサイトをある程度高い順位にランクインさせなければならない。問題とされているのは、この順位を正確に特定し、具体的なランクの価値を割り当てる行為である。

先日、SEOのエキスパートのグループの力を借り、(非科学的)な実験を行い、ある会社が優先するフレーズのランクを分析した。実験の参加者には、15分間にわたって、グーグルを使って、米国内の様々な場所から、それぞれのコンピュータで、様々なブラウザとウェブプロキシを用いて、一部はログインした状態で、そして、ログアウトした状態で、まったく同じ検索を行ってもらった。

その結果、この会社のサイトは、1ページ目の様々な順位にランクインしていたものの、一部のケースでは、1ページ目から漏れていることが判明した。それでは、このフレーズに対する当該のウェブサイトの「ランク」は何位なのだろうか?謎である。

ランクを追い求める

特定のランクを狙う取り組みは、無益である。一方、計測可能で、行動に移すことが可能な基準に力を入れる取り組みは、有益である。

検索結果の「ランク」は、検索エンジンのユーザーに見てもらい、トラフィックをウェブサイトにもたらす効果がある。分析ツールでサイトの特定のページを精査すると – 自然の検索から、ウェブページにトラフィックを送り込むキーワードの量は、ページを最適化した特定のキーワードよりも遥かに多いことに気づくはずだ。実際の検索クエリは、ターゲットに選んだフレーズの副産物、ターゲットに選んだフレーズ、ブランドならではのフレーズのバリエーション、そして、ロングテールのフレーズの組み合わせである可能性が高い。

適切なキーワードとフレーズに対して、ページを最適化する際、当該のページへの自然のトラフィックの増加によって計測する目に触れる機会を永遠に追い求める傾向がある。(not provided)プライバシー保護の設定のため、キーワードを全て把握することは出来ないものの、自然のトラフィックに対するランディングページのレベルで、行動に移すことが可能なデータ(一部のクエリのデータ、エンゲージメント(オーディエンスの参加のレベル)のデータ、コンバージョンのデータ等)を数多く得ることが出来る。

ランキングレポートに焦点を絞るのではなく、事業の成果に影響を与える計測基準 – トラフィック、その次にコンバージョン(売り上げ、リード生成、エンゲージメント、その他のウェブページまたはウェブサイトの目標)を優先して、SEOプログラムの価値を証明するべきである。

結局、重要になるのは、品質である。潜在的なキーワードやフレーズの調査を真剣に行うのは、質の高いビジターを確保するためだ。ページの内容を検索の意図に合わせて、トラフィックを適切な訪問とコンバージョンに変える必要があるのだ。

何かが思い通りにいっていないことを、どうすれば知ることが出来るのだろうか?

パフォーマンスの観測と内部の評価を行うために、ランキングレポートが利用されることがある。大きな変化(特に順位の大幅な落下)を、重大なダメージを受ける前に、確認する取り組みは、重要視されている。積極的な姿勢は、SEOを成功に導く要素だと私は考えている。そして、ランキングレポートに頼らなくても、積極的に評価することが出来る効率の良い方法が、存在するはずである。

自然の検索結果を分析する3つの代案

ウェブマスターツール

グーグルウェブマスターツールは、大きなトラフィックの変化を記録すると、ウェブマスターに警告を発する(検索結果から脱落する – つまり、トラフィックに影響が現れる)。また、ウェブマスターツールは、キーワードレベルのデータが絶対に必要とされる場合、「ランク」に関するトレンドをチェックする上で有益な「平均掲載順位」をウェブマスターに伝えてくれる。

分析プログラム

大半の分析プログラムは、特定のパフォーマンスの基準を監視させ、警告を発するように設定することが出来る。グーグルアナリティクスでは、インテリジェンスイベント機能を介して、自動アラート(「大きな変化を検出すると、グーグルが生成する」)とカスタムアラート(自分で特定することが可能)を利用することが出来る。詳細はグーグルのページで確認してもらいたい:

自力で順位を確認

ランキングレポートよりも大幅にスピードは落ちるものの、自分で順位をチェックして、期待した結果と順位が一致しているか、そして、実際のリスティングが、上下のリスティングよりも優れていることを確認してもらいたい。

ペナルティの問題…

グーグルのデータベースを“取得”する行為は、利用規約に違反する。この規約の施行は不可能に近いものの、検索結果でユーザーの目に触れる機会を増やすことを望み、トラフィックを獲得するために必要な検索エンジンの利用規約を意図的に違反するのは、直観的に適切な方針だとは思えない。私ならルールを守り、所謂、“猛獣”を怒らせないように注意する。

グーグルの利用規約の本サービスの利用の項目を確認しよう:

「本サービスを不正に利用しないでください。たとえば、本サービスの妨害や、Google が提供するインターフェースおよび手順以外の方法による本サービスへのアクセスを試みてはなりません。ユーザーは、法律(輸出、再輸出に関して適用される法規制を含みます)で認められている場合に限り、本サービスを利用することができます。」

本当にランキングレポートが必要なのか?

クライアント、上司、または、マネージャーから、ランキングレポートには「y」位と記されているにも関わらず、実際の検索結果には「x」位であることを問われた経験があるなら、ランキングの報告が無益な取り組みだと気づいているはずである。結局、実際に検索を実行すると、レポートとは異なる結果が表示され – レポートの結果(の妥当性)を説明しなければならなくなるのだ。

「ランキング」と言う名の動く的を追いかけるのではなく、最も大事な測定アイテム、つまり、トラフィックとコンバージョンに焦点を絞るべきである。ランキングレポートからは窺い知ることが出来ない情報を、パフォーマンスのデータから得ることが出来るからだ。

最後になるが、ランキングレポートだけでなく、デジタルパフォーマンスの領域には、進歩が必要とされている分野がいくつもある。事実、「SEO」と言う用語自体が、矛盾している。検索エンジンを最適化することが出来るのは、検索エンジンを運営する会社のスタッフのみである。そのため、「ウェブサイトの最適化」という表現の方が正しい。

現在、SEOのエキスパートは、複数の役目を持ち、サイトの質、技術的なパフォーマンス、ユーザビリティ、そして、従来のマーケティングに力を入れている…この点に関しては、違う機会に詳しく説明したいと思う。

この記事の中で述べられている意見はゲストライターの意見であり、必ずしもサーチ・エンジン・ランドを代表しているわけではない。

この記事は、Search Engine Landに掲載された「The Fallacy Of SEO Ranking Reports: How To Better Spend Your Time & Effort」を翻訳した内容です。

今日のビジネスに関する29のショッキングな統計データ

リブートするという考えは、多くの人々を怖がらせるように思われる。

私の新刊『CTRL ALT Delete』が1週間前に発売され、幸運にも多くのメディアの注目を集めてきた。全てのインタビューの中で、人々はこのコンセプトに対して不安で神経質で心配した態度を取っているように思える。『CTRL ALT Delete』のサブタイトルは、“Reboot Your Business. Reboot Your Life. Your Future Depends On It(ビジネスをリブートせよ。人生をリブートせよ。あなたの未来はそれにかかっている)” だ。私には何が一部の人々を怖がらせているのかが分かるが、このことは紛れもない真実だ:『CTRL ALT Delete』は可能性と機会に関する本である。それは、あなたがする仕事について、もっと上手くなる(そして、もっとハッピーになる)ために力を与える本なのだ。

あなたにはどんな選択肢があるのか?

あなたは、自分自身、家族、コミュニティ、業界のためにどんな種類の未来が欲しいだろうか?多くの人々は、私たちTwist Imageチームが『CTRL ALT Delete』に人々の関心を向けさせるために作ったデジタル体験に感銘を受けている。この話を前に押し出し、どれほどビジネスが変化したかについてより多くの証拠を提供する取り組みにおいて、あなたは以下のプレゼンテーションを見ることができる。それは、たくさんの統計データと、片眉(もしくは両眉)を上げるような興味深いニュースだ。あなたがこの情報に価値を見いだし、ビジネスの基盤がいかに変化したかに関して、さらにはそのさらなる変化が今後しばらくの間起こり続けることに関して、このようなことは誇張もしくは過大表現であると考える人にこのプレゼンテーションを回すことを期待している。

今日のビジネスに関する25以上のショックな統計データはこちら:

mitchjoelより、25+ Mind Blowing Stats About Business Today – CTRL ALT Delete

今日のビジネスに関する29のショッキングな統計データ

-

世界は変わった

変わりつつある - この問いだけを頭に叩き込め — 今後5年間、企業に求められる人材になりたいか?

- 何もかも変わったことを、これから嫌と言うほど分かってもらう…

- グーグルの広告収入は、米国全体の印刷媒体の広告収入よりも多い(BUSINESS INSIDER)

- アップルの収益の2/3は、2007年以降に発売を開始した製品によってもたらされている(INTERESTING SNIPPETS)

- アマゾンの1年間の収益は、世界の半分のGDPよりも多い(PC MAGAZINE)

- アマゾンの倉庫の総面積は、マジソンスクエアガーデン700個以上の広さに当たる(BUSINESS INSIDER)

- OFFICE DEPOT、STAPLES、DELLが束になってかかっても、アマゾンのオンラインショッピングには敵わない(PC MAGAZINE)

- 有職者の12%は、自分達が務める会社が、ビジネスの変化についていけていないと感じている(CTRL ALT DELETE USER SURVEY)

- 1999年、ブロードバンドのインターネット接続の所有者は3800万人であった。現在、12億人が携帯電話でブロードバンド接続を行っている

- フェイスブックでは、1億5000万人のデイリービジターの半分近くが、モバイルデバイスからアクセスしている(CONSTANT CONTACT)

- 安全な水道水と電気を利用することが出来る人よりも、携帯電話サービスを契約している人の方が多い — これが現実(BUSINESS INSIDER)

- 74%…これは、モバイルが覇権を握る新たな世界で、競争に勝ち抜くための計画を持っていない企業の割合(CTRL ALT DELETE USER SURVEY)

- KICKSTARTERは、たった4年の間に9万8000を超える新しいプロジェクトの立ち上げに貢献し、5億2100万ドルを調達した(KICKSTARTER)

- KICKSTARTERは、昨年、全米芸術基金よりも多くの資金を芸術分野のビジネスに調達した(POLICYMIC)

- 企業の14%…現在の激しい競争のスピードに対応する準備が遅れる(CTRL ALT DELETE USER SURVEY)

- 商売の世界は、負けたら即地獄行き

- 243…過去5年の間に倒産した著名リテールブランドの数(RETAIL RESEARCH)

- CMO(マーケティング部門責任者)の平均在職期間は2年間(FORBES)

- フェイスブックでは、ブランドのページから投稿しても、平均でファンの16%にしか届かない(THE NEXT WEB)

- 2013年のタブレットの販売台数は2億を突破する(ENDERS ANALYSIS)

- INSTAGRAMは1億を超えるアクティブマンスリーユーザーを抱える(INSTAGRAM)

- INTERBRANDが発表したトップ 100のブランドの59%がINSTAGRAMを利用している(SIMPLY MEASURED)

- 2012年、スマートフォンユーザーの77%が、ローカルのコンテンツにアクセスしていた(LOCAL SEARCH ASSOCIATION)

- インターネットで買い物をするユーザーの81%は、PINTERESTの情報とアドバイスを信頼している(BLOGHER)

- インターネットには、14兆3000億のウェブページが存在する(WORLDWIDEWEBSIZE.COM)

- アメリカのインターネットのトラフィックの23.1%は、モバイルデバイスから発生している(WALKER SANDS)

- REDDITの驚異的なスタッツを紹介する — マンスリーユニークビジター = 6230万人、マンスリーページビュー = 44億回、1回のセッションの滞在時間 = 39分間(BUSINESS INSIDER)

- REDDITの従業員 = 22名(BUSINESS INSIDER)

もし気が向いたら、『CTRL ALT Delete』に関する詳しいことはこちらで見ることができる:CTRL ALT Delete. Reboot Your Business. Reboot Your Life. Your Future Depends On It. Today Is The Day.

筆者について:ミッチ・ジョエルは数々の受賞歴を誇るカナダ発のデジタルマーケティング/コミュニケーションエージェンシー、Twist Imageの代表です。2008年にはカナダで最もソーシャルメディア上で影響力のある人物、そして40歳以下で最も有名な40人の一人、さらに世界で最も影響力のあるオンラインマーケッター100人の一人に選ばれました。著書である「Six Pixels of Separation」(Grand Central Publishing – Hachette Book Group)は、ビジネス/マーケティング書として英語圏で大ベストセラーになっています。ミッチのブログはこちらから。

この記事は、Six Pixels of Separationに掲載された「25+ Mind Blowing Stats About Business Today」を翻訳した内容です。

上級者向けSEOガイド5/9 : データ&リサーチ

チャプター 4を終える頃には、強固なウェブサイトが出来あがっているはずである。しかし、SEOは、スピード、インデクセーション、そして、メタデータだけではない。

チャプター 5では、ImportXMLを用いたオフサイトSEOから説明していく。

1. ImportXMLとは

ImportXMLとは、html、xml、csv等のファイルの種類から、xpathを使って情報を引き出す手段である。

グーグルドキュメントのスプレッドシートに直接インポートすることが出来るため、外部サイトの情報を取得し、調達する上で大いに役立つ。また、高度な検索を実施して、他の方法では取得することが難しい情報を得ることも可能である。

ImportXMLを使った例を紹介していく。

基本的なシンタックス

ImportXMLはエクセルやグーグルドキュメントの数式と同じであり – 割とシンプルなシンタックスを利用する:

=importXML(URL, Query)

URL = 取得するURL

Query = URLで実行するxpathクエリ

基礎の例 – クイックスプラウトのH1タグを取得する

新しいグーグルドキュメントのスプレッドシートを作成する。

URLを設定する。

基本のxpathの関数を作成して、ページのH1を取得する(スクリーミングフロッグ、または、サイトのクロールを介して同じ作業を行うことが出来るが、分かりやすい例を紹介するため、この方法に拘っていく)。

importxml関数をセルB2に加える。

URLが存在するA2を参照している点に注目してもらいたい。

クエリは引用符で囲まれる。

次にxpathは返されるファイルの部分を特定する。//h1は、ページのh1を含む全てのコンテンツを返す(これは“//”のパーツによる命令であり – どれだけレベルが深くても、あるいは、どれだけネストされていても、全てのh1“path”を求めることが出来る)。

次のアイテムが返される:

これで投稿のH1をグーグルドキュメントに引き出すことに成功した。次に、グーグルドキュメントのimportxmlにおいて、有意義な例を幾つか挙げていく。

2. ImportXML – クオラ/ツイッター

次にクオラを使って、ツイッターのURLにおいて影響力の強い、あるいは、権力を持つ可能性のあるユーザーを調達する方法を伝授する。

以下に最終的な結果を表示する。この結果を目指して、これから作業を進めることになる:

ステップ 1 – グループまたはトピックを探す

この例ではブログのトピックを取り上げる - http://www.quora.com/Blogging/followers

ステップ 2 – カラムAにクオラのURLを入力する

カラムBで実行されている関数の中で、このセルを参照する。

ステップ 3 – importxmlの関数を作って、ユーザー名を取得する

関数を以下に挙げる:

=importxml(A2, “//h2/a/@href”)

コードを理解し、作りやすいように、関数を分解していく。

- =importxml() 空の関数

- A2 クオラのURLを参照する“URL”フィールド

- //h2 このURLの全てのh2を参照する

- /a h2内にネストされたタグを参照する

- /@href アンカータグに含まれるリンクのみを参照する

ご覧のように、この関数はブログのトピックの上位20名のユーザーをリストアップする。

ステップ 4 – 完全なURLを作成する

既にお気づきかもしれないが、クオラは相対URLを使ってリンクを張るため、絶対URLにコンバートする必要がある。

シンプルにconcatenate関数を利用する:

因みにconcatenate関数を念のために掲載しておく:

=CONCATENATE(“http://quora.com”,B2)

このコードも分解していく。

- =CONCATENATE() 空のconcatenate関数(複数の文字列を一つにまとめる)

- “http://quora.com” クオラURLの出だし(別のセルを参照しない場合、すべて引用符で囲う必要がある)

- B2 不完全なユーザーのURLを持つセルを参照する

この作業を終えたら、今度は数式を掴み、カラムの残りに引き下げていく:

ステップ 5 – ツイッターのURLを取得する

最後の仕上げとして、ツイッターのURLを取得する。

以下に関数を掲載する。長いので区切って一つずつ説明していく:

=ImportXML(C2,"//div[contains(@class,'profile_action_links_section')]//a[contains(@href,'twitter.com')]/@href")

- =importxml() 空のimportxml関数

- C2 参照している完全なクオラのプロフィール

- //div HTML内のdivタグを参照する

- [contains()] divタグを絞り込む

- (@class,’profile_action_links_section’) ここではclassの要素を選択している

HTML内のクオラのコードのスクリーンショット:

- //a[contains(@href,’twitter.com’)] ツイッターへのリンクを含むアンカーテキストを選択する

- /@href アンカーテキスト内のリンクを実際に取得する

忘れずに数式をつかみ、カラムの残り全てに引き下げよう。

これで、20名のツイッターのユーザーを1度に取得することが出来るようになった。これは技術的なガイド(How To)であり、このリストをどのように使うかに関しては、皆さんの判断に任せる。きっと様々な用途が浮かび上がるはずだ :-)

3. キーワードのアイデアを得るために Ubersuggestを取得する

- グーグルドキュメントのスプレッドシートを新たに作成する。

Create > Spreadsheetの順にクリックする。

- セルA1で、Ubersuggestで質問したいことを入力する。

この例では、“how to …”を入力し、クエリを始めている。

- セルA2に次の数式を入力し、Enterを押す。

=ImportXML("http://ubersuggest.org/?query="&A1& "&format=html&language=English%2FUSA&source=web&submit=Suggest", "//li/span") スプレッドシートがUbersuggestの答えで埋まる:

スプレッドシートがUbersuggestの答えで埋まる:

4. ウェブページのリストでHTMLを探す

一度に100(または100以上)の候補のサイトを手っ取り早く探し出す方法をこれから紹介する。高額なリンク発見ツールを使って、この取り組みを行うことも出来るが、予算が少ないなら、または、ツールの数を減らしたいなら、この方法は大いに役に立つだろう。しかも、とても簡単であり、また、楽しいと言うメリットもある。

この方法は、コンテンツの一部ではないリスト – つまりコードでHTMLを探している際に役に立つ。この例では、‘rel=author’タグを探していく – この作業には2つの意図がある。まず、ウェブサイトのオーナーは、わざわざ時間を割いてこのタグを設定するくらいなら、マーケティングの観点から見て、出来るだけ上の方に陣取ろうとするはずである。次に、ウェブサイトのオーナー(または助っ人)はある程度の技術的なスキルを持っていると考えられ – 協力を容易に要請することが出来る可能性がある。

これから挙げていくステップに従ってもらいたい:

1. グーグル検索を幾つか考える。

2. 結果を取得する。

3. スクリーミングフロッグを使って、リストの特定のコードを探す。

ステップ 1. グーグル検索

リンクを獲得することが出来る可能性のあるサイトのリストを手に入れたい。ここでは、食べ物をテーマにブログを運営しており、ゲスト投稿を行うため、他のブログを探していると仮定する。次のような検索を実行することが考えられる:

food inurl:blog intitle:submit post

food inurl:blog intitle:contribute post

あるいは、キーワードを使ってさらに具体的な検索を行う手もある:

gourmet food inurl:blog intitle:submit post

eclectic desserts inurl:blog intitle:submit post

良質な検索を実施すると、結果内に複数のサイトの候補が表示されるはずである – 多過ぎても良くない。例えば:

手始めに上のクエリから取り掛かることを薦める。

2. グーグルの結果からURLを取得する

グーグルの結果をテキストドキュメントにまとめ、スクリーミングフロッグを実行する準備を整える必要がある。

1. 準備段階として、1つのページにつき100点の結果を返すようにグーグルを設定する。

検索の設定にアクセスする。

ページあたりの表示件数を100に設定する

グーグルに戻り、再び検索結果を表示させる。

次にSERP Redux ブックマークレットを使う – リンクをクリックする。

URLのリストをクリップボードにコピーする。

テキストエディタに貼り付ける。

.txtファイルとして保存する。

3. スクリーミングフロッグを介してURLを絞り込む

1. スクリーミングフロッグをリストモードに設定する。

2. テキストファイルを選び、開く。

3. Custom設定にアクセスする。

4. 絞り込むHTMLを入力する。

この作業を実施する方法が鍵を握っている。

次の4つのリストを作成する:

- rel=authorを含む

- rel=authorを含まない

- rel=meを含む

- rel=meを含まない

5. カスタムの結果を見る。

‘custom’タブをクリックする – すると、フィルター1-4を選択することが出来るようになる。

このケースでは、リストにはrel=authorを持つブログは1つしか存在しなかった。それで問題はない。と言うよりも、むしろその方が良い。全ての結果を確認して、オーサーシップを持つ結果を探す作業を想像してもらいたい。これで、ターゲットが絞られた候補のサイトを1つ手に入れたことになる – このプロセスを実施して、さらに多くの候補のサイトを見つけることが可能だ。

5. Citation Finderを使って、リンクを張る機会を探す

このセクションでは、有料ツールの利用方法を紹介する。無料バージョンも用意されているものの、全ての機能を利用することが出来るわけではない。ただし、このセクションで取り上げている作業に関しては、恐らく、無料バージョンでも足りるだろう。因みに、私はこのツールのアフィリエイトに参加しているわけではない。

作業を始める前に、 - https://www.whitespark.ca/local-citation-finder/にアクセスし、無料版または有料版のアカウントの登録を行う。

パート 1 – 検索(プロジェクトなし)

一つ目のタブをクリックし、個人情報をフィールドに入力していく。

数分間待つ:

レポートの準備が整うと、eメールの通知が送られてくる:

すると次のようなレポートを見ることが出来るようになる。「compare citations for these businesses」をクリックする。

その後、csvとしてレポートをエクスポートする。

エクセルファイルとして開き、保存することが出来るようになる – これから、どのサイトが最もサイテーションを得ているのかを容易に判断することが出来るように、少しカスタマイズを加えていく。

次のエクセルの数式を利用する:

=COUNTIF(A2:A111,"*Y*")

このように表示される(カラムBにカーソルを合わせている場合):

全てのアイテムをカウントするため、横方向にドラッグする:

もちろん、オートフィルタをかけ、YまたはNだけを見ることも出来る:

パート 2

パート 1は、一般的な候補を探す上では役に立つが、レポートに含まれていない場合はどうすればいいのだろうか?「search by phone number」機能を利用すればよい。

自分の電話番号、または、会社の名称(電話番号が最も有効であり、肩書きによる検索は難しい)を利用することが出来る。

情報を入力していく。このレポートをプロジェクトに加える:

忘れずにプロジェクトを作成してもらいたい。

生成されるレポートには、キーワードにとらわれないサイテーションのソースが全てリストアップされる。

小さな+をクリックすると、サイテーション(通常は電話番号を意味する)付きのページを見ることが出来る。

データのエクスポートに関しては、複数の選択肢が用意されている:

Re-run and append – 同じレポートを再び実施し、以前見つからなかった新しい結果を加える。

Export CSV – データをエクスポートする。ウェブサイトの名前のみが表示され、URLは表示されない。

Export CSV w/URLs – フルレポートでURL(+をクリックすると表示される)が表示された状態でエクスポートする。

6. eメールアドレスを取得する

データ取得のこのセクションでは、Citation Labs Contact Finderを利用する - http://citationlabs.com/tools/ - 始める前にアカウントを作成する必要がある。

候補のURLのリストを持っている場合、このツールはとても役に立つ – 接触する上で必要なeメールアドレスを速やかに手に入れることが出来る。

パート 1 – URLを集める

(このガイドを参考にして)候補のURLリストを持っているか、あるいは、リストを要領よく手に入れられる方法を心得ていると仮定して、話を進めていく。

この例では、取得したグーグルのURLのリストを利用する – 私が食べ物をテーマに取り上げるブロガーであり、レシピを投稿する機会を狙っていると仮定する。その場合、次のような検索をかけることが考えられる:

recipe inurl:submit

検索を実行したら、Contact Finderにアクセスする。

次にフォームに記入する。

通常のエクスプレッション(regex)を使って、結果を調整することが出来る。例えば、このエクスプレッションは:

^(Contact|About|Email|Submit)

contact、about、email、または、submitで始まる結果を求める。

私ならアンカーテキストをワード数で限定しないようにする。

Contactsタブをクリックして、結果を取得する(処理に数分間要することもある)。

ご覧のように、幾つかの種類の結果が存在する:

- Emails – 見つかったeメールアドレス。

- Forms – 見つかった投稿用フォーム

- Contact Pages – eメールアドレスが存在しない連絡先の情報を持つページ。

- Empty – 該当ゼロ。

次に、個別のレポートまたは全てのレポートをCSVにダウンロードすることが出来る。

ご覧のように、100本のURLの中から、次のアイテムを獲得している。

- 38点のeメール

- フォームを持つ47本のURL

- 7つのコンタクトページ

- 該当ゼロは8本ページのみ

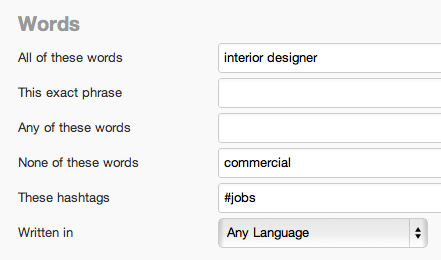

7. ソーシャルリスニング – ツイッターの高度なデータ収集

別のツールで検索を設定する前に、まずはフォローするべき高度な検索のリストを策定する必要がある。

インテリアの装飾をテーマに取り上げていると仮定する – その場合、出来るだけ多くのバリエーションを持たせるべきである – キーワードリサーチと基本的にほとんど変わりはない。

- interiordecorating

- interior decorating

- #interiordecorating

- interiordesign

- interior design

- #interiordesign

こののワードが中心的なワードになる。次に意図を判断するためのワードのリストを手に入れる:

- need(必要)

- help(助け)

- trouble(問題)

- looking for

- tips(アドバイス)

- question(質問)

特定の場所をターゲットにする場合:

- Los Angeles

- CA

- California

- LA

ブランドも忘れずに(私の場合):

- Quicksprout

- neil patel

- kissmetrics

- kiss metrics

- crazy egg

- crazyegg

- i’m kind of a big deal

このようなキーワード、そして、検索の組み合わせを行うと、キーワードの言及を全て拾い集めることが出来る。具体的なユーザーをモニタリングする方法は後ほど紹介する。

次のURLで自分で検索を作成し、テストすることが可能だ: https://twitter.com/#!/search-advanced

過去12-24時間以内の複数の結果を入手することを目標にしよう。

IFTTTのレシピを作成する

次に、モニタリングしたい検索が見つかったら、IFTTTのレシピを作り、実行させることが出来る。IFTTTの長所は、様々なプラットフォーム全体で通知を受けることが出来る点である。それでは、アラートが動作する際にeメールまたはテキストメッセージを送信する設定を紹介していく。

注記: 結果の頻度が少ない場合、とりわけ有効である。

アカウントを作成し(無料)、新しいレシピを作成する。

「trigger」としてツイッターを利用する。

「New tweet from search」を選択する。

検索のフィールドに記入する – 単純な検索なら、プレーンテキストを利用することも可能だが、高度なオペレータを利用する必要があるケースが考えられる。

「Action」チャンネルとして、eメールまたはGメールを選択する。

フィールドに記入し、必要に応じてカスタマイズする。

テキストメッセージを受信したい場合:

「Action」としてSMSを選択する。

フィールドを設定する。

後はeメールが届くのを待つだけだ。

おまけ: eメールのフィルターを設定する

情報収集の取り組みGメールのフィルタリング機能を使って、さらにレベルアップさせることが出来る。フィルターを作成し、フォルダーに全てのアラートを送信する:

高度なツイッター検索のシンタックス

幸いにも、ツイッターの高度な検索を生成するツールを利用すると、代わりに検索を考えてもらえる:

次のURLにアクセスし: https://twitter.com/#!/search-advanced 検索を実行する – 結果にはオペレータ付きの検索シンタックスが含まれるはずだ:

![]()

ツイッターでインフルエンサーの声に耳を傾ける

インテリアデザインの分野の例を再び取り上げる。今回は、ブログを運営しているインテリアデザイナーとのつながりを増やしたいと仮定する。いつ、助けを必要としているのかを把握しておきたいところだ。

まず – followerwonk等のツールを使って、情報を集めることが出来るユーザーを探し出す: http://followerwonk.com

次に、手を貸すことが出来る点を誰かがメンションすることを考慮し、高度な検索を作成する。コンピュータのエキスパートなら、次のような検索を利用することが出来るのではないだろうか:

ターゲットの人物は、1年に1度しかツイートを投稿していないかもしれないが、大物とのつながりを作ろうとしているなら、IFTTTのレシピを作成し、テキストメッセージを介して、当該の人物が助けを必要としている時に、通知してもらう価値はあるはずだ。

ここでも、ツイッターの検索ページで検索を実行すると、検索に対するシンタックスを提供してもらえる。

Monitterを使って追跡する

Monitterは、特定のキーワードが含まれる大量のツイートをチェックすることが出来る、優れた無料のツールである。ツイッターのリアルタイムモニターと言っても過言ではない。

http://monitter.com にアクセスし、アカウントを作成する。

検索の用語を使って、カラムを作成する。

![]()

ここでは、4つのインテリアデザインの検索に対して、それぞれストリームを用意した:

次に特定の場所からのツイートを追跡する高度な設定を行う。

返信するべきツイートを見つけたら、Monitterから直接行動を起こすことが出来る。

その他のツイッター用ツール

他にもツイッターをモニタリングするためのツールは数多く開発されている。

http://ifttt.com - 複数のオンラインプラットフォームを一つにまとめ、作業を自動化する。

http://monitter.com/ - 複数のカラムを設定し、ツイッターの検索をリアルタイムで追跡する。

http://tweetmeme.com/ - 共有されることが多い、人気の高い記事を調べる。

http://trendsmap.com/ - 特定の場所でトレンドになっているアイテムを確認する – 役に立つビジュアルツール

http://tweetbeep.com/ - ブランド、自分、または、他の何かに関する全てのメンションをeメールで通知する(IFTTTに似ている)。

http://needium.com/ - 検索とメンションをモニタリングする。

8. ブラウザ用プラグイン

ブラウザプラグインは、作業をスピードアップし、効率を高める上で大いに役に立つ。このセクションでは、グーグルクローム用のプラグインを幾つか紹介し、また、プラグインの高度な利用方法を少し指南する。

ブラウザプラグインのセクションでは、サイトのアクセシビリティ & インデクセーションの最適化に貢献するプラグインを紹介する。

まず、プラグインのリストを提供する。

- Broken Link Checker - https://chrome.google.com/webstore/detail/ojkcdipcgfaekbeaelaapakgnjflfglf

- Web Developer - http://chrispederick.com/work/web-developer/

- Redirect Path Checker - https://chrome.google.com/webstore/detail/aomidfkchockcldhbkggjokdkkebmdll

- SEOmoz Toolbar - https://chrome.google.com/webstore/detail/eakacpaijcpapndcfffdgphdiccmpknp

- Chrome Sniffer - https://chrome.google.com/webstore/detail/homgcnaoacgigpkkljjjekpignblkeae

- Google Analytics Debugger - https://chrome.google.com/webstore/detail/jnkmfdileelhofjcijamephohjechhna

- Microformats for Chrome - https://chrome.google.com/webstore/detail/oalbifknmclbnmjlljdemhjjlkmppjjl

- Rulers Guides and Eyedropper Color Picker - https://chrome.google.com/webstore/detail/bjpngjgkahhflejneemihpbnfdoafoeh

- Word Count - https://chrome.google.com/webstore/detail/kmndjoipobjfjbhocpoeejjimchnbjje

- Source Kit - https://chrome.google.com/webstore/detail/iieeldjdihkpoapgipfkeoddjckopgjg?hl=en-US

これから、幾つかのプラグインの高度な利用法を伝授していく。

Broken Links Checker

このプラグインは、自分のサイトのリンク切れを発見することが出来るだけでなく、創造力を発揮して、他の人のサイトで実行し、リンク構築 & リンク候補の調査においてアイデアを得ることも可能である。

例えば、競合者のウェブサイトのサイトマップでこのプラグインを実行してみる。以下にその方法を紹介する:

1. 競合者のサイトのHTMLサイトマップを探す。この例では、適当に www.bizchair.com を利用した。サイトマップは次の通りである – http://www.bizchair.com/site-map.html

2. Link Checkerを実行する

エクステンショのアイコンをクリックする。

リンク切れが見つかるまで待つ – この例では、多くのリンク切れが見つかった。

「resource」ページにすぐに気がつくはずだ。楽にリソースのコンテンツを再現し、リンクを獲得するためにこのプラグインを利用することが出来る。

Chrome Sniffer

このプラグインは、自動的にウェブサイトが利用しているCMSまたはスクリプトのライブラリを表示する。例えば、ワードプレスのサイトのオーナーのみに接触したい場合、非常に便利である。

ウェブを閲覧していると、URLの右側のアイコンが利用されているCMSまたはスクリプトのライブラリに応じて変化する。

例えば、私のサイトはワードプレスで構築されていることが分かる。

このサイトはドルーパルをベースにしている。

Redirect Path Checker

このプラグインは、リダイレクトに遭遇すると、ユーザーに通知する。特に自分のサイトを閲覧している時に利用すると、古いURL(または外部のサイト)に内部リンクを張っている際に教えてもらえるため、とても便利である。

例えば、私のサイトでは、ギズモードの302リダイレクトにリンクを張っているリンクを発見した:

なぜ分かったかと言うと、プラグインから302に関する通知を受けたためだ。

このアイコンをクリックすると、ブラウザが当該のページに導く上で利用したリダイレクト(あるいは一連のリダイレクト)を表示する。

SEOmoz ツールバー & プラグイン

Mozのプラグインは様々な用途に利用することが出来る。その中でもより高度な方法を幾つか紹介していく:

リンクがfollowedかnofollowedかを速やかに特定する。

または、ウェブサイトの国およびIPアドレスを見つける。

9. プロキシの利用

プロキシとは何だろうか?また、なぜプロキシを利用するべきなのだろうか?

プロキシは、ユーザーとサーバーの間の仲介役のような存在である。要するに、プロキシを使って、ウェブ上で匿名で行動することが出来る。自分のIPアドレスではなく、プロキシのIPアドレスが表示されるためだ。これは、Rank Tracker等のローカルのソフトウェアを使ってランクキングをチェックしている場合、とりわけ有用である。自動でグーグル検索を何度も行い、当該のロケーションのランキングをチェックしていると、グーグルに危険信号を送ってしまうリスクを背負うことになる。プロキシを非倫理的な方法で利用している人達がいるが、私はこのような方法を推奨しているわけではない。しかし、自分のIPアドレスから、普段とは異なるアクティビティをグーグルに送ることなく、ランキングをチェックする方法として、うってつけである。

それでは、プロキシを利用する方法を伝授していく。多くの無料のプロキシアドレスを一度に見つけるあまり知られていない方法を私はマスターしている。

ステップ 1: 次のURLにアクセスする: http://www.rosinstrument.com/proxy/

無料の公開されたIPアドレスのリストが表示される。このリストは頻繁に変わるため、しばらくこの画面を開いていたなら、更新する必要がある。

ステップ 2: プロキシをScrapeboxにコピペし、テストする:

これは魔法のような効果をもたらす。プロキシのアドレスは、すぐに、そして、頻繁に利用することが出来なくなるため、全てのアドレスを一つずつチェックしていると時間を無駄に使ってしまうことになる。

「Manage」、次に「Test」をクリックする。数分後、プロキシのテストが終了する。続いての手順では、無駄のないリストを作成し、プロキシを選択していく。

ステップ 3: 良質なプロキシをメインのリストに戻す

「Export」の下の「Transfer Good Proxies to Main List」を選択する。すると、有効な無駄のないプロキシのリストが表示される。

ステップ 4: プロキシのアドレスをランキングをチェックするソフトウェアにコピーする

Rank Trackerでは、次のようにプロキシのアドレスを入力することが出来る:

しばらくするとアドレスは利用することが出来なくなるため、リストを再びテストし、次のURLからさらにコピペすることを薦める: http://www.rosinstrument.com/proxy/

おまけ: プロキシの代案

上述した方法は無料であり、それが最大のメリットである。しかし、もっと安定した取り組みを求めている場合は、バーチャルプライベートサーバー(VPS)を手に入れるとよい。大半のウェブホスティングサービスは、VPSを用意しているはずだ。これは、自分専用のIPアドレスを持つようなものだ。多少の料金を毎月求められる可能性もあるが、公開されているプロキシよりも強固であり、手に入れる価値はあるかもしれない。

既に究極のデータ収集マニアになっているはずである。しかし、まだ続きはある。次のチャプターでは、あまり利用されていないキーワードリサーチの方法を紹介する。

この記事は、Quick Sproutに掲載された「Chapter 5: Advanced Data Research」を翻訳した内容です。

データ・インフォームドとデータ・ドリブンの違い

メトリクスは、あなたが整備することができる製品戦略の反映にすぎない

データが強力なのは、それが実体を伴うだからだ。多くの起業家にとって、実験データは、他の何にも―ベストプラクティスや、素晴らしい教育と肩書を持つ人にも―勝る。そして、それには正当な理由がある。それはまさに、疑い深い人の持つ最高の武器で、スタートアップが新しく革新的な方法で問題を解決するのを助ける重要なツールなのだ。

深入りするのは簡単だ―それが、“データ・インフォームド”と“データ・ドリブン”の区別だ。私が最初にその話を聞いたのは2010年のFacebookの講演だった(この記事の下に埋め込んだ)。結局のところ、メトリクスは、あなたがすでに持っている製品戦略の反映にすぎない。それは、既存の製品がどう機能するかということや、既存オーディエンスを基にあなたがすでに築いたものに基づいているにすぎず、自ずと限りがある。データ・インフォームドであるとは、成功する製品を築くために必要な情報のほんの一部分だけを持っているということをあなたが認識していることを意味する。最終的には、それらのデータを元にあなたの製品が、他の新しいオーディエンスをターゲットにすることができたか、または全く異なる優れた機能を備えることができたかなのだ。データはあなたがすでに築いたものに基づいたスナップショットを基に作られ、一般的には、あなたは1回に2~3個の変数を変えることができるが、それは限られている。

これは、あなたは極大に向かったイテレートの方法を知っているが、最大の市場で最高の結果を得る方法を理解するための十分なデータを持っていないことを意味する。

データを謝って必要以上に簡略化することがないようにすること

つまり、データ・インフォームドとデータ・ドリブンの違いは、私の考えでは、あなたが何千もの継続して変化する変数を使って解決している厄介な問題の1つの欠片として、データを比較検討できるかということだ。データは実体があるが、時々、統計的に見方が偏る。全てが最適化問題ではないため、それは適切なツールでもない。そして、自分の意思決定を今測定できることだけに任せることは、より重要な問題のマクロの側面をしばしば後回しにする。

データ・ドリブンのアプローチが弱い意思決定を招くいくつかの点を検証しよう。

データは、時に統計的に偏りすぎることがあり、気づかなければその代償は大きい

データ・ドリブンであることの最初の問題は、あなたが集めることができるデータは、その性質上、固定できない形で統計的に偏ってしまうことがよくあるということだ。

以下の条件が満たされる時にはデータを集めるのは簡単だ:

- データを集めるための多くのトラフィック/ユーザーを持っている

- データを素早く集めることができる

- 何が良くて何が悪いかの明確なメトリクスがある

- 自分が持っている製品(持ちたいと思っている製品ではない)を使ってデータを集めることができる

- 費用がかからない

このような種類のデータは、ホームページ上のサインアップ率のようなことに適している。それらは、サイトの最も訪問者の多い部分であることが多く、明確なメトリクスがあるため、数日間実験を行ってデータを素早く回収することができる。

対照的に、長期保持率を測定したいのなら、それはもっと難しい。もしくは、ユーザー体験の長期的認知や、重要だがニッチな機能(アカウント削除など)の影響力を測定しようとする場合もだ。これらは全て、ものすごく難しい。なぜなら、長い時間を要するか、お金がかかるか、集めるのが不可能なデータポイントであるからだ―人々は、1か月以上の保持率がどうなのかを見るために1か月も待てない。

にもかかわらず、これらのメトリクスは、時に最も重要な解決すべき存在でもある。

さらに悪いことに、“データ・ドリブン”の考え方を持って、長期的な保持率に対するサインアップ率のような具体的なデータポイント間でメトリクスをトレードオフしようとするケースを検討するのだ。データの役割に関してあなたがよりマクロな賢明な視点を持たない限りは、保持率が勝利を収めるのは難しい。短期対長期のトレードオフは、浅いデータではなく深い思考を要するのだ!

全てが最適化問題ではない

もっとマクロレベルでは、最も重要な戦略的問題は最適化問題ではないことに注意しなくてはいけない。最初から、つまりあなたが製品を選択する時から始めよう。例えば、あなたは、消費者もしくは法人もしくはSBMをターゲットとした素晴らしいビジネスを築くことができる。同様に、あなたは、ウェブ先行(Pinterest)もしくはモバイル先行(Instagram)のビジネスを築き、どちらも成功することができる。これらは、マーケットサイズやモバイルの成長のような一般的なパラメーターを感じるにはいいかもしれないが、最終的に、それらは、あなたが満足する決断をすることが重要なとても大きな市場なのだ。これらのケースの場合、あなたはデータ・インフォームドになることが強いられるが、データ・ドリブンになることは難しい。

これらのタイプは、イノベーションのジレンマの中で議論されているように、破壊的イノベーションを業界が経験している時に、質問が特に重要となる戦略だ。この本の中で、クレイトン・クリステンセンは、成功を収めて1つのエリアで大きな収益ベースを築く会社のパターンについて議論している。彼らは、コアビジネスを10%増やすことの方が同じことをするために新しいビジネスを作るよりも大抵簡単であると気付くが、この考え方が次第に彼らの崩壊を招く。これは、メインフレーム対PCから、ハードウェア対ソフトウェア、デスクトップ対ウェブ、今ではウェブ対モバイルと、テクノロジー業界で何度も起こった。現職者は自分が考えていることは正しいと思ってやっている―既存顧客ベースの話を聞き、1パーセント基準から収益を増やし、一般的には最もデータ・ドリブンなことをしようとする。しかし、業界がどのように進化し改善するのかのビジョンを持たなければ、大企業は次第に破壊される。

直ちにデータを活用する

戦略的だろうと戦術的な問題だろうと、同じようにデータを活用することが重要だ。自分がしようとしていることに対してビジョンを持つこと。正当性を認証してあなたがそのビジョンをしっかりと進む手助けするためにデータを使用し、それをあなたがデータ・インフォームドのやり方で実行し始めることができるほどに小分けする。たまたま安く/簡単に/早く集まったデータの浅はかな分析によって、あなたの起業家的探究心からそれないようにすることだ。

データ・インフォームド対データ・ドリブンに対するFacebookの考え方

最初にこの記事をインスパイアしたアダム・モセリによるFacebook動画を紹介する。彼は、複数の写真アップロードの例を使用し、どのようにワークフローを最適化するためにメトリクスを使用するかを説明している。以下に埋め込んだ動画を見るか、YouTubeで見よう。

この記事は、@andrewchenに掲載された「Know the difference between data-informed and versus data-driven」を翻訳した内容です。

Googleアナリティクスとワードプレスを使ってエンゲージメントを計測する方法

ブログを運営し、優れたコンテンツを配信している自信があっても、エンゲージメントには手が届かないように思える。良質な記事を作成すると、高く評価してもらい、ツイートしてもらい、共有してもらい、そして、+1してもらえる – しかし、実際にコンテンツはどのぐらい読んでもらえているのだろうか?

グーグルアナリティクスで、キーワードがコンテンツにビジターを導く仕組みにおける、検索およびキーワードの領域を理解したら、次の段階に進むべきだえる。ページから検索結果へすぐに戻るユーザーの行動(直帰)は、グーグルにマイナスのイメージを与えると考える人達は多い。当該のユーザーは、事実上、サイトにマイナス票を投じ、「クエリを入力した際、このページを求めていたわけではない」と発言していることになるためだ。

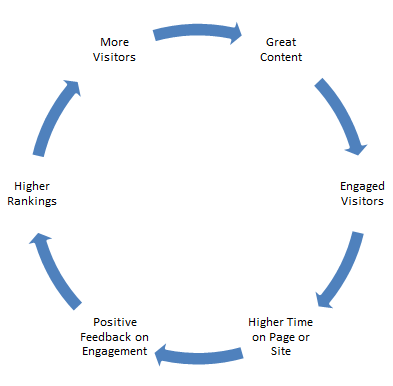

この考えが正しく、また、私も同意すると仮定すると、ユーザーの行動を調査して、直帰率を削減する取り組みは、特定のフレーズに対して上にランク付けしてもらう確率を高める方法として、有効だと言えるだろう。上位のランクとユーザーを満足させるコンテンツを合わせると、目標達成につながる。次のようなサイクルで、この取り組みを実施することが出来る。

ビジターはどれだけの間ページにとどまり、実際にどの程度スクロールしているのだろうか?今回は、コンテンツのページに関するビジターのエンゲージメントを計測する上で、私が持っているアイデアを幾つか検証していきたい。

まず、優れたコンテンツを持っている必要がある。3-4つのキーワードフレーズを含む300ワードのコンテンツを作ることに苦戦し、ユーザーがページに到達した後の行動などどうでもいいと考えているなら、優れたコンテンツを重要視しているとは言えない。一方、読者を没頭させ、読者や顧客としてビジターを維持することを考慮して、コンテンツを作成しているなら、この記事を読み進めていってもらいたい。

グーグルアナリティクス

グーグルアナリティクスを使って、ページのエンゲージメントを測定する方法には、簡単な方法と難しい方法がある。最も容易なのが、イベントの測定である。しかし、求めるイベントを実装し、発動する方法には、簡単な方法と複雑な方法の2種類がある。

スクロールの深さ

ユーザーがスクロールする、または、特定のポイントを通過することで、イベントを発動するように設定することが可能である。確かに素晴らしいアイデアだが、私自身は、ワードプレスのプラグインを使わずに、この方法を実施したことはない。だからと言って、不可能と言うわけではい。私のようなコーディングの初心者が実装するには複雑過ぎるだけである。

このタイプの計測をワードプレス以外のサイトに実装したいなら、ジャスティン・カトロニ氏が投稿した記事 ? そして、Savio.noのこの記事に目を通してもらいたい。この2本の記事は、手順ごとに設定方法を説明している。一方、ワードプレスを利用しているなら、運が良いと言える。その訳をこれから説明する。

イベントの評価

シンプルなサムズアップ、または、サムズダウンによる評価を行うボタン(駐:親指を上げている・下げている評価ボタン)をコンテンツの最後に加えるのは、良いアイデアだと思う。星評価システムを加える手もある。読者がボタンまでスクロールダウンし、いずれかのボタンをクリックした場合、グーグルアナリティクスのダッシュボードでイベントがトリガーされる。こうすることで、少なくともページをスクロールダウンした点は分かるようになる。

また、読者が気に入ったコンテンツと気に入らなかったコンテンツを知る上でも役に立つ。ただし、この評価を得るのは容易ではなく、総合的なサンプルの票を得られるように、十分な量のトラフィックが必要になる。

コンテンツのページネーション

これは、コンテンツを提供する方法の中で、個人的に一番嫌いな方法かもしれない。多くの大規模なニュース/マガジンサイトは、この方法を採用している。この方法は、直帰率が低く、「1回の訪問当たりのページ数」が多いことをアピールして、広告料金を高く設定するために用いられているはずである。とは言ったものの、記事の「ページ 2」にイベントの計測を設定することで、ページ 1の一番下まで、何人のビジターが目を通したのかを把握する上で目安になる。

ページ解析

この機能は、グーグルアナリティクスのヘビーユーザーの間でもあまり利用されていない気がする。確かに初めて公開された際、ページ解析機能は質が低く、あまり役に立たなかった。当時と比べると、この機能は大幅に進化している。ただし、注意するべき奇妙なポイントがまだ幾つか残っている – 見ているページから、複数本のリンクが同じページに向かっていると、このページへの全てのリンクが同じ数字を報告する。

例えば、- ホームボタン、ワードプレスの管理者バーのホームボタン、そして、ヘッダーのロゴは全て私のホームページにリンクを張っているが、それぞれ異なるアプローチで利用されている。しかし、グーグルはユーザーの8.3% – 全て同じ確率 – が、全てのルートを辿ってホームページにアクセスしているとレポートしている。これは、正しい情報ではない。この3つのアイテムが同じページに向かっているため、グーグルは、クリック数を合計しているだけである。この点に関しては修正してもらう必要があるが、それだけでこのツールを役立たず呼ばわりするべきではない。

例えば、ページ解析のおかげで、ページの右上のソーシャルメディアリンクが全く利用されていないことが分かった。そのため、エンゲージメントを促すために、この要素のデザインを変更する必要がある。クリックされていないと言うことは、誰も利用していない。そのため、対策を講じる必要があるのだ。

ワードプレス

ブログを作成し、アップデートするために利用することが可能な様々なプラグインやコンテンツ管理システムが存在するものの、私はワードプレスのみを利用している。ドルーパルやジュームラを利用しているなら、申し訳ないが、これから提供するアドバイスは役に立たない。私はコンテンツエンゲージメントを計測する上で有効な優れたワードプレスのプラグインを発見した。そのうちの幾つかは、グーグルアナリティクスのイベントセクションで計測値をレポートしてくれる。しかも、全て無料で利用することが出来る。

グーグルアナリティクススイート

グーグルアナリティクススイートプラグインは、グーグルアナリティクスとグーグルアドセンスのアカウントを結びつけ、ページビュー、スクロール量、ページ速度、ダウンロード、そして、アドセンスのリンクをイベントとしてレポートする。簡単に設定することが可能であり、グーグルアナリティクスのカウントに容易に引っ張り込むことが可能だ。

以下のイメージには、このプラグインをインストールした数時間後のイベント計測のスクロールに関する情報が掲載されている。これで、読者がページをどこまでスクロールダウンしているかが分かる。また、このデータをリアルタイムで閲覧することも可能である。

グーグルアナリティクスプラグイン- Yoast

Yoast de Valk氏が開発したこのグーグルアナリティクスのプラグインを私は愛用している。インストールおよび設定が容易であり、様々なイベントのレポートを提供してくれるからだ。ジャスティン・カトロニ氏は、ブログの中で、このプラグインを使って、スクロール量をイベントに実装することが出来ると指摘しているが、今のところその証拠はつかめていない。

このプラグインの長所は、外部へのリンクとアフィリエイトリンクを追跡することが可能な点である。多くのサイトにリンクを張っているなら、「exit page」- ビジターが消えただけ – ではなく「exit link」として計測することが出来る。これはインデックスツール/ヤフー!ウェブアナリティクスがかつて得意にしていた分野であり、グーグルが不得手としている分野である。

また、外部サイトへのクリックをページビューとして計測し、アナリティクスのダッシュボード内の「サイトのコンテンツ」と「すべてのページ」で容易に区別することが出来る。

ユーザーがページをどのように利用しているかを把握することは、ユーザーがページにアクセスしている点を把握することと同じぐらい重要である。レシピを紹介しているのであれ、コンピュータを販売しているのであれ、ユーザーがサイトのページに到達した後、どのような行動を取っているのかを理解すると、ニーズを満たすコンテンツを作成する上で大いに役立つ。

分析せずにユーザーの行動を把握することは出来ない。自分のサイトに合う方法が見つかるまで、上述したメソッドを幾つか、または全て試してもらいたい。ユーザーが没頭するコンテンツのタイプ、そして、ユーザーが読む確率が高いコンテンツの形式を理解したら、より効率良くコンテンツを作成することが出来るようになるはずだ。

PS: コメント欄の指摘によると、私はツールの価値をさらに高める設定のステップを幾つかスキップしていたようだ。

Yoastのプラグインはとても便利だが、本人が、ページビューではなく、外部クリックをイベントとして設定することを薦めている。プラグインの設定で、Advanced Settingsにアクセスし、「Track Outbound Links as Pageviews」(アウトバウンドリンクをページビューとして計測する)ボックスのチェックを外す必要がある。因みに私がインストールした際は、このチェックは外されていた。

また、ページ解析に関して、グーグルは、ランディングページではなく、リンクでアトリビューションを設定する修正を行ったと発表した。そのため、アナリティクスのコードを少し変更する必要がある – このブログの投稿で分かりやすい説明が提供されている。

最後に、この記事で正確な情報を提供する上で貢献して頂いた、SearchEngineManおよびポール・トンプソン氏に感謝の意を伝えたい。

この記事の中で述べられている意見はゲストライターの意見であり、必ずしもサーチ・エンジン・ランドを代表しているわけではない。

この記事は、Search Engine Landに掲載された「How To Measure Content Engagement And Effectiveness With Analytics & WordPress」を翻訳した内容です。