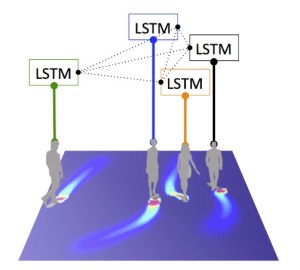

もしシンプルなカメラが捉えた映像を機械学習が分析して、フェンスに近づいてくる人物の警戒レベルを教えてくれるとしたらどうだろう。もし同様にして食料品店の売り場で買い物をしている人の行動を分類できるとしたら?例えば、買う気があるのか、決断停止中か、はたまた探しているものをちゃんと見つけられているのか。画像認識と解析速度の向上のおかげで、単に観察するだけではなく、人間の行動を分類できるスマートカメラはモノのインターネットの次のステップなのかもしれない。

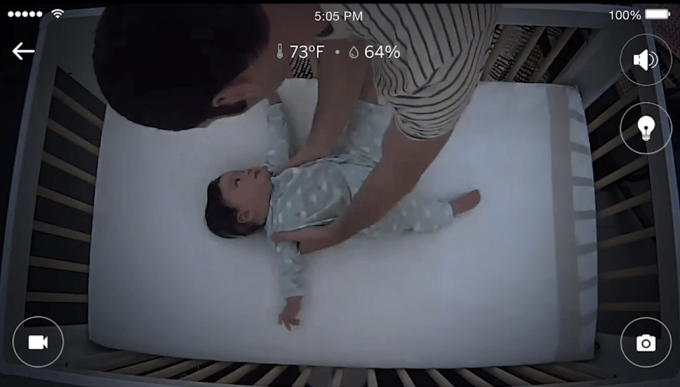

Nanitはそう言った市場に進出した最初の企業の1つだ。Dr. Assaf Glazerは、自分自身が父親でもあるが、彼と彼のチームは親にとって最も大変な仕事の内の1つ、つまり赤ちゃんが夜しっかり寝るようにすること、が少しでも楽になるようにすることを目標に掲げている。

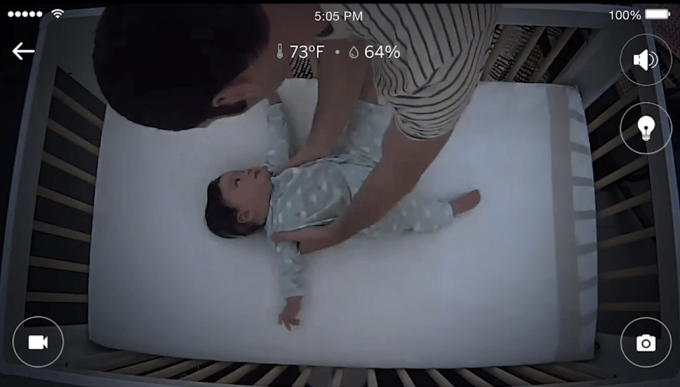

カメラをベビーベッド上に固定するには3オンスのカメラを10.5ポンドのスタンドに取り付ける。アカデミアとコネクションのあるテクノロジー系スタートアップは往々にして、最適なニッチ市場を見つけ出したり一般の消費者にテクノロジーを分かりやすく説明する点で苦労することがある。Glazerは200以上ものデザインを検討し独自性のあるデザインを採用した。睡眠不足の親は装置を充電したり電池を替えたりといったことに煩わされることはない。この低電圧で動く装置に関しては、ただ壁のコンセントに挿すだけで良い。

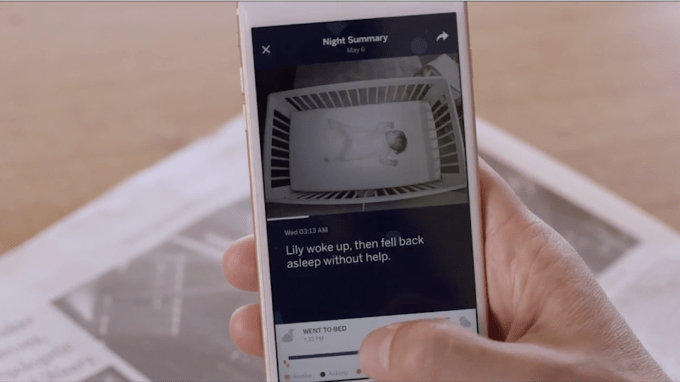

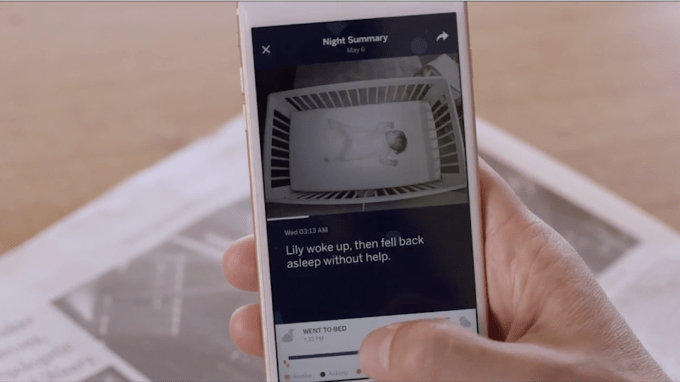

NanitのアプリはオプションのNanit Insightsを付けることで赤ちゃんの睡眠パターンの分析を行い、直感的に理解出来るカテゴリーに分類し、例えば睡眠中の乳児の動きをヒートマップで表示したりしてくれる。残念ながら、そう言った解析オプションを付けない場合は、Nanitはベビーベッドからの映像のライブストリーミングにしか使えない。Nanit Insightsは4つの主要な睡眠測定値について色別に可愛くラベル付けして表示してくれる。それらは、睡眠パターン、親がベッドに来る回数、寝つき、そして睡眠時間だ。

コンピュータ科学的に言えば、Nanitは機械学習を一般家電に応用した点が謳い文句だ。一般にこのような画像解析では、ほとんどの場合で変数の数が膨大になり、行動解析はほとんど不可能となる。幸運にも、Nanitの開発チームにとって、ベビーベッドのマットレスのサイズはほとんどが似たり寄ったりだ。そのおかげで、カメラの変数が標準化できるのでコンピュータはその空間を小さなサイズに分けることで正確な分析が可能になった。

Nanitのベビーモニターの箱を開けると、まず簡単な機械のキャリブレーションをする必要がある。それが終わって一旦カメラをスタンドに設置するとシステムを調整する必要は二度とない。

加えて、Nanitには便利な夜間灯、ホワイトノイズや様々な自然の音を流してくれる装置、ケーブル管理システムが付属する。睡眠以外にも、赤ちゃんモニターは湿度、温度、音、動きを測定、記録可能だ。

Nanitに投資しているのはUpfront VenturesからMark Susterがリードを務め、その他RRE、645 Ventures、Jacobs Technion-Cornell Institute、Flex、Jerry Yang’s AME Cloud Venturesが参加している。同社はこれまでシードラウンドで660万ドルの資金を調達した。

このスマートベビーモニターの市場は活発な状況が続いている。Owlet、MimoやSproutlingなどの会社は乳児用ウェアラブル機器を製造しているが使える部品やセンサーには制約がある。親の多くは自分の子供の服にトータルでアップルウォッチにも相当するものを埋め込もうとは思っていない。また、Dropcamのような装置は行動分析まではしてくれない。Dropcamでできるのはライブ映像を中継してピクセルの情報として他の機器上で表示することだけだ。Nanitのベビーモニターを使えば、新しいセンサーを増設することなく新たな分析機能を追加することが可能な点がとても強力だ。Glazerのゴールは、Nanit Insightsをさらに改良することで、データに基づきその家庭に最適なペアレンティングのアドバイスを提供することだ。

ただ、行動科学に興味がある人はNanitのベビーモニターを面白いと感じるかもしれないが、この装置が親に情報を与えるだけでなくその行動にも影響を及ぼし得るという可能性を考えることはとても重要だ。

Nanitが子育てに良いとされている慣行に影響を与えるかもしれないと考えるきっかけになったのは、子供が一度起きてから再びどれだけ自分だけで寝付くことができるかがNanitで測定可能になったことが発端だ。この知識があれば、子供が起きても、特に必要がなければベビーベッドに急行することはないし、逆にベッドに行ってしまえばさらに子供を起こしてしまうことにつながる。

Nanitは本日よりインターネットによる直販での先行販売を開始する。同社は最初の1万5000台を、消費者の手に届くまでの時間を短縮すべくアメリカ国内で製造する予定だ。その後、生産拠点は国外に移転する予定だ。

先行発売は279ドルでNanit Insights1年間のサブスクリプションを50ドルで付けることができる。先行販売期間終了後はベイビーモニターが349ドル、Nanit Insightsは100ドルとなる。Nanit Insightsのオプションの更新にあたっては30日間考慮する期間が与えられる。

[原文へ]

(翻訳:Tsubouchi)