編集部記:Eric Paleyは、Crunch Networkのコントリビューターである。Eric Paleyは、Founder Collectiveのマネージングパートナーだ。EricはBrontesのCEOで共同ファウンダーを務めた。Brontesは2006年、3Mに買収された。

VCはプロダクトではなく、プラットフォームに投資しているという話を良く聞く。個人的にはその理屈は逆であり、ファウンダーがそのように考えることはとても危険であると思う。プラットフォームは長期に渡る競争有利性をもたらすだろうし、スタートアップがプラットフォームを構築したいと考えるのも分かる。しかし群を抜くプラットフォームのほとんどは、最初は狭い対象に向けた重要なユースケースのために製作した素晴らしいプロダクトから生まれているのだ。

ファウンダーはこのアドバイスを受け入れるのに苦労する。VCはユニコーンになる可能性を秘めたビジネスにしか投資しないと聞いているからだ。彼らは、ニッチなソリューションが投資に見合う金額を生み出すところを想像するのに苦戦する。ファウンダーは自分のスタートアップがプラットフォームになるストーリーを夢想し、解決しなければならない課題から遠ざかるのだ。

プラットフォームとプロダクトの違い

プラットフォーム、ネットワーク、マーケットプレイスと横断的な戦略の議論は多くあるが、これらを用語を定義し、線引きする記事が少ないことに驚かされる。起業家がプラットフォームの理屈を無視すべき理由を説明する前に、これらの異なるコンセプトをできる限り丁寧に定義したいと思う。ただ、この定義で全てを網羅できるとは考えていないし、これらのコンセプトを違うように捉えている人がいるのなら、それについてオープンに検討したいと思う。

プロダクト

プロダクトとはユーザーが排他的に所有する、あるいはアクセスのあるツールやサービスのことを指す。iPhoneやGoProはプロダクトである。Microsoft OfficeやAdobe Photoshopもプロダクトだ。Candy CrushやThe New York Timesのモバイルアプリもプロダクトだ。

ユーザーは一律価格やSaaSの使用料を支払ったり、使用するのと引き換えに広告が表示されたり、最初はいくらか無料で使えたり、アプリ内でサービスを購入したりすることができるが、コンセプトは全て同じだ。ユーザーは購入したり、サインアップしたりすることでそれらを使用することができる。良いプロダクトというものはユーザーにとって実用的なもの、あるいは些細な用途のためでも特定のニーズを埋めることができるものだ。

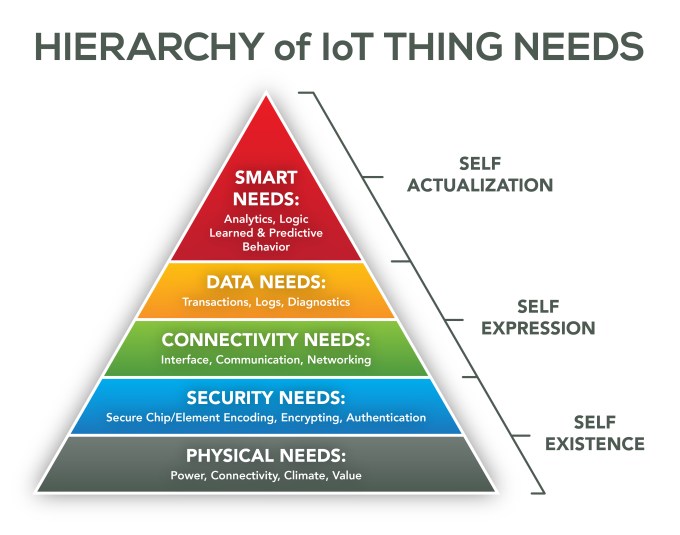

プラットフォーム

Amazon Web Services、iOS、Androidはプラットフォームだ。プラットフォームの違いは、他のユーザーがそこでプロダクトを構築し、収益が得られることにある。プラットフォームの製作者が想像だにしなかったプロダクトがそこから生まれるだろう。プラットフォームはそれらの売上の一部を得る。プラットフォームが利用されるほどコストも比例して増える。

ネットワーク

多くの人は「プラットフォーム」とネットワーク効果を持つプロダクトとを混同している。しかし、これらは全く別のものだ。LinkedInはネットワークであり、後に人材採用のプラットフォームになった。Pinterestは美しい画像のインタレストグラフであり、開発プラットフォームではなかったが、グロースに伴い広告のプラットフォームに変容しつつある。両サービス共にAPIを提供しているが、APIがあるからといってプラットフォームであるとは限らない。

eBay、Airbnb、Etsyのようなマーケットプレイスは、一見プラットフォームのように見えるが、プロダクトのネットワークだ。そこで利益を上げることはできるが、サービスの利用方法は限られているからだ。Airbnbで車を販売したり、eBayで宿泊のために城を借りることはできない。マーケットプレイスの価値はその流動性から生まれるのだ。マーケットプレイスではユーザーはネットワークの上に価値を構築しているのではなく、ネットワークの中で価値を交換していると言える。

これらのサービスに関連するところで価値を構築することはできる。例えば、eBayの有力な販売者に掲載商品の管理ツールを提供したり、Airbnbのホストに清掃サービスを提供したりということだ。しかし、マーケットプレイスはネットワークを構成している者から最も重要な価値を得ている。Airbnbは家の所有者にとっても高層オフィスビルの管理人にとってもプラットフォームではないのだ。

この定義に同意しない人もいることだろう。ここに上げた全ての企業は種類は違えど「プロダクト」を作る企業であるとも言えるからだ。しかし、少なくてもそれぞれの重要な違いを明確にできたと思う。

プラットフォームの話をするVCを真に受けないこと

多くのVCは会社を作った経験もないし、中には起業に挑戦することの意義を完全に理解していない人たちもいる。ファウンダーは重要な課題を解決するスタートアップのアイディアを持っているかもしれない。明確な収益モデルもあるかもしれないが、それでは規模が小さすぎるのではないかと恐れている。ファウンダーはプロダクトを強く打ち出すのではなく、テクノロジーを曖昧な方法でも活用でき、抽象的な要素を組み合わせて数十億ドル規模となる最大市場規模(TAM)に訴求する方法を考える。

VCは何十億ドル規模に成長できるプラットフォームのアイディアを見て、ファウンダーが会社を立ち上げたその日からそれがプラットフォームとして成立することを望む。大きな目標を描くことや将来の会社の姿を思い描くことに何ら問題はないが、VCにはファウンダーの会社はカスタマーが抱えている重要な課題を解決することから始めること、そして時間を追ってプラットフォームに成長する可能性のあるプロダクトを構築するということを理解してもらわなければならない。最も重要なことは、現時点で誰も欲しがらない大げさなプラットフォームを作るという目標に惑わされないことだ。

プラットフォームのロジックが危険なのはそこだ。多くの違うカスタマーに対応できるような広範な機能というのは、誰の役にも立たないということになりかねない。プロダクトマネージャーは小さなカスタマイズで試したとしても、全ての要素において幅を広げることに注意した方が良い。横断的なプラットフォームを作るスタートアップはマーケットが彼らの元にやってくるのを待っている。それが実現するには長い時間がかかる。大抵の場合、そのようなことは起きないのだ。

垂直的で狭いユースケースしかないプロダクトは、プラットフォームが約束するものとかけ離れているように見える。事実、残念ながらアーリーステージのスタートアップにとってプロダクトとプラットフォームは全く異なるものだ。プラットフォームでありながら、特定のユースケースで高い価値を提供することはほぼ不可能に近い。

ファウンダーが「プラットフォーム戦略」のようなデモトークをしている時、多くのファウンダーはカスタマーのニーズを明確に把握していないように感じる。抽象的な話は壮大に聞こえるが、一般的な話になりがちで実行に移せるかかどうかは分からない。

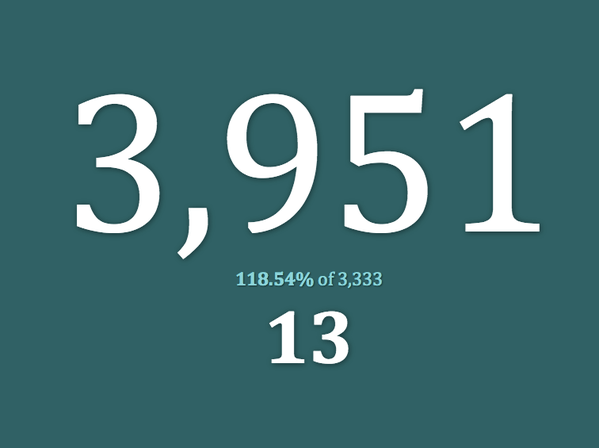

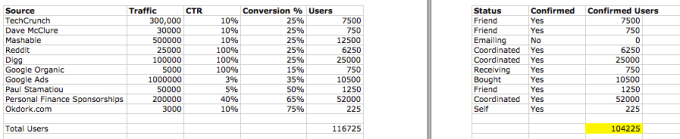

この時点で、私はどのようにしてクリティカルマスを獲得するかについて尋ねる。その答えには決まって、身振り手振りでの説明が続く。マーケティングプランには、何人かのキーインフルエンサーと、数値化出来ないようなマーケティングプログラムを混ぜ合わるというような話が多い。そのスタートアップが解決する特定の課題を誰も理解できない間は、クリティカルマスを獲得することは難しいだろう。

大きなビジョンを持つことは良いことだが、それに惑わされてはならない。プラットフォームになるには、まず価値あるユースケースのためのプロダクトを構築することが必要なのだ。

「シングル・プレーヤー・モード」を製作する

プラットフォームを作るという概念から抜け出せないのなら、使える「シングル・プレーヤー・モード」を開発することに時間を割いてほしいと思う。何を作るにしても、サインアップしたユーザーが1人でも価値を得られるようなプロダクトにすべきだろう。Instagramはユーザーが綺麗な写真を撮影できるように助ける。ネットワークはその次に来る。Pinterestはアーティストのイメージボードの役割を果たす。Pinterestでのつながりは裁縫の趣味サークルを世界規模で展開することを可能とした。Minecraftは世界最大のLEGOセットと言えるだろう。インターネット接続によって、Minecraftは世界最大の遊びのグループになったのだ。

私の言うことは信じなくても良い。Bezos、Zuckerberg、Jobsから学ぼう

プラットフォームは長期的なビジネスになるだろうが、スタートアップがゼロからプラットフォームを作るのは不可能に近い。GoogleがGlass Collective (イミテーションと言えば多少は聞こえは良いだろうか)を作ろうとしたことを覚えているだろうか。彼らはA16ZやKleiner Perkinsの支援を受けたが、それでもプロジェクトは終了することになった。突き詰めれば、Googleは誰も欲しがらないプロダクトのプラットフォームを作るのではなく、魅力的なプロダクトを作ることに注力することを優先すべきだったと言える。

スタートアップの世界から誕生したプラットフォームのほとんどが素晴らしいプロダクト・ソリューションの副産物であるというのが真実だろう。AmazonのAWS、FacebookやiOSは今日のテクノロジー業界で最も重要な3大プラットフォームと言って良いだろう。しかし、どの会社もどこか無意識的にプラットフォームビジネスに参入したと言える。

Amazon

Amazon Web Service(AWS)は、スタートアップのインフラストラクチャの中核になった。AWSはHTTP規格が確立されて以降、スタートアップの爆発的な急増の最も重要なイノベーションをもたらしたサービスであると言える。

しかし、Amazonは最初から共通のコンピューティング・インフラストラクチャのプラットフォームを構築しようとしていたのではない。彼らは、ハーレクイーンのロマンス小説、LostのDVDボックスセット、テニスラケットなど何百万点の商品を取り扱うサービスだ。

彼らがコンピュティングサービスに注目したのは、煩雑な配送と受け取りの仕組みを掌握してからのことだ。AWSのプラットフォームは、特定の課題に対して信頼できて愛されるソリューションを構築したことによる副産物として誕生したものであって、Amazonが最初から注力していたものではなかった。

プラットフォームを構築しようと動き出してからも、スタートアップのファウンダーという特定のカスタマーを対象にしていた。医療や金融のプライバシー規制、法人のセキュリティーの懸念点を考慮すると、そこから始めるのは相応しくないと判断し、それらの市場は最初から視野に入っていなかった。そのような多種多様な企業向けのサービスであるとは約束していない。AWSは、急成長するスタートアップにとって本当に必要なものを構築したのだ。

Amazonは1994年創業したが、AWSの提供を開始したのは2006年からだ。そして、AWSで収益が上がるようになったのは2015年からだ。きみのビジネスがもっと短い時間でプラットフォームを作れない理由にはならないが、歴史上最も成功しているウェブ企業に名を挙げられるAmazonでも、プラットフォームになるまで10年以上の歳月が必要だったのだ。ペース配分に気を配ることも必要かもしれない。

Facebookはプラットフォームではなかった。

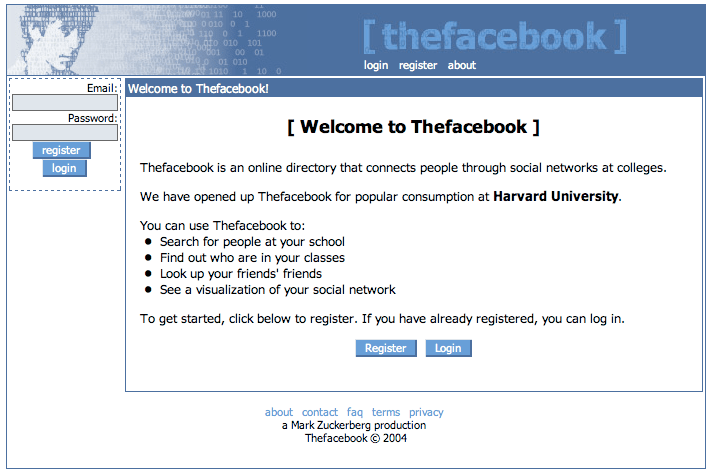

Mark Zuckerbergの当初の目標はプラットフォームを構築することではなかった。TheFacebook.comの最初のバージョンには写真共有の機能すらなかった。

Farmvilleが普及するようなプラットフォームになるまで、Facebookは大学生が友人の友人を探すためのシンプルなプロダクトだった。現在では、ウェブ上のログイン機能を提供し、史上最も急成長する広告プラットフォームになった。

Facebookは2004年に創業した。何百万人のユーザーベースを抱えるFacebookが初めてプラットフォームに向けた取り組みを行うと発表したのは2007年のことだった。つまり、3年間は素晴らしいプロダクトを作ること、ユーザーの声に耳を傾けること、そしてFacebookのプロダクトとネットワークを構築することに集中してきたのだ。今では15億人が使用するプラットフォームでさえ、10年前までは.eduのメールアドレスがなければアクセスすることはできなかったということを覚えておいてほしい。

iPhone

Appleはホーム画面を埋めるだけの数のアプリを持っていなかった。アプリストアもローンチ時にはなかった。

思い出すのが難しいが、iPhoneが2007年にローンチした時、それは世界が初めてみる最高のスマートフォンというだけのものだった。コピーペーストすることもできず、「それ用のアプリがあるよ」の広告キャンペーンの展開や開発者が何十億ドルの収益を生むようになるのはそれからまだ数年先のことだ。

ソフトウェアのエンジニアはAppleにアプリの開発をすると連日提案した。Appleはローンチ初日からプラットフォームになることができたということだ。しかし、Appleはその提案を断り、代わりに開発者にはウェブアプリの構築を促した。

それについて考えてみてほしい。AppleはiPodでこれ以上にない成功を収めていたし、何十億ドルも銀行に入っていて、大量の熱狂的なファンに支えられ、プレスの反応も友好的だった。Appleはローンチ初日からプラットフォームを構築することができたが、そうはしなかった。彼らは、大勢のオーディエンスに解放する前に、プロダクトの中核となるユースケースを磨き上げる必要があると気がついたのだ。現在、iOSはコンピューティングの歴史上最も重要なプラットフォームの一つになったが、これも最初は魅力的なプロダクトとして始まった。

スティーブ・ジョブズより賢いのなら問題はないが、そうでないと思うならカスタマーの課題を解決することに注力し、サービスやプロダクトがその課題解決において市場のスタンダードになってからプラットフォームになることを考えるべきかもしれない。

[原文へ]