Facebookにはフェイク・ニュースを拡散してドナルド・トランプの大統領当選を助けたという非難が殺到している。Gizmodoの記事によるとFacebookは右派メディア多数に対する影響が大きすぎるという理由でフェイク・ニュースを探知するアップデートを延期したという。

Facebookはこの報道を直接に否定し、TechCrunchに対して「記事の主張は真実ではない。われわれは特定の政治的立場への影響を考慮してニュースフィードへの変更を行ったり、延期したりしたことはない」と語った。

TechCrunchはコンテンツの中立性に関してFacebookから直接詳しいアップデートを得る機会があった。

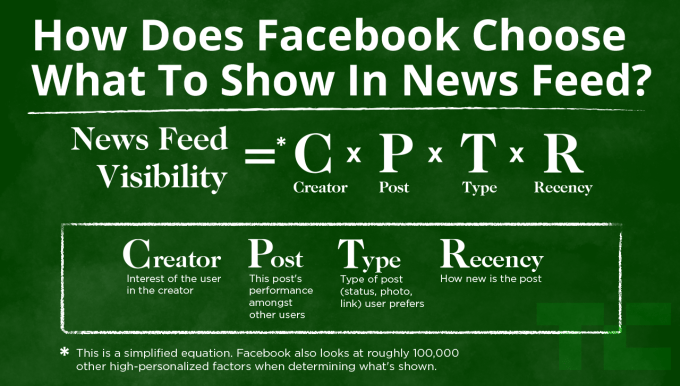

2015年の1月にFacebookは捏造ニュース記事を追放するためのアップデートを発表した。これはユーザーによって多数の「報告」フラグが付けられた記事の表示ランクを下げるものだった。こうして降格された記事の多くは後で投稿者自身が削除している。このシステムは現在も作動中だ。

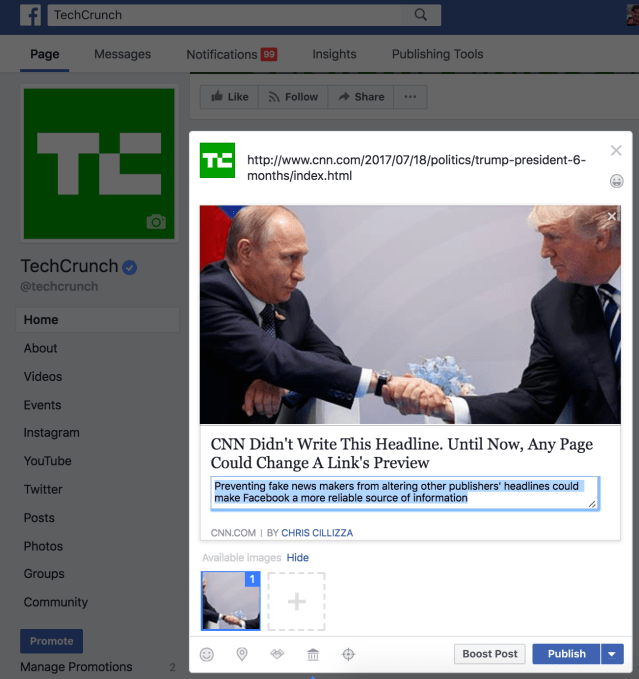

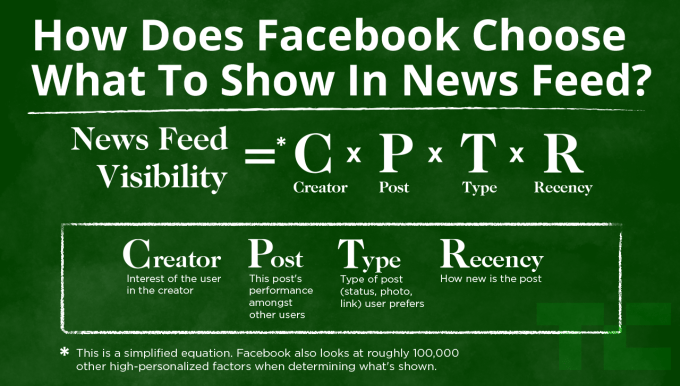

その後2016年8月にFacebookはさらにニュースフィードのアップデートを行った。 これは クリックベイトと呼ばれる記事を抑止することを目的としたもので、 Facebookは人間が選んだ典型的なクリックベイト的記事タイトルを資料として機械学習システムに学習させた。機械学習はクリックベイト的タイトルを認識し、そのような記事の表示ランクを自動的に下げることが期待された。

Facebookによると、 今年のクリックベイト対策アップデートで、開発チームは2種類のオプションを用意した。一つは2015年のユーザー報告にもとづくフェイク検出システムで、他方はもっぱら機械学習のアルゴリズムに頼るコンピューター・システムだった。

Facebookによれば、機械学習を利用したクリックベイト探知システムは間違った陽性反応(クリックベイトでないものをクリックベイトと判定すること)もその逆のエラーも人間の場合より少なく良好な実績だったという。そこでFacebookはこのシステムをリリースした。もちろん開発過程でリリースされなかったバージョンをGizmodoが取り上げている可能性はある。Facebookの担当者に対するインタビューでは、「右派の言論の降格が適切であるかどうかはクリックベイト抑止策を実際に選択するにあたって全く考慮されなかった」ということだ。しか政治的バイアスの有無はやはり懸念事項だろう。

Facebookの決断は ユーザーの「報告」に基づく人間のキュレーションより機械学習アルゴリズムに重きを置くというものだった。これは「人間の介入によるバイアスの可能性を減らす」というFacebookの最近の方針にも一致する。ただしこの立場自体がさまざまな問題を含んでいる。

今年に入ってGizmodoに掲載された記事には「Facebookのトレンドをチェックする人間のキュレーターは編集権の一環として主観によって保守派の傾向の記事を排除している」という主張が紹介されていた。Facebookはこの主張を否定したが、同時にキュレーション・チームを解雇し、人力に頼らずアルゴリズムによってトレンドを設定する方向に舵を切った。すると今度はFacebookはフェイク記事をトレンドとして表示したとして非難された。New York Timesの記事は「トレンドの記事選定方法はFacebookの客観性を麻痺させるもの」と激しく攻撃した。

仮に Facebookが保留されているクリックベイト対策版をリリースしていたとするなら、フェイク記事の選択はユーザーからの報告を検討する担当スタッフの主観に依存することになっていただろう。しかしクリックベイトを選び出すにあたって、あからさまなデタラメと巧妙なトリックとの間の線引は非常に難しい。一方、政治活動家やトロルはFacebookの記事報告機能を乱用して、自分たちに不利であれば正確な記事に対しても組織的に報告フラグを立てるという攻撃をしかけるだろう。

この難しい状況はソーシャル・フィードの掲載ランク付けにあたってユーザー・エンゲージメントをベースとしていること必然的な結果だ。国民を2分するような政治的状況における選挙活動やどんな記事であろうと閲覧されれば広告収入が得られるということがフェイク記事の氾濫の大きな動機となっている。

誰が真実の審判者となるのか?

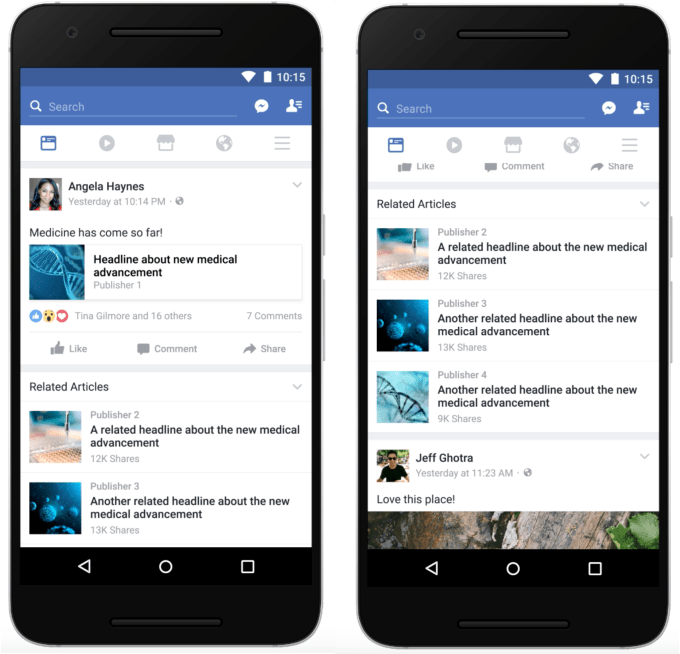

Facebookとともに大きなニュースのチャンネルであるTwitter、Googleも前途に難関が予想される。事実によって簡単にそれと見分けられるフェイクは問題の一部に過ぎず、対処も比較的簡単だろう。誇張が極端な記事、あからさまなテクニックを用いた釣り(クリックベイト)記事への対応はもっと難しい。

というのも、Facebookなどのプラットフォームはユーザー・エンゲージメントに比例する報酬システムを用いているため、ニュース媒体にはセンセーショナリズムによってページビューを稼ごうとする動機が存在するかだらだ。政治的立場が明らかな伝統あるニュース媒体の場合、不当な誇張がないよう責任を持つことが求められる。しかしFacebookのようなネットワーク上である目的のために特別に設定され、口コミのパワーだけ頼ろうとするニュースサイトの責任を問うのは難しい。こうした媒体はその場限りのトラフィックと収入を目的としているので、読者が誇張やフェイクにうんざりしても、単にそのサイトを閉鎖して新しい名前で別のサイトを立ち上げればすむ。

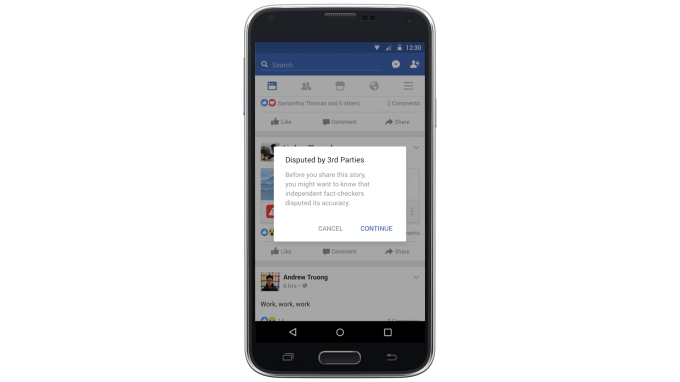

誇張ないしフェイク記事を報告する手順をシンプルにする、実否が疑わしい記事にはファクトチェック・サイトへのリンクを追加する、正確性が立証されていないサイトの記事の拡散を保留する、などはそれぞれ有効だろう。しかしフェイク記事がマネタイズに有効だという構造そのものを再検討するのがフェイクの追放にあたって最優先されるべき事項だ。

しかしFacebookのようなネットワークに真実の警察となるよう求めるのは危険過ぎる。どのニュースを削除しろという圧力は現在よりはるかに増え、それに伴って非難のボルテージが上がるのは必然的だ。少なくともテクノロジー・プラットホームがユーザー・エンゲージメントによって記事のランキングを行うならば、仮にフェイク・ニュースの検出で誤りがあったとしても、それは個々のユーザーが誇張やフェイクであるかどうかを判断すればよいことだ。FacebookのCEO、マーク・ザッカーバーグはこの立場を強調し、「われわれ自身が真理の審判者であるかのような立場に立つことにはこの上なく慎重でなければならない」と書いている。

現在 Facebookは難しい立場に置かれている。ユーザーの判断を信頼するとしてフェイク・ニュースが拡散するに任されば非難されるだろう。しかしフェイク・ニュースを発見して削除する立場を取れば、それは検閲と同じでありユーザーから選択の自由を奪うことなるとして非難されるはずだ。世界最大のソーシャル・ネットワークは次の行動を慎重に選ばねばならないだろう。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)