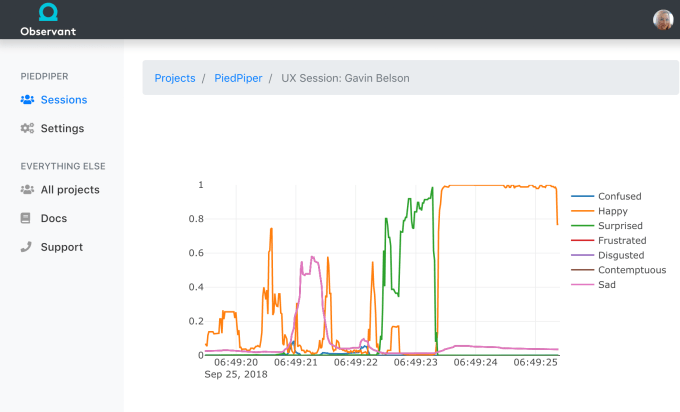

Observantは、iPhone X, XS, XRの、赤外線を利用する奥行き(z軸方向)センサーの、新しい使い方を見つけた: ユーザーの顔の表情を分析して、製品やコンテンツに対する反応を読むのだ。

ObservantはY Combinatorの本年冬季の‘生徒’だったが、3月のデモデーの時点でもステルスだった。作者は、バグを報告するBuglifeを作ったのと同じ企業で、CEO Dave Schukinによると、彼のチームがユーザーの反応を正しく知りたいためにObservantを作った。

本誌TechCrunchはWebカメラや視標追跡(eye tracking)を使う方法を過去にも取り上げてきたが、CTOのDaniel DeCovnickと共に同社を興したSchukinによると、それらの方法はObservantに比べて精度が低い。とくにそれらは、表情の細かいニュアンスを捉えることができず、また十分明るくないと使えない。

彼によると、赤外線を用いる奥行きセンサーは、照度が低いところでも顔を詳細に捉えることができる。またObservantは独自のディープラーニング技術により、顔のデータをリアルタイムで感情に翻訳できる。

Observantは、どんなiOSアプリからでも利用できるSDKと、そのバックエンドとしてのリアルタイムの感情分析ストリームと、アプリ内イベントに対応するユーザーの反応のスナップ・ショットを提供している。今は完全招待制だが、Schukinによると、すでに一部のリテールやeコマース、それにフォーカスグループテストでも利用されている。

自分のiPhoneがこっそり自分の表情を捉えている、と後で知ったら誰しも気分悪いので、Schukinは事前にユーザーに知らせることを強調する。“ユーザーはそれがどのように使われるか明確に知っている”のだそうだ。またすべての分析はユーザーのデバイス上で行われるので、顔の映像やバイオメトリクスデータなどがどこかへアップロードされることはない。

この技術には、もっといろんな用途がありうる、とSchukinは主張する。たとえば消費者へのリコメンデーションの質をアップしたり、チャットボットが“感情認識能力”を持ったり、居眠り運転を検出したり、などなどだ。

現在、特定のスマートフォンの特定の三機種でしか使えないことに関してSchukinは、赤外線による奥行きセンサーがあるのは、開発を始めた当時iPhone Xだけだった、と言う。そして、いずれはAppleのiPhoneとiPadの全機種に搭載されるだろうし、Androidにも載るだろう、と彼は考えている。

現時点でObservantの将来性を占うのは時期尚早だが、Schukinによると、わずか一機種だったのがすぐに三機種になったのだから、今後この技術が広まっていくことは確実だ、という。

画像クレジット: Observant