2017年にTesla(テスラ)が、Model 3の驚くほど野心的な毎週5000台の生産目標と「生産地獄」の始まりを発表したときは、アナリストたちは慎重だった。しかしイーロン・マスク氏は、ハイパーオートメーション、すなわちロボット組立ラインが、製造スピードを上げコストを引き下げる秘密兵器だと言いながら、それを上手くやり遂げられると豪語した。そこから1年半経って、今やテスラは2018年第4四半期の時点で9万1000台を出荷している。しかし、その生産台数の増加は、無数の問題の解決や、マスクの当初の「高度に自動化された組立ライン構想」から離れることなしには達成できなかった。

何が起きたのだろう?

自動化への取り組みがうまくいかなかった理由を尋ねられたマスク氏の答えは、終始一つの大きな課題を巡っていた。それはロボットビジョンである、つまり組立ラインのロボットが行動を決めるための対象として何を「見る」のかをコントロールするソフトウェアのことだ。残念なことに、当時の組立ラインのロボットは、ナットやボルトのような物が予期しない方向を向いていることや向き、車のフレームの間での複雑な操作に対処することができなかった。そのような問題が発生するたびに、組立ラインが停止していたのだ。結局、多くの組み立て工程の中で、ロボットを人間に置き換えたことで、はるかに簡単に問題を解決できたのだ。

現在コンピュータビジョン(ロボットビジョンのより包括的な名称)は至るところに存在していて、さまざまな業界を横断するAIテクノロジと画期的なアプリケーションの、次のフロンティアを象徴している。この分野で、現在研究者や企業によって行われている進歩はとても印象的なものであり、イーロン・マスク氏の自動車組立ラインの自動化ビジョンの実現に必要だった要素も現れはじめている。その核となるのは、コンピューターやロボットが、現実の世界で発生する(ナットやボルトの間違いのような)予期せぬ厄介な出来事の大部分を、確実に処理することができるようになるという技術だ。

コンピュータビジョンの転機の瞬間

コンピュータビジョンが転機を迎えたのは、2012年に畳み込みニューラルネットワーク(CNN)を適用したときだった。それ以降、その勢いは本当に増している。2012年以前は、コンピュータビジョンのソリューションは主に手作りのものだった。基本的にアルゴリズムは、手作業で定義されたルールセットを持ち、画像の特徴を比較的効率的に数学を用いて記述することが可能だった。これらは人間によって選択され、そしてコンピュータビジョン研究者によって組み合わされて、自転車や、店頭、または顔のようなオブジェクトを画像の中で特定することに用いられた。

機械学習の台頭と人工ニューラルネットの進歩が、これらの全てを変えてしまった。画像の特徴を自動的に読み解き学習できる、大量のトレーニングデータを使用したアルゴリズムの開発が可能になったのだ。その実際の効果は2つに分けられる。

(1)ソリューションがはるかに堅牢になったこと(たとえば、顔の向きが多少違っていたり、影があっても、変わらず顔として識別できるなど)。

(2)優れたソリューションの作成は、大量の高品質のトレーニングデータに依存するようになったことだ(モデルはトレーニングデータに基づいて特徴を学習するため、トレーニングデータが正確かつ量が十分で、アルゴリズムが後で見る可能性のある、多様な状況を表していることが重要だ)。

現在研究されていることは、GANと教師なし学習、そして合成データ

GAN(Generative Adversarial Networks、敵対的生成ネットワーク)、教師なし学習、および合成グランドトゥルースなどの新しいアプローチにより、高品質のコンピュータビジョンモデルの開発に必要なトレーニングデータの量と、収集に必要な時間と労力を、大幅に削減できる可能性が出てきた。これらのアプローチで、ネットワークは実際に自分自身の学習をブートストラップし、より高い忠実度ではるかに速く、例外的ケースと異常値を識別することができるようになる。その後、人間がそうした例外的ケースを評価して解決策を再考し、高品質のモデルによりすばやく到達することができるようになる。

これらの新しいアプローチは、適用性、堅牢性、および信頼性の観点から、コンピュータビジョンの範囲を急速に拡大している。それらは、マスク氏の生産課題を解決できるだけでなく、無数の重要なアプリケーションでその境界を劇的に広げることになるだろう。そのいくつかの例を以下に挙げてみる。

- 製造オートメーション:ロボットは、中心から20度ずれた車の座席や左に1インチずれた位置にあるネジのように、ランダムな向きのオブジェクトを扱うことが、ますます得意になって行くだろう。さらに、ロボットは、柔らかくて、折り曲げ可能な透明な物体を確実に識別することができるようになるだろう(例えば、先週Amazonで注文したビニール袋に入った靴下について考えてみよう)。現在バークシャー・グレイのような新しいロボットメーカーたちが、こうした技術の最先端を走っている。

- 顔面検出:以前は、側面からの顔や、部分的に影が落ちていたり、隠されていたりする顔、そして赤ん坊の顔といった例外的なケースに対しては、顔面検出は堅牢に動作しなかった。現在、研究者たちは、コンピュータビジョンが、顔写真から90%の正確さでまれな遺伝性疾患を識別するのに役立つことを発見している。ある種のアプリケーションは消費者の手に渡るようになっていいる。これは、さまざまな照明条件や、画像キャプチャのコントロールが十分に行えない状況に対して、アルゴリズムがますます堅牢になったために可能になったのだ。

- 医療用画像処理:進歩により、MRIの評価、皮膚癌の検出、 その他多数の重要なユースケースでの自動化が可能になった。

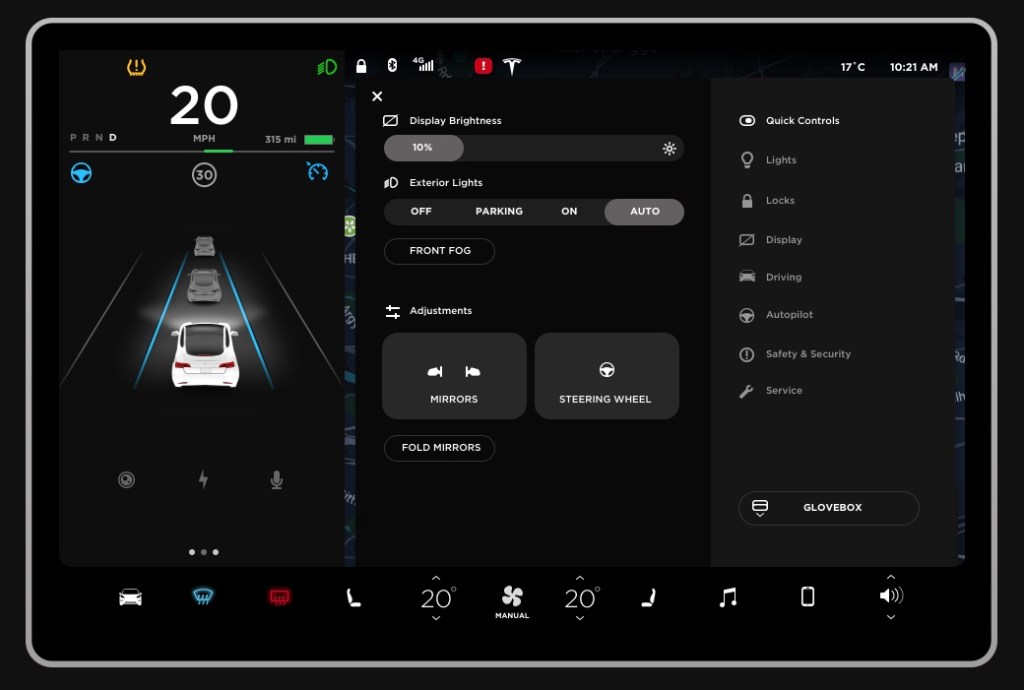

- 運転手の支援と自動化:霧のかかっている状況では自律運転システムは機能していなかった。なぜならこれまでは濃い霧と岩を区別することができなかったからだ。現在では、教師なしの学習と(Nvidiaなどが主導する)合成データ作成機能が、数十億マイルに及ぶ路上記録映像でもカバーすることのできない例外的ケースでシステムを訓練するために、利用され始めている。

- 農業:ジョン・ディアが買収した ブルー・リバー・テクノロジーのような企業は、現在雑草と作物を確実に区別して、選択的に除草剤を自動散布することができる。このことで、商業農業で使用される有害化学物質の量を劇的に減らすことができる。

- 不動産情報:地理空間画像にコンピュータビジョンを適用することで、企業は洪水、山火事、ハリケーンによる風が、特定の施設に危険を及ぼす可能性がある時期を自動的に特定できる。これにより家の所有者たちは災害が訪れる前により早く行動することができる。

こうした進歩をながめていると、1つのことがすぐに明らかになる:イーロン・マスク氏は間違っていなかったのだ。単に彼のビジョン(ロボットやそれ以外のもの)が、現実から1〜2年先行していただけのことだったのだ。AI、コンピュータビジョン、そしてロボットは皆、正確性、信頼性そして効率性の転換点に近づいている。テスラにとって、「生産地獄」への次の段階(おそらくModel Y)を迎えるフレモント工場と上海工場では、大幅に異なる組立ラインを目にすることになるだろう。それらは、より上手く、ロボットとコンピュータービジョンが組み合わされたものになるのだ。

画像クレジット: Guus Schoonewille/AFP / Getty Images

この著者によるほかの記事:シリコンバレーの企業たちが人工知能の可能性を損なっている

[原文へ]

(翻訳:sako)