Googleが新型Chromeでリリースした会話型検索サービスその名も「カンバセーショナル・サーチ」がスゴイらしい、ということでその機能をサーチエンジンランドが徹底解説した記事を早速。 — SEO Japan

先週のグーグル I/Oカンファレンスでグーグルがデモを行った「Conversational Search」(会話型検索サービス)が、クロームブラウザのユーザーに公開された。この会話型検索サービスによって、検索エンジンを利用するアプローチが大幅に進化すると見られている。

先週のグーグル I/Oカンファレンスでグーグルがデモを行った「Conversational Search」(会話型検索サービス)が、クロームブラウザのユーザーに公開された。この会話型検索サービスによって、検索エンジンを利用するアプローチが大幅に進化すると見られている。

私は検索に関する記事を17年間に渡って書き続けており、検索に革命を与えると言われてきたあらゆる検索製品、とりわけ「自然言語」や「セマンティック検索」等の用語で飾られたものの、期待を裏切った製品をこの目で見てきた。

会話型検索は、自然言語やセマンティック検索等の技術が活かされた製品である。完璧とは程遠いものの、「酸いも甘いも噛み分けた」私のような人物でさえ、思わず緊張し、好奇心を掻き立てられるポテンシャルを持つ。

グーグルは複雑なシステムを用いているものの、実際には、自然且つスムーズに稼働する。幾つか例を挙げ、最後に「内部」の仕組み、そして、コツを紹介する。

クロームの音声検索

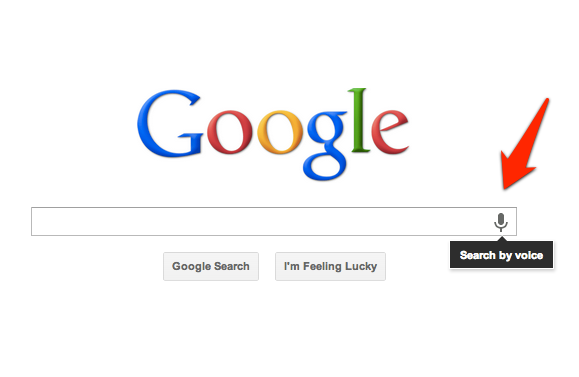

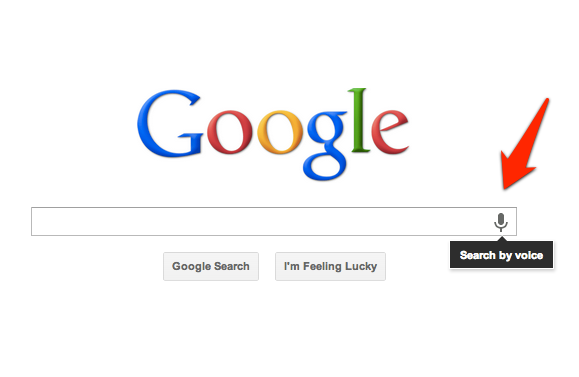

クロームの最新版では、検索ボックスのマイクをクリックして、音声で検索を実行することが出来る。

これは新しい機能ではなく、グーグルは2年近く前に音声検索機能を導入していた。しかし、iPhoneとアンドロイド向けのグーグル検索アプリと同じように、検索エンジンが音声で答える点が以前とは異なる:

検索結果が表示される:

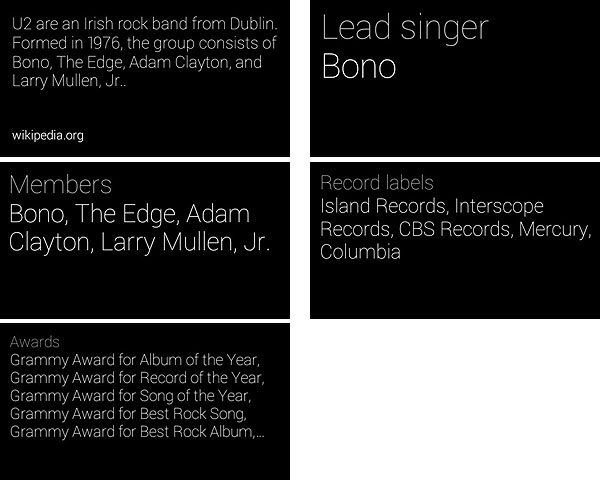

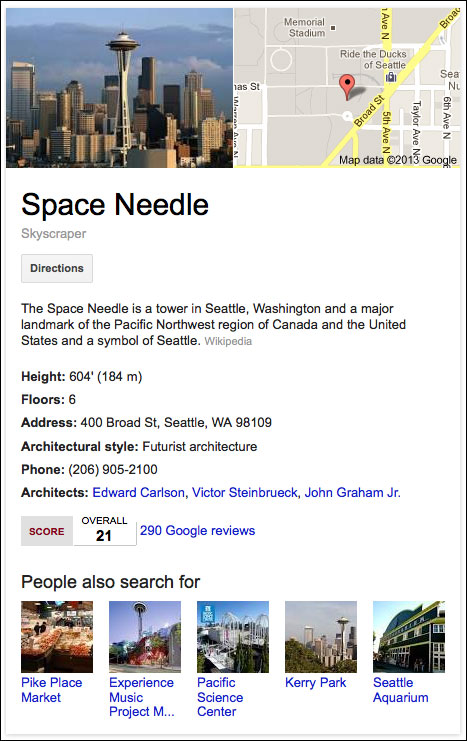

時折、とりわけグーグルがナレッジグラフのデータを呼び出すことが可能な検索においては、直接の答え、または、情報「カード」(グーグルナウ(日本語)でデータを提示するアプローチ)が結果の上部に掲載される。

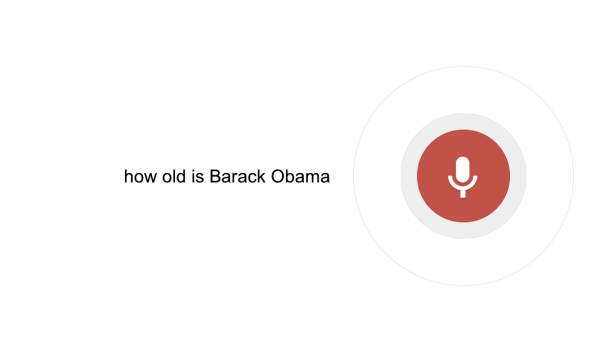

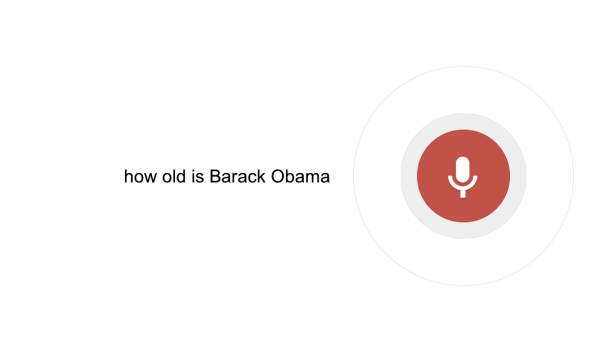

上の例では、「how old is Barack Obama」(バラク・オバマは何歳)と問いかけると、グーグルは答えをカードで提示し、さらにカードからオバマ大統領の年齢のカードを引き、[Balack Obama is 51 years old]と答えを音声で伝えてくれた。

会話を交わす

検索エンジンに話しかけられると、結果を音声で提供すると言う機能は、実にスタイリッシュであり、見事だとしか言いようがない。しかし、驚くのはまだ早い。なんと、代名詞や過去のクエリ内の情報を参照するその他の近道を活用し、さらに質問を投げかけて、検索による“会話”を継続することが出来る点こそが、この機能の最大の目玉である。これは通常の検索では考えられない。

例えば、上の検索を行った後に、[how tall is he](彼の身長は?)と問うと、次の答えが得られる:

「Barack Obama is six feet one inch tall」(バラク・オバマは6フィート1インチです)とテキストと一緒に再び音声で答えが返ってくる。しかし、私はオバマ大統領の身長を尋ねたのではなく、「彼の身長」を尋ねたのだ。グーグルは「彼」がバラク・オバマ大統領に言及している点を理解したことになる。

人間はこの点を容易に理解する。会話を交わし、会話の中で話した内容を把握し、既述した事柄 – 代名詞や前に登場した事柄を参照する近道 – を区別する。しかし、検索エンジンはこのような記憶を持たない。検索エンジンは、通常、それぞれの検索を以前の検索とは関連させることなく処理する。

「過去のクエリ」だけではない

グーグルとビングは「知的な履歴」を用意している。グーグルは2008年から過去のクエリの提供を行っている。ビングは、2011年からアダプティブ検索を提供している。この2つのサービスでは、過去に検索したクエリが事実上後続のクエリに追加されることがある。例えば、「new york」を検索し、次に「travel」(旅行)で検索をかけると、一部の検索は、ニューヨーク旅行に関する検索結果を表示させる可能性がある。

過去のクエリによる絞り込みは便利だが、会話型検索はそのさらに先を進んでいる。単純に後続のクエリに用語を加えるのではなく、言語を解析して、クエリを完全に理解することが出来るのだ。

「how old is Barack Obama」の検索を行った時、グーグルは、文字をマッチさせようと試みる2つのワードではなく、バラク・オバマが実在する人物である点を理解する必要があった。これは一年前に導入されたナレッジグラフ(日本語)がもたらした知性である。この知性は、「年齢」が、オバマに関する特定のデータに該当する可能性がある点を把握する上で貢献する。

次の検索が行われると、グーグルは、再び単純にワードをマッチさせるのではなく「he」が誰かの代名詞である点を理解しなければならなかった。その後、「he」が誰なのか考え、過去のクエリを確認し、それがオバマを参照している可能性があることに気づいた。最後にナレッジグラフに戻り、オバマ大統領の身長にマッチするデータを見つけ出した – つまり、グーグルは[tall]が身長を間接的に求めている点を理解したのだ。

実に難解なプロセスである。これは、自然言語処理であり、セマンティック検索と連動し、文の意味を正確に理解するための力である。データとページが、見えないところで全てつながっているのだ。

会話を続行

それでは会話を継続していく。次にグーグルに「who is his wife」(彼の妻は誰)と尋ねたところ次の答えが返ってきた:

「Barack Obama’s spouse is Michelle Obama since 1992」(バラク・オバマの配偶者は、1992年からミシェル・オバマです)。グーグルは「his」がバラク・オバマに言及し、[wife]がナレッジグラフで調べることが可能なデータのリクエストであると理解し、答えを出したのだ。

さらに会話を継続してみる。次に「how old is she」(彼女は何歳)と尋ねてみた。すると、次の答えが返ってきた:

グーグルの答えは[Michelle Obama is 49 years old](ミシェル・オバマは49歳です)であった。この答えを得るため、グーグルは最初の質問から延長された3つの先行するクエリを理解した。

残念ながら、この一連の動きを適切にとらえることが可能なソフトウェアをインストールしていないため、直接見せることは不可能だが、これから説明していくように、皆さん自身で試してもらうことは可能である。それでも、次のアニメーション画像を見て頂ければ、何となく分かってもらえるのではないだろうか。

これは、先週グーグルI/Oで行われた会話型検索のデモの最中に撮影したスクリーンショットである。

完璧ではないが素晴らしい

会話型検索は常に適切に動くわけではない。さらに会話を続けていくと、失敗する確率が高くなる点に私は気づいた。予想に反して質問に対する答えが返ってこないときもある。事実、上の例にある4つのクエリで構成される検索で正しい結果を得るまでに数回試さなければならなかった。

グーグル I/Oでこの製品を直接試し、参加者と話をしている時、グーグルはこの点を認めていた。クロームでのサポートを正式に発表していたら(現時点では正式な発表はなく、そっとリリースされている)、バグを警告する注意書きが掲載されていただろう。

エンジニアやその他の製品のスタッフは、私が目の前でテストを行い、バグに遭遇すると顔を歪めていたが、私は正常に動く頻度の高さ – そもそも正常に動いた事実 – に感動していた。さらに改善していってもらいたいものだ。

誰 & どこに基づいて提供される答え

グーグルはユーザーの場所を把握しているため、または、個人情報の一部にアクセスすることが出来るため、一つの質問から、実際に述べた情報を越える答えを得られることがある。

天気が良い例だ。[Will it rain tomorrow?]と尋ねてみた:

すると、グーグルは「No, rain is not expected tomorrow in Newport Beach. The forecast is 70 degrees and cloudy」(いいえ、ニューポートビーチでは雨が降るとは予想されていません。予想気温は華氏70度で、曇になる見込みです)と答え、天気予報を表示した。私は自分の居場所も教えたわけでも、天気予報を求めたわけでもないが、グーグルは私の場所を把握し、雨が天気に関連していると理解し、素晴らしい答えを提供してくれたのだ。

Gメールのフィールドトライアル(Gメール以外の情報も含まれているため、名称として相応しくない)を介して、個人情報へのアクセスを認めているなら、[what’s happening today](今日の予定は何?)等の検索を行うと、スケジュールが表示される:

スケジュールを音声で伝えるわけではないが、- グーグル自身のサービスを使うことに抵抗がないなら – 称賛に値すると言えるだろう。グーグルカレンダーやGメールを利用していない場合、ユーザーエクスペリエンスのレベルは格段に下がる。

「カード」以外 & 音声で答えが提供されない結果もある

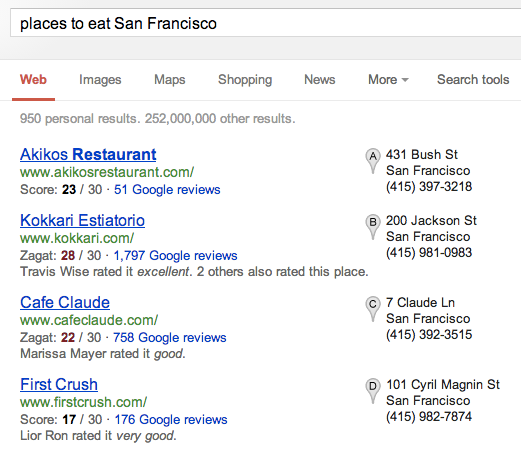

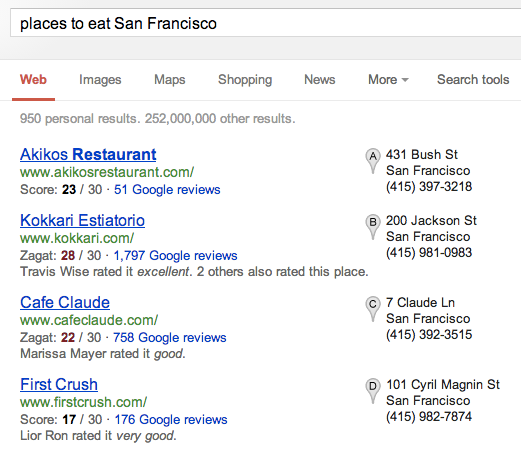

答えは、オバマ大統領のクエリで紹介した情報カードから必ずしも得られるわけではない。例えば、「places to eat in San Francisco」(サンフランシスコで食事をする場所)と尋ねてみるとグーグルから次の答えが返ってきた:

グーグルは、「There are several listinsg for restaurants near San Francisco」(サンフランシスコ近郊のレストランに対するリスティングが幾つかあります)と音声で答え、地域のレストランのレビューを表示した。レビューは音声で紹介されなかった。

同様に[Newport Beach]と語りかけると、[Here is some information about Newport Beach](ニューポートビーチに関する概要です)と答えるものの、実際の結果は音声では紹介してくれなかった:

グーグルは、右側のナレッジグラフボックスを使ってニューポートビーチの詳しい情報を読もうともしなかった。オバマ大統領に関する音声検索では、この程度の手間は惜しまなかった。

当然だが、デスクトップでは、情報を読んでもらうことが便利だとは言い切れない。事実、音声検索は、2年前に導入された頃、とりわけオフィスで仕事をする人達にはいまいち受けが良くなかった。レスポンスを読んでもらう機能は確かに高度な技術だが、モバイルデバイスとは異なり、デスクトップでは必ずしも便利だとは言えない。

待ち遠しい音声による起動 & OK グーグル!

音声で会話型検索を起動することが出来るようになれば、利便性は改善されるかもしれない。この機能は今回のリリースには含まれていない。

音声起動検索では、コンピュータは「ホットワード」 – 恐らく先週デモが行われた「OK グーグル」を聞くと、ユーザーが検索を実行しようとしている点を把握する。

そのため、キーボードが存在しない環境で、検索を実施する必要がある場合、「OK グーグル バラク・オバマは何歳?」と話しかけると、コンピュータは自動的に検索を行ってくれる。

それでは、コンピュータは常に耳を傾けているのだろうか?グーグルによると、現在、このシステムを動かす仕組みを開発しているようだが、グーグルのホームページ、または、検索結果ページにアクセスしている際にのみ耳を傾けるブラウザのエクステンション等が採用されるのではないだろうか。 また、コンピュータが耳を傾けている時、実際にグーグルに送信されるのは、「OK グーグル」コマンドの後のクエリのみだとグーグルは明言している。

今後その仕組みが明らかになっていくだろう。会話型検索が、移動時に実行可能な取り組みを深くユーザーに理解してもらうための訓練場としてデスクトップを位置づけ、ユーティリティとしてモバイルに残るのかもしれない。

また、会話型検索サービスが、現在とは異なる方法で、先行する検索を用いて、より会話を意識したスタイルでクエリを入力するきっかけを与える可能性もある。

「会話」モードは入力では動作せず

現時点では会話型検索サービスは、クエリを入力すると動作しない。これは会話型検索がもたらす大きな違いである。

試しに、バラク・オバマ関連のクエリを音声ではなく、文字を入力して検索してみよう。次のイメージをご覧になれば分かるように、「身長」を問うクエリで白紙に戻ってしまう:

入力しているために会話型検索モードではなくなり、グーグルは「he」が誰に言及しているのかを特定する試みを止めるため、トム・クルーズとジョニー・デップに関する答えが代わりに表示されている。

自分で試してみる

先程も申し上げた通り、グーグルは会話型検索のリリースを正式に発表しているわけではない。しかし、実際に利用することが可能である。アンドロイドセントラルは、クロームの最新版を利用しているユーザーはこの機能を利用することが出来ると指摘している。そのためこの機能を使うためには、アップデートする必要がある。クロームの設定画面にアクセスし、次にヘルプを選択する。すると、最新版がインストールされているかどうかの確認が行われる。

Macでは、アップデートを行った結果、バージョンは27.0.1453.93になった。奇妙にもクロームブックでは、バージョン26以降にアップデートすることが出来なかった。ウィンドウズ 8のコンピュータはまだ確認していない。

参考までに伝えておくが、これはグーグルナウではない。確かに似ており、また、クローム/デスクトップ向けのグーグルナウはいずれ登場すると見られているものの、会話型検索からは、グーグルナウ(日本語)が提供する推測検索結果を得ることは出来ない。

いろいろ試してみよう。検索マーケッターにとっては、クエリが検索の意図を表現しなくなるため、とても一般的な用語でユーザーがウェブサイトを探し出す、全く新しい世界を垣間見るチャンスである。

皮肉にも、不評であったここ1~2年の「不透明なグーグル」の方針 – ログインしたユーザーが検索した用語を(広告主以外には)明かさない方針 – は、ユーザーがグーグルと“会話”するため、ユーザー自身が正確な用語の提供を差し控える状況への対応をトレーニングする格好の機会になっている。

検索エンジンのユーザーにとっては、検索の習慣を根本的に変える可能性がある大きな飛躍である。今後は、様々なタイプのトピックに対する答えを得るために昔から頼りにしてきた「親友」に対して、違和感なく話しかけることが出来るようになるだろう。

グーグルの競合者にとっては、新たに対応しなければならない難問がまた一つ増えたことになる。グーグルナウは既に検索を巧みに推測する取り組みに成功している(日本語)。現在、グーグルの会話型検索は、ユーザーにサービスを試してもらい、また、ユーザーが「今日の予定」等を検索エンジンに尋ねることが出来るように、グーグルのその他のサービスを介してより多くの個人情報を共有してもらおうと試みている段階である。

この記事は、Search Engine Landに掲載された「Google’s Impressive “Conversational Search” Goes Live On Chrome」を翻訳した内容です。

Google Now、

Google Glassサーチと革新的なサービスを送り出している最近のGoogleですが、またもやってくれたという感じですね。路線的にはどれも関連していると思いますが、次世代検索の幕開けといった感じですね。しかしGoogle以外のプレイヤーが黎明期の検索エンジン市場と違って余りいないのも残念というか怖いというか。MicrosoftとAppleに頑張ってもらうしかないのですが、、、さてさて。 — SEO Japan [

G+]

グーグルのスパム対策「ペンギンアップデート」が発動された。今回で4度目である。ペンギン 4は今までのペンギンとは少し異なる。グーグルがスパムの阻止を改善するテクノロジーとして期待しているペンギン 2.0のテクノロジー(日本語)を搭載しているのだ。

グーグルのスパム対策「ペンギンアップデート」が発動された。今回で4度目である。ペンギン 4は今までのペンギンとは少し異なる。グーグルがスパムの阻止を改善するテクノロジーとして期待しているペンギン 2.0のテクノロジー(日本語)を搭載しているのだ。 先週のグーグル I/Oカンファレンスでグーグルが

先週のグーグル I/Oカンファレンスでグーグルが

グーグルグラスの「エクスプローラ」版には7つの音声コマンドが搭載されている。6つのうちの2つは検索に関連している – [google]と[get directions to](~へのルートを調べる)。その他の音声コマンドは、[take a photo](写真を撮影する)、[record a video](動画を録画する)、[make a call to](~に電話する)、そして、[start a Hangout with](~とハングアウトのチャットを始める)である。

グーグルグラスの「エクスプローラ」版には7つの音声コマンドが搭載されている。6つのうちの2つは検索に関連している – [google]と[get directions to](~へのルートを調べる)。その他の音声コマンドは、[take a photo](写真を撮影する)、[record a video](動画を録画する)、[make a call to](~に電話する)、そして、[start a Hangout with](~とハングアウトのチャットを始める)である。