Overclock Labsは、アプリケーションの複数のクラウドにまたがるデプロイと管理を自動化により容易にするためのサービスを提供している。そのために同社が作った、分散クラウドインフラストラクチャを自動化するツールは、今どき当然ながらコンテナを使用する。そしてそれらのツールの主役は、コンテナオーケストレーションツールKubernetesだ。

今日(米国時間11/21)、2年前に創業されたOverclock Labsはステルス状態を脱し、130万ドルの資金調達を発表した。投資家はシリコンバレーの複数のエンジェルとCrunchFund、こちらは本誌TechCrunchと名前や経歴を多少共有しているが、本誌と特別の関係はない。

同社は、今回初めて一般に公表される資金を使って、DISCOというものを開発していた。DISCOは Decentralized Infrastructure for Serverless Computing Operations(サーバーレスコンピューティングオペレーションのための分散インフラストラクチャ)の頭字語だ。サーバーレスとあるからにはそれは、AWSのLambdaやAzure Functionsのようなイベントドリブンのサービスか? そう考えたくなるのも無理もないが、しかしOverclock Labsの協同ファウンダーGreg Osuri(CEO)とGreg Gopman(COO)によると、彼らの言う“サーバーレス”とは、完全な自動化のことだ。Lambdaは、イベントドリブンなアプリケーションのためにリアルタイムの自動化をやってくれるが、オープンソースにする予定のDISCOの場合は、もっといろんなアプリケーションのサポートを目指している。なお、同社の三人目の協同ファウンダーは、Adam Bozanichである。

Osuriが説明するその基本的な考え方は、ユーザーがどんなクラウドサービスのプロバイダーでも使えて、それら複数のクラウド間を容易に行き来できるようにすることだ。そのようなデベロッパー体験は、クラウドアプリケーションプラットホームのHerokuにやや似ており、ユーザーインタフェイスはGUIとコマンドラインの両方を提供している。

目下このツールがサポートしているのはAWSとGoogle Cloud Platform、そしてベアメタルのスペシャリストPacketだが、今後徐々にそのほかのクラウドもサポートしていく。DISCOはオープンソースだから、ほかの人たちが自分のものを統合するのも容易だ。

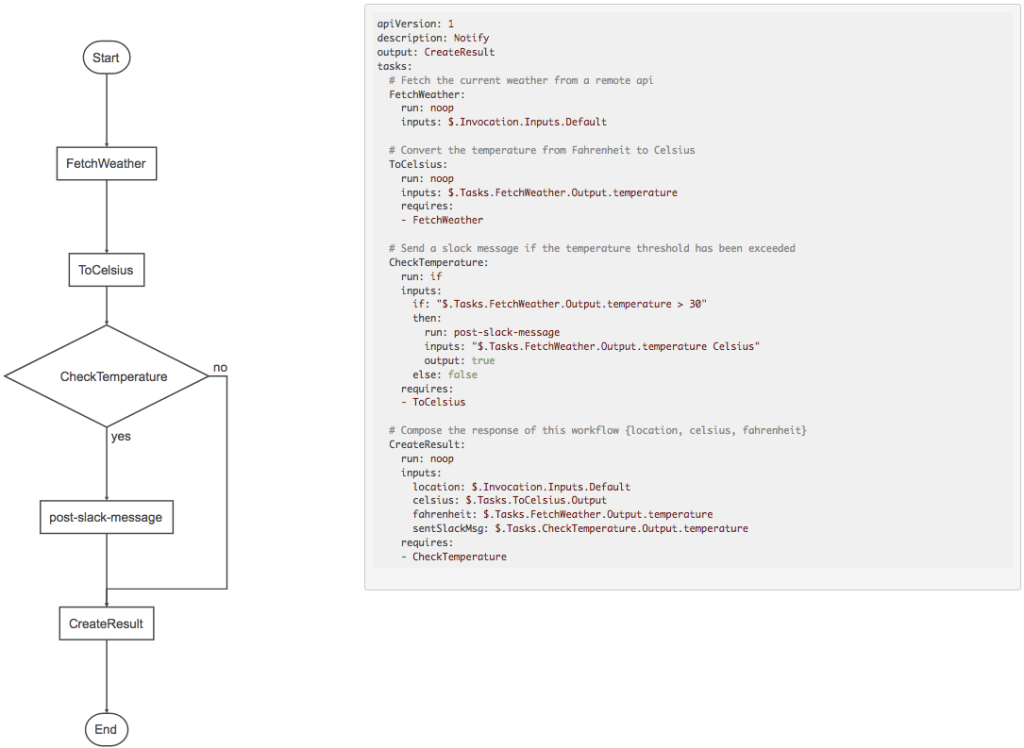

DISCOを使ってアプリケーションをデプロイするやり方は、二(ふた)とおりある。12-factor appのありがたい教えに従ってアプリケーションを作っている場合は、DISCOは単純にソースコードを取り込んでアプリケーションをデプロイする。あるいは独自のコンテナでアプリケーションを作ってる場合は、それらのコンテナをDISCOに渡してデプロイさせる。するとDISCOがコンテナレジストリを扱い、コンテナをデベロッパーに代わって管理する。

DISCOの約束は、アプリケーションのデプロイをHerokuを使う場合のように容易にすること、ただしその1/3のコストで。前にAngelHackを一緒に作ったOsuriとGopmanには、オープンソースのツールを作った経験が豊富にあり、今でもオープンソースのエコシステムの一員だ。だからDISCOをオープンソースにするのも自然な流れで、その上に有料サービスを乗っけていく気だ。

その有料サービスは現段階ではまだ具体化していないが、とにかく同社が真っ先にやることは数か月後にDISCOをリリースし、そのまわりにエコシステムを築いていくことだ。

今では高度なオープンソースのプロジェクトが毎日のようにローンチしているから、DISCOのエコシステムづくりも容易ではないだろう。でも同社のファウンダーたちは、その過程について現実的な見方をしている。それに、コンテナとKubernetesによるアプリケーションのマルチクラウドデプロイと管理の自動化は、誰にでもできることだから、そのうち競合他社があふれてくるだろう。近くAWSのre:Inventカンファレンスがあるから、そのへんの情況を確認してみたい。でもOverclock Labsの連中は、早くスタートした者にはそれなりの優位性があり、ビッグプレイヤーになれる、と信じている。