「やりたいのはセンシングをソフトウェアを用いて高度にしていくこと。画像認識や音声認識などの信号処理技術によって、従来の物理的なセンサーでは取れなかった実世界の情報を取得してソフトウェアで分析できるようになった。自動車産業を代表に、製造や物流など様々な分野がソフトウェアでビジネスをしていく形に変わる中で、その基盤となるサービスを提供したい」

そう話すのはIdein(イデイン)で代表取締役を務める中村晃一氏だ。近年サーバーではなく末端のデバイス(エッジデバイス)で画像や音声データを処理する「エッジコンピューティング」が注目を集めているが、Ideinは安価なエッジデバイスにディープラーニングを搭載する技術を持つスタートアップとして知られる。

7月には手軽にエッジコンピューティング型のシステムを構築・運用できる開発者向けプラットフォーム「Actcast」のβ版を公開。今後はActcastのADKを用いて開発したアプリケーションを売買できるマーケットプレイス機能などを備えた正式版のリリースも見据えている。

そのIdeinは8月19日、グローバル・ブレインなど複数の投資家を引受先とした第三者割当増資により総額8.2億円の資金調達を実施したことを明らかにした。調達した資金は同社のメインプロダクトであるActcastの本格的な事業展開に向けた人材採用の強化や業務環境の拡充に用いる計画だ。

Ideinとしては2017年7月に数社から1.8億円を調達した後、2018年2月にアイシン精機と資本業務提携を締結して以来の資金調達。今回同社に出資した投資家陣は以下の通りだ。

- グローバル・ブレイン6号投資事業有限責任組合及び7号投資事業有限責任組合(グローバル・ブレイン)

- HAKUHODO DY FUTURE DESIGN FUND投資事業有限責任組合(博報堂DYベンチャーズ)

- Sony Innovation Fund by IGV(Innovation Growth Ventures)

- SFV・GB投資事業有限責任組合(ソニーフィナンシャルベンチャーズとグローバル・ブレインが共同設立)

- DG Lab1号投資事業有限責任組合(DG Daiwa Ventures)

エッジコンピューティングを普及させるために必要なこと

Ideinが公開している資料「ディープラーニングの社会実装の鍵となるエッジコンピューティング」より

ここ数年エッジコンピューティングがホットな領域となっている背景には、サーバー集約型(オンプレ・クラウド型)AIシステムの課題がある。

「従来のソフトウェアと違いAI技術を使ったサービスの大きな違いは常時動き続けるのが基本。扱うのは画像や音声といったデータのボリュームが大きいもので、膨大な生データを処理するため計算の負荷も高い。結果的に通信コストとサーバーコストが従来のWebサービスとは比べ物にならないくらい、桁違いにかかってしまう」(中村氏)

高コストであることが現在AIの発展を阻害している1つの要因であり、まずはそれを解決したいというのがIdeinの考えだ。末端デバイスで計算を行うエッジコンピューティングの場合、サーバーに送るのは必要なデータのみ。通信回数が桁違いに減るので通信コストを削減でき、計算用のサーバーがいらないためサーバーコストも抑えられる。

加えてサーバーのスペックがボトルネックになることによるスケーラビリティの問題を回避できるほか、プライバシーの観点でも個人情報や機密情報が漏洩するリスクも減らせる。

もちろんエッジコンピューティングを普及させるためにはクリアしなければいけない課題もある。中村氏が主要なものとして挙げるのが「エッジデバイスの価格」「ソフトウェアの入ったデバイスがばら撒かれた際のシステム開発やメンテナンス」「ビジネスモデル」の3点だ。

「サーバーでやっていた計算をデバイスに持っていくので高額になりがち。画像認識機能を持ったカメラが1台数十万円で販売されているのが現状だ。また様々な場所にソフトウェアの入ったデバイスがばら撒かれた時、たとえば数千個のデバイスに1個1個ソフトウェアが入っている場合にどのようにメンテナンスを行うのかはものすごく重要なポイントになる」

「ビジネスモデルもやっかいな問題。デバイスにソフトウェアを乗っけるので、組込みソフトウェアのライセンス販売のようなビジネスになりやすく、クラウドでサブスクリプション型のサービスとはギャップがある」(中村氏)

安価なデバイスへディープラーニング搭載、遠隔運用の仕組みも

この3つの課題をクリアし、幅広い開発者がエッジコンピューティング型のシステムを構築する手助けをするのがActcastだ。

前提としてIdeinは自社のエッジ技術を使った受託開発を主力にしているわけでも、ディープラーニング用のコンパイラを販売しているわけでもない。開発者向けのクラウドサービスを提供するスタートアップであり、サービスのユーザーである開発者に対してエッジ技術を無償で提供している。

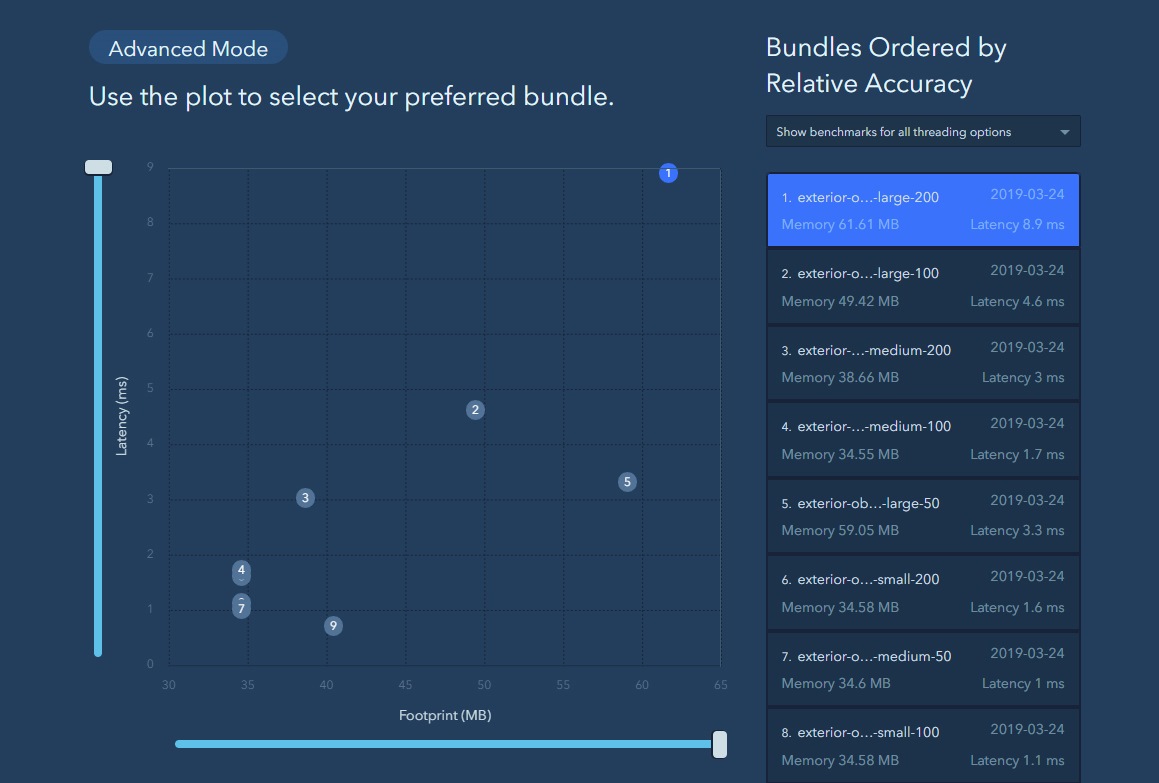

同サービスの特徴の1つは安価なエッジデバイスで高度な計算ができること。これは上述した「エッジデバイスが高額になってしまう」問題を解決する技術であり、前回の記事で詳しく紹介した点だ。

IdeinではかねてからRaspberry Pi上でディープラーニングモデルによる高度な計算を実行できる仕組みを研究してきた。エッジAIに取り組むプレイヤーはいくつか存在するが、演算量をできるだけ減らすためにモデル圧縮を採用する企業が多い。一方でIdeinはモデル圧縮ではなく“プロセッサー側をハックする”というアプローチをとった。

「自分たちがやったのはプロセッサー側に乗っているGPUを汎用的な計算に使えるように、アセンブラからコンパイラまでソフトウェアスタックを丸ごと作るということ。プロセッサーの引き出せる性能を上げるとともに、高い効率で使えるコンパイラ技術を研究した」(中村氏)

中村氏によるとモデル圧縮を採用した場合「精度の維持が難しい」ことに加え「開発者が作ることのできるアプリケーションに制約が出てくる」ことがネックになるそう。Ideinは別のアプローチを取ることで安くても精度を落とさず、なおかつ開発者がより自由にアプリケーションを作りやすい仕組みを整えた。

ユーザーはActcastのSDKを利用すると追加のハードウェアを用意せずともRaspberry Piのみでエッジデバイス向けのアプリケーションを開発することが可能。TensorflowやChainerなど既存のフレームワークで開発したモデルをそのままの精度で動かせる。

また中村氏いわくこの技術ばかりがフォーカスされがちなのだそうだけれど、実はより重要なのが「遠隔からソフトウェアを書き換えられること」だという。

「AI技術のようなものは開発者もユーザーも最初から正確なニーズを掴むのは難しく、やりながらアップデートすることが重要。やればやるほどデータも蓄積され精度が上がるので『1回作りきって現場に設置したら終わり』というやり方では上手くいかない。Actcastでは核となるアプリケーションの遠隔インストールや設定変更機能を始め、エッジコンピューティングシステムを構築しようとする際に必要な『ディープラーニング以外の部分』を一通り揃えている」(中村氏)

正式版ではApp Storeのようなマーケットプレイスの仕組みを

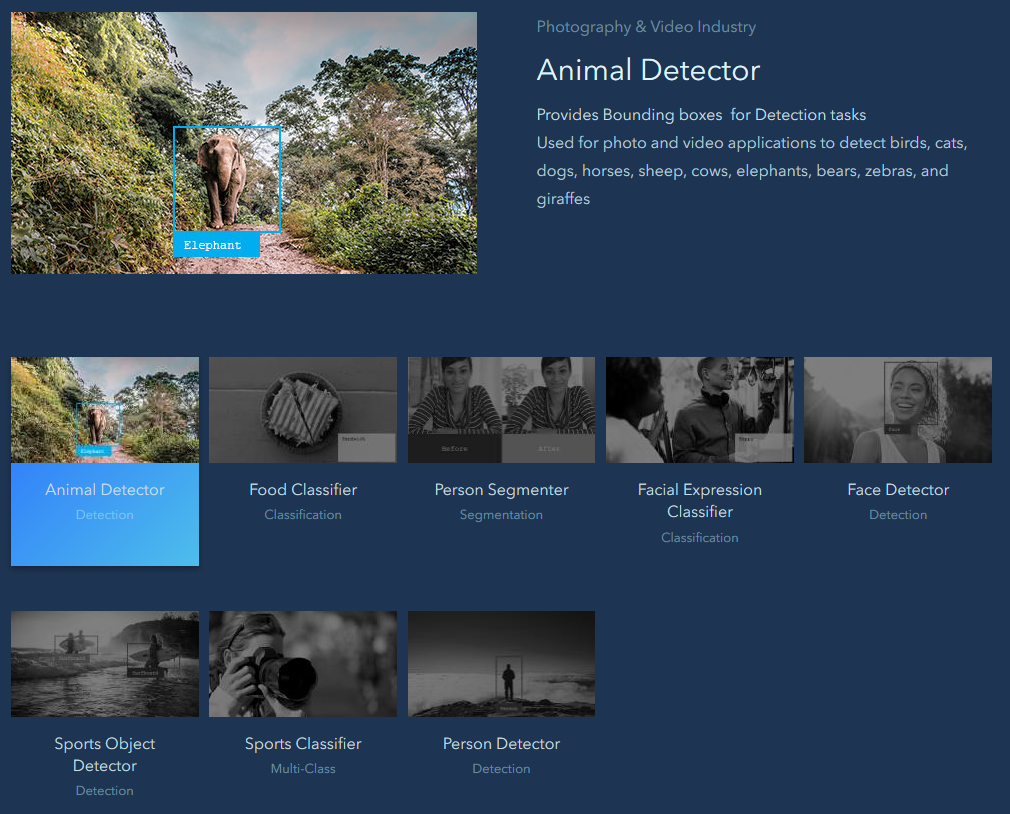

上述した特徴に加え、今後予定している正式版には同社のビジネスのキモとなる「マーケットプレイス」など新しい概念も追加される。

これはApp Storeのような感覚で、ActcastのSDKを使って開発したアプリケーションを売り買いできる仕組みだ。各アプリの価格は1デバイス、1日単位で自由に設定可能。エンドユーザーはミニマムで様々なアプリを試すことができ、ベンダーもいいものを作ればサブスク型のスケーラブルなビジネスを確立するチャンスを手に入れられる。

中村氏によるとエンドユーザー側からは特にリテールやセキュリティ業界からの問い合わせが多いそう。Actcastを上手く使えば従来は受託開発会社などと時間とコストをかけてPoCから取り組んでいたようなプロジェクトも、より安価に最小単位から現場でテストできる。これまでコストなどが理由でAI活用に踏み切れなかった企業や個人にとっても新しい選択肢になるだろう。

このマーケットプレイスはIdeinにとっての収益源でもあり、同社はApp Storeと同様にベンダーから手数料を得る計画。開発用ツールの提供などは無償で行うことで、より多くのベンダーが参加しやすい環境を作っていきたいという。

IdeinではActcastのパートナープログラムも展開中で(現在は24社が参加)、多くのパートナーとの協業を通じて魅力的なプラットフォームサービスの構築を目指すとのことだ。