Generative Adversarial Net(GAN)の人気は今がピークなのか、よく分からないが、1年前に比べると、これをいじくっている人びとの数が相当増えている。そしてそれは、すごいことだ。ウィリアムズ大学の二人の学部学生が機械学習の初歩を独学し、そして今やほとんどメインストリームの技術であるGANに関する論文を50近く読んでから、ある教授と一緒に美術作品を生成するGANに取り組み、ほぼ1年で完成させた。

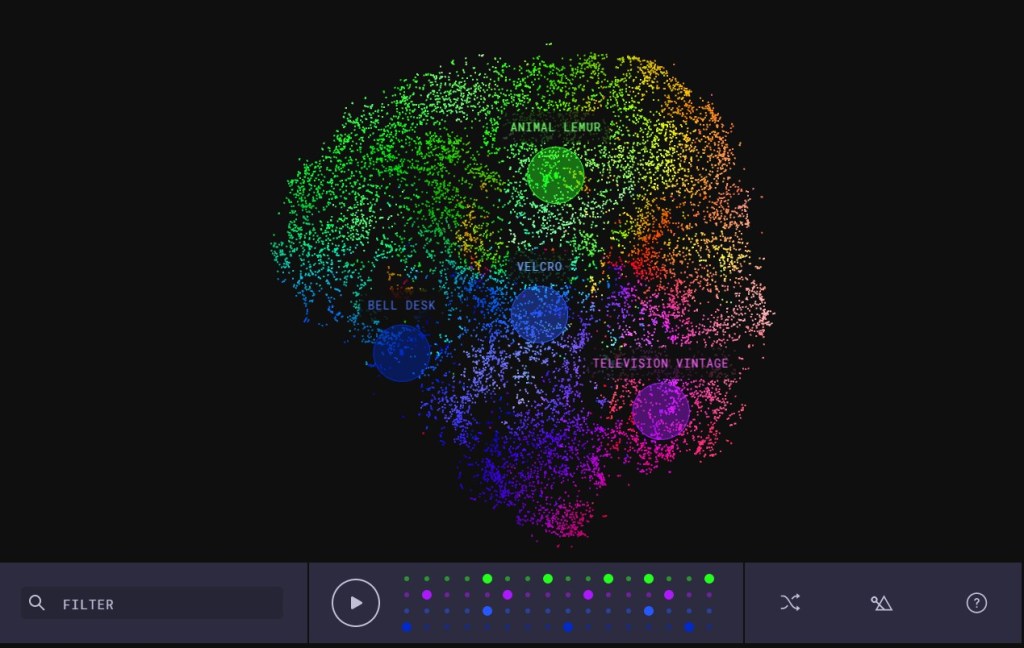

コンピューターサイエンスの学生だったKenny JonesとDerrick Bonafiliaは今年の初めごろ、Martin ArjovskyのWasserstein GAN(WGAN)に出会った。ベーシックなGANの安定性を高めたWGANは、アートの様式(スタイル)の学習や新しいアートの生成により適していることが明らかになった。

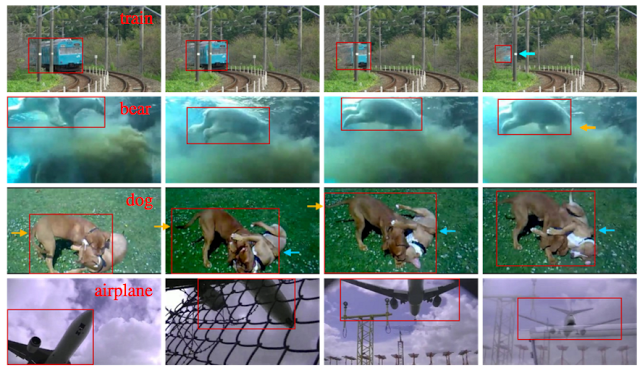

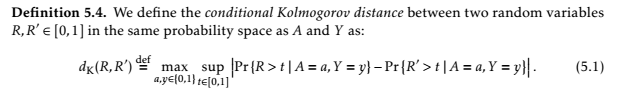

GANの基本構成要素はジェネレーター(generator, 生成部)とディスクリミネーター(discriminator, 差別部)で、両者が敵対的に対話することによって動作する。ジェネレーターは人工的な画像を作り、それをディスクリミネーターに本物と思わせようとする。同時にディスクリミネーターは、偽の画像をできるだけ多く排除しようとする。

ジェネレーターとディスクリミネーターが対決

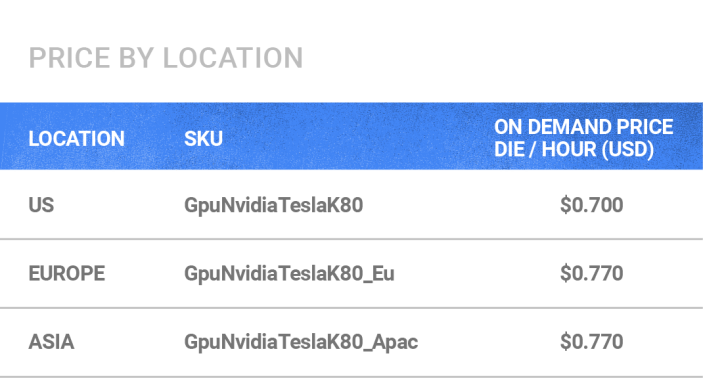

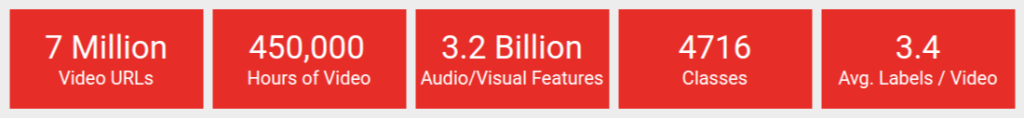

しかしGANは、不安定なことで悪名高く、まったく使いものにならないこともある。Wassersteinが改良したGANは、アートと分かるようなものを作り出す程度の安定性はある。そこでチームはWikiArtのデータベースからラベル付きの絵画10万点を取り出し、訓練用の素材として使った。

そのモデルの性能を最大化するためにチームは、ディスクリミネーターに新たな部位を加え、絵画のジャンルを予見できるようにした。またモデルが、生成される画像の“本物性”と“偽物性”にこだわりすぎるのを避けるため、予備訓練によりグローバル条件を加えた。これによりディスクリミネーターは、アートの様式の違いに関する理解を、維持できるようになった。

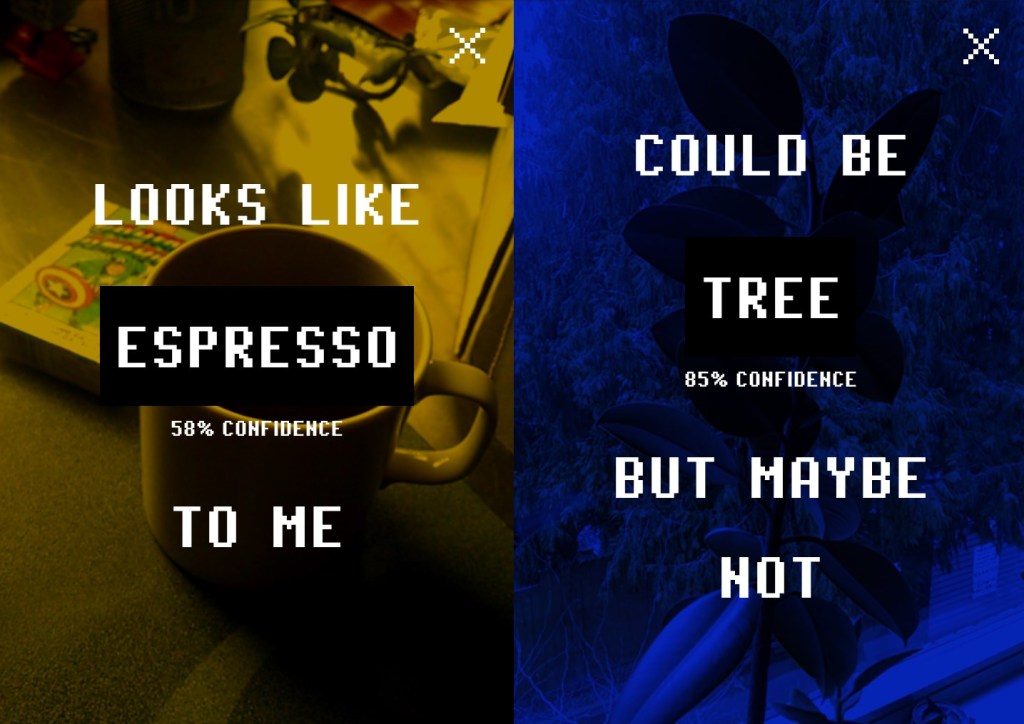

“難しいのは、成功の判定方法だ”、とJonesは語る。“そのための普遍的な測度はあまりない。それはアートに限った問題ではないが、芸術作品は通常の画像認識のように本物偽物の区別が明瞭でないから、判定がものすごく難しい”。

しかしとりあえずそのプロジェクトは成功し、JonesとBonafiliaは秋になったらソフトウェアエンジニアとしてFacebookに就職する予定だ。Bonafiliaの考えでは、もっと強力な計算機資源を使えたらプロジェクトの性能は大きくアップするだろう。Facebookには、強力なコンピューターがふんだんにあるはずだ。

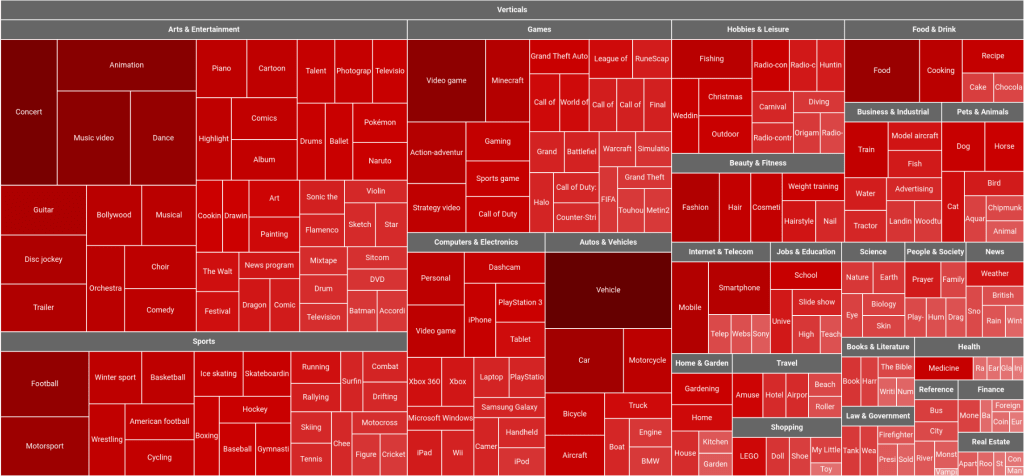

アートは今、機械学習で人気の高い素材だ。Jonesによるとその理由は、ビジュアルでしかも分かりやすいからだ。Facebookは昨年の秋に、モバイル上のリアルタイムのスタイル変換(style transfer)で関心を喚(よ)んだ〔例: 葛飾北斎のスタイルをふつうの写真に移送(transfer)する〕。JonesらGANGoghチームの作品と違ってStyle Transferは、新しいアートを作り出すのではなく、既存のストリームに(別のスタイルで)変更を加える。

スタイル変換は映画で使われている…女優のKristen Stewartは今年の1月に共著したペーパーで、彼女の短編映画Come Swimへの機械学習の応用を説明している。機械が生成した新しい作品が現代美術の美術館に展示されるのはまだ早いと思うが、今後本物のアーチストがモデルづくりに取り組んだそれらを、美術館はどう扱うか。その問題を歴史上初めて指摘した文献がこの記事だぞ、と自慢しておこう。