【編集部注】著者のKapil Kedarは、Alpine Dataのテクニカル・セールス部門のディレクターである。

最近CNNの論説で、オバマ大統領は、火星へ有人ミッション送り込む米国のコミットメントを再確認した。データサイエンス上の課題が複雑すぎると思うだろうか?火星遠征が健康へ与える影響を理解するために行う、データマイニングの難しさを想像して欲しい。

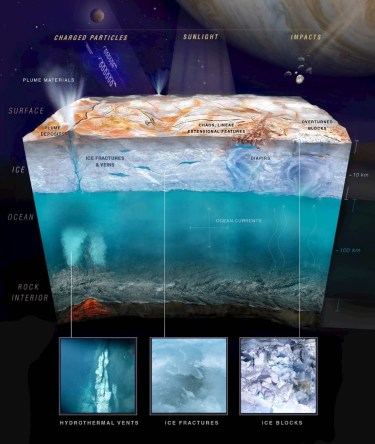

数年にわたる宇宙の滞在で、宇宙飛行士の筋力や肺活量に何が起きるのだろうか?どのくらいの体重なら安全に減らすことができるのだろうか?乗務員の居住スペースのCO2はどの程度であればよいのか?個々の宇宙服の関節の柔軟性を計算するのに必要とされているセンサーの数はいくつだろうか?

人間を「これまで誰も行っていない場所(where no one has gone before)」に送り出すときには、考慮すべき多数の変数があり、そのためにNASAは、将来の火星行きミッションに備えて健康と安全のリスク研究を熱心に行っている。これらのリスクを理解することはとても重要だ、なぜならそれらは旅行計画を行う際に必要となる多くの意思決定にインパクトがあるからだ — それはおよそ全ての項目に及ぶ。乗組員候補をどのように評価するべきかというものから、機器エンジニアリング、ミッションの物流、そして燃料の必要量の決定まで。

賭け金は高いが、NASAは最初の段階から、完璧な分析モデルの開発ではなく、意思決定者が連続的に変化する多くの疑問に分析を使って答えることができるようにするための、データサイエンスプロセスを構築することにより力を注ぐ必要があることに気が付いていた。とはいえ、NASAの分析アプローチから学ぶために、ロケットサイエンスに精通している必要はない。以下に示すのは、これからビッグデータ分析を始めようとしている組織、あるいはビッグデータ分析に行き詰まっている組織に当てはまる、有用なキーポイントである。

複雑にするな

簡単に言えば、データサイエンスはロケットサイエンスのように複雑であってはならない(そこで昔私がやっていたことを知りたい人はいるだろうか?)もちろん、ビッグデータの分析には様々な課題がある、そしてもちろん、どのような洞察を得たいかによって、アプローチも変化する。しかし、状況が必要としていること以上に物事を複雑にする必要はないのだ。

あまりにも頻繁に、多くの組織が、データ分析を行うことに集中すべきときに、ひたすら分析のためのデータ移動の無限のサイクルに落ち込んでいる。ビッグデータは、その定義から明らかなように、その移動は不可能ではないにせよ、大変難しい。Hadoopのような分散ストレージと処理のフレームワークが存在する理由はここにある — クラウド内のデータは、サイロ内のローカルデータよりもはるかにスケーラブルなのだ。

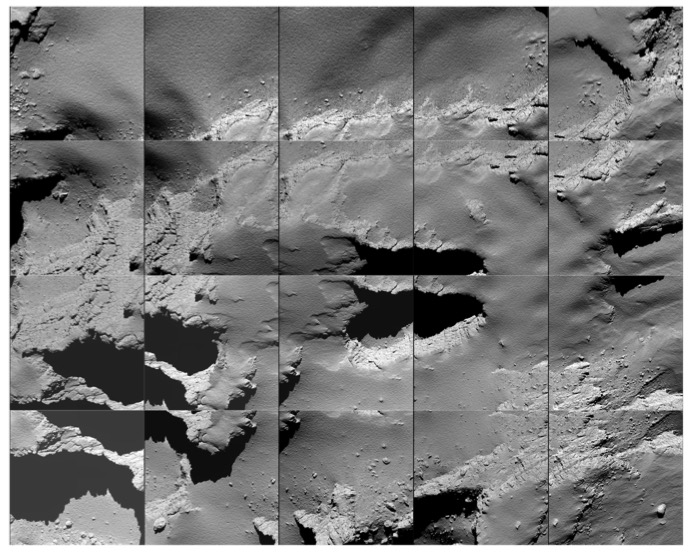

火星行きのプロジェクトでは、見るべきデータに大変多くのレベルが存在する、たとえば前回の宇宙ミッションを完了したScott Kellyのような宇宙飛行士から収集したヘルスデータから、非宇宙飛行士を使った研究や、ヒューストンのJohnson Space CenterにあるHuman Exploration Research Analog(HERA)のような模擬宇宙空間で行われる研究まで。

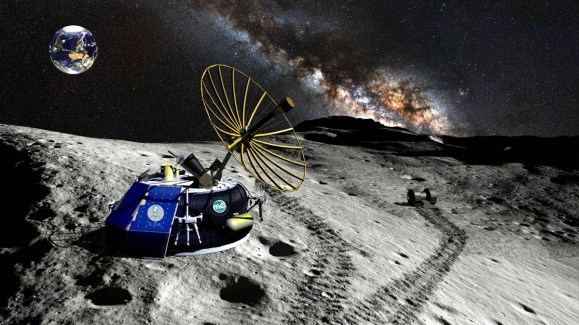

全てのデータを1箇所で得ることが、重要な最初のステップだ。このためにNASAは、Lockheed Martinを始めとする複数の分析パートナー(例えばAlpine Data)によって開発された、高度分析と情報供給のための共同プラットフォーム(Collaborative Advanced Analytics and Data Sharing platform)を用いて、データをその提供元で分析するために使っている。仕事をするために一々分離した分析環境へデータをダウンロードすることを待つ必要がないので、研究者たちはその時間とエネルギーを、火星行きミッションを計画する際の問い合わせと回答を得る作業に集中できる。

打ち上げは単なる始まりに過ぎない

ロケット打ち上げの成功は、数年にわたる火星へ遠征の最初の1ステップに過ぎない。過去の経験から、NASAはその全行程の間に、多くの問題が発生し、対処を迫られること知っている。同じことが、データ分析プロジェクトにも当てはまる。モデルをデプロイすればプロジェクトが完了するというわけではない。実際には、最も貴重な分析の取り組みは、モデルが継続的に洗練され反復される形で行われる。

データサイエンスはロケットサイエンスのように複雑であってはならない。

科学的方法と同様に、分析を最大限に活用するためには、実験、テスト、失敗からの学び、そして更なる再びテストを必要とする。米航空宇宙局(NASA)は、自由に大容量のデータを照会できるようにしたいと考えていて、これまでの知見に洞察を注ぎ込み新しいモデルを構築できるようにしたいのだ。これが、データサイエンスに関わるこの活動が「振り子」に似ている理由である、前に振り出しながら研究者の洞察を深め、後に戻しながらモデルの定量化、結果評価、そして精細化を行い、そしてまた新たな振りを繰り返すのだ。

持っているデータを使え。持っていれば良いなと思うデータではなく

素早く簡単に分析モデルを洗練することが出来る能力は、データセットは完璧ではないときに、特に貴重なものとなる。(いや実際に、完全データセットなどというものがあるだろうか?)。

NASAにとって、データ上の最大の課題は、宇宙飛行士のサンプルサイズが小さいことである — わずか300人の個人がこれまでにNASAの宇宙飛行士として受け入れられてきた。研究者らは、この小さなサンプルから収集したデータをなんとかマイニングし、外挿を行う必要があるのだ。

例えば、120ポンドの体重を持つ35歳の女性の宇宙での5ヶ月の旅の記録に基づいて、出発時32歳で123ポンドの人に2年間の間に何が起きるかを計算できるだろうか?30歳で118ポンドなら?更には、これまで宇宙飛行士が、赤い惑星に足を踏み出したことはないので、実際に火星に住むことへの健康への影響については何のデータもない(マット・デイモンは除いて)。

しかしNASAは、月へ行った、あるいは国際宇宙ステーションで1年を過ごしてきた宇宙飛行士たちから、何を学ぶことができるのだろう?模擬宇宙環境に住んでいる被験者からのデータが予測モデルに適用されたときに、何が起きるのだろうか?迅速なモデルの展開と洗練を支援する分析ツールを使用すれば、組織は例え重要な情報が欠落している場合でも、より良い予想を行わなければならない洞察を、データから引き出す様々な方法を試し続けることができる。

ブラックボックスを打ち破れ

火星ミッションでは、NASAは納税者の何十億ドルをつぎ込んでいるだけではなく、宇宙飛行士たちの命も預かっている。宇宙飛行士達は科学と探求の名のもとに、彼らの健康と安全をリスクに晒すのだ。

分析の他の消費者と同様に、NASAは結果として得られた提案が信頼できるものであるようにする必要がある、しかし、もしこうした予測が、データサイエンスの専門家だけが扱ったり理解できる「ブラックボックス」ので計算されている場合にはそうした信頼の獲得は難しい。

このようなプロジェクトのためには、データサイエンスの博士号を持たない分析結果の利用者たち(ヘルス研究者、機器エンジニア、その他のミッション計画実施者たち)の力を拡大して、自分自身のデータに対して実際に問い合わせを組み立てて実行できるようにすることが鍵である。これは、ビジネスとITステークホルダーの間の緊密な協力を必要とし、同時に利用と変更が簡単で、必要な人へ洞察を届ける能力を持つツールも必要とする。これがNASAが共同分析プラットフォームを選んだ理由である。このプラットフォームには、火星ミッションで働く科学者と意思決定者たちによって使われているシステムとアプリケーションに直接出力を展開するツールが含まれている。

大規模で複雑なデータセットは、分析の展開に着手しようとするどのような組織に対しても、課題を提起する。しかし、NASAによるデータを最も複雑な旅(火星への遠征)へと結びつけようとする例は、その課題が乗り越えられないものではないということを証明している。適切なツールと、最も重要な一貫性のあるよく計画されたアプローチを使えば、データサイエンスはロケットサイエンスのように困難なものとはならない。

注:Lockheed MartinのInformation Systems & Global Solutionsは、現在Leidos Holdingsの一部である。

[ 原文へ ]

(翻訳:Sako)