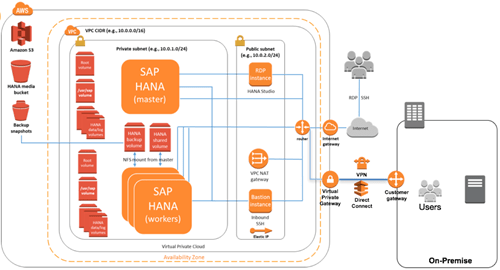

Amazonは、ラスベガスで開催中のAWS re:Invent会議で、新しいサービスAWS Fargateを発表した。このサービスを使うことで、実行インフラストラクチャについて考えることなくコンテナを運用できるようになる。

これは注目すべきアイデアだ。コンテナを起動して、Kubernetesや他のオーケストレーションエンジンをマネージャとして動作させ、AWSが必要となるハードウェアをすべて賄う。

新しいサービスを発表したRandall Huntのブログ記事では「簡単に説明するなら、FargateはEC2と似たようなものですが、仮想マシンを提供する代わりにコンテナを使うことができるものです。これは、基盤となるインスタンスを管理することなく、コンテナを基本的な計算プリミティブとして使用できるようにするテクノロジーです」と説明されている。

AWSのCEOであるAndy Jassyは、re:Inventのステージでこの新しいサービスを紹介し、とても簡単に利用できることを強調した。タスクを定義し、アカウントとアクセス管理要件と必要なメモリとCPUを指定すれば、Fargateが残りの作業を行う。サーバーやクラスタの調達について心配する必要はなく、自動スケール機能も備えている。

このサービスは、インフラストラクチャを管理する複雑な仕事を、簡素化してくれるものだ。もちろんインフラストラクチャーの管理を自分たちで行いたい企業もいるし、そうした企業のためにはEC2が用意されているが、インフラストラクチャー管理をやめてしまいたい企業はFargateを利用し、AWSに全てを任せることが可能だ。

さらに、特定のアプリケーションの要件に合わせてFargateを設定すれば、各コンテナに必要なリソースに対してのみ支払いが発生する。

本日発表されたこの出発点から、さらなる拡張計画もある。AmazonはAmazon EKSも発表した。これはAmazon版Kubernetesである。ブログの記事によれば、EKSと組み合わせてFargateを使ってコンテナを起動することができるということだが、理にかなったアイデアだ。

本日(11月29日)、Fargateは米国東部(バージニア州北部)リージョンでの提供が始まった。

[原文へ]

(翻訳:Sako)