Googleが、同社のオープンソースのコンテナオーケストレーションサービスKubernetesのニューバージョンバージョン1.3を発表した。

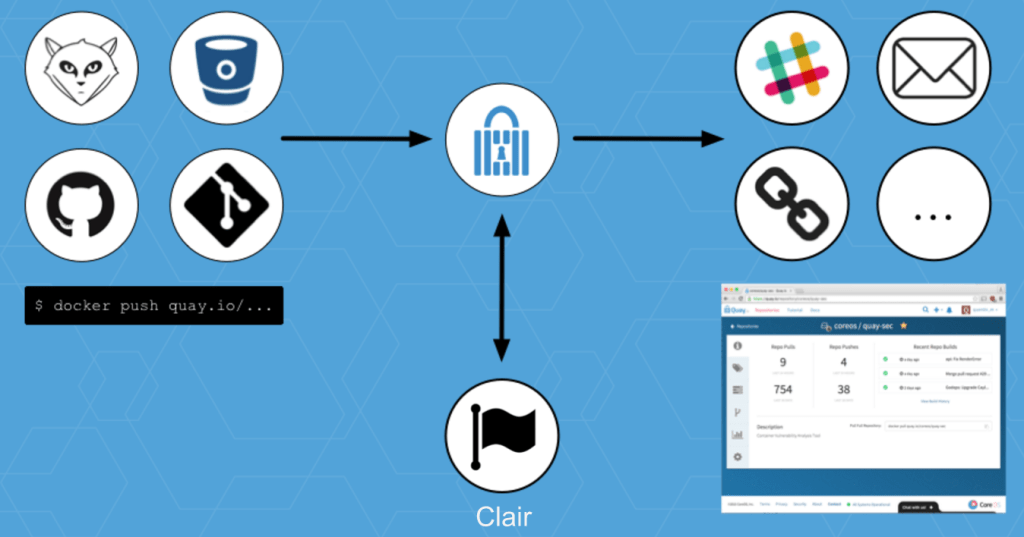

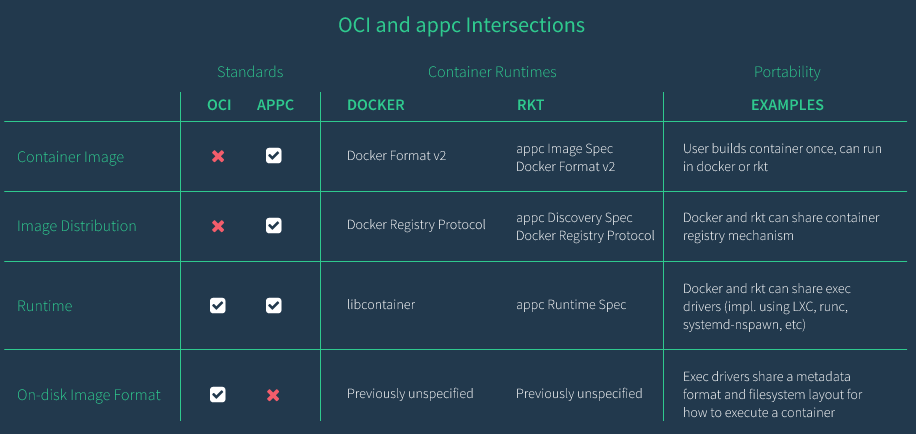

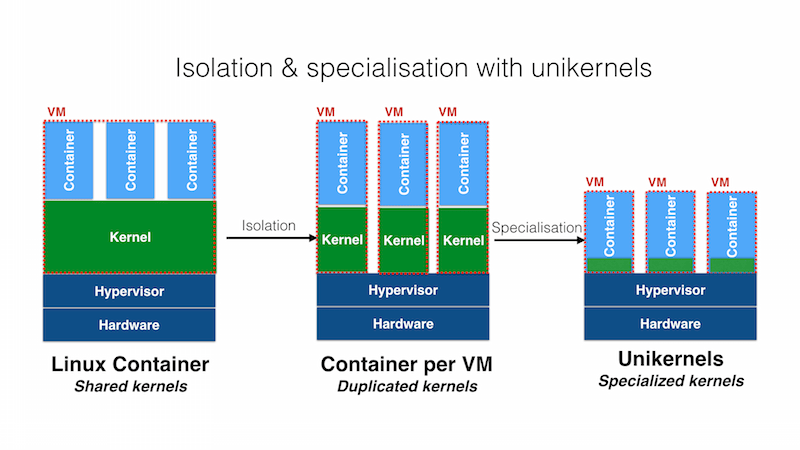

1.3は、プロダクション(本番稼働)におけるコンテナを管理するための、よりスケーラブルでロバストなシステムをユーザーに提供することに焦点が当てられている。また、今度のKubernetesは、CoreOSのrktやOpen Container Initiative (OCI)、Container Network Interface(CNI)などが提起している新しい規格もサポートしている。

GoogleのプロマネAparna Sinhaが、今日(米国時間7/6)の発表声明でこう書いている: “ユーザーが自分たちのプロダクションのデプロイをスケールしていくに伴い、サービスを複数のクラスターやゾーン、あるいはクラウドの境界にまたがって利用したい、という声が大きくなっている。また、ステートフルなサービスなど、もっと多くのワークロードをコンテナ化したい、という要望もある。今回のリリースでは、これら二つの問題への対応にとくに力を入れた。また、新しいデベロッパーやエンタープライズがより容易にKubernetesを利用でき、彼らが大小さまざまなスケールで分散システムを管理できるよう心がけた”。

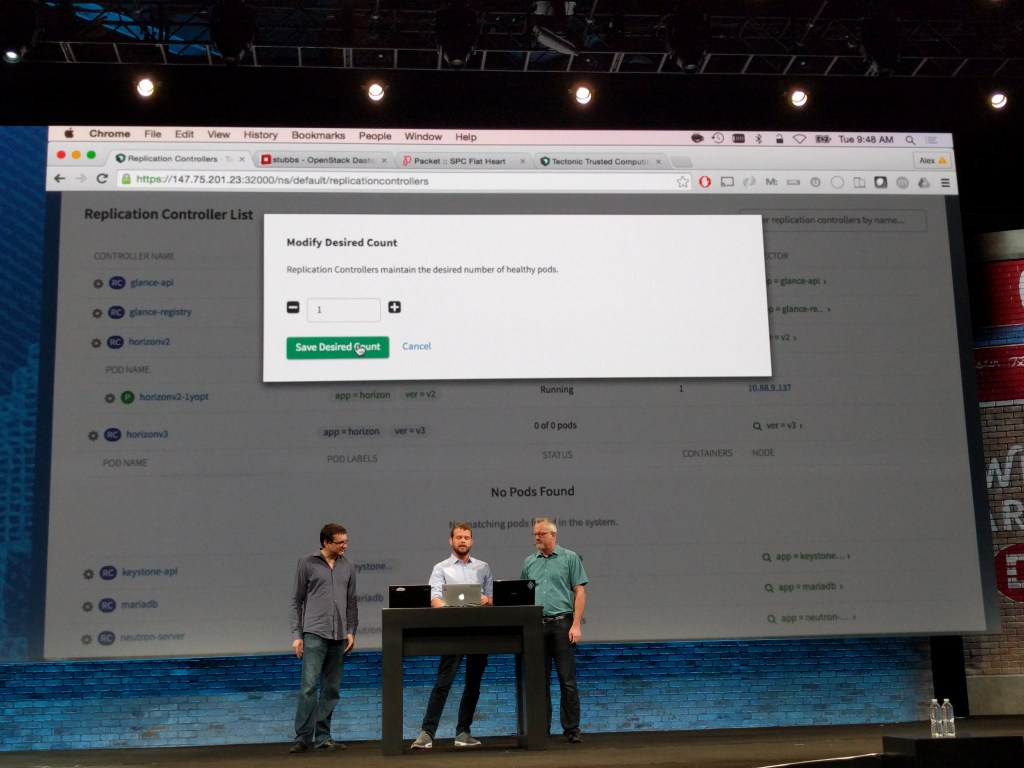

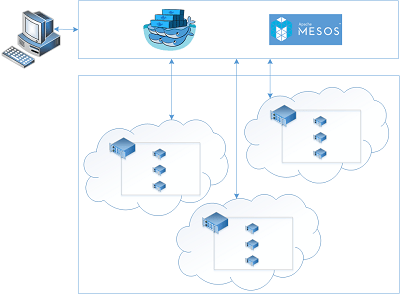

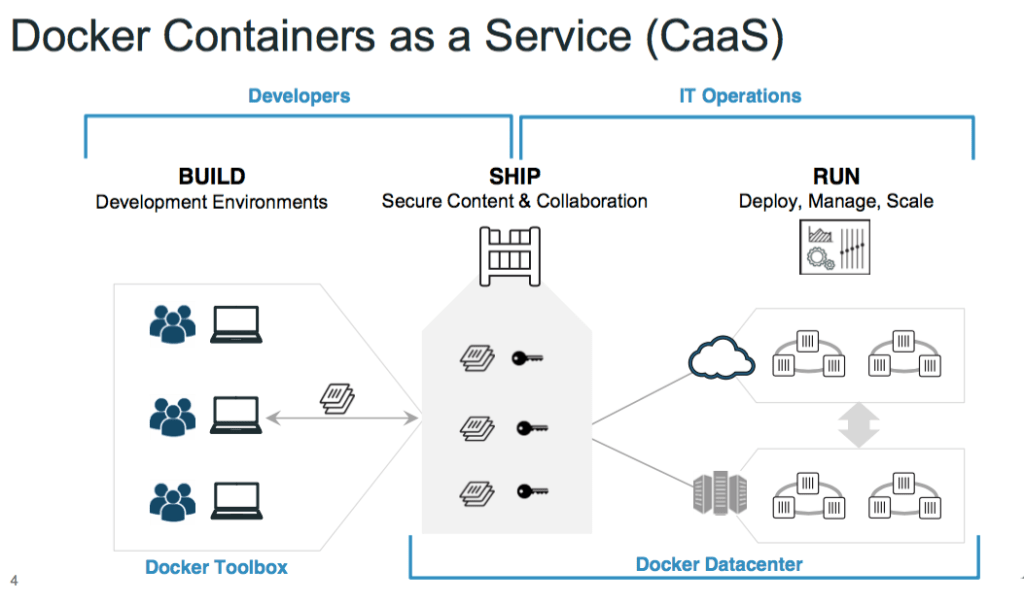

今回のアップデートでユーザーは、複数のクラスターから成るサービスをセットアップでき、しかもそれらは複数のクラウドからホストされていてもよい。Googleによると、これによってハイブリッドでマルチクラウドなシナリオにも対応でき、停電などの事故にも強い高可用性のクラスターを作れるようになる。

ニューバージョンのKubernetesは、データベースのようなステートフルなアプリケーションをコンテナで動かしたい、という多くのデベロッパーの要望にも応えている。関連して、オートスケーリングのサポートも改良され、“これからの顧客はクラスターのサイズを気にする必要がなく、デベロッパーは、クラスター自身が需要の変化に対応できる、と期待してよい”、とGoogleは言っている。

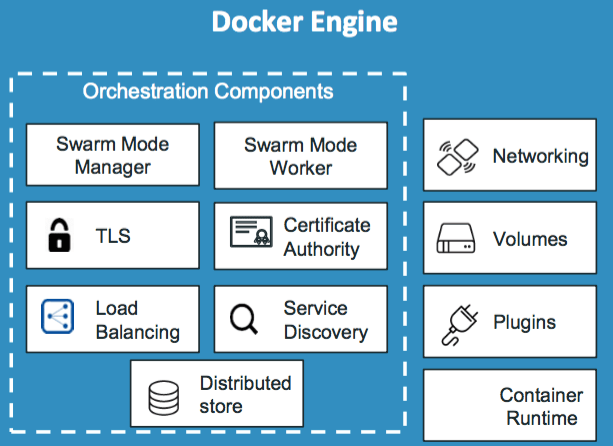

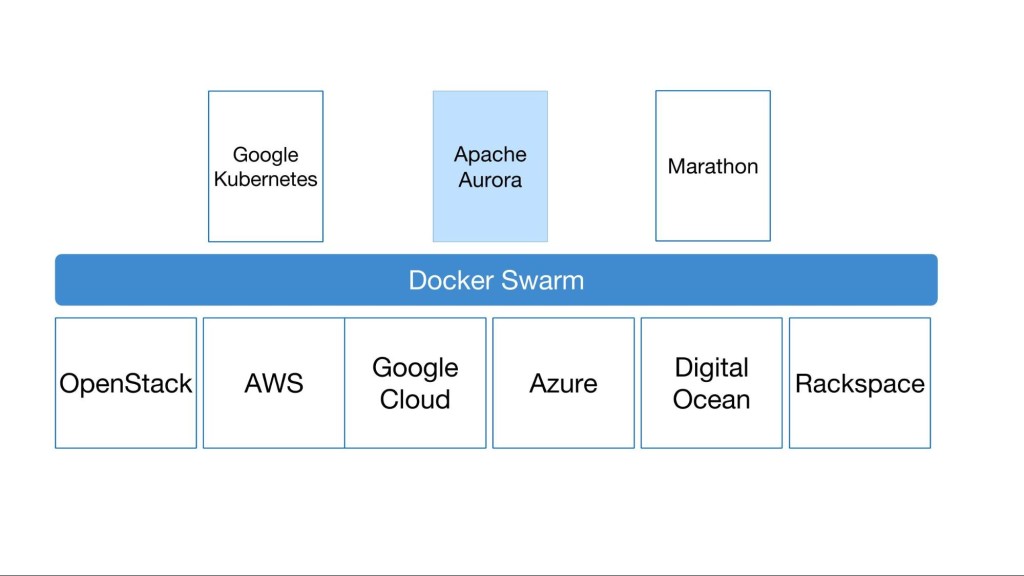

Dockerのランタイムに対する代替的なコンテナランタイムとしてrtkのサポートが加わったことは、それほど意外ではない。GoogleはKubernetesが、拡張性のあるオープンなプラットホームであることを望んでおり、コンテナへのニーズも多様であることを知っている。Dockerの、自由でプラッガブルな性質はもともとKubernetesにも合っているが、それにもかかわらず、あえてユーザーに、自分の好きなパーツの利用を許そう、というのだ。

Kubernetes 1.3はGoogleの、このところ人気が盛り上がっているContainer Engineサービスにも展開される。これは基本的には、Googleのクラウドプラットホーム上の完全な管理を伴うKubernetesサービスだ。Googleによると、Container Engineのユーザーは90日ごとに倍増しており、また今回のKubernetesのニューバージョンにより、ユーザーはひとつのクラスタでこれまでの倍のノード(最大2000まで)動かせる。そしてサービスは、複数の可用性ゾーンにまたがって利用できる。