Google(グーグル)は米国時間9月4日、同社の主要プロダクトで使っている差分プライバシーライブラリ(参考:日本語ブログ記事)のオープンソースバージョンをリリースした。デベロッパーはこのライブラリを使って独自のツールを作り、社内社外に個人を特定できる情報を明かすことなく、集積されたデータを利用できる。

同社のプライバシーとデータ保護部門のプロダクトマネージャーであるMiguel Guevara(ミゲル・ゲネヴァラ)氏は「あなたが、都市計画のプランナーや、中小企業の経営者、ソフトウェアデベロッパーなど、どんなお仕事をしていても、データから有益な知見が得られれば仕事の質を向上し、重要な疑問に答えが得られるようになる。しかし強力なプライバシー保護がないと、あなたは一般市民や顧客、そしてユーザーの信頼を失うリスクを負う。差分プライバシーによるデータの分析は道義にかなったアプローチであり、企業などの組織が多くのデータから学べると同時に、それらの結果から絶対に個人のデータが識別されたり、特定されないようにする」とコメントしている。

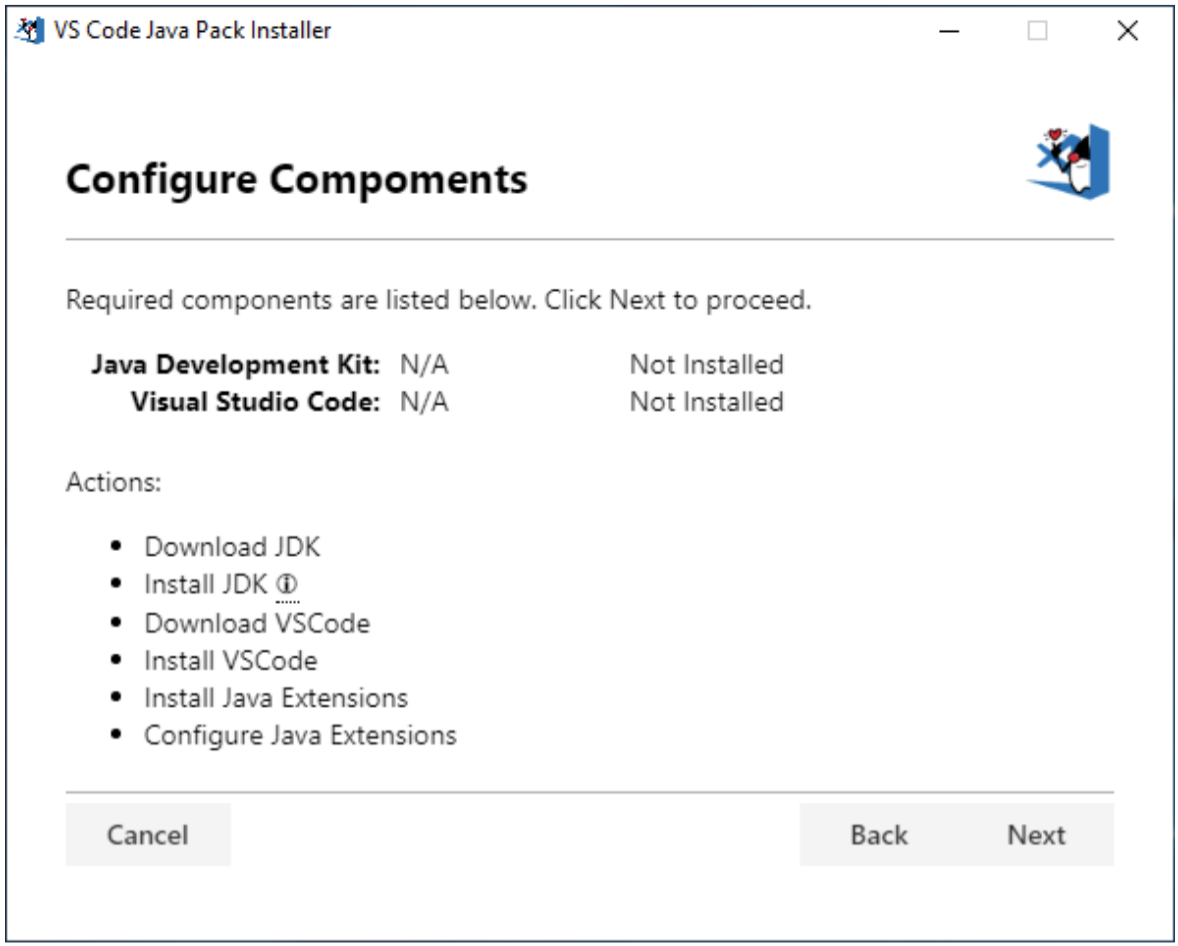

Googleの注記によると、このApacheライセンスによるC++ライブラリは、スクラッチから作ることが通常は困難な機能にフォーカスし、デベロッパーが必要とする標準的な統計関数が多く含まれている(計数、和、平均、分散、などなど)。さらに同社は、このライブラリに「厳密なテスト」のための補足的ライブラリが含まれていることを強調している。差分プライバシーを正しく得ることは、難しいからだ。その他PostgreSQLエクステンションやデベロッパーの仕事をサポートするレシピ集なども含まれている。

最近では、同じ文の中に「Google」と「プライバシー」があると、思わず注目してしまう。それも当然だ。Googleの社内にはこの問題をめぐって相当な軋轢があるのだろうけど、でも今回のオープンソース提供は疑問の余地なくデベロッパーの役に立つし、デベロッパーもユーザーも、人びとのプライバシーを侵す心配なく、彼らが作るツールでデータを分析できるようになる。差分プライバシーはかなり専門知識を要する技術だから、これまでは手を出さないデベロッパーが多かった。でもこのようなライブラリがあれば、差分プライバシーを実装しない言い訳がなくなる。

画像クレジット: Bloomberg/Getty Images

関連記事:Appleは差分プライバシー技術を利用して個人データに触らずにSafariの閲覧データを収集

参考記事:一般人が差分プライバシーを理解するためのスライド

[原文へ]

(翻訳:iwatani、a.k.a. hiwa)