SEO Bookのアーロン・ウォールが米国SEO業界の重鎮二人とペンギンアップデートに関して語りつくしたインタビュー記事を。普段は表には出てこない米国のSEO事情が垣間見えて大変興味深い内容となっています。 — SEO Japan

Googleが、大きなアルゴリズムのアップデートを行うと、大勢のウェブマスターは、慌ててデータをチェックし、ランキング、および、検索トラフィックに関する変化を確かめ、続いて、トレンドを見出し、変化を解明しようとする。

大きなアルゴリズムの変更が行われる際、通常、私はジョー・シンクウィッツとジム・ボイキンに連絡を取る。先日も、ペンギンアルゴリズムに関して、この二人に意見を求めた。

今回は、次のトピックについて話し合ってもらった:

- ペンギンアルゴリズムとは?

- どのようなインパクトをもたらすのか?

- なぜ、しばらくアップデートされていないのか?

- 問題が、ペンギンに関連しているのか、あるいは、ペンギンとは関係ないのかを判断するには、どうすればいいのか?

- (ペンギン、および、手動のリンクペナルティからの)回復のプロセス

- その他諸々

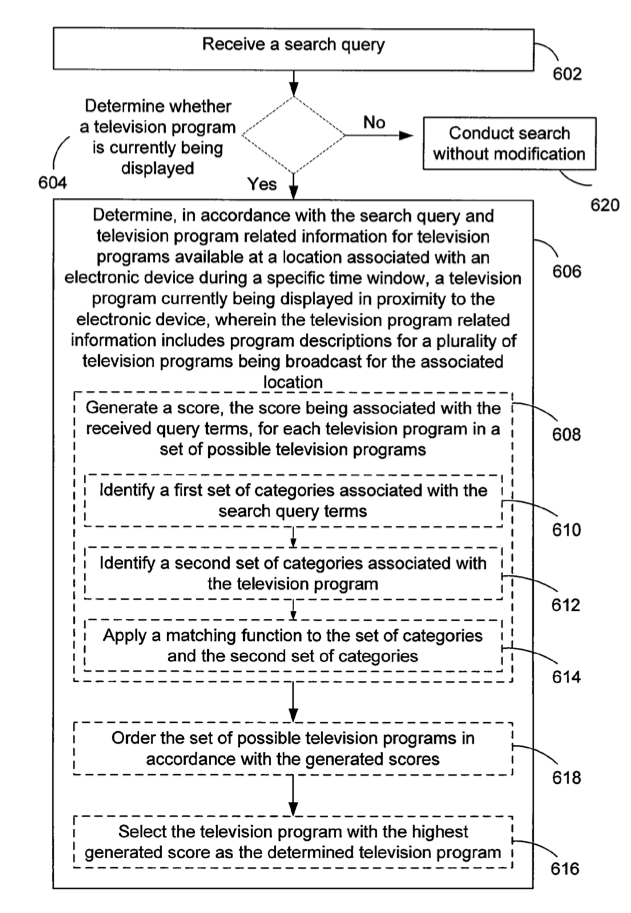

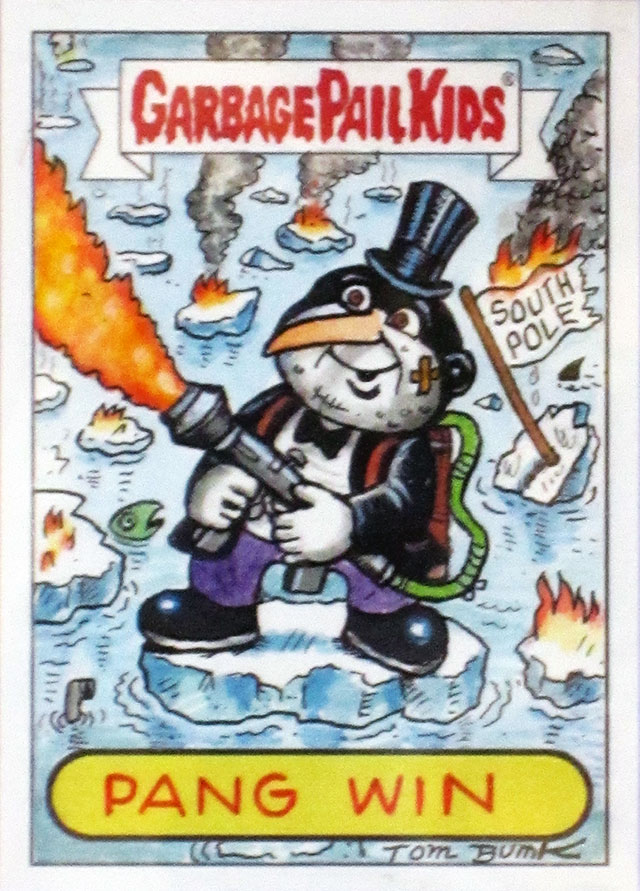

今回のインタビューのために、特別に発注した絵を以下に掲載しておく。

このイメージをウェブサイトに埋め込みたい方は、以下のコードをコピー & 貼り付けしよう。

現在までに、5回のペンギンアップデートが行われている:

- 2012年4月24日

- 2012年5月25日

- 2012年10月5日

- 2013年5月22日(ペンギン 2.0)

- 2013年10月4日

しばらくの間、アップデートは行われておらず、まだ復帰することが出来ていない大勢のウェブマスターにフラストレーションを与えている。それでは、早速、インタビューに移ろう…

根本的に、Google ペンギンとは何か?

ジム・ボイキン: ペンギンとは、ペナルティを引き起こすリンクフィルターだ。

ジョー・シンクウィッツ: 根本的には、品質の低いリンクプロフィールを持つサイトに罰を与えることを目的とした、アルゴリズムベースのバッチ処理のフィルターだと見て良い。

ペンギンでは、通常、どの程度ランキング、および、トラフィックの減少が生じるのか?

ジム: 30-98%。一部では、トラフィックに関しては、ほとんど変わらない「手動の部分的なマッチング」も見られたが…これは稀なケースだ。

ジョー: ほぼ全面的な減少だと言えるだろう。もう少し詳しく説明しよう。ペンギン 1.0は、後のペンギンとは一線を画す。初回のペンギンは、ほぼ固定のフラグ形式を採用していたが、後のペンギンは、初回ほどシビアではない。

初回のアップデートが行われた1ヶ月後、再びアップデートが行われ、その後、約6ヶ月おきに行われるようになった。前回のアップデートから既に10ヶ月が経過している。なぜ、ペンギンのアップデートは、頻度が少ないのか?また、なぜ、前回のアップデートから、期間が長くあいているのか?

ジム: 良い質問だ。誰もが6ヶ月おきにアップデートが行われると考えていたが、既に6ヶ月以上経過している…マット・カッツが休暇を取っているからか…あるいは、逆に、次回のアップデートの予定時期が、まだまだ先であるため、マットは休暇に出掛けたのか…もしくは、Googleは、ペナルティを受けたウェブサイトに、半年間以上、苦痛を味あわせたかったのかもしれない。

ジョー: 1.0は、サイトを301することを厭わない場合、一時的に逃れることが可能であった。1.1以降は、リダイレクトしてもダメージが出るようになった。最新のアップデートまでに、随分と長く時間がかかっているのは、出来るだけ大きな苦痛を与えたいからだと私は思う — Googleは、ウェブマスターを苦痛から、まだ解放するつもりはなく、どんなに低姿勢で懇願しても、許してもらえない。その上、クリーンなリンクプロフィールのほぼ全てを否認してしまう輩がいる。そもそも、「汚い」リンクと「綺麗」なリンクを区別するのは、容易ではない。

ジム: 大半のウェブマスターは、一部のリンクを否認し、続いて、さらに否認するリンクを増やす…1年待って、全てのリンクを否認している気がする :)

ジョー: 同感だ。

ジム: その後、Googleは、…からかい半分で…ペナルティから解放する。

ジョー: 98%以上のリンクを否認したサイトを見たことがある。Wikipedia、Yahoo!ディレクトリをはじめとする、素晴らしいソースのリンクもその中に含まれていた — 勿体ない。

ジム: 同じようなサイトを私も知っている。ほとんどの人は何も分かっていない…トラフィックが落ち、ペンギンに捕まったに違いないと考え、リンクの否認を始める人達が多過ぎる。

ジョー: その通りだ。パンダに捕まったものの、すぐにリンクを否認したがる人達は多い。まずは、落ち着くことが必要だ。

ジム: ペンギンペナルティからの解放を約束するサービスが存在する。と言っても、リンクの全てを否認するだけだ。確かに、手動のペナルティからは解放されるかもしれないが、これでは何も残らない。

ジョー: ついでなので、ペナルティから逃れることを約束するのは、まやかしに過ぎないと言っておこう。

ジム: あるいは、サイトに寄せられている全てのリンクを否認しているだけだ。

たった今言及した「サイトに寄せられている全てのリンク」の件は重要だと思う。それでは、どのリンクのソースを利用するべきなのか?また、Google ウェブマスターツールのデータは、どの程度網羅しているのか?ウェブマスターツールのデータは、サイトを復帰させる上で十分なのか?

ジョー: 十分とは言えない。Ahrefs、Majestic SEO、ウェブマスターツールで、手動のアクションを見つけ、リンクを一掃したにも関わらず、Googleに、ウェブマスターツールのデータリストには掲載されていなかったリンクを問題視されたケースに遭遇したことがある。事実、1年間にわたって、リンクの否認と削除ばかり行ってきた優良ドメインを買ったクライアントを私は抱えている。Googleは、休む余裕も与える気も、仕切り直しさせる気もない。

ジム: まず…Googleからリンクを得ているなら、サイトのwwwバージョンと非wwwバージョンの被リンクを考慮する必要がある。一つだけではなく、両方の被リンクを取り出さなければならない。つまり、ウェブマスターツールを使って、wwwと非www版を検証する必要がある。

弊社では、まずは、この作業から始めることが多い。原因と思われる大きなパターンを見つけたら、Open Site Explorer、Majestic SEO、そして、Ahrefsを開き、同じ被リンクを探し出し、さらに、パターンに一致するリンクを引っ張り出す。ただし、Googleで被リンク分析を最初に実施するようにしている。

先ほど、パンダに捕まったものの、勘違いして、リンクを否認する人達がいると言っていたが、ペンギン、パンダ、手動のリンクペナルティを見分けるにはどうすればいいのか?

ジョー: Googleは、アップデートを重ねて繰り出し、見分けにくくしている。この点を鑑みると、良い質問だと思う。ペンギンは、リンクを最も重要視している。簡単に見つけられるものの、修復するのは最も難しい。初めてウェブサイトを訪れる際は、アンカーの%、リンクのソース等を確認する。ペンギンと手動のリンクペナルティの大きな違いは(ウェブマスターツールを確認していない場合)、タイミングだ — 時限爆弾とスナイパーの違いと言うことも出来る…大勢のウェブマスターが、不満をもらしているなら、アルゴリズムだ。数名が文句を言っているなら、手動のアクションが行われたのだろう。手動のアクションの場合、ウェブマスターツールに通知が届いている。パンダに関しては、まずは、ページ上で、悪質なキーワードスタッフィング、薄いコンテンツ/コンテンツの重複を発生させる奇妙なインフラ構造等をチェックして、エンゲージメントの数値、さらに…外部でサポートされているページ:インデックスされているページの合計の比率を検証するようにしている。

ジム: 手動に関しては、何度も投稿を繰り返し、判断してもらうことが出来る。アルゴリズムのアップデートの場合、次回の更新を待ち、十分に対応を講じて、復帰させてもらうことを願うしかなく、まさに踏んだり蹴ったりの状態だ。

手動ペナルティに関して、Googleとやり取りをすること自体は、特に問題視していない。少なくとも、答えを得られるからだ。

トラフィックが減ったら、パンダとペンギンが行われた日付と照らし合わせれば、見極めることが出来る。アップデートの日付とは関係なく、トラフィックが減っていたら、ペナルティではなく、ただ単に、その日は、たまたまトラフィックが減っただけなのかもしれない。

ジョー: このインタビューを受けている最中に、スタッフから連絡をもらい、domain.com/?var=var&var=varのようなURLで、手動アクションに拒否された、と言う報告を受けた。実際には、既に、ドメイン全体が否認されていた。検索のことをよく知らない第三者が、適当にレビューしただけでは、何とも言えない。

ジム: その通り。昨日、SEOchatに投稿した記事で同じ指摘をした。レビューの担当者は、絶対に真剣に検証を行っていない。

復帰を100%保証するソリューションは、まやかしに過ぎないと指摘していたが、復帰する確率はどの程度あるのか?また、復帰に力を入れる意味があるのは、どのようなケースか?反対に、新しいサイトを始めた方が無難なのは、どんな時か?また、双方を同時進行すると良いのは、どんな時か?

ジム: 私はサイトを守る努力をしている。「このサイトは、もう手遅れだから、新しくサイトを始めた方が良い」と言ったことは一度もない。リンクは非常に重要であり、サイトに向かうリンクをたった数本でも救うことが出来るなら、私は手を尽くす。二つのサイトに取り組むアプローチは好きではない。コンテンツが重複する問題を生みだし、また、2つのサイトに対応しなければならないためだ。

ジョー : 何に違反したかに左右される。パンダ、手動アクション、そして、ペンギンの2回目以降のアップデート(理論的には、最新版の更新も含む)から、サイトを復帰させることに私は成功してきた。ただし、ペンギン 1.0に捕まったサイトの救出を要請されても、料金は受け取れない…無料でアドバイスを送り、データベースを追跡するリストには加える。ただし、確実にペンギン1.0であり、否認ツールを利用した結果、回復したものの、技術的な理由ではなく、意図的に回復するケースは、ごく稀である。

短い期間において、うまくやれば、リダイレクトとカノニカルは、今でも一定の効果をもたらす…ただし、戦略を変更するほど、改めて力を入れるような取り組みではない。

否認プロセスに関して、先ほど、一部のリンクを否認し、時間の経過と共に、さらに多くのリンクが否認している、と述べていたが、Googleは、主に苦痛をもたらすために、プロセスを長引かせているのだろうか?あるいは、集めたデータを何らかの方法で活用しているのだろうか?

ジョー: 間違いなく、わざと長引かせている。数学的な観点から見て、下降を引き起こす閾値はX%で、回復を引き起こす閾値はX-10%だと考えられる。さらに、当初、Googleは、否認のデータを大いに気に入っていたものの、神経質になり、何でも否認する行為が続出してしまった。このシグナルをもてあそぶため、意図的に多くの質の高いサイトを否認する巨大なネットワークを持つ集団を私は知っている :)

ジム: 苦痛を与えるためだ :) … データを活用しているかどうかは不明だが、その可能性はある。Googleなら、無料でリンクを手に入れましょう-directory.com等のサイトからのリンクを大勢のウェブサイトが否認していることを容易に特定し、「誰もこのリンクを信頼していないようなので、このサイトを追放し、リンクのカウントをやめる」判断を下すことが出来る。

自分達が所有しているツールで、同じ行為をすることが可能だ…ドメインが否認リストに登場する回数を数え、否認した回数を数えよう…例えば、spam.comが20回否認リストに登場し、20回とも否認している…あるいは、good.comが20回にわたって登場し、1度も否認していないなら、簡単に判断することが出来る。Googleも同じようなことをしているはずだ。

Googleが、引き延ばしていると仮定すると、手動ペナルティにおいて、追加の要請で、作業をスケールアップさせていく中で、苦痛を味わい、苦労をしていることをGoogleに分かってもらうため、徹底した取り組みを行う意味はあるのか?初回の取り組み、次回の取り組みにおいて、どの程度のリソースをつぎ込めばいいのか?通常、いつ頃回復するのか(再審査リクエストの回数)?

ジョー: 「否認」および「申告」を行う際は、さらに深い苦痛の留意事項が存在する可能性を自覚した上で、複数のレベルで実施するようにしている。1回目の挑戦で復帰したケースもないわけではないが、通常、3回以上、再審査リクエストを投稿する。

ジム: 2、3回、再審査リクエストを送信する必要がある…私は最初から「大胆」な取り組みを行い、さらに「スケールアップ」させていく。

と言っても、これはサイト全体のペナルティの話だが…

サイト全体のペナルティが、一部に縮小されることもある。一部に縮小されたら、遥かに容易に、影響を受けていないページに向かうリンクを残しながら、問題を特定し、対応することが出来るようになる。

サイト全体のペナルティは、サイトを壊滅させる…一部のペナルティでは、ランク付けの対象になるものもあれば、対象にならないものもあり…サイトの一部に限定されていれば、問題を解決する自信が湧いてくる。

先ほど、良質なリンクを否認してしまう、あるいは、否認する必要がないにも関わらず、リンクを否認してしまうミス、そして、新しいサイトに対処する際に、過去の否認のデータを活用することが出来ると言っていたが、自分で回復作業を行う方が良いケース、または、プロを雇って代行してもらう方が無難なケースを挙げてもらいたい。被リンクプロフィールの規模に応じて、大体のコストを算定する際に役立つ目安はあるのか?

ジョー: 知識に左右される。ペナルティの原因を自分で作ってしまった場合、すくにプロを雇うよりも、まずは、その原因を解消する試みを行うことも出来る。苦痛に「全力を注いでいる」姿を見せることで、1度目の否認が却下された際に、必死さが伝わる可能性がある。また、機会費用(選択肢Aを採用することで失われた選択肢Bを採用した際に得られた利益)にも左右される。予想される修復の可能性を考慮し、修復につぎ込む自分の時間の価値を考えると良いだろう。

ジム: 私の会社では、分析に5000ドル、そして、リンクを削除するプロセスに新たに5000ドルを課金する。高過ぎると思うかもしれないが、良質なリンクを削除してしまうと、そして、劣悪なリンクを残してしまうと、壊滅的なダメージを被る可能性がある。まさしく科学的な取り組みであり、誤ってしまうと、5000ドル以上の被害が出る…私自身がこのサービスを販売しているように、プロに相談することを薦める…そもそも、リンクの専門家ではないにも関わらず、なぜ自分でやろうとするのか、私には理解できない。

ちなみに、このサービスでは、追加費用なしで、サイトを回復させることが出来るまで責任を持って対処する。

ジョー: 良い心掛けだ。

ジム: どうも。

先ほど、既に否認されているリンクを理由に、再審査を却下されるケースに触れていたが、Googleのレビューワーが多くのミスを犯すことを考えると、否認ツールを使うよりも、積極的にリンクを削除した方が良いのか?リンクを削除する最良の戦略を教えてもらいたい。

ジョー: DDoSかな。

ジム: そういう手があったか(笑)。

ジョー: リンク否認サービスを利用する際は、素直に、そして、正直になるべきだ(1本1本対処していくよりも、私ならツールを使って、まとめて実施する)。

ジム: 実際に、リンクを削除する人は1%程度である。Googleに対して、リンクを削除することに疲れたとアピールするのが、本当の狙いだ。

ジョー: ペナルティを科されたことをリンクの所有者に伝えよう。自分のウェブサイトが、被害を受けているため、整理しているだけであり、無理なお願いをしていることを弁えて、礼儀正しく要請する必要がある。

私のサイトは、ドメインの規模が大きいため、様々な戦略の対象にされたこともある。かつては、料金を払って私のサイトにリンクを張った人物から、要請を受けることなく、いきなり訴えられたこともある。

ジム: 3回ほど削除を申請し、リンクに関するメッセージを送ったなら、再審査リクエストを投稿する際に、Eメールを送信した相手、送信した時期、そして、リンクを削除したサイト、nofollowしたサイトをスプレッドシートにまとめて紹介しよう…と言っても、これは、あくまでもGoogleに「アピール」することが狙いである。

ジョー: その通り。強制ではない。ウェブマスター達は、既にリンクを削除する作業に追われ、疲労している。

SEOと言うよりも、事業に関する質問だが、回復にかかる費用に対する予算の編成と同じぐらい、サイトがペナルティを受けている間の利益の減少に対応することも重要である。そこで、手動のペナルティから回復するまで、通常、何ヶ月を要するのか問いたい。また、どのタイミングで人員整理に踏み切ればいいのか?裏でSEOに対する取り組みを行いつつ、その他のマーケティングのチャンネルにも積極的に力を入れるべきか?

ジム: 手動のペナルティから回復するまでに、通常、2-4ヶ月間を要する。回復にも色々種類がある。手動のペナルティが解除され、最大で5%回復したものの、以前と比べると、90%低い場合もある。手動ペナルティの解除は、リンクプロフィールに優れたリンクが残されているなら、喜ぶことが出来るが、全てのリンクを否認しているなら、何も残らない。「回復」したらどうなるのか?と問われることがあるが、それは、残っているリンクに左右される…それでも、ペナルティを受ける前の状態に戻ることはない。

ジョー: 変動するコスト次第だ。コストが固定されているなら(条件が同じだとすると)、人員を削減するまでに、ある程度待つことが出来る。一方、2500ドル/月をリンクに用意しているなら、生き残るために、出来るだけ早く対応した方が良い。

その他のチャンネルへの取り組みに関しては、1つのチャンネルを極め、その他の複数のチャンネルをある程度マスターするアプローチは、非常に重要だと言っておこう。他のチャンネルのエキスパートを雇って提携を結ぶことが出来るなら、それが一番だ。ある大手の会社は、SEOでは、平凡であったが、TVとラジオでも実績があるため、多くの問題を抱えても、良い成果を残すことに成功していた。また、Eメールアドレスの収集を忘れずに行ってもらいたい。Eメールは、適切に利用する限り、今でも価値は高い。

長い間、ペンギンがアップデートされていないのは、ウェブマスターが、武器としてリンクを利用することに恐怖を感じるようになり、また、ライバルのサイトを葬ろうと試みることで発生する誤検出をGoogleが出したくないからだと私は考えている。苦痛を与えるためではなく、この動機を私が挙げるのは、Googleは、いつでも回復を遅らせることが可能であり、その一方で、アップデートで新たなサイトにペナルティを与えることが出来るためだ。先程、2度目のペンギンのアップデート以降、ペナルティがリダイレクトにも送られるようになったと話していたが、ウェブマスターは、ペナルティを受けたサイトを競合者のサイトに向けているのだろうか?

ジョー: その通りだ。また、競合者の自然なリンクにも向けている。私は、長年、ネガティブ SEOを非難してきた…2012年1月、初めての手動アクションが発生した時からだ。あの手動ペナルティが転機となった。現在、リンク構築に投資して、自然にサイトのランキングを上げるよりも、ライバルのサイトをランクを下げる方が、経済的である(この点に関しては、かなり自信がある)。

ネガティブ SEO向けのリンク戦略に関する話題は尽きることがない。この手法は、驚くほど浸透している。事実、大企業から、週に数回、ネガティブ SEOの実行を要請される。混雑した状態を正常に戻すのが、ブランドだと、誰かが言っていたような気がするが…

ジム: 間もなく、月に1度のペースで被リンクを監視するようになる。事実、ある大企業は、毎週、最新の否認リンクリストをGoogleに提出している。

その点に関連することだが、先制否認について問いたい。どのようなケースで、事前に自らリンクを否認するべきなのだろうか?このタイプの取り組みに特に注目する必要があるのは、どんなサイトだろうか?

ジョー: Fortune 500に挙げられない会社は、不利な立場にある。少なくとも、リンクプロフィールには注意してもらいたい — 私なら、何か大きな問題が浮上しない限り、先制してリンクを否認するアプローチは取らない。

ジム: 自分のサイトに対して、先制否認を行ったことがある。劣悪な被リンクを一掃するために、先制否認を行うべきだと私は思う。

ジョー: 私は認可サービスを始めたくて仕方がない…数千ドルで、否認を一掃するサービスだ :))

ジム: コンビを組んで、そのビジネスを始めよう :)

ジョー: 後で打ち合わせしよう。

ジム: ペンギンペナルティから地球を救おう。Googleのために、リンクを綺麗な状態に戻すのだ。

ジョー: Googleを救うのか?それとも、Googleから救うのか?:) また、時間があったら、刑罰の持続期間に関する法律の書籍を見習い、Googleのペナルティの種類に関する本を書きたいと思う。知名度の低いサイトを使って、RapGeniusと同じ行動を取っていたら、修正を行ったとしても(因みに、RapGeniusは修正を行っていない)、今でもペナルティの解除を待っているはずだ。なぜなら、基本的に、Googleは、直接的にも間接的にも私のサイトに資金を投じていないからだ。

SEO業者は、Google VenturesやGoogle Capital向けのプレゼンの資料を作るサービスを始めるようになるのだろうか?名称は、BeatThatPenalty(BeatThatQuote)?あるいは、BanMeNot(BugMeNot)でも良いかもしれない ;)

ジョー: あるいは、元Googleの従業員から資金を絞り出す手もある…ブランドを狙うベンチャーキャピタルのおかげで、Googleの元従業員が立てる計画には、続々と資金が投じられている。Googleでは、ボタンやフォントの色を変えることが主な仕事だったのかもしれないが、大ピンチを覆す力を持つ人物と今でもつながっている可能性があるためだ。

Googleの投資を受ける以外で、競争の激しい分野に参入する際に、SEOのリスクを減らす良質な方法を知っていたら、教えてほしい。

ジム: 今後は、特定のフレーズを狙って、上位へのランクインを試みる方法は薦められない。時間がかかり過ぎる。

ジョー: Googleへの依存を軽減すると、力を得られる。仕事の面接だと思ってもらいたい。その仕事をどうしても必要としているのだろうか?必要とする度合いが低ければ低いほど、交渉しやすくなる。Google以外のチャンネルからの収益が増えれば、重要なブランドのシグナルを得ている可能性が高い。

ジム: 素晴らしい作品を提供しなければならない。その結果、ブランドは構築されていく…この取り組みを優先させてもらいたい…手っ取り早くランクを上げる手法を採用し、Googleからペナルティを受けるリスクを背負う覚悟があるなら、話は別だが。

ジョー: 同感だ。プレミアムドメインの獲得 + SEOオンリーの取り組みを行う回数はめっきり減った。有効だった時期もあったが、現在は、状況が変わっている。

一部の人達(非リンク構築業者)は、SEO業者がリンクのことをあまりにも深く考え過ぎていると茶化している。コアのコンテンツ、UX、そして、ソーシャルメディアは、なぜ、リンク構築よりも、重要だと考えられているのだろうか?

ジム: リンクは、今でもGoogleのアルゴリズムで最も重要度が高い要素である — 無視することは不可能だ。ウェブで言及してもらえるような作品を用意し、出来れば、リンクを張ってもらいたいところだ。今でもリンクは、一番大事なアイテムである…リンクに次いで、優れたコンテンツ、UX等にも力を入れる必要がある。

ジョー: CopyPress(私が経営する会社)は、コンテンツを販売している(お願いだから、誰かコンテンツを買って下さい。私には幼い子供が3人もいるんです)。しかし、最高のコンテンツだけあれば、全てが解決するわけではないことを指摘しておく。ユーザーが一人もいない状態で、UXに力を入れることが出来るのだろうか?リンク構築、トラフィックの購入、注目の獲得は、SEOにおいてだけではなく、マーケティング全般において、重要である。Googleは、リンクを票として利用している。多様性は、変化し、進化していくものの、大半は今でも変わっていない。来年、または、再来年にリンクが消え去るとは、私には思えない。

例えば、私は大学生の頃に詩に関する本を2冊執筆した。内容には自信があったが、出版したことも、注目を集めようと試みたこともない。それでは、実際に、この本は、どれぐらい読む価値があるのだろうか?宣伝、そして、普及させなければ、推測に頼るしかない。

最後に、時間を割いて、今回のインタビューを快諾してくれたお二人に感謝したい。

SEOの賢者について:

ジム・ボイキンは、Internet Marketing Ninjasの創設者であり、CEOでもある。また、Webmasterworld.com、SEOChat.com、Cre8asiteForums.comを含む複数のコミュニティサイトを運営している。ジム・ボイキンは、自然な被リンクを集めるデジタルコンテンツの作成、および、ペナルティから復帰するため、リンクを分析し、不自然なリンクを否認する取り組みを得意としている。

ジョー・シンクウィッツ、通称、Cygnusは、CopyPress.comで最高収益責任者を務めている。ビーチでの散歩、必要なコンテンツの供給、そして、ランキングを上げるアドバイスの提供に生き甲斐を感じている。

この記事は、SEO Bookに掲載された「Understanding The Google Penguin Algorithm」を翻訳した内容です。

日本に負けじと、いやそれ以上に米国のSEO業界も大変なんだなぁ、と思わずにいられない内容でしたが、日米問わず共通の悩みは多そうですね。インタビューの端々に出てくる普段は余り耳にしない米国のリアルな現場界隈の話が聞けてとても新鮮な記事でもありました。 — SEO Japan [

G+]