すでにGoogle Glassの一般消費者向けの販売は停止されているが、同製品のエンタープライズ向けのビジネスはペースを加速している。今日、Google Glassを利用したメディカルサービスの有力企業の一つであるAugmedixが、重要な資金調達を発表した。同社のCEOによれば、医師の顔をコンピューターの画面から引き離すことによって、医師と患者との交流に「再び人間味を持たせる」ことが目的だ。

サンフランシスコ発のスタートアップであるAugmedixが開発したプラットフォームでは、顧客である医師は患者のリアルタイムに医療データを集め、アップデートし、取り出すことができる。今回、その同社がストラテジック・ラウンドにて1700万ドルを調達した。

この資金調達のすごいところは、その出資者の顔ぶれだ。米国でもっとも規模の大きいヘルスケア企業の5社である、Sutter Health、Dignity Health、Catholic Health Initiatives(CHI)、 TriHealth Inc.が出資者であり、もう1社の名前はまだ公表されていない。これらの企業は、ヘルスケア業界において互いに競合する関係にある。このグループが運営する病院などの医療機関には合計で10万人の医師などの医療提供者が所属し、そこには何十万もの患者が通っている。Augmedixのアイデアは、インターネットに接続されたアイウェアをその医療従事者に提供するというものだ。

この資金調達はシリーズAの後に位置するが、シリーズBの前になる。(CEOのIan Shakilはインタビューで、このシリーズBでの資金調達はまだ開始していないと話した)。そして、この資金調達によって同社の合計調達額は4000万ドルとなった。前ラウンドで1600万ドルを調達したあと、Augmedixのバリュエーションは約1億ドルだった。Shakilは企業価値について公表をしていないものの、私に今回の資金調達は「前回より高い評価を得た、健全なアップラウンドだった」と話してくれた。私の理解では、現在のバリュエーションは1億2000万ドルから1億6000万ドルの範囲であり、おそらく後者に近い金額になるだろう。

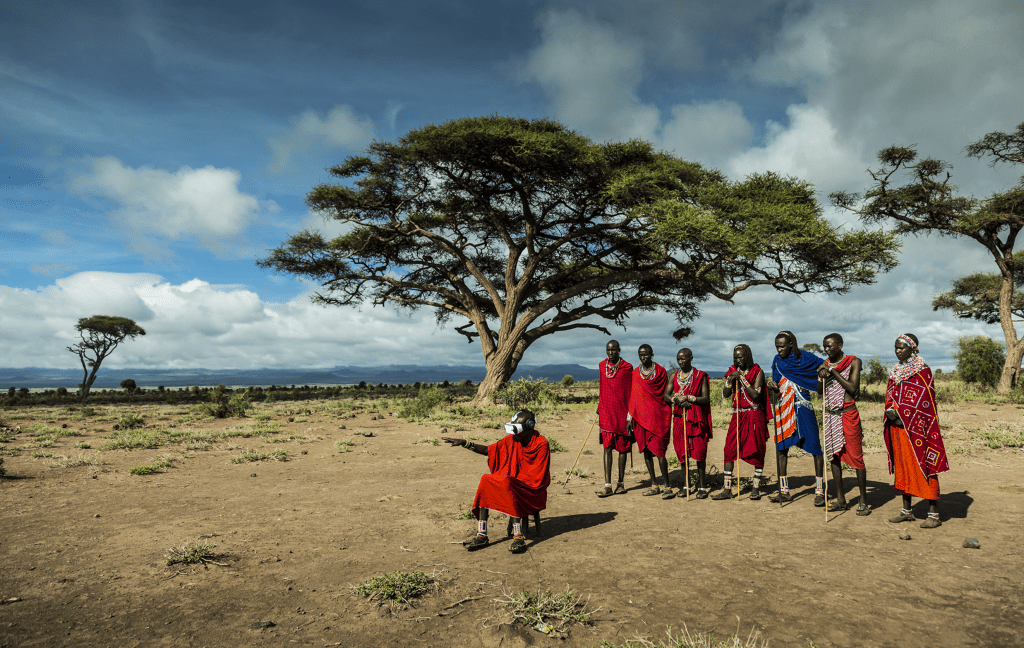

Google Glass(とその他のウェアラブル端末)に対するおもな批判の一つは、顔にデバイスを取り付けることによって、交流している人からあなたを遠ざけるというものだ。話し相手もデバイスを装着した人と話をするのは嫌だし、着用者にしても目の前にいる人に集中することを妨げるからだ。

皮肉にも、現在までのAugmedixの成長の背景には、これとは正反対の理由がある。米国の医療システムが抱える大きな問題の一つは、医療従事者が入力し、参照しなければならない各患者ごとのデータの量が膨大であることだとShalkiは述べた。

「Google Glassを装着していない医師は、画面をクリックしたり、図面を描くことに長い時間を費やせねばならず、目の前の患者に集中することができません」と彼は話した。「Google Glassを使って情報を集め、参照することができれば、医師と患者とのより良い交流を促すことができます」。またShalkiは、Augmedixのシステムでは、「みなさんが思っている以上に素早くバックグランドで資料を処理し、そのプロセスに人間味を持たせます」と付け加えた。

これがストラテジック・インベスターたちを惹きつけたようだ。たとえ、それが競合と横並びに資金を投資することを意味するとしてもだ。

Dignity HealthのChief medical information officerであるDavin Lundquist博士は、「Dignity Healthは、外部とのパートナーシップの構築に取り組んでいます。それらのパートナーシップによって、テクノロジーが持つポテンシャルの有効活用ができます。そして、テクノロジーを医療の現場に適用することで、日々の治療において、患者と医療従事者がより良い決定を下すことができるのです」と述べた。「医師がGoogle GlassとAugmedixを利用することで、コンピューターに患者の医療データを入力する時間を省くことができ、より長く患者と接することができます。これによって医師は患者にもっと集中することができ、結果的に患者がより良い医療体験を得ることになるのです」。

Sutter Healthのバイスプレジデントであり、Chief of digital patient experienceでもあるAlbert Chan博士は、「私たちは、患者の皆様がSutter Healthに期待しているような、ハイクオリティで価値の高い医療経験を創り出す事を目指しています。そのために新しいテクノロジー・ツールとサービスを導入することで、より効果的でかつ安価な、患者用にカスタマイズされた治療を提供することができます」と語った。「特に、診察室における医療体験の価値を高めることにおいては、ウェアラブル端末には大いに期待できます。私たちは患者と協力していきます。そして、私たちのデジタル医療のイノベーターのネットワークが成長し、患者と医師の関係を新たな方法で強化することに価値を感じています」。

興味深いことに、「人間化」はこのシステムにおける患者側の側面に限ったことではない。Augmexが利用するソフトウェアは、人間によって構成された大規模なチームがバックエンドで情報を入力し、アップデートすることによって成り立っている。「現状では、このソフトウェアはAIや音声認識機能によってではなく、人間によって支えられています」とShalkiは語る。

しかし、今回調達した資金でAugmedixはその分野における新しいテクノロジーを取り入れたシステムを構築しようとしている、と彼は付け加えた。「将来的には自然言語処理をさらに取り入れたシステムを導入していくつもりです。それによってシステム効率を高めることができます」。Googleの自然言語処理テクノロジーを採用する可能性もあるが(Googleはこの分野に注力している)、Nuanceやその他の企業によるソリューションを採用するかもしれないと彼は話した。

これまで、そしてこれからもGoogle Glassはニッチな製品として扱われている。それでは、現時点でのAugmedixの規模はどれほどの大きさなのか?Shakilによると、現在は「数百の」医師がAugmedixのソフトウェアを搭載したGoogle Glassを利用しており、その大半はカリフォルニア州の南部および中部に集中しているという。この数字はそこまで大きなものには聞えないが、Shakilによると、それぞれの医師は毎月「数千ドル台の前半の金額」を支払っており、これによって「かなり正当な」年間収支が形成されているという。

来年までには数千の医師が同社のサービスを利用する予定だと話し、5年以内には1万人の医師を顧客にするというより大きな目標を語った。今回の新しい出資者たちが合計で10万人の医師や開業医を抱えていることと、これまでに彼らが医療のITに対して費やしてきた金額の大きさを考えれば、10%の市場シェアという数字はそう突飛なものでもないだろう。

現状ではGoogle GlassがAugmedixのビジネスの根幹ではあるが、長期的にはそれが必ずしもGoogle Glassだとは限らないようだ。いかにも、Google Glassはこの分野における先駆けではあるが(そして賢くもエンタープライズ版によってその敷居を下げたが)、それ以降、ユーザーに情報を与えるヘッドセットという分野において、世界は進歩した。現在では、FacebookのOculus、Meta、Microsoft、Samsungといった企業から生まれた拡張現実および仮想現実のハードウェアが存在している。

Shalkiは、今後しばらくはAugmedixのサービスとビジネスはGoogle Glassに特化したものになると語る。(注: DCMやEmergenceなどのVCが同社に出資するなか、GoogleはAugmedixに出資していない)しかし同社は、Shalkiが言うところの「軽いAR」の利用実験もしているという。

Augmedixは、将来的に同社のプラットフォームに機能を追加して、患者と医師とのより良いコミュニケーションを実現したいと考えている。そういった機能の中には、「患者が家に帰って落ち着いてからも、医師の話をもう一度聞ける」という患者志向の機能や、セルフケアのデモンストレーションを提供する機能などが含まれる。

また同社は、医師に対するガイダンスも追加したいと考えている。たとえば禁煙治療や、その他の診療における重要なポイントを医師が思い出すことを助けるためだ。将来、このような機能が、たとえば手術など、ほかの領域にも導入されることも想像できる。

[原文]

(翻訳: 木村 拓哉 /Website /Twitter /Facebook)