DreamHostはWebホスティングサービスとしてよく知られているが、でも同社はかなり前から、オープンソースのエンタープライズプラットホームOpenStackの、主要なコントリビューターだ。そして数年前からは、OpenStackベースの同社独自のクラウドコンピューティングサービスDreamComputeをベータで提供していた。

今日(米国時間4/5)、そのDreamComputeがベータを終わり、従量制と月額定額制を折衷したような、新しい料金モデルで一般供用を開始した。

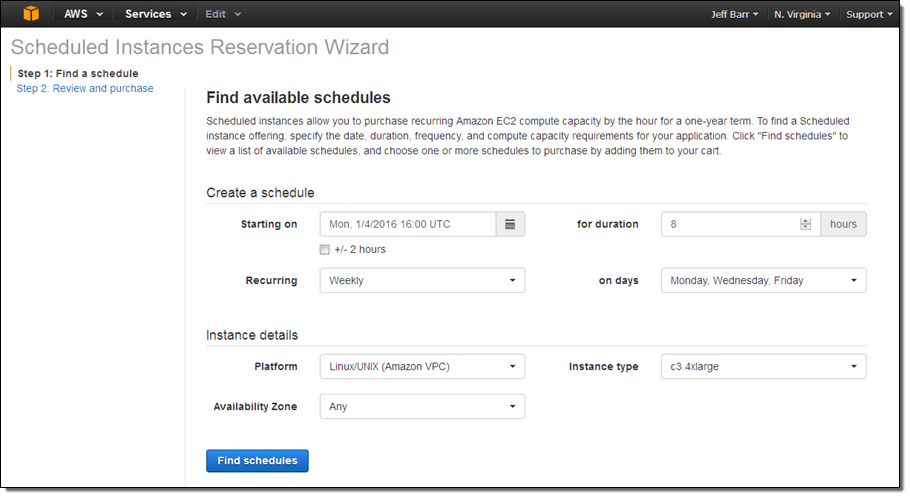

DreamComputeは、OpenStackにストレージシステムCephと、Dreamhostが育てたネットワークオーケストレーションサービスProject Astaraを組み合わせたサービスで、AmazonのクラウドコンピューティングサービスEC2などともろに競合する。

約1200社の顧客企業と一緒に、DreamComputeのベータを長年やってきた経験から、チームはDreamHostの合衆国東部データセンターに完全に新しいアーキテクチャを実装した。同社のクラウド担当VP Jonathan LaCourによると、この新しいアーキテクチャはベータ時の倍近いパフォーマンスを提供する。チームがこの新しいアーキテクチャの開発に取り組んだのは約1年前だが、そのときチームがすぐに理解したのは、たとえばユーザーがSSDのストレージを求めていること、そして、たくさんコアがあることよりも、高速なシングルコアのパフォーマンスに関心があることだった。

DreamComputeはベースがOpenStackだから、デベロッパーはマシンにrootアクセスでき、またOpenStackのAPIもすべて利用できる。

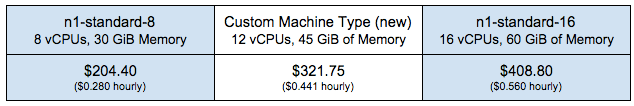

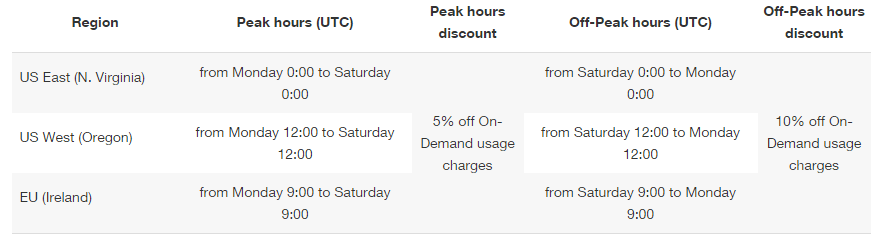

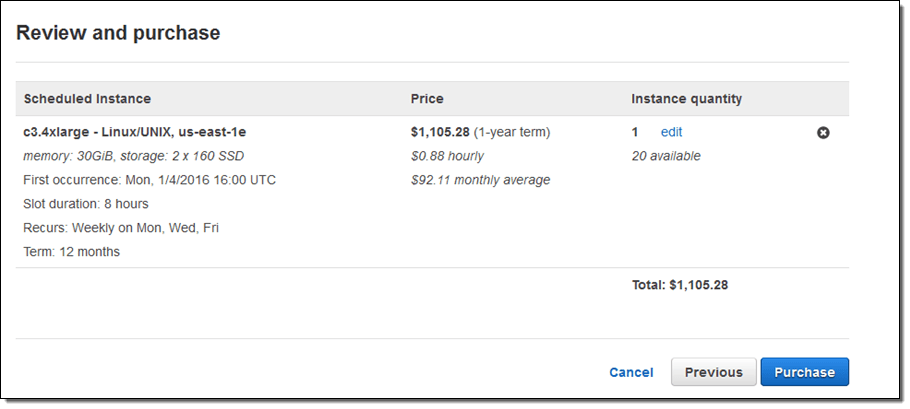

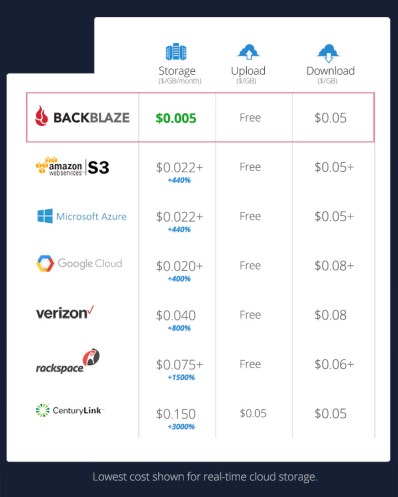

料金は時間単位の従量制が基本だが、顧客は25日ぶん以上を請求されることはない。月額の最低料金は4ドル50セントだ。この金額では、従来的なハードディスクを使う古いクラスターは、RAM 1GB、仮想CPU1つだが、SSDを使う高速なクラスターではRAMが512MBのみだ(1GBのマシンは月額6ドルから)。DreamComputeの各クラスターには、100GBのブロックストレージが無料でつく。詳しい料金体系は、ここにある。

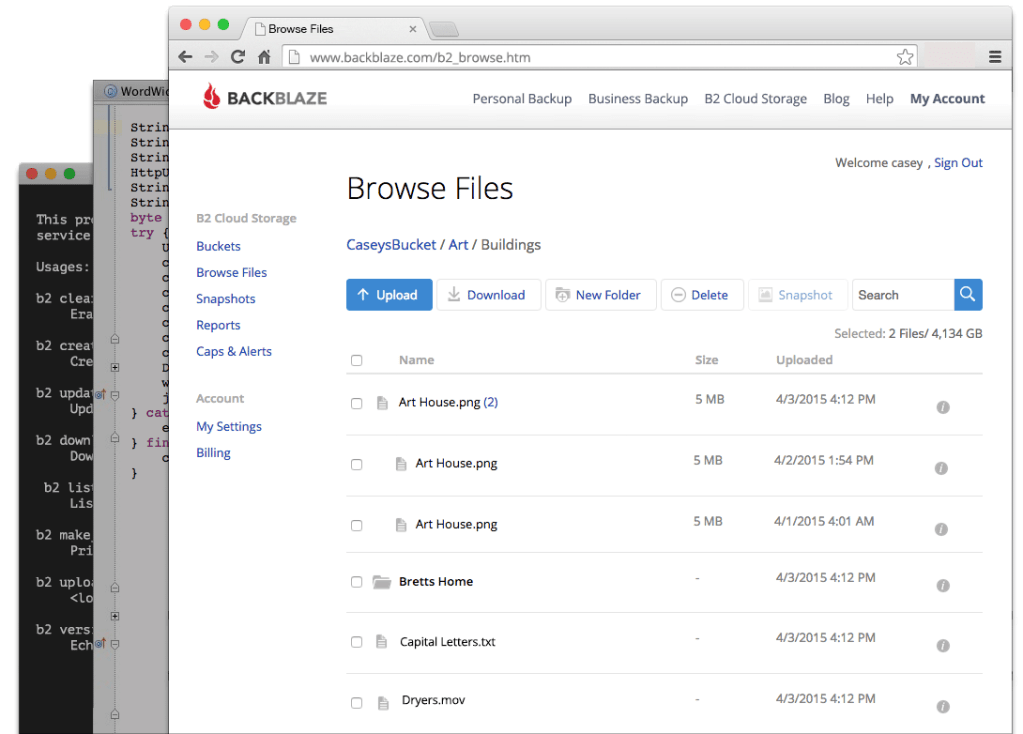

同社はこの、OpenStackクラウドコンピューティングサービスのローンチに併せて、サービスの使い方を詳細に記した知識ベースを立ち上げた。そのすべての情報はGitHub上にあり、またこれに対する、ユーザーの今後の自由な貢献も期待している。LaCourによると、今後はチュートリアルなどそのほかのドキュメンテーションも、何らかのインセンティブ制により、ユーザー貢献型にしたいという。ドキュメンテーションに対するこのやり方は、Linux仮想サーバーホスティングのLinodeのやり方に似ている。