アクセラレータAngelPadを巣立ったPolybitが、同社のプロダクトStandard Library of the Internet(インターネットの標準ライブラリ)の公開ベータを開始した。それは、デベロッパーはもちろん、初心者にとっても、バックエンドのコーディングを楽にする、というリソース集だ。

Standard Library、略して“stdlib”と同社が呼ぶクラウドサービスに、デベロッパーは自分が書いたファンクションをアップロードしてもよいし、またマイクロサービスやロジックをこの上でポータブルにし、再利用可能にする。ユーザーがサーバーの管理をする必要はない。

PolybitのファウンダーでCEOのKeith Horwoodは、かつて、オープンソースのNode.jsフレームワークNodalを作ったことがある。彼曰く、“ぼくは、バックエンドやAPIの世界が長いね。そんなぼくの今の目標は、ソフトウェアのデベロッパーが、インフラストラクチャに関していっさい悩まなくなることだ”。

コードを書いて、それに何百万もの人たちがオンラインでアクセスできるようにするのは、とても複雑な工程だ、とHorwoodは言う。構想しているロジックを、実際に書いて実装しなければならない。さらに、それをネットでどのようにホストするのかを、考えないといけない。そのコードをサーバーに載せなきゃならないし、そしたら今度は、サーバーのことを毎日心配しなければならない。コードを自分で書かずに外注したら、かなりの時間と手間とお金がかかる。そしてしかも、自分が作るWebサービスは、確実に人びとに注目されるものでなければならない。

PolybitのStandard Libraryは、ファンクションと、いろんなアプリケーションのためのビルディングブロック(構築部材)のリポジトリだ。デベロッパーは、自分が書いたファンクションをここで、即座にオンラインでアクセス可能にできる。

Horwoodがstdlibで共有されるファンクションの例として見せてくれたのは、リオデジャネイロ・オリンピックの、国別の金メダル取得者のリストを作るコードの一部だ*。〔*: ここのAPIを利用する。〕

デベロッパーはこの“マイクロサービス”を拾い上げ、国名をCanadaから別の国に書き換えたり、あるいはメダル獲得数のトップ5を作るように書き換えたりできる。ライブラリの共有と再利用の、一例だ。

彼がstdlibで共有できるようにしたいと考えているファンクションの例は、ハードウェアをクラウドに接続するための一連のコードだ。またサードパーティに情報をリレーしたり、データを操作するファンクションも必要だ。

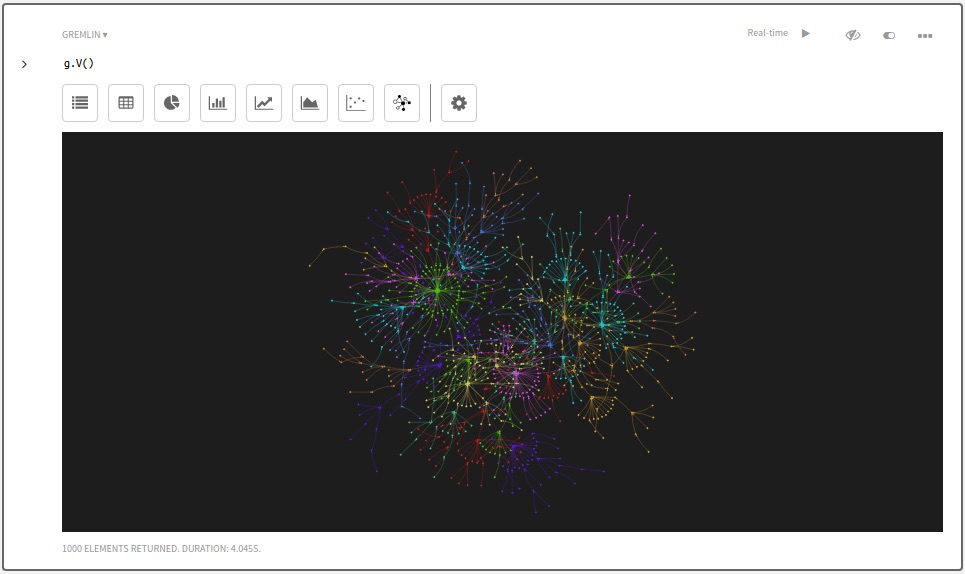

stdlibのデモビデオが、これだ:

Horwoodの考えでは、いろんなファンクションがオンラインで入手できるようになると、企業のITチームにとっても便利なはずである。彼らは企業の中で常時、プライオリティリストに正規に載せることもできない、雑多なリクエストを抱えているからだ。それらに、ライブラリ上の出来合いのファンクションで対応できたら、ありがたいだろう。

たとえば営業はITに、雑多な顧客情報を見込み客の“有望度”順にソートしてくれ、それをスプレッドシートに落としてくれ、とリクエストしているかもしれない。でもそれは、企業にとって重要なメールの処理や福利厚生の問題などと違って、ITのプライオリティリストにはなかなか載らない。しかしStandard Libraryへ行けば、そんなリクエストにぴったりの既製品のソフトウェアパッケージがあって、営業のニーズに対応できるかもしれない。

PolybitのStandard Library(stdlib)は公開ベータに入ってまだ1週間だが、すでに500のファンクションがデプロイされ、登録ユーザーはほぼ1500名いる。さらにstdlibからは、NPMの30万あまりのNode.jsのソフトウェアパッケージのすべてに、アクセスできる。