IBMは同社の今年のInterConnectカンファレンスで、機械学習の学習コースを発表した。それは、スタートアップの卵たちにワークスペースと教育を提供しているGalvanizeとの提携事業で、主にWatsonのAPIの使い方を教えていく。それらのAPIを利用すれば、言葉や音声や視像(画像や映像)の認識に依存するアプリケーションの構築が、容易にできるようになる。

そのコースはIBM Cognitive Courseという、なんか冴えない名前だが、4週間で機械学習の基礎とWatsonで何ができるかを教える。生徒はそのクラスに、IBMのクラウドプラットホームBluemixからアクセスする。

IBMでWatsonとIBM Cloudを担当しているCTOのBryson Koehlerはこう言う: “WatsonのAPIで何ができるのか、知らない人もいる。Watsonのエキスパート、と呼べるほどの技術者は、まだとても少ない”。

コースを補助するリアルなワークショップ、題してBuilder Fairsが、Austin, Denver, New York, San Francisco, Seattle, Bostonの各都市で行われる。また、ハッカソンや個別面談(“オフィスアワー”)などのイベントBuilder Spacesも予定されている。

“ワークショップがあることは、この学習ではきわめて重要だ”、とは語る。“実用アプリケーションを作れるためには、実物体験が欠かせないからね”。

Galvanizeは過去にいろんなコースを展開した経験があり、そのために技術者たちのコミュニティができている。最初のBuilder Spaceは、今行われているInterConnectカンファレンスがその会場になる。

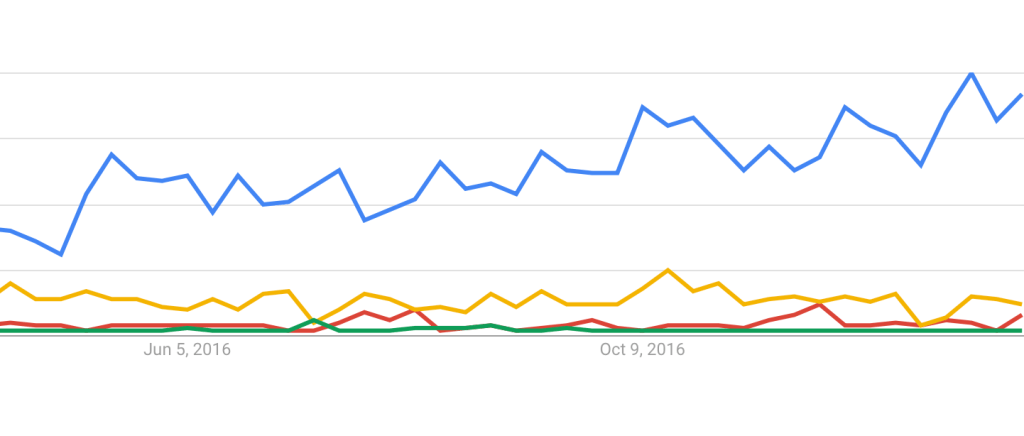

クラウドコンピューティングを提供している各社はこのところ、デベロッパーへの訴求に熱心だ。デベロッパーというより、これから人生で初めてプログラミングをする、という超初心者も対象にし始めている。IBMは、Galvanizeとのパートナーシップで、最初からいきなり技術者たちの大きなコミュニティに訴求できる。この前GoogleがKaggleを買収したのも、同じねらいだ。コミュニティの人数はもっと多い。

クラウド上のデベロッパー向け学習リソースは、AWSにも、AzureやGoogle Cloudにもある。たとえばGoogleはUdacityと組んで、ディープラーニングの3か月コースを提供している…こちらはもちろんWatsonではなくTensorFlowが中心だ。

IBMには前から、Galvanizeとの関係がある。GalvanizeのデータサイエンスのディレクターNir Kalderoは、2017年のIBM Analytics Championに指名された。昨年の秋に両社共同で、企業役員のためのデータサイエンス教育を催している。また昨年初めには、両社でエンタープライズ顧客のためのBluemix Academyを開催した。Galvanize単独では、IBMのクラウドプラットホームのプロモーションのために、サンフランシスコでBluemix “Garage”を行った。