人工知能はチェスや囲碁等の高度な頭脳ゲームをある程度習得した ― それでは、スタークラフト2のように、高度な戦略を迅速な反応が必要な戦術的思考と組み合わせたゲームはどこまで戦えるだろうか。おそらくかなり強いと思う。そしてGoogleのDeepMindとBlizzardの協同研究がそのことを証明してくれる。

このプロジェクトはAIがただスタークラフト2をプレイするだけではない ― それならゲーム自身に内蔵されたものから、あらゆる人間よりも速く操作するようにプログラムされたボットまで、既に数多く存在している。ザーグリングが大量のシージェタンクと戦うところをご覧あれ。たいていはザーグ味のスープが出来上がる(大音響注意)。

実際には、ゲームのためにAIに優しい環境を作ることを目的に、この見るからに厄介で複雑なゲームを理解するのに必要なAI機能をゲームに統合する。

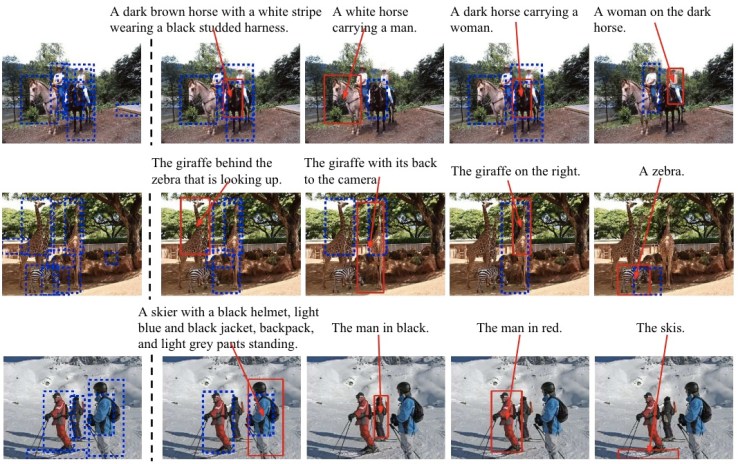

例えば、ヘルスバーの読み方や人間のSVCとプロトスのプローブの見分け方を知り、それに応じて行動することができる。しかし、画面上の画像しか利用できないAIは、試行錯誤によって学習する必要がある。ただしこのAIは、誰が敵か、低地と高地をどう区別するか等のヒントをこっそり教えてくれるバージョンでプレイしている。

上の動画は、初期バージョンでAIが実際のピクセル上に様々な意味の「レイヤー」を重ねているところ。このカンニングペーパーを使うことでAIはもっと重要なことに集中できる。ワーカーユニットをいくつ作るか、ガスをいつ止めるか、武器とアーマーのどちらを先にアップグレードするか等だ。

ゲームをプレイしたり記録されたゲームを見ることで、AIは「マクロ」ゲームと呼ばれる戦略や戦術に関する知識を蓄積し、超人間的速度のアクションを活用してバトルや小競り合いで「マイクロ」を支配する方法を学んでいく。山ほどの情報を分析してゲーム中いつでも利用できるようにしておく必要がある ― 完璧なユニット制御も、優れたリソースを持つ敵に出し抜かれたり潰されたりしては意味をもたない。リアルなプレーヤーと同じく、AI「高次元アクションスペース」を移動しつつ、長期的記憶と計画を操る必要がある。

大切なのは勝利の栄光だけではない(一部ではあるが) ― このレベルのビジュアルと複雑なゲームプレイを扱うAIを作ることは、われわれのモデルの何が問題で、何に秀ているかを理解する助けになる。

興味が湧いた人cBlizzconで詳しい情報を見ることができる。あるいは少し待って、スタークラフト2のテスト環境が公開されれば、自分専用のAIを配備することもできる。

[原文へ]

(翻訳:Nob Takahashi / facebook)