Dropboxのようなストレージサービスが企業ユーザーの獲得を目指すときは、単純なファイル共有を超えた機能の提供が必要になる。Dropboxが、これまで欠けていたコラボレーションの層としてPaperを作ったのも、そのためだ。今日(米国時間9/3)同社は、プログラムを切り替えたりせずにコラボレーションツールの中だけで仕事ができるための、拡張機能をPaperに導入した。

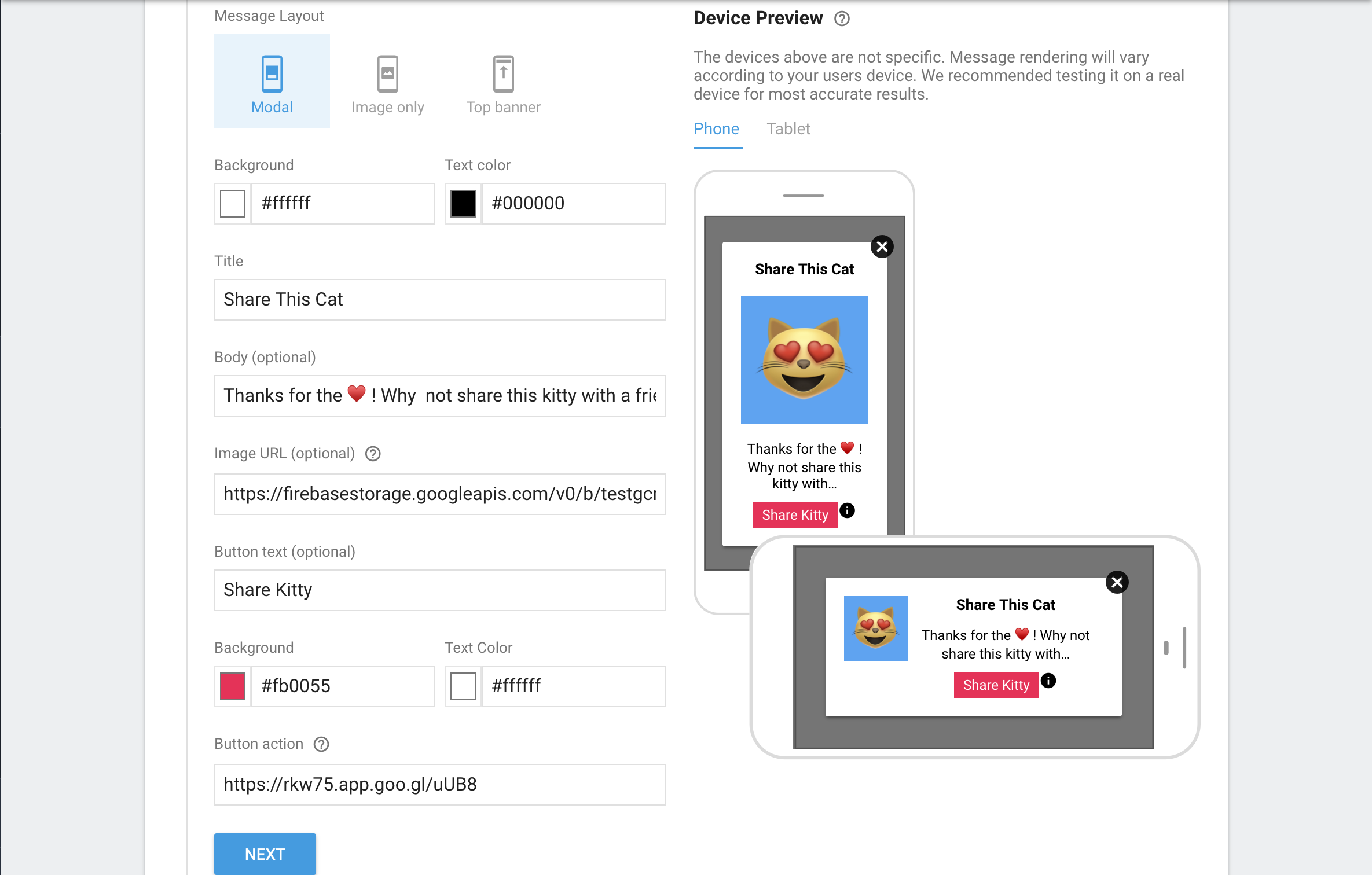

“Paperは、チームのためのDropboxのコラボレーションの場だ。複数のユーザーが一緒に仕事をできるための機能がいろいろあり、締め切りを決めてオーナーにタスクを割り当てたり、YouTubeやSoundCloudやPinterestなどのマルチメディアコンテンツを埋め込むこともできる”、とDropboxは説明している。

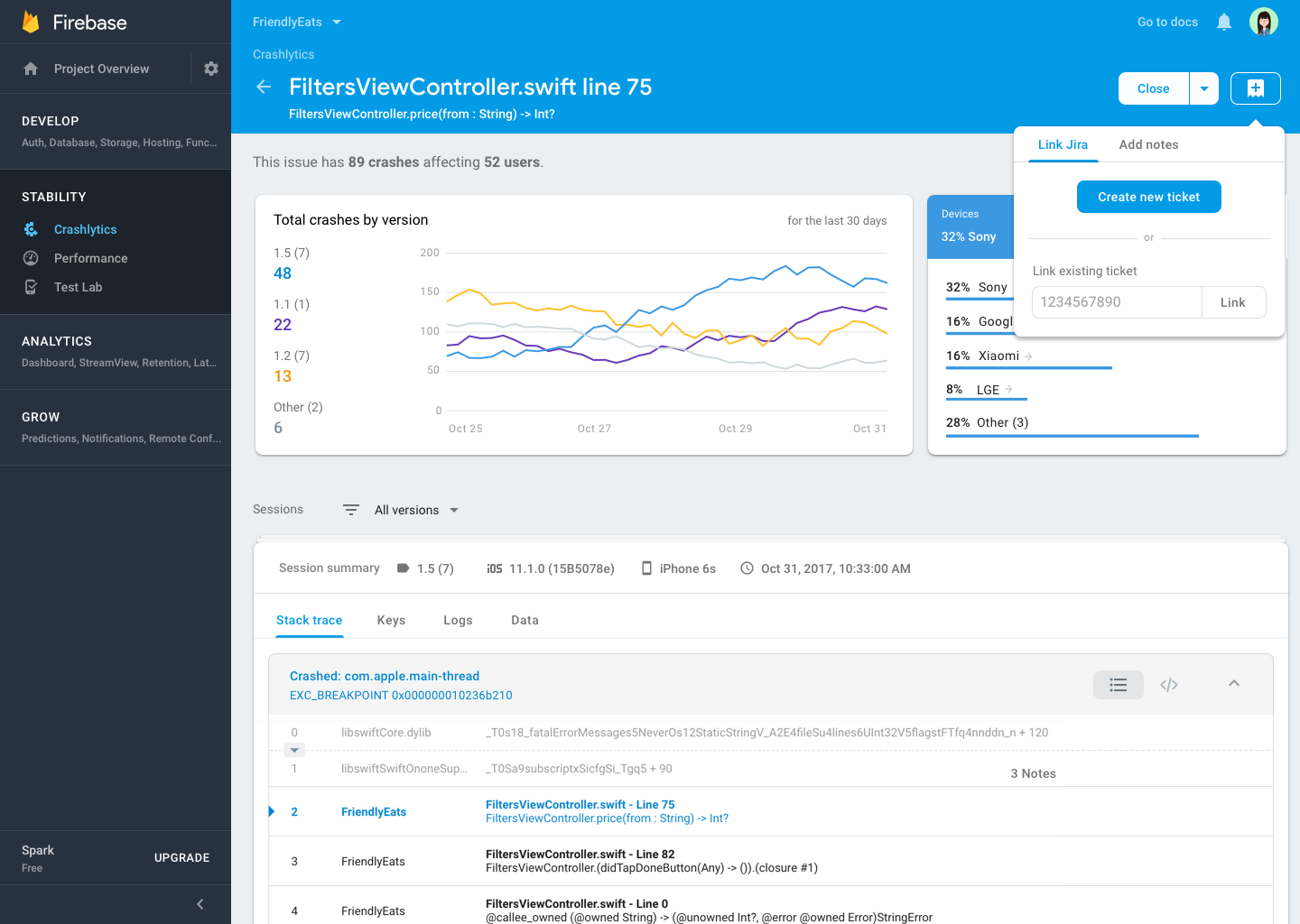

今日発表された拡張機能で、Paperの中にさらにほかの要素を取り込めるようになった。たとえばPaperの中でDropboxのフォルダーへリンクして、ファイルの中身を見たり、サブフォルダーへ降りて行ったりもできる。リンクはフォルダーそのものへのリンクなので(コピーではないので)、ファイルへのアップデートはPaperの中のビューにもすぐ反映する。これはDropboxのような企業にとって、かなり思い切った機能だ。

画像提供: Dropbox

今のDropboxは、スプレッドシートをパワーアップしたような機能Airtableをサポートしているが、今回のPaperのアップデートで、Airtableを埋め込みコードでPaperに取り込めるようになった。これも、Airtable本体のアップデートが即、Paperのビューに反映される。

さらにこれからのPaperは、Googleのコラボレーション機能のように、図表を作れるLucidchartをサポートする。これも、フォルダーやAirtableと同じく、ライブのビューをPaperの中で見られる。つまり図表本体が変わればPaper上の図表も変わる。

Paperの中で、これだけいろいろなことができるから、プログラムをあちこち切り替える必要がない。最近BoxがActivity StreamとRecommended Appsを発表したのも、同じような理由からだ。Slackが企業で人気が高いのも、同じ理由だ。つまり、ひとつのコラボレーションツールの中で、いろんなアプリケーションのコンテンツをシェアできる。そのために大量のタブや、別のアプリケーションを開かなくてもよい。

Dropbox Paperではさらに、ユーザーがあちこちのアプリケーションのコンテンツサイロを訪ねなくても、一箇所でいろんなプレビューを見ながら、最後まで中断なく仕事ができる。Dropboxはこの機能を、企業顧客獲得の決め手にしたいのだ。

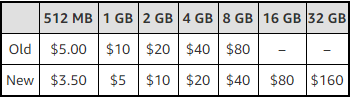

Linuxインスタンスの中で唯一50%の値下げでなかったのは、5ドル/月の512 MBインスタンスで新価格は3.50ドル。これでも悪くはない。ニーズによっては512 MBでもプロジェクトをいくつか動かすのに十分なので、1 GBが必要ないユーザーはLightsailを使えばDigital Oceanの最小構成である5ドル/月よりも数ドル安くできる。実際、Lightsailの1 GBインスタンスも5ドル/月になったのも驚きではない。

Linuxインスタンスの中で唯一50%の値下げでなかったのは、5ドル/月の512 MBインスタンスで新価格は3.50ドル。これでも悪くはない。ニーズによっては512 MBでもプロジェクトをいくつか動かすのに十分なので、1 GBが必要ないユーザーはLightsailを使えばDigital Oceanの最小構成である5ドル/月よりも数ドル安くできる。実際、Lightsailの1 GBインスタンスも5ドル/月になったのも驚きではない。