エンタープライズLinuxの代表的企業であるRed Hatは近年、同社のOpenShiftプロダクトで、Kubernetesを軸とするコンテナ技術に積極的に注力してきた。そして今日(米国時間1/30)同社は、その路線のさらなる拡張のために、コンテナ管理のスタートアップ*CoreOSを2億5000万ドルで買収すると決定した。〔*: 元々はCoreOSはDockerコンテナの使用を前提とするエンタープライズLinuxディストリビューションである。〕

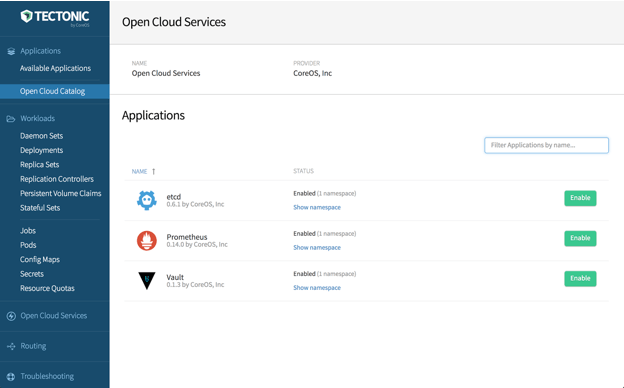

CoreOSのメインのプロダクトは、LinuxディストリビューションCoreOSと、Googleが開発したオープンソースのコンテナオーケストレーションプラットホームKubernetesをベースとするコンテナ管理ソリューションTectonicだ。本誌TechCrunchのコンテナ入門記事が、ここにある。

CoreOsとRed Hatは、Google, FathomDB, ZTE Corporation, Huawei, IBM, Microsoft, Fujitsu, Mirantisなどと並んでKubernetesの最大のコントリビューターの一員だ。

おそらくKubernetesをめぐる密接な協働関係が契機となって、CoreOSとRed Hatの仲が深まり、この際一つになった方が顧客の共有や人材の有効活用の点で有利、という結論に達したのだろう。両者はコンテナを前提とするLinuxディストリビューションでも、CoreOS vs. Red Hat Atomicで競合してきたが、これについてもやはり、デベロッパー環境を統一すべき、という結論になったのだろう。

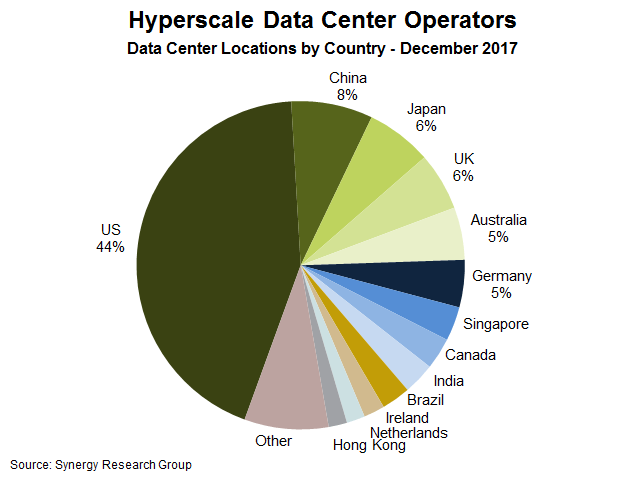

次世代の中心的なソフトウェア環境が、自社データセンター上のオンプレミスとパブリッククラウドを併用するハイブリッドクラウドになるのなら、クラウドネイティブな枠組みにより、統一的な方法でアプリケーションをデリバリしていくことがとても重要になる。Red Hatでプロダクトとテクノロジーを担当するPaul Cormierによると、両社の合体はそのようなハイブリッド環境や複数のクラウド環境を 統一的に扱える力を与える。

Cormierは声明文の中でこう述べている: “次世代のテクノロジーは、複数の、そしてハイブリッドなクラウド環境にまたがるコンテナベースのアプリケーションが駆動する。それらは、物理環境、仮想環境、プライベートクラウド、パブリッククラウドなど多様な要素から成る環境だ。KubernetesとコンテナとLinuxが、この変化の核であり、Red Hat同様CoreOSも、これらのイノベーションを推進する上流のオープンソースコミュニティと、エンタープライズ級のKubernetesを顧客に提供していく能力の両方において、リーダー的存在だった”。

昨年CoreOSのCEO Alex Polviもインタビューでこう語った:“うちはGoogleやDocker、Red Hatなどと共に、コンテナという新しい技術カテゴリーを作ってきた、という自負を持っている。うちはこれまで、まったく新しいカテゴリーのインフラストラクチャを作ってきた”。

彼の企業は、エンタープライスKubernetesプロダクトを作って早くからゲームに参戦し、そのことを有利に生かしてきた。“Kubernetesについては、その初期から、すごい大物になる、と感じていた。そして当時からすでに、TicketmasterやStarbucksなどのシステムにKubernetesを導入してきた”、と彼は語る。

彼によると、同社のコンテナ管理システムTectonicには4つのメイン成分がある: ガバナンス、モニタリング・ツール、課金、そしてワンクリック・アップグレードだ。

Red HatのCEO Jim Whitehurstも昨年のインタビューで、うちもコンテナとKubernetesに関しては早かった、と述べた。彼によると、同社はオペレーティングシステムのカーネル(すなわちLinux)もコンテナに入れられることを理解していた。同社は本来Linux企業なのでKubernetesと(Linux上の技術である)コンテナ化技術に早期から専念して、OpenShiftを作った。

CoreOSは2013年の創業以来5000万ドルを調達している。主な投資家であるGV(元Google Ventures)とKleiner Perkinsは、おいしいリターンを得たようだ。いちばん最近のラウンドは、GVがリードするシリーズBの2800万ドルだった。Kubernetesの作者で最大のコントリビューターでもあり、CoreOSの主要投資家であるGVを同系とするGoogleが、Red HatというトンビにCoreOSという油揚げをさらわれた形になったのはおもしろい。

買収は今月中に完了するものと思われる。ただし1月はあと1日だけなので、すでに完了しているのかもしれない。