まずこれだけは、はっきりさせておこう。iPhone11シリーズのナイトモードは素晴らしい。これは使える。他の暗いところに強いカメラと比べても非常によくできている。露出と演色性はクラスでトップ。以上だ。

これだけで納得できるなら、もうこの先を読む必要はない。もし、iPhone 11についてもっと詳しく知りたいなら、そしてこの記事に載せた大量の写真を見て、遠い遠い銀河の果てまでの旅で、iPhone 11がどのように活躍したかを知りたいなら、この先も読み続けていただきたい。

それで、だいたいわかっただろうか。そう、新しいiPhoneを携えて、またディズニーランドに行ってきたのだ。このテーマパークでの、私の他のレビュー を読んだことがある人なら、そこはさまざまな能力を試すことができる、現実世界の理想的な試験場のようなものだということを理解してくれているだろう。そこには、iPhoneとともに休暇を過ごしている人が大勢いる。

ディズニーランドの中は暑く、ネットワークは大混雑だ。iPhoneは、チケットとして、食料を注文するためのツールとして、それからもちろんカメラや地図としても大活躍する。友人や家族と連絡を取るためのツールとしても不可欠だ。そこは、要するに要求の厳しい環境なのだ。このような、いわば有機的なテストは、オフィスに閉じこもって、バッテリが尽きるまでベンチマークテストを走らせるよりも、ずっと現実的なものになると感じている。

私はだいたい1台、または2台の新機種を、前任機と比較しながらテストするようにしている。私は、AndroidとiPhoneを並べて比較して議論することに、それほど興味はない。なぜなら、それは不毛なことのような気がするからだ。どうしても、プラットフォームに縛られているので、AndroidもiOSも関係なく機種を選ぼうという人は、どんどん少なくなっていくばかりだ。普通の人は、以前と同じ系列のモデルを、サービスあるいは価格によって選んでいる。こんなことを言うと、AndroidやiOSの信奉者を苛立たせることもわかっている。しかしほとんどの人は、こういった類の製品を宗教的な基準で選ぶほどのこだわりを持っているわけではないだろう。

モデル間の類似性(詳しくは追って述べる)を考慮して、テストでは主にiPhone 11 Proを使用し、必要に応じてiPhone 11も加えた。また、比較の基準としてはiPhone XSを使用した。さらに、異なるプラットフォーム間の比較をしたくなかったにもかかわらず、今年のテストには、GoogleのPixel 3も持ち出すことにした。Pixel 3の「夜景(Night Sight)」モードが、非常に優れていると話題になっていたからだ。

比較することに意味がある場合にのみ、iPhone XSを使うことにした。それ以外の場合は、できるだけiPhone 11 Proを使って、なるべく負荷を掛けてみることにした。いずれにせよ、実際にディズニーランドに出かける前には、新しいデバイスのセットアップから始めなければならない。

セットアップ

iPhoneをセットアップするためのプロセスのほとんどは、長年にわたって何も変わることがなかった。しかしApple(アップル)は、ここで改めて述べておく価値のある新しい機能、Direct Transferを追加した。セットアップ中に使えるこのオプションは、感覚的には、ローカルなMac上に作成したバックアップから復元することと、iCloud上のバックアップから復元することの中間に位置するように思えるもの。

Direct Transfer(iPhoneから転送)は、2つのデバイスをピアツーピアで直接接続して、1つのデバイスからもう1つのデバイスに、直接情報を転送できるよう設計されている。具体的には、AWDL(Apple Wireless Direct Link)を利用する。AWDLは、AirDropやAirPlayでも利用されている技術だ。転送は、Apple Watchのセットアップの際に表示されるものと同様の、パーティクルによる雲のようなアニメーションを使って起動する。転送が開始されると、転送するデータ量にもよるが、新旧、両方のiPhoneは、最長で2〜3時間は使えなくなる。

転送中のデータは暗号化されている。直接転送される情報には、メッセージの履歴、iPhone本体に保存されているフル解像度の写真、インストールされているアプリに付随するデータといったものがある。アプリ本体は転送されない。Appleのアプリ署名の手続きによって、各アプリはデバイスに対してロックされているからだ。そのため、アプリはApp Storeから再ダウンロードする必要がある。もっとも、Direct Transferが完了すると自動的にダウンロードされるので、手動で操作する必要はない。これにより、アプリの適切なバージョンを確実にゲットできるというメリットもある。

また転送が完了すると、iPhoneのデータはiCloudと同期され、最新の状態になる。ユーザーが他のデバイスも使っていて、データの転送中に、そのデバイスでiCloudのデータを変更したような場合は、転送が完了後に、その分をアップデートする必要があるのだ。

Appleによれば、Direct Transferは、以下のような種類の人に適している。

iCloudにバックアップしていない人

しばらくバックアップしていない人

たとえば中国のように、インターネット速度がどこでも速いわけではない国の人

「より完全に」復元するために最初に長く待つのを気にしない人

簡単に言えば、2つの選択肢があるということになる。1つは、すぐにiPhoneの基本機能だけで「準備完了」として使い始めるもの。この場合、iCloudのバックアップからの復元に頼ることになる。そしてもう1つは、少し長く待って、最初から個人のデータにアクセスできるようにするもの。この場合、後でiCloudから写真やメッセージの履歴をダウンロードする必要はなくなる。

またDirect Transferは、Face IDやTouch IDの設定、Apple Payに関する情報は転送しない。またユーザー名とパスワードを除き、メールのデータそのものも転送しない。

iPhoneの乗り換えが完了すると、デバイス上のメッセージのコンテンツが、iCloud上のメッセージのコンテンツと照合され、同期が維持されるようになる。iCloudに保存されている写真についても同様だ。

ちょっと付け加えると、Direct Transferの使用中には、いくつか面白い経験をした。最初のiPhoneへの転送は、完了するまでに約2.5時間かった。その時点でも、さらにメッセージのアーカイブについては、バックグラウンドでダウンロードを続ける必要があるというアラートが表示された。Appleによると、これは、このプロセスの合理化に起因するものではないかということだ。

また、同時に複数のDirect Transferを走らせた場合、2つのデバイスを隣り合わせに置いておくと、余計に時間がかかることにも気付いた。これは、電波の干渉が原因である可能性が非常に高いと思われる。実はAppleは、それに対する解決策を用意している。Direct Transferは、有線接続でも動作するのだ。そのためには、カメラ接続キットを用意して、2つのデバイスをUSBで接続する。Appleによれば、理想的には転送速度は変わらないはずだが、当然ながら有線接続なら電波の干渉の問題を完全に回避できる。Apple自身も、実店舗内でDirect Transferを使って新しいiPhoneにデータを復元する際には有線接続を使うことになるはずだ。

私が経験した範囲でも、Direct Transferでの転送にまったく問題がなかったわけではない。例えば、すべてのキーチェーンのデータをまるごと転送できなかったようで、いくつかのパスワードは自分で入力しなければならなかった。しかし、まっさらなデバイスに対して「かなり完全」と思われる転送方法が用意されているのは歓迎すべきことだ。

デザインとディスプレイ

私は、iPhoneをずっと裸のまま使ってきた。つまり、ケースに入れたことはない。ケースはうっとうしい。かさばるからだ。それに、滑りやすくなるか、逆にネバネバしたりすることも多い。それに私は、ハイテク用の服を着ることが多い。スマホを入れる場所は決まっていて、手品のように素早く出し入れができる。留め具を引くと、すぽっと手の中に落ちてくるような感じだ。ケースに入れると、こういう芸当はできなくなる。

Appleは、3台すべてのiPhoneをクリアケースに入れて貸し出してくれた。レビュー中にキズを付けたりしないよう、今回はケースに入れたまま使ったが、私個人のiPhoneはケースに入っていないことを誓ってもいい。

iPhone 11 Proは、つや消し仕上げによって、デバイス単体でもグリップ性が向上している。これは、喜んでで報告しておこう。iPhone 11とiPhone XSの場合、背面がスベスベしているので、ポケットから出し入れするために持ち換えようとする際など、指先に多少の湿り気が必要となる。

ディズニーランドの中を歩き回っていると、夏なら汗をかくし、プラザのフライドチキンやターキーレッグの油も手に付く。子供がいろいろこぼしたりすることもある。そのような、ある種の切迫した状況では、ケースの必要性もまったく理解できる。しかし日常的な使い方としては、私はケースが好きではないのだ。

私は、iPhone 11/Proの統一感のあるデザインが気に入っている。前者は背面全体がツヤありで、カメラモジュールの出っ張りの部分がツヤ消しガラスになっているのに対し、後者は、それが逆になっている。そこには、配色の手法の違いはあっても、デザイン言語の共通性が感じられる。

このカメラ部分の出っ張りが、機能的でカッコいいと思うか、本能的に嫌悪感を抱くか、人によって分かれるところだろう。カメラの数が増えたこと自体は、この際好き嫌いの判断材料にはなっていないようだ。iPhone 11 Proと同Pro Maxは、人気ゲーム「スプリンターセル」に出てくるスコープのような雰囲気を醸し出している。iPhoneが装備するカメラの数がどんどん増えていく、といったジョークを見たことがある人も多いと思うが、もはやそれはジョークではなくなったわけだ。

Appleは、ここに現在考えられる最高のものを実装したように感じられる。iPhone 11 Proの本体は、それだけで前の世代のものよりも厚くなっているが、それでもこのカメラ部分の出っ張りをなくすことができるほど厚くなったわけではない。どうせなら、そうすればいいのにと思うかもしれないが、それでは厚くなりすぎる。

Appleは、ほとんどのレビュアーにミッドナイトグリーンのiPhone 11 Proと同Max、およびグリーンのiPhone 11を貸し出した。正直に言えば、私はこのミントグリーンのようなiPhone 11のグリーンが好きだ。淡く明るい色が好みなのだ。もっと言うと、私はラベンダー色のiPhone 11 Proが欲しかった。しかし残念ながら、Appleの路線にはそういうものはない。

私が受けた説明によると、ミッドナイトグリーンを選んだ背景には、Appleの彩色担当者が、この色が来年あたりブレークすると考えていることがあるという。ファッション業界の人は、ある程度同意するだろう。ミント、シーフォーム、ネオンといったグリーンのバリエーションは、今年の初めごろには流行っていたが、すでにセージ、クロコダイル、モスといった他のグリーンの系列に取って代わられた。Appleのミッドナイトグリーンは、暗く、控えめな色で、Appleは、Proの雰囲気を演出するのに理想的な色だとしている。

ただし、このグリーンはAppleのサイトにあるどの写真とも違って見える。

私の目にはこのミッドナイトグリーンは、直接ライトの光を受けているとき以外、屋内では暗いグレーに見える。屋外では、ステンレス製の縁取りが施された「80年代のモールグリーン」のような色合いが感じられる。その感じは好きだ。背面部分の面積が広いので、屋外ではむしろフォレストグリーンのように見えることもある。全体的に見れば、これはとても落ち着いたよく整えられた色だ。他の選択肢、スペースグレー、シルバー、ゴールドといった、無彩色や自然な感じの色の中にあっても違和感がない。

この中ではシルバーが、私の個人的なチョイスとなる可能性が高い。つや消しの白のように見える背面が、すごく気に入ったからだ。このところ、ずっとグレーや黒を選んできたが、今回は違った選択になりそうだ。

Appleの新しいSuper Retinaディスプレイのコントラスト比は2百万:1で、最大輝度はHDRコンテンツに対しては1200ニト、それ以外では800ニトとなっている。これはディズニーランドの太陽の下で何を意味するだろうか?それほど大きな差は感じられないが、日当たりの良い場所でも画面は以前よりもじゃっかん見やすくなり、細かい部分まで確認できるようになった。Appleが言う、iPhone 11 Proの新しいXDRディスプレイの「改善」部分は、ルクス、つまり輝度に関するものであり、色彩についてではない。というわけで、色の再現範囲は以前と同じだ。ただし、HDR画像については、iPhone 11 Proに比べてiPhone XSでは、わずかながら平坦なものに感じられることに気付いた。iPhone 11の画面は、XSに比べるとそこそこ優れているが、iPhone 11 Proの深い黒と広大なコントラスト範囲には及ばない。これが、Proにアップグレードしたくなる2つの大きな理由のうちの1つだ。

Apple独自の3D Touchは、iPhone 11ではついに絶滅した。この背後には、3D TouchをiPadで実現するのが難しいという事情がある。コストが高くなり現実的ではないからだ。そこで、3D Touchはあきらめて、代わりに触覚タッチ(Haptic Touch)を採用した。これなら、iPhoneだけでなく、Appleの他のラインアップでも採用できる。

感触タッチも悪くない。ただ、3D Touchに慣れたユーザーにとっては、最初はちょっと違和感があるかもしれない。例えば「ピーク」や「クイックアクション」の操作は可能だが、「ポップ」はできなくなった。というのも、いったん画面を押してから、それ以上の圧力がかかったことを検出できないからだ。これまで、おそらく3D Touchによって操作してきた、カメラやフラッシュライト、ホーム画面でのアプリのショートカットなど、ほとんどの操作は触覚タッチでも問題なく可能だ。

私自身は、3D Touchを強く支持していた。パワーユーザー向けに、操作中のコンテキストのレイヤー、つまりタッチをホバーするというレイヤーを追加することに可能性を見出していたからだ。残念ながらAppleの社内にも、そして社外にも、この機能の存在に気付いてもらえないのではないかとか、便利に活用してもらえないのではないかと疑う人たちがいた。そのため、この機能が十分成功するために必要な投資を受けることができなかったのだ。彼らが正しくて、私が間違っているという可能性も否定できないことは認める。いずれにせよ、これについてはうまく事が運ばなかったということ。

パフォーマンスとバッテリー

AppleのA13 Bionic(バイオニック)は、A12 Bionicよりも、さらに20%高速で、消費電力は40%少ないという効率的なコアを特徴としている。その効果の1つとしては、バッテリー寿命が飛躍的に向上したことが挙げられる。全体的なクロック速度では20%高速となり、ベンチマークでも、だいたい同じくらいの性能向上が見て取れる。パフォーマンスコア単体では電力消費量は30%減少した。GPUに至っては40%も少ない電力で動作する。Neural Engineも例外ではなく、消費電力は15%削減されている。なお、以上の数字は、すべてiPhone XSと比較したものだ。

私はここで、コアの消費電力に焦点を当ててみたが、その点はそれほど魅力的なこととは思えないかもしれない。しかし新しいiPhoneは、どれもこの点で非常に優れている。Appleは、だいたいいつでも、ハードウェア性能に見合った消費電力となるよう、実は巧妙な仕事をしているのだ。そして、前世代のソフトウェアをそのまま持ってくると、かなりの余裕が生じてしまうことになる。これについてはいつもと同じだ。

こうしたシリコンチップの特徴が、一般の人の生活に及ぼす効果の中で最大のものはもちろんバッテリー寿命の延長だ。

iPhone 11 Proのバッテリーの容量は、iPhone XSのものより大きい。また化学的特性も異なり、より高電圧を発生する。それが、上で述べた省電力性能と組み合わされ、さらにディスプレイや、その他の部品の省電力化も加わって、バッテリー寿命はかなり延びている。

私が、ディズニーランドで数日間にわたってバッテリーテストを実施した結果は、Appleの言うiPhone XSからの改善の割合と、ほとんどドンピシャで一致するものだった。Appleは、iPhone 11 Proは、iPhone XSより4時間長持ちすると主張している。昨年のテストでは、iPhone XSはほぼ9.5時間持続した。今年のiPhone 11 Proは、ほぼぴったり12時間だった。いずれもかなり厳しい条件でのものだ。

暑く、ネットワークは混雑する中、私は自分で操作できる限り、カメラと本体の、ありったけの機能をテストした。ディズニーランドでは、Wi-Fiをサポートしている領域もあるが、カバレッジは完全ではない。そのため、大部分はLTEに頼って使うことになる。テストによる負荷としては、写真とビデオの、デバイス上での処理も含まれる。ビデオは毎日約40分ほど撮影した。ディズニー製のパークアプリも使ったが、これにはイライラさせられどおしだった。それについて書けと言われれば、いくらでも苦言を書くことができる。

食べ物を注文し、並んでいる間にツイッターを閲覧し、子供たちにビデオを観せておいて、妻と私はワインを必要量、たぶん6杯くらい飲みながら、ひっきりなしに家族と同僚にメッセージを送り続けた。iPhone 11 Proのバッテリーは、かなり激しい使い方にもかかわらず、iPhone Xに比べて、ずっと長持ちした。昨年のテスト では、iPhone XSは、ほんのわずか自前のiPhone Xの持続時間を上回っただけだった。

人為的に空にしたテスト用のデバイスを用意するのではなく、私が普段使っているデバイスのクローンを作成し、それをテストに使ったのは、ほとんどの人は、そうやって新しいiPhoneを使い始めると信じているからだ。デバイスの中身を完全に消去したり、新たに購入したiPhoneを、まっさらな状態から使い始めるのは、デバイスのテスターや、コンマリの信奉者のような、ちょっと変わった人だけだろう。

バッテリー性能の改善については、これで十分に理解していただけたことと思う。これまでに何度もやってきたことだが、このようなテーマパークでのテストでは、人工的なウェブブラウジングのルーティーンを走らせるベンチテストや日常生活での使い方よりも、ずっと大きな負荷がスマホにかかる。もしかすると、あなたはどこかのロボット農場の労働者で、私は気に触ることを書いてしまったかもしれない。もしそうなら謝りたい。

iPad Pro用のものと同じ18W電源アダプターが、iPhone 11 Proの箱にも入ってる。ようやくだ。私が持っているケーブルの大多数は、少なくとも片側のコネクタがUSB-Cなので、これは助かる。というのも、同じケーブルで、Anker製のマルチポートのGaN充電器や、他のUSB-Cポート付きのアダプターも使えるからだ。Apple純正のUSB-C Lightningケーブルは、以前のものより若干太くなっている。もちろん充電用としてだけでなく、データ転送にも使用可能だ。ワット数が大きな充電器は、それだけ速い充電を意味する。Appleは、この新しい18Wの充電器なら、30分の充電で最大50%の充電が可能だとしている。実際に試してみても、だいたいそれくらいだった。

充電は確かに速い。DCA(ディズニー・カリフォルニア・アドベンチャー)のWine Country Trattoriaにある、階上のちょっと秘密めかしたバーで、ミートボールを食べながら一杯ひっかけている間に、満充電にできるのは頼もしい。カウンターの後ろにはコンセントがあり、頼めば使わせてくれる。

残念ながら「Pro」が付かないiPhone 11に付属しているのは、いまだ5Wのアダプター。これはお粗末だ。iPhoneシリーズは、18Wのアダプターで統一すべきだと思う。

それから改善されたと言われるFace IDの認識角度だが、私が見る限り、たぶん良くなったとしても本当にほんのわずかなもの。言われるほどではない。せいぜい2、3度といったところだろうか。他のレビュアーが、どう評価するのかを見てみたい。もしかすると私の顔が悪いだけかもしれないし。

カメラと写真

写真の仕組みを、比較的わかりやすく図示することができたのは、もう大昔の話になってしまった。カメラのレンズを通過した光は、フィルムや、化学薬品が塗布された紙のような媒体に届く。そして現像プロセスが発動して印画処理が行われ、写真が完成する。といったところだ。

iPhone 8が登場したとき、私は、それが拡張された写真のニューウェーブの第1波だ と騒ぎ立てたものだ。その流れは、このiPhone 11でも継続している。これまでも使われていたISP(Image Signal Processor)は、色補正や、センサーが出力した生の信号から視覚的な画像を組み立てる際の計算タスクを担っている。iPhone 11では、ISPに加えて、Neural Engine(ニューロエンジン)を、処理の流れの中に追加した。機械学習による専門的な機能を実現し、様々なモードで多くの処理をこなしている。

これが、iPhone 11のカメラを拡張した最大の立役者だ。同世代のスマホに対して、かなり印象的な優位をもたらした。それは新しいレンズでも、新しいセンサーでもなく、機械学習のタスクを実行するために特別に設計されたプロセッサーなのだ。

iPhone 11 Proは、3つのイメージセンサー、3つのレンズ、分散されたモーションセンサー、ISP、機械学習に最適化されたチップ、CPU、これらすべてを統合したものなのだ。それらが連携して1枚の画像を写し出す。これは機械学習カメラとでも呼ぶべきものだ。しかし、iPhone上で動作するソフトウェアから見れば、背面カメラは1つだ。実際、それは単なるカメラではない。いくつものデバイスと、ソフトウェアの集合体であり、それらが画像を生成するという、たった1つの目標に向かって協調して動作する。

画像処理についてのこのような考え方は、ナイトモードからHDRなど、さまざまな機能の基本となっている。そして、私がこれまで手にしたスマホの中で、最高のカメラを実現することになった。

ともあれ、新しいレンズの話から始めよう。

超広角

iPhone 11とiPhone 11 Proのいずれにも、Appleが13mmと呼んでいる新たな「超広角」レンズが搭載された。これは、実質的にフルフレームの一眼レフカメラでは、ほぼ13mmのレンズに相当する画角を実現するもの。かなりの広角だ。エッジ補正を加えても、被写体に近付いて大きく写す際には、当然ながら、期待通りの、かなりダイナミックな画像が得られる。遠く離れて写す場合には、これまでになかったほどの広い視野のパノラマ画像が得られる。室内では、ちょっと引こうとすると背中が壁についてしまうような狭い部屋でも、グループや家族の写真の撮影に大きな威力を発揮する

広角撮影のテストでは、特に明るい条件で、その効果が非常によく現れた。クローズアップした素晴らしい家族写真、背景の景色や力強さを強調した広角のポートレートの撮影が可能となる。これは、これまでのiPhoneには望むべくもなかった撮影の可能性を拡げるものだ。

全般的にポートレートモードでは、エッジ検出が微妙に進化している。細い髪の毛、サングラス、複雑な背景のパターンなど、一般的なポートレートモードの弱点とされているものにも、高い効果を発揮する。上の写真のような変わった柵は、従来のiPhoneではお手上げだったが、iPhone 11はほぼ完全に捉えている。

ここで感心したのは、1xまたは2xで撮影する際のファインダーの表示だ。画面には、実際に撮影する範囲よりも広い画角のライビューがブレンドして表示される。これは、単に広めに表示しておいて、トリミングのマーカーを重ねただけのものではない。そこには、センサーから送られてくる実際の映像が表示される。実際に写る写真の範囲を確認しながら、そのフレームの外にも何か写しておきたいものがないか、同時に確認できるのだ。これは、カメラのファインダーのエンジニアによる離れ業といったところだろう。

私は人物を広角でクローズアップで撮影するのが好きだが、誰でもそうだというわけではないだろう。ほとんどの人は広角を、大人数のグループや、風景を撮影するのに使うはずだ。それでも私は、人物を近くで撮るのは楽しく、親密な瞬間を捉えられることに気付いた。近付いて取ることで、より個人的な雰囲気が出せるのだ。

1つ注意すべきは、iPhone 11、iPhone 11 Proのいずれにも、超広角レンズには光学式手ぶれ補正機能がないとうこと。このため、暗い場所や夜間に使うのをためらってしまうこともある。

超広角カメラはナイトモードでは使えない。このカメラのセンサーには、100%フォーカスピクセルもなく光学式手ブレ補正機能がないからだ。そのため、超広角で夜間に撮影する場合には、静止した状態でしっかりと保持していなけれならない。そうしなければ、ぶれた写真になってしまう。

この超広角レンズは本当に素晴らしい。これが追加されたのはとても喜ばしいことだ。iPhone 11を手に入れた人は、みんなこれで撮りまくるだろう。標準的なレンズに何か1つを付け加えるとしたら、やはりこの超広角が選ばれるべきだった。というのも風景写真よりも、大人数のグループ写真を撮る機会の方がずっと多いと思われるからだ。

VIDEO

超広角レンズは、ビデオ撮影にも優れた効果を発揮する。ビデオの特性として、どうしてもトリミングが入るので、標準的な広角レンズでは常に少し狭苦しい感じがするのだ。ビデオの場合、センサーの狭い範囲しか使わないので、切り取られた感じが避けられない。たとえば、メリー・ポピンズと同じ回転木馬に乗ってビデオを撮ると、iPhone XSでは、彼女とバートをいっしょにフレーム内に収めることができなかった。しかし、iPhone 11 Proではできた。マッターホルンに乗りながら取れば、その体験をより広く撮影することができ、「前の人の頭」しか映っていなかったということはなくなる。それはカーズでも同じだ。座席の前の風防を通した前方しか映らないか、その外側の景色も映るかという違いになる。今挙げたのは、かなり特殊な例かもしれないが、家族が集ったときに、小さな庭、室内、あるいは他の狭い場所で、どのような状況が展開されるか、容易に想像できるだろう。

超広角レンズについては、もうひとこと付け加えておこう。iPhoneの握り方を見直す必要があるということ。レンズの画角は非常に広いので、指先などがフレーム内に入り、自分の指が写真に写ってしまうことがよくあるのだ。iPhoneの下の方に指を掛けるという持ち方に慣れるまで2、3日かかったが、それまでは、そういうことが何度も起こった。iPhone 11 Pro Maxならば、このような心配は無用かもしれない。

HDRとポートレートの改善

先に述べたような画像データ処理の改革によって、もともと着実なものだったHDR撮影の写真は、ポートレートモードでさらに進化している。Neural Engineが、iPhoneのカメラから出力されるHDR画像に作用して、トーンマップを調整し、さまざまな物理センサーからのデータを活用して画像を融合させ、写真を作成する。1枚の写真の中でも、1つのカメラからのピクセルを使ってハイライト部分のディテールを描写し、別のカメラからのピクセルを使ってエッジを強調する。私は2016年以降、HDRで撮影した写真をかなり広範囲に見直してみたが、Neural Engineの追加によって、洗練されたものになることが分かった。

この秋にDeep Fusion(ディープ・フュージョン)が追加リリースされれば、さらに大きな飛躍を遂げるはずだが、それについてはまだテストできていない。

今のところは、Neural Engineによるセマンティックレンダリング機能の効果を確かめることはできる。このプロセスでは、まずiPhoneがポートレートの被写体に対して顔検出を実行し、顔と肌の部分だけを、それ以外の部分から分離する。そして、顔と肌に関しては、他の部分とは異なる経路のHDR処理を適用するのだ。残りの部分にも、それなりのHDR処理が施された後、2つの画像が融合される。

このような操作は、画像処理の世界では珍しいことではない。それなりの技量を持ったプロの写真家は、人物の顔の部分に対して、画像の残りの部分とは異なる調整を施すのが普通だ。顔をマスクして、平坦な感じにならないようにしたり、逆にコントラストが強くなりすぎないように、あるいは肌の色調が不自然にならないようにする。

そうした従来からの処理との違いは、もちろんセマンティックレンダリングでは、すべて自動で、すべてのポートレート撮影に対して、あっという間に処理が完了することだ。

その結果、iPhone 11やiPhone 11 Proでは、これまでより優れた見栄えのポートレート写真が得られる。顔の部分は、iPhone XSでたまに見られたような、不自然に平坦な感じのものにはならない。XSのHDR処理では、シャドウ部分をそのまま含めて、画像のコントラストを正規化していたために、どうしてもそうなってしまうことがあった。

上の2枚は、同じ時間に、同じ条件で撮影したもの。iPhone 11 Proは、背景の明るさを確実に検出し、特に顔や額の部分に適切な補正がかかっている。結果としては、文句なく、より良いコントラストと優れた色調が得られている。これは、この写真だけに限らない。多くのポートレートを、これら2台のカメラで撮影してみたが、常にiPhone11 Proの方が優れていた。特に、被写体の後ろから光が当たっている場合には、差が大きかった。ポートレート撮影ではよくある条件だろう。

また今度の2枚の違いは、さらに微妙だが、カラーバランスを見比べていただきたい。iPhone 11 Proの方が肌の色合いが暖かく、オリーブ色がかっている。そして、これについては私を信用してもらう必要があるが、より実物に近い。

それから、「ハイキー照明(モノ)」は、それなりに機能するが、まだ完全ではない。

ナイトモード

さて、重要なものを取り上げよう。iPhone 11は、ついにナイトモードを装備した。これは、特に手動で有効にする必要はないので「モード」とは呼びたくない。そうすることが有益だと判断された場合に自動的にオンになる。

技術的に言えば、ナイトモードはカメラシステムの機能であり、かなりHDRに似たもの。光量が既定のしきい値を下回ったことを検知すると、以下のようなことを実行する。

光量、加速度計やその他の信号から算出したカメラの安定度に基づいて、キャプチャするフレームの数を動的に決定する。

次にISPが、ブラケット撮影されたショットを取得する。露光時間には長いものと短いものがある。

Neural Engineは、どちらかというとナイトモードとは独立したものだが、iPhone 11では、すべてのHDR撮影のセマンティックレンダリングにも使用されるため、やはり連動する

ISPは、前景と背景の露出に基づき、Neural Engineから提供されたマスキング情報を利用して、撮影された複数のショットを融合する。

その結果、ちょっと暗めから、かなり暗い範囲のシーンを明るいものにすることができる。すぐに捨てたくなるような写真も、取っておく価値のあるものにまで補正することができる。私が経験した範囲では、この効果を十分に確かめらるほど暗いシーンを見つけることが、そもそも難しかった。しかし、iPhone XSと比べて、広角カメラでISOにして33%改善され、望遠カメラでは42%も改善されるのは、それだけでもかなりありがたいたことだ。

しかし、適切なシーンでは、ディテールとシャドウのポップが画面に表示され、シャッターを押す前から、そのシーンが劇的に明るくなっていることがはっきりとわかる。ナイトモードは1x、および2xの撮影モードでのみ動作する。これは、それらのモードで使用されるカメラのみが、100%フォーカスピクセルを備えているからだ(訳注:100%フォーカスピクセルを備えているのは、Appleの「仕様」によれば広角カメラのみ)。iPhone 11でナイトモードの効果を実現するための検出とマッピングを実行するためには、100%フォーカスピクセルが必要なのだ。

私は、この一風変わったリトマステストを、これまでのすべてのiPhoneの新モデルで試してきた。それは、くまのプーさんのような、暗いところを走る乗り物から撮影し、本当にシャープで使い物になる写真が撮れるかどうかをテストするというもの。これは、なかなか厳しいテストだ。たいていブラックライトが点灯していて、その中を車が動き、被写体も動いているからだ。これまでは、ただのいちども満足できる写真が撮れたことはなかった。しかし、iPhone 11 Proではうまくいった。完璧ではないが、いろいろな点を考慮すると、すごいとしか言いようがない。

ナイトモードに関して気付いたことを以下に挙げておく。

夜に撮った写真は、しっかり夜の雰囲気を残している。これはAppleが、すべてのシャドウ部を処理して、画像の隅々まで明るくし、彩度をただ広げ、コントラストをなだらかにする、といった方針を採用しなかったことの直接的な結果だ。

写真は、ナイトモードなしで撮影したものと、同じ遺伝子構造を持っているかのように感じられる。より鮮明で、被写体が明るくなっているだけだ。

セマンティックマッピングが、他の被写体検出機能と組み合わされて作用するので、ピントはクリアで明るいが、全体のゲイン調整のように、すべてが一様に調整されてしまうわけではない

iPhone 11も、他社のほとんどの「ナイトモード」と同様、移動している被写体の撮影には問題がある。誰も動いていなかったり、ごくわずかしか動いていない場合に、ベストな効果が得られる。これは、1〜3秒という露出時間によっても異なる。

三脚などの固定器具を使った場合、ナイトモードは自動的に露出時間を最大10秒まで延長する。その場合、ライトペインティングや、後幕シンクロのような効果など、素晴らしい夜間撮影の効果が可能となる。

その結果得られるのは、自然な感じに明るい写真だ。すばらしいレベルのディテールを維持し、元の被写体の物質が持つ自然な色を再現しているように感じられる。

Night Sight(ナイトサイト)モードを備えたPixel 3が登場したとき、私はゲインベースのナイトモードでは、それなりの結果しか出せないことを指摘した。そしてAppleも、純粋に明るさだけを増強するものを出してくるかもしれないが、これまでは常に他のやり方を選んできたので、これについても今までの製品と同じようなアプローチを取るのではないかと書いた。この考えはまったく支持されなかったが、結局はそうなった。

Galaxy 10+にも優れたナイトモードがあるが、Pixel 3がこの分野のパイオニアであり、夜間の撮影を評価するとなると、真っ先に思い浮かぶモデルだ。Googleの選択は、「すべてを明るく」という基本方針を固く貫くもの。それが良いと思う人にとっては、それで良いだろう。しかし、それは抑制を効かせたアプローチからは程遠いものだ。

上に示した例は、Pixel 3と比較したiPhone 11 Proのナイトモードの撮影結果だ。ご覧のように、どちらも画像を明るくするという点では着実に機能しているが、Pixel 3の画像は冷たく、平坦で、どこも均一に明るくなっている。色はまったく忠実ではない。

付け加えると、Googleがどうやって1つのカメラの1つのセンサーから、こうした画像を引き出しているかは別として、ディテールはかなり犠牲になっている。上の写真では、岩と塔の部分の違いが明らかだろう。暗いままの画像よりははるかにマシというものだが、iPhone 11 Proの方が抜きん出ていることは間違いない。

もちろん、もうすぐPixel 4が登場するだろう。Googleがどのような改善を盛り込んでくるのか、待ちきれない気持ちだ。私たちの世代は、スマホのカメラで暗いところの写真を撮るという点に関して、本当に黄金時代を生きている。

ところで、iPhone 11、および同Proのフラッシュは、iPhone XSより36%明るくなっている。動いているものが、ナイトモードでうまく撮れなくても、明るいフラッシュが、それを補ってくれるはず。

その他もろもろ

自動トリミング

iPhone 11はデフォルトで、1x、2xのビデオ撮影では、被写体を自動的にトリミングする。たとえば子供を追いかけていて、子供の頭がフレームから外れたりすると、少し処理時間はかかるが、追加のレビュー画面に自動ボタンが表示される。それをタップすると、自動的にビデオのフレーミングが調整される。現状では、これが使えるのは、iPhoneのロック画面から直接QuickTake機能を利用してビデオ撮影を始めた場合のみ。この機能はオフにすることも可能だ。

そうしたいのであれば、カメラの設定メニューで、写真の自動トリミング機能をオンに切り替えることもできる。これはデフォルトではオフになっている。これもビデオの場合とかなり似た効果を発揮する。画像を解析して、被写体を画面の中心に移動して配置するための画像データがあるかどうかを調べるのだ。

スローフィ(スローモーションセルフィー)

VIDEO

確かに、これは楽しい。うん、これは使える。特に髪の長い人は気に入るだろう。

U1チップ

Appleは、iPhone 11にU1チップを搭載した。このテストはできないが、死ぬほど興味深い。たぶんここしばらくは、これについて話をするちょっと控えておいたほうがいいだろう。Appleが、このU1チップの最初の応用例としてiPhoneに搭載するのは、指向性のある?AirDrop機能かもしれない。これは間違いなく、将来を見越して搭載されたもので、たぶんメッシュ状に位置を認識できる機能なのだ。それが何らかの理由で遅れ、AirDropチームが余力で開発していたものがいきなり最初のリリースに昇格してしまったのではないか。興味深いことに、Appleは単なる例として、U1チップの機能を使って車のエンジンを始動したりすることもできるはずだとしている。もちろん、該当するメーカーの協力が得られればの話だ。

もし読者が、ここ数年の私が書いたものを何か読んでくれていれば、以下のような話を何度も聞いたような気がするかもしれない。それは、iPhoneやApple Watchは、必然的にこのような機能を備えるはずだということ。問題は、それをどうやって、正確、かつ安全に実現するかということだ。U1は、マイクロレベルの位置情報を取り扱うもの。広い範囲ではなく、ネットワークベースでもなく、GPSベースの位置情報でもない。正確な位置と方向に関するものだ。これは、さまざまな興味深い可能性を開くはずだ。

ナイトモードなし

ナイトモードあり

「Pro」の意味するもの

あとは、iPhone 11 Proという名前について考えてみよう。私は、カメラ店で働いていたときに、「プロ」という言葉の魔力を学んだ。ある種の人にとっては媚薬のようなものなのに、またある種の人にとっては、拒絶を意味する言葉だった。そして、さらに別の人にとってはそれはただ必要なものだった。

これがプロモデル? ああ、私はプロじゃないんで。おおプロの方ですか!

むろん、販売ツールとして使った。しかし、ときには、お客が必要以上に買い過ぎたり、逆に必要なものを買わない、ということを防ぐためにも、プロという言葉を使う必要があった。

フィルムで撮影していた時代には、プロ、アマを問わず、カメラマンとして撮影がもっとも難しいものの1つは屋内のスポーツだった。動きは速く比較的薄暗い空間で、被写体はコートサイドから離れたところにある。これを、安い機材でうまくやる方法はなかった。ISOを6万4000に上げて撮ってから、カメラのコンピューターでノイズを除去するなどということはできなかったのだ。高価なレンズを入手し、そのレンズに見合うような高価なカメラ本体を入手し、例えば一脚のような高価なサポートを手にする必要があった。また、撮影者はずっと神経を研ぎ澄ませていなければならなかった。実際、これがもっとも難しい部分だった。

このようなシナリオでの撮影は、アマチュアにとって非常にハードルの高いものだった。しかし本当のプロは、良いモノにお金をかければ利益が10倍にもなることを知っていた。なぜなら、保護者の安い全自動カメラでは、決して真似できないような写真を提供できたからだ。

しかし、カメラ店に入ってくる大多数の人は、ホッケーやレスリングをしていなかった。ほとんどの人は家族の写真を撮り、それも屋外の写真が多く、たまに夕日を撮ったりする程度だった。

これで、Proという用語の本当の意味がわかるだろう。Proはエッジケースを表す言葉だ。

それは、約80%の人をカバーするのではなく、機材からさらに何かを引き出したいと考え、それを必要としている20%の人のことなのだ。

こうしたことを考えると、iPhone 11はかなりよく売れると思われる。そのはずだ。素晴らしいモデルだからだ。新しい最高のレンズを搭載し、超広角カメラで、家族の写真も風景写真も、素晴らしく撮影できる。また、ソフトウェア機能を比べれば、iPhone 11 Proにほとんど引けを取らない。ただし、ディスプレイは最高のものではないし、望遠カメラもない。最高のビデオと写真撮影のオプション、より優れたダークモード、より明るいディスプレイなど、エッジケースに対処したい人のために、iPhone 11 Proがあるのだ。それ以外の人にとってふさわしいのは、会計年度2020年のiPhoneのベストセラーとなるはずのiPhone 11のほうだろう。

当然ナイトモード

[原文へ ]

(翻訳:Fumihiko Shibata)

ABCが制作する同番組のプロデューサーは、参加者と審査員の自宅にホームスタジオ機器を送り、シーズン終盤の放映分を撮影している。システムはカメラ3台の構成で、iPhone 11 Pro 3台、三脚とリングライトからなる。制作チームは、自宅から安全な距離をおいてカメラ設定の補助と編集が可能だ。

ABCが制作する同番組のプロデューサーは、参加者と審査員の自宅にホームスタジオ機器を送り、シーズン終盤の放映分を撮影している。システムはカメラ3台の構成で、iPhone 11 Pro 3台、三脚とリングライトからなる。制作チームは、自宅から安全な距離をおいてカメラ設定の補助と編集が可能だ。 数多くのテレビ、映画の制作会社が、コンテンツ作成でのスマートフォン利用を模索している。ほとんどの場面で、近いうちにスタジオ機器に取って代わることはありそうにないが、進行中のパンデミックは、スタジオでのスマートフォン利用が主流になる大転換のきっかけにになるかもしれない。

数多くのテレビ、映画の制作会社が、コンテンツ作成でのスマートフォン利用を模索している。ほとんどの場面で、近いうちにスタジオ機器に取って代わることはありそうにないが、進行中のパンデミックは、スタジオでのスマートフォン利用が主流になる大転換のきっかけにになるかもしれない。

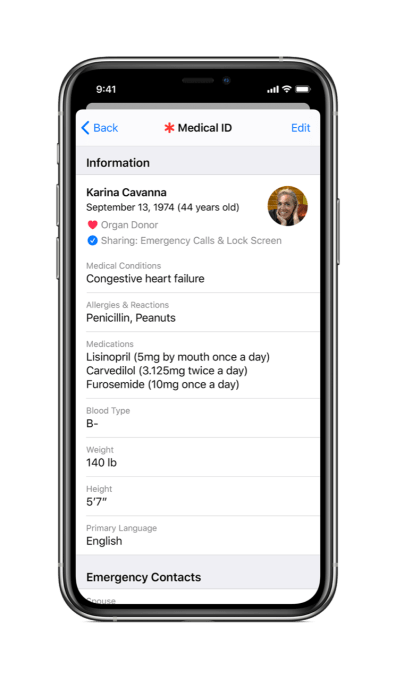

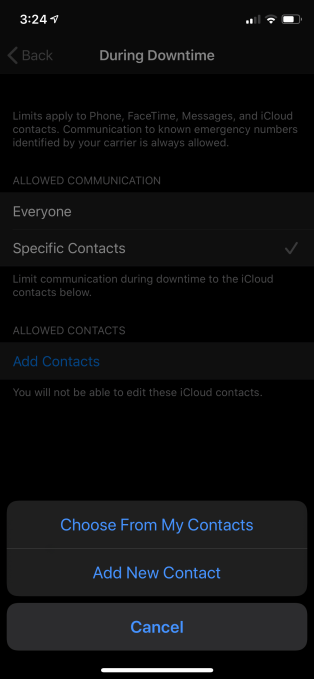

スクリーンタイムのペアレンタルコントロールで設定すれば、親は子供がいつ誰と連絡できるかを決められる。休止時間中については、子供がメッセージや通話できる相手を個別に指定可能だ。例えば、ママやパパとだけのように。

スクリーンタイムのペアレンタルコントロールで設定すれば、親は子供がいつ誰と連絡できるかを決められる。休止時間中については、子供がメッセージや通話できる相手を個別に指定可能だ。例えば、ママやパパとだけのように。