一週間前にAWSは、同社のEC2サービスの秒単位の課金への移行を発表した。Googleが今日、ほぼ同じ移行を発表したのも、当然だろう。

Google Compute Engine, Container Engine, Cloud Dataproc, およびApp Engineが依拠する伸縮性仮想マシンは、今日からただちに毎秒課金が開始される(AWSの秒課金開始は10月2日からだ)。この新しい課金方式は、プリエンプティブマシンと、同社のプレミアム(特別優遇)オペレーティングシステム(Windows Server, Red Hat Enterprise Linux, SUSE Enterprise Linux Server)が動くVMにも適用される。AWSの秒制課金は標準のLinuxインスタンスのみで、Windows Serverや他のLinuxディストリビューションは従来どおり時間制の課金だ。

AWSの秒制と同じなのは、Googleも最小課金量が1分であること。(30秒しか使わなくても1分)

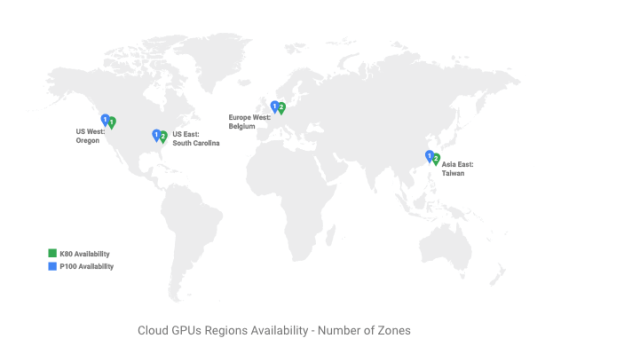

なおGoogleはすでに、Persistent Disks, GPU, そして特定の割引利用では秒課金を導入している。

毎秒課金になっても多くのユースケースにおいて課金額はほとんど変わらない、とGoogleは言っているが、頻繁かつ急速にスケールアップ/ダウンを繰り返すようなアプリケーションもたくさんあり、そんなアプリケーションでは有意な差がある、とも言っている。Webサイトやモバイルアプリ、データ処理のジョブなどが、そんなアプリケーションの典型だ。

Compute EngineのプロマネPaul Nashが今日の発表声明で述べている: “課金額に大きな違いが生じないことが、これまで秒課金の要望が少なかった理由だと思われるが、みなさんが時間を気にせずに朝のコーヒーをゆっくりお飲みいただけるために、そのVMsの課金方式を最小を1分とする秒制にできたことは、本当に喜ばしい”。

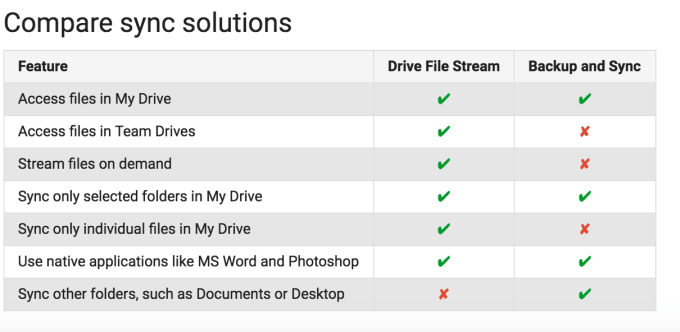

Google自身がそれを白状することはないが、でもこれは明らかにAmazonへの対抗だ。表向きには、両クラウドコンピューティングサービスの機能を比較するページの、チェックボックスがひとつ増えただけだけどね。

ではMicrosoftはどうなる?

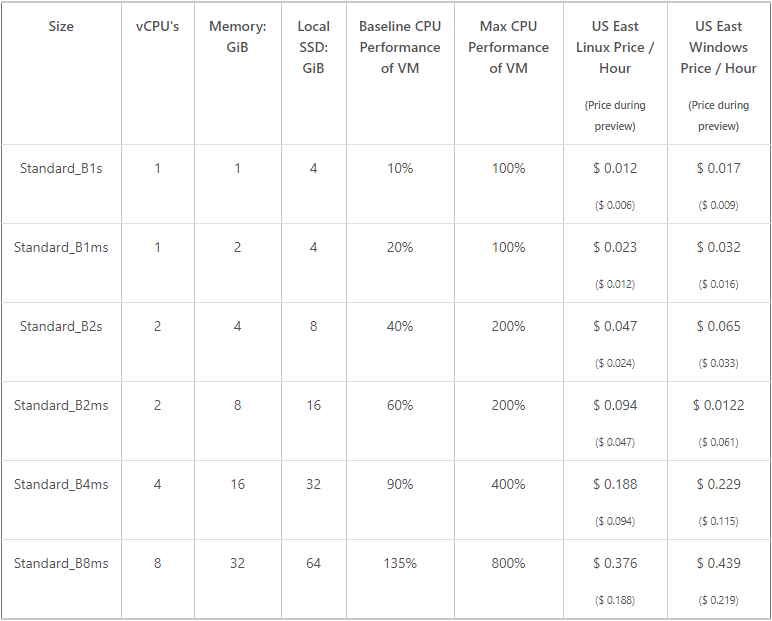

今のところ、Microsoftは同じ動きを見せていない。MicrosoftのAzure Compute部門のプロダクト担当Corey Sandersは同社のIgniteカンファレンスの会場で、私の質問にこう答えた: “Azure Container Instancesでは、数秒でスピンアップし数秒でスピンダウンするようなサービスは実質的に秒課金だから、秒制課金の先鞭をつけたのはむしろ弊社である。われわれは顧客にこのような粒度を提供することがコストの面で重要であることを、前から理解していた。他のクラウドがわれわれに見習って、顧客の課金に最良の柔軟性を提供しようとしている光景を目にすることは、実に嬉しい”。

通常の仮想マシンに関してはSandersは明言を避け、Microsoftはコンテナにフォーカスしたい、秒制課金がもっとも有意なのはコンテナだから、と述べた。“弊社のプラットホーム全体にわたって、課金の構造はつねに改善に努めている。それによって顧客がもっと容易に、そしてもっとアジャイルにプラットホームを利用できるようにしたい”、と彼は語った。でもMicrosoftが近く、比較ページに毎秒課金のチェックボックスを含めなかったとしたら、その方がビッグサプライズだろう。