今日紹介するSwiftypeは元々、TechCrunchなどのニュースサイトで利用するサーチシステムを開発していたスタートアップだ。しかしその後、同社はカスタマーサポートやEコマースの分野の企業にもシステムを提供するようになった。そして今日、Swiftypeはこれまで以上に大きな飛躍をすることとなった。同社が新しいエンタープライズ向けのサーチプロダクトを発表したのだ。

中小規模向けに開発されたSwiftypeの新プロダクトを利用すれば、さまざまなクラウドサービスからお目当てのファイルを見つけ出すことが可能だ(先日にはGoogleもCloud Searchの提供を開始しているが、その検索対象となるのはGoogle製のサービスに限られる)。

「ソースがバラバラに存在しているせいで、企業の中に存在するナレッジもバラバラに保管されてしまっています」と共同創業者のMatt Riley氏は語る。

Swiftypeの検索対象は、Dropbox、Office 365、GoogleのG Suite、Zendeskなどのサービスだ(同社はAPIも提供していて、それを利用すればカスタマイズされたデータソースにも対応することができる)。またRiley氏は、単一のインターフェイスで様々なサービスに保管されたファイルを検索できるようにすることは、ビジネスの現場には欠かせない機能だという。

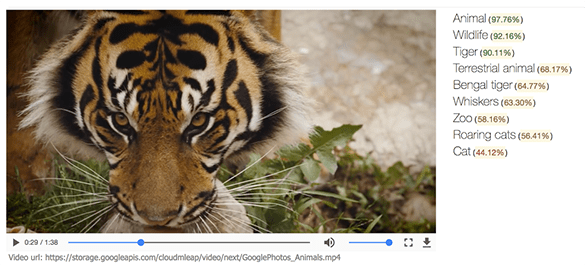

面白いのは、このサービスには人工知能も搭載されている点だ。その人工知能がクラウドサービスに保管されたデータを解析して、共同創業者兼CTOのQuin Hoxie氏が呼ぶところの「エンタープライズ・ナレッジグラフ」を作成する。そして、そのグラフがSwiftypeのサーチ体験を向上させている。

その1つとして、Swiftypeは単なるキーワード型のサーチシステムではなく、ユーザーから与えられた複雑なクエリを理解することもできる点が挙げられる ― 例えば、ユーザーが「連絡先ファイル」や「最近のドキュメント」を探している場合、探しているドキュメントにその言葉が含まれていなくても目当てのものを見つけ出すことが可能なのだ。

また、Swifttypeはデータを利用しやすいかたちに構造化することもできる ― ユーザーがある企業について検索すると、その企業についてのあらゆる情報をまとめた要約カードを見ることができる。加えて、あるドキュメントを検索すると、それぞれのドキュメントに関連する情報も一緒に確認することができるので、複数のドキュメントを1つ1つ開いて確認する必要がなくなる。

これは特に重要な機能の1つである。なぜなら、Swiftypeが提供しているのはデスクトップPCで利用できるサーチシステムだけではないからだ。同社はSlackと統合して利用できるモバイルアプリも開発している。私たちは、たくさんのフィルターを設定したり、複数のページをブラウズする時間がないこともある。そういう状況下では、サーチシステムは複雑なクエリを理解し、ドキュメントから最も重要な情報を抽出する必要がある。

また、Swiftypeはブラウザ用のプラグインも提供している。先ほど紹介した関連情報を一覧表示する機能は、ここで生きてくる ― 例えば、営業やカスタマーサービス部門に所属する社員のプロフィールを開くと、それと同時に、その社員に関連するさまざまなドキュメントがポップアップ表示されるのだ。Swiftypeを一度も開かずに情報を取得できるのが理想的だ、とRiley氏は語る。

加えて彼は、Swiftypeを導入するまでにかかる時間は従来のエンタープライズ向けサーチシステムに比べて大幅に少ないと語る。Swiftypeを導入するためには、まずはアドミニストレーターが企業で利用中のクラウドサービスとSwiftypeを連携し、あとは個々の従業員が自分のアカウントを登録するだけだ。

もちろん、企業内に存在するあらゆるドキュメントを1つの場所から検索できるようにするとセキュリティに関する懸念が生まれる。Hoxie氏によれば、Swifttypeでは社員ごとのアクセス権限を細かく設定することが可能だという ― オフィスネットワーク内からのアクセスに限定することも、社員の個人デバイスからアクセスできるようにすることも可能だ。

ここで明確にしておくべきなのは、SwiftypeはWebサイトで利用するサーチシステムの提供を停止したわけではないということだ。Hoxie氏によれば、開発チームはすべてのSwiftypeプロダクトで「同じコアテクノロジー」を利用するという目標を達成するために大変な苦労をしたという。しかし、そうすることで、あらゆるユーザーがすべてのSwiftypeプロダクトの恩恵を受けることができるという考えだ。

同社は、エンタープライズ向けサーチシステムによって、これまでのSwiftypeプロダクトよりも大きな市場を狙うことができると考えている。Hoxie氏は、「(エンタープライズ向けサーチシステム市場は)これまでよりも大きな市場です。ただ、どの点を考えてもこのプロダクトがもつ市場の方が大きいというわけではありません。マーケットにはサイトサーチの方が適している企業がたくさんあり、だからこそ、これまで私たちは成長してきました。しかし、エンゲージメントという面を考えると世界はがらりと変わります。TechCrunchで利用されているようなサイトサーチでは、検索するときにSwiftypeと向き合っているユーザーはおそらく1人でしょう。しかし、このプロダクトでは、すべてのユーザーが私たちのプロダクトと交流することになるのです」。

[原文]

(翻訳: 木村 拓哉 /Website /Facebook /Twitter)